Comment se fait-il que l’on continue à débattre sans fin sur la notion même d’intelligence artificielle ? A dénoncer l’IA washing des startups ? Sur le fait que telle ou telle solution est ou n’est pas de la “vraie IA” ? Et pourquoi cette distinction entre intelligence artificielle étroite et généralisée, intégrée dans une roadmap devant nous mener inéluctablement à une perte de contrôle de l’Homme sur les machines ?

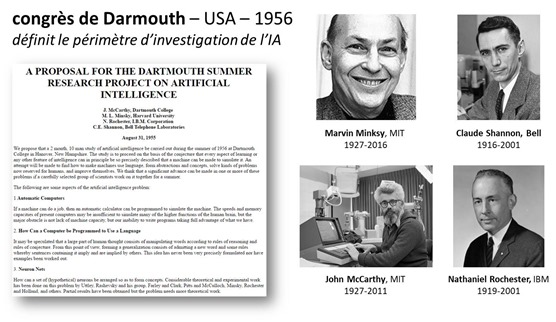

L’explication est pourtant simple ! L’origine de ces querelles sémantiques remonte au mois de décembre 1955, l’année de la naissance de Steve Jobs, Bill Gates, et aussi d’Isabelle Adjani, mais sans aucun rapport avec le sujet. L’expression « intelligence artificielle » fut proposée ce mois-là par l’un des initiateurs du summer camp de Darmouth prévu pour l’été 1956, John McCarthy. L’ordre du jour de cette sorte de hackathon intellectuel prévu pour durer deux mois était de jeter les bases d’une nouvelle discipline recouvrant les sciences et technologies qui permettent d’imiter l’intelligence humaine avec des machines. Vaste programme !

L’IA est à l’origine une promesse intenable

Le groupe de travail du summer camp de Darmouth, situé à Hanover dans le New Hampshire, comprenait Marvin Minsky, Claude Shannon, à l’époque au MIT, Allan Newell et Herbert Simon de Carnegie Tech, et Arthur Samuel et Nathanial Rochester, tous deux d’IBM. Le groupe voulait plancher sur la conjecture selon laquelle tous les processus de l’intelligence humaine pouvaient théoriquement être mis en œuvre par des machines.

L’objectif était de concevoir, au moins conceptuellement, des machines capables d’imiter l’intelligence humaine, notamment la vision, le langage et le raisonnement. Il était des plus ambitieux à une époque où les ordinateurs se vendaient en quantités négligeables et étaient construits à base de lampes et pas encore de transistors, et encore moins de circuits intégrés !

Les 10 participants à ce congrès pensaient qu’il serait possible de régler la question en une à deux décennies. Malgré les beautés de la loi empirique énoncée par Gordon Moore à partir de 1965, nous y sommes encore, 62 plus tard.

Nous disposons cependant d’outils permettant de créer des solutions d’IA qui dépassent les facultés humaines dans tout un tas de domaines. Elles sont encore loin d’intégrer nombre de caractéristiques de l’intelligence humaine comme le raisonnement. Et la faculté à se mouvoir dans l’espace tout comme la vision restent approximatives avec l’IA d’aujourd’hui, ce qui explique la relative lenteur des progrès en robotique.

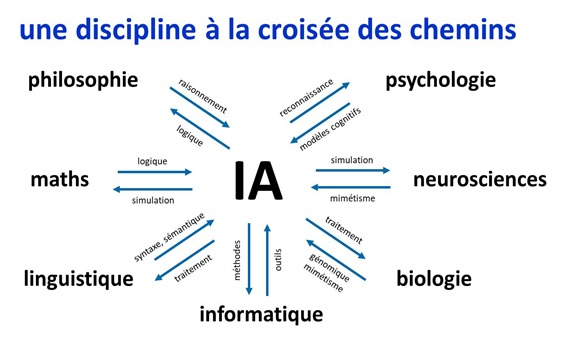

L’IA était une appellation adoptée par des chercheurs souhaitant poser les jalons d’une nouvelle discipline, et d’éviter son association trop étroite avec des domaines scientifiques existants comme les mathématiques, les statistiques, l’informatique ou les sciences cognitives. C’était presque une appellation “marketing”, basée sur une promesse difficile à tenir.

L’IA, un voyage éternel ou un aboutissement ?

Après deux hivers rigoureux dans les années 1970 puis 1990, l’IA est revenue au devant de la scène. Il y a à peine une dizaine d’années, l’IA n’était pas à la mode et symbolisait la “lose” dans l’univers entrepreneurial. Les choses ont bien changé depuis !

Dans la pratique, l’IA se matérialise par une grosse boite à outils disparate qui évolue très vite et qui n’a pas encore atteint les objectifs de 1955. On qualifie les solutions actuelles d’intelligence artificielle étroite (ANI = Artificial Narrow Intelligence). Dans la pratique, ajouter Narrow ou Etroite n’est pas très vendeur, donc on évite le qualificatif.

D’où une définition pragmatique de l’IA comme étant le champ académique de la création de logiciels et matériels dotés de certaines formes d’intelligence, et pas forcément d’intelligence humaine. C’est aussi un ensemble de sciences cognitives.

L’intelligence artificielle est … artificielle. Elle naît dans des machines créées par l’espèce humaine. Mais il faut éviter de projeter sur elle une vision anthropomorphique. On peut éventuellement évoquer de l’intelligence humaine augmentée, l’IA étant principalement destinée à permettre à l’homme de faire plus de choses, comme avec tous les outils numériques jusqu’à présent.

A l’origine, sur son chemin, d’un tas d’avancées technologiques plutôt complémentaires de l’intelligence humaine, l’IA incarne finalement la conquête d’un Graal distant, l’intelligence artificielle générale imitant et dépassant celle de l’Homme. Peu importe si ce Graal est atteignable ou pas puisqu’elle est déjà utile en l’état !

Vraie et fausse IA ?

L’intelligence artificielle génère toutes sortes de fantasmes pour les uns et de craintes pour les autres. Les définitions de l’IA vont d’ailleurs bon train. L’appellation d’intelligence artificielle est source d’une interminable bataille sémantique, tout comme celle de l’intelligence humaine.

Pour certains, seul l’apprentissage profond, ou deep learning, est digne de faire partie de l’IA et le machine learning, pas du tout. Comme si seules les technologies un peu magiques dans leur apparence pouvaient faire partie de l’IA. Pour les spécialistes du secteur, toutes les sciences et technologies de l’histoire de l’IA en font partie. Simplement, leurs capacités évoluent dans le temps.

Ces différents viennent aussi de ce qu’une partie importante de la valeur ajoutée des applications de l’IA est issue du volume et de la qualité des données qui les alimentent. Mais les méthodes importent aussi et elles évoluent constamment. On peut se rassurer en se rappelant que l’intelligence artificielle est … mécanique et artificielle, et donc différente de l’intelligence humaine.

L’IA chez les startups

La querelle sémantique atteint surtout l’univers des startups. Celles-ci feraient de “l’IA washing”, peignant aux couleurs de l’IA des solutions qui n’en contiennent pas forcément. Et les investisseurs dans les startups de l’IA seraient de véritables gogos, suivant aveuglément un effet de mode. Ils le sont probablement souvent, mais pas plus que ceux qui investissent dans nombre d’autres secteurs d’activité, l’échec étant la règle et la réussite, l’exception dans l’univers des startups

Cette notion d’IA washing est à nuancer. Ce n’est pas parce que certaines startups utilisent des briques technologiques prêtes à l’emploi ou ne relevant que de méthodes anciennes de machine learning sans réseaux de neurones qu’elles ne font pas d’IA ou que leur solution n’intègre pas d’IA. Et c’est valable même si la société a ajouté en cours de route de l’IA à son discours marketing. Lorsque l’IA n’était pas à la mode, des éditeurs de logiciels en utilisaient déjà des briques dans leurs logiciels. Ils étaient juste discrets à ce sujet. Pour ne prendre qu’un exemple, le traitement du langage n’a pas attendu le deep learning pour se développer. Nombre d’entreprises du numérique sont fondées par ou emploient des informaticiens formés il y a 10, 20 ou 30 ans aux techniques de l’IA.

Enfoncer le clou sur l’IA washing des startups revient à affirmer qu’un site web réalisé en WordPress avec un thème standard au lieu d’être développé avec son propre framework en Ruby on Rails avec un front-end custom en React ou Angular n’est pas “de l’internet”. L’IA est une sorte de vague de logiciels 2.0, amenée à se généraliser dans tous les pans du numérique.

Reste à définir “une IA”, qui est toujours un assemblage de plusieurs composantes (data, algos, hard, savoir-faire métier) et à ausculter les startups de près pour appréhender les morceaux d’IA qu’elle exploite et l’impact qu’ils ont sur la qualité de la solution proposée.

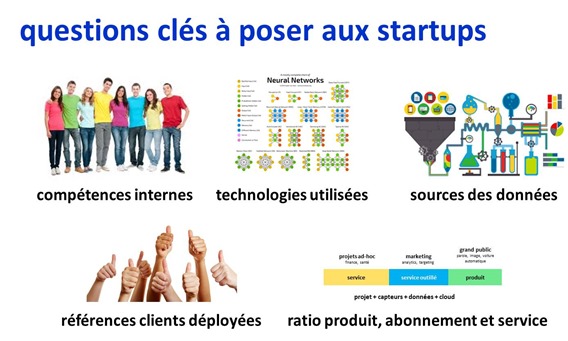

Quelles sont les caractéristiques d’une bonne startup faisant appel à de l’IA ? On peut identifier sept grands aspects à creuser…

- Talents : une startup dans l’IA doit faire appel à des talents techniques variés avec des data-scientists, des développeurs maitrisant le paramétrage de systèmes de machine learning et deep learning, et les autres connaissances techniques classiques allant du back-end au front-end de la solution. Le design est aussi de la partie car les solutions logicielles se distinguent encore par là que ce soit via leurs interfaces graphiques ou vocales.

- Métier : une bonne startup connait bien le métier de ses clients, leurs contraintes, leurs besoins et aspirations. Elle sait créer une solution qui s’intègre bien dans l’existant. Elle sait se différencier par rapport à l’existant qu’elle connait, si possible, sur le bout des doigts. Ce qui compte avant tout est la valeur apportée par la solution ! Si l’IA permet d’être plus efficace, tant mieux !

- Données : il n’y a généralement pas d’IA sans accès à des données pour entraîner ses modèles. Les données exploitées par la startup peuvent être de trois types : ouvertes et facilement disponibles sur Internet (open data, ImageNet, WordNet, MNIST), collectées de manière exclusive à la startup, par exemple via ses objets connectés, ou provenant des systèmes d’information de ses propres clients. La différentiation de la solution provient généralement de la combinaison des trois sources. Une startup n’exploitant que des données ouvertes aura moins de barrières à l’entrée. Et pour accéder aux données des entreprises clientes, il faudra souvent faire du spécifique ce qui réduira les effets d’économie d’échelle de la startup. Autre question clé : où sont stockées les données ? Comment est géré le respect de la vie privée des utilisateurs pour les applications grand public ? La startup est-elle prête à respecter la nouvelle réglementation européenne RGPD en mai 2018 ?

- Technologies : quand une startup indique avoir créé « son IA », il est bon de creuser un peu pour se faire expliquer le pourquoi du comment. Quels outils a-t-elle exploité pour créer sa solution ? Quelles méthodes de machine learning ou quels types de réseaux de neurones ? Quelle est la partie algorithmique qui est spécifique à la startup ? Est-ce qu’elle a développé un savoir-faire spécifique dans l’assemblage de briques algorithmiques diverses ? Au minimum, il faut segmenter les techniques d’IA utilisées : moteurs de règles, machine learning, réseaux de neurones et deep learning. Et puis éventuellement, décrire les ressources matérielles exploitées, que ce soit côté terminaux ou serveurs, y compris dans le cloud.

- Produit : est-ce que la solution est générique ou demande-t-elle d’adopter un mode projet lourd pour sa mise en œuvre chez chaque client ? Si on est en mode projet à chaque fois, on sera dans la catégorie des services outillés, la startup étant hybride entre startup produit et entreprise de services du numérique (ESN) avec peu d’économies d’échelle.

- Business : quel est le modèle économique de la startup ? Est-il récurrent ? Où sont les économies d’échelle ? Des questions classiques à se poser.

- Financement : c’est toujours le nerf de la guerre pour le développement de véritables startups, celles qui ont une grande ambition, notamment internationale. Les startups US bénéficient souvent de financements importants, pouvant facilement dépasser les $30M, ce qui est plus rare en France et en Europe en général.

Sortir du bricolage

L’IA en est encore au stade artisanal et du bricolage. Cela ne se voit évidemment pas directement lorsque l’on fait le tour d’horizon des startups du secteur. Surtout dans le mesure où la plupart d’entre elles sont “b-to-b” et diffusent leurs solution en marque blanche. Vous les retrouverez éventuellement dans les agents conversationnels des sites web de marques, dans le ciblage marketing qui vous touche avec une offre pertinente (ou pas du tout…), dans des robots capables de dialoguer plus ou moins avec vous, ou dans les aides à la conduite de votre voiture haut de gamme.

L’un des moyens de se rendre compte indirectement de cet aspect artisanal consiste à d’évaluer la part produit et la part service des entreprises du secteur. Plus la part du produit est faible, plus on est dans le domaine de l’artisanat. Cela n’apparait pas dans les données publiques mais peut au moins s’obtenir quand on a l’occasion d’observer à la loupe ces entreprises : dans le cadre d’une relation grand compte/startup ou d’un investissement. On peut l’observer également dans les profils LinkedIn des salariés de l’entreprise s’ils sont disponibles. Bref en utilisant ce que l’on appelle des sources d’information “ouvertes”.

La querelle de sémantique autour de l’IA est une affaire de perspective historique mais aussi de pédagogie. Le marketing des startups faisant de l’IA est à inventer complètement. Elles devront apprendre à expliquer ce qu’elles font en termes à la fois compréhensibles par le plus grand nombre et aussi de manière crédible auprès des rares spécialistes qui connaissent les grandes techniques mises en œuvre dans l’IA.

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

IBM a clairement l’intention de dépasser le débat sémantique autour de l’IA en parlant en lieu et place (au moins aux US) d’Intelligence Cognitive ou d’Intelligence augmentée. Voir l’interview récent de sa pédégère dans Bloomberg Busineeweek.

En effet, bien vu ! Le cognitif est un moyen de contourner le problème. Même si le terme est aussi un peu survendu.

https://t.co/qSlGDnjWgs #IA or not IA that’s the question…

@jmplanche moi je bouge pas sans l’avis d’ @olivez https://t.co/JSx4QNUuTi

Un article sur l’#IA clair, documenté et lucide… https://t.co/orWaFwsbWf

> il n’y a pas d’IA sans accès à des données

> pour entrainer ses modèles

Ce n’est pas une règle absolue, certains programmes apprennent sans aucune donnée d’entrainement :

AlphaGo Zero: Learning from scratch

Oui, c’est vrai dans un tel cas. Mais gagner au Go n’a aucune application dans la vie courante. Les chatbots, la reco d’images, le machine learning et les systèmes experts ont tous besoin de données. Dans le cas d’Alpha Go, la data, ce sont juste les règles du jeu. Certaines IA savent détecter elles-mêmes les règles du jeu en observant des parties.

Deepmind pense pouvoir utiliser la même approche “Learning from scratch” à des problèmes tout à fait concrets :

“While it is still early days, AlphaGo Zero constitutes a critical step towards this goal. If similar techniques can be applied to other structured problems, such as protein folding, reducing energy consumption or searching for revolutionary new materials, the resulting breakthroughs have the potential to positively impact society.”

Je doute que Google/Deepmind ait investi autant d’argent juste pour gagner au go. C’était juste un modèle très utile pour tester de nouveaux concepts.

J’ai ajouté un “généralement” dans mon point sur les données nécessaires pour les principales solutions de de l’IA.

Il serait intéressant de segmenter les applications entre celles qui ont besoin de données et celles qui n’en ont pas besoin. Au nez, celles qui n’en ont pas besoin font de la simulation s’appuyant sur des lois bien définies et immuables, comme les règles de jeux de société, ou les lois de la physique ou de la chimie, d’où le repliement des protéines ou la simulation du comportement de matériaux qui sont évoqués.

Celles qui ont besoin de données ont un lien avec le monde extérieur qui ne peut pas être facilement représenté par les lois de la physique, comme le comportement des consommateurs, le cours de la bourse d’une entreprise ou même, le comportement du vivant au niveau macro, comme l’imagerie médicale. Et tout ce qui a trait au lien entre le monde et sa description par le langage, que l’on retrouve dans la vision artificielle ou le NLP.

Quand aux annonces de DeepMind, je les prendrais avec des pincettes, notamment pour ce qui relève du repliement des protéines. L’arbre de décision à élaguer pour gagner au jeu de Go présente une forte combinatoire mais est “discret”. Alors que le repliement des protéines n’est pas discret mais continu. Il s’agit de trouver le moyen d’optimiser une fonction d’énergie avec un nombre incroyable de paramètres qui sont continus et non discrets. Donc, l’approche de AlphaGo Zero n’est pas directement applicable à ce problème.

Il faudrait peut-être coupler leurs techniques avec des processeurs quantiques, y compris ceux sur lesquels bossent Google, et pas juste les D-Wave qui font du recruit quantique qui n’est pas considéré comme étant un véritable ordinateur quantique par les spécialistes.

L’horizon de tout cela est plutôt lointain. Au sens… au-delà de 5 ans.

Il semble que Deepmind obtient de très bon résultats plus rapidement que prévu dans ce domaine, avec AlphaFold :

https://www.sciencemag.org/news/2018/12/google-s-deepmind-aces-protein-folding

Merci. La performance de Deep Mind sur le repliement des protéines est à prendre avec des pincettes. L’article indique qu’elle est équivalente à d’autres méthodes connues, pas qu’elle est excellente. On n’a notamment pas d’indication de l’exactitude des repliements calculés, juste une comparaison. Il faut toujours lire entre les lignes de ce genre d’annonce…

AlphaFold a tout de même remporté la compétition !

https://youtu.be/cEOAerVz3UU?t=3492

La suite de la présentation donne des indications sur les taux d’erreur et la comparaison avec les autres équipes.

Oui, certes, mais pas encore au point d’augmenter significativement la taille des protéines simulées. Peut-être en raison de la base d’entraînement utilisée.

Quand on parle d’IA, ne pas oublier non plus que l’informatique en général était considérée comme des machines intelligentes. Le biais postérieur est qu’on considère que dès qu’une machine peut le faire, ce n’est plus intelligent – outre qu’on idéalise l’humain en faisant semblant de croire qu’il est lui même si intelligent qu’il incarne toutes les formes admirées d’intelligences!

Dans mon bouquin (“Philosophie contre IA”), j’ai cité un bon exemple de cette problématique dans le cas de la soeur de Blaise Pascal à propos de la machine à calculer inventée par son frère: « L’esprit avait été en quelque sorte capturé par la machine » car « il était possible d’exécuter sans erreur toutes sortes de calculs, chose extraordinaire sans crayons, mais, bien plus, sans même connaître l’arithmétique » (René Moreau, “Ainsi naquit l’informatique”, p. 13). C’est autant intéressant de voir ce que pensaient les gens de cette époque que de voir qu’on ne s’étonne pas de tout ce que font les ordinateur, “simple” calcul compris. Ce n’est pas très… intelligent.

Nous sommes en phase ! L’IA est souvent considérée comme IA lorsqu’elle conserve un côté magique. Quand on ouvre le capot, la magie disparaît et ce n’est plus de l’IA, mais de la plomberie probabiliste !

C’est pour cela que je préfère éviter ces querelles épistémologiques et plutôt adopter un regard historique. L’IA est une discipline scientifique à la croisée des chemins qui a été créée en 1955. Avec de nombreux objectifs pas encore atteints. C’est un peu la même chose avec la cancérologie, qui n’a pas permis, pour l’instant, de guérir tous les cancers, même si elle permet d’améliorer petit à petit le taux de survie des patient.

Et il faut accepter le côté artificiel de l’IA, qui ne ressemble donc pas et ne peut pas ressembler à ce que l’on croit comprendre de l’intelligence humaine. Il faut sortir de la vision anthropomorphique pour décrire des machines !