Depuis 2015, la vague de l’intelligence artificielle bat sont plein dans l’écosystème numérique et bien au-delà. C’est même déjà devenu un sujet politique. Nous sommes bombardés d’annonces sensationnelles à répétition et des prospectivistes professionnels nous dépeignent un futur parfois utopique et le plus souvent dystopique à l’image d’une bonne partie de la science fiction.

La réalité d’aujourd’hui sur laquelle ils s’appuient est souvent travestie et exagérée. L’IA est parée de capacités qu’elle n’a pas encore et n’est pas prête d’avoir. On est en pleine construction d’une vision mythique de l’IA, basée sur des mécanismes de propagande de l’innovation que j’avais eu l’occasion de décrire en 2014 dans une série de six articles. Ces mécanismes sont amplifiés par la communication marketing des fournisseurs tels qu’IBM et Google qui embellissent toujours la mariée, par une stratégie de la sidération, par la difficulté de vérifier les faits avancés ou la fainéantise intellectuelle ambiante, et par l’absence généralisée de connaissances techniques sur l’IA, même chez la majorité des spécialistes du numérique.

Le phénomène est notamment lié à l’appellation même de l’IA, lancée en 1955 par John MacCarthy lorsqu’il proposa la tenue d’un summer camp pour l’été 1956 au collège de Darmouth dans le New Hampshire. C’était une appellation marketing créée pour faire parler d’elle et l’effet s’en ressent encore aujourd’hui. A tel point que les débats sont sans fin pour définir la nature même de l’intelligence humaine et celle que les machines peuvent acquérir. On en vient parfois à qualifier d’IA ce que les machines ne peuvent pas encore faire. Dès que la magie des tours de l’IA d’aujourd’hui est révélée, pour certains, ce n’est plus de l’IA !

Vous entendez aussi les mêmes arguments jusqu’à la lie. IBM Watson est le Rémy Bricka de l’IA qui sait tout faire, DeepMind AlphaGo symbolise l’intelligence de la machine, le dernier futur-processeur d’Intel Loihi imite le cerveau humain (avec 130 000 neurones…), les voitures autonomes sont pour tout de suite et des solutions marketing miracles vont même prédire à l’avance ce que vous allez désirer et acheter. Bref, l’IA incarne un déterminisme futur prêt à défier toute forme de sérendipité, de hasard et de libre arbitre pour ce qui concerne votre petite vie monotone.

Trop souvent, les études de cas sont bien enjolivées comme avec ce fonds d’investissement Deep Knowledge Venture de Hong Kong et Londres qui nommait en 2014 une IA à son board, dénommée VITAL ! Elle devait servir à identifier les projets les plus prometteurs dans lesquels investir. Le logiciel est ainsi facilement passé de membre du board à CEO de l’entreprise ! Son modèle est en tout cas récursif car ce fonds a investi dans Transplanetary, une startup spécialisée dans la recommandation d’investissements dans les industries spatiales, avec son logiciel SPOCK (Space Program Ontologically Computed Knowledge). Il y a aussi ces solutions d’IA “precogs” qui pourraient prédire les heures et lieux des crimes à Londres alors, que dans la pratique, il s’agira de déterminer les risques de récidives de suspects en garde à vue (source). Et c’est à Durham, qui est à plus de 300 km de Londres ! A chaque annonce, il faut quasiment tout vérifier !

Enfin, les prévisions vont bon train sur la disparition des emplois : jusqu’à 50% d’ici 2025 sachant que des études récentes sont descendues à 7% en net. En oubliant au passage qu’une bonne part de la disparition de métiers ne vient pas spécifiquement de l’IA mais de l’automatisation et du transfert du travail vers… les clients, comme pour les caisses automatiques dans la distribution ou dans une bonne part de l’économie collaborative.

La suprématie des GAFAMI est souvent montée en épingle, érigée en barrière insurmontable pour les autres innovateurs. On vous rabattra les oreilles avec la création de valeur de Whatsapp vs celle de PSA et la comparaison du nombre de salariés (55 vs plus de 200000). Et tant qu’à faire, d’ici même pas 10 ans, nos cerveaux seront directement connectés aux “IA”. La preuve : Neuralink et Facebook y travaillent ! Pas la peine de résister !

Ces prospectivistes diablement efficaces dans leur communication sont rarement des spécialistes de l’IA au sens scientifique du terme. Et quand ils le sont, les exagérations subtiles s’accumulent sur leurs fonctions. L’exemple le plus connu est celui de l’empereur des prévisions et le prince consort de la singularité Ray Kurzweil qui est présenté selon les jours comme dirigeant toute la R&D, toute la recherche ou toute l’ingénierie de Google, alors qu’il ne dispose que d’une petite équipe d’une vingtaine de personnes et ne dirige ni Google Brain ni Deep Mind qui sont les deux principales entités de recherche de Google dans l’IA. C’est totalement anecdotique mais fait partie de la manière on enjolive les choses pour faire passer ses messages ampoulés sur l’IA.

A force de ne parler que du futur, on en oublie le présent ! Cette société de l’IA du spectacle créé une atmosphère délirante qui devient perturbante pour les entreprises. Certes, elle va les titiller, éventuellement leur faire peur et peut-être aiguiser leur intérêt. Elles se demandent surtout comment intégrer l’IA dans leur stratégie et ont besoin de revenir sur terre, à des choses pratiques et faisables.

L’IA constitue bien une évolution majeure des outils numériques. Il faut en appréhender les enjeux et les opportunités. Ceux-ci n’ont rien de sensationnel. Le potentiel de l’IA est énorme pour les entreprises de tous les secteurs d’activités mais encore faut-il conserver la tête sur les épaules pour l’appréhender posément. Les technologies d’aujourd’hui sont déjà suffisamment riches pour être créatifs et innovants ! Pas besoin d’en faire des tonnes ! Par ailleurs, l’automatisation à outrance a des limites qu’il faut évaluer. Les entreprises doivent conserver un minimum de visage humain et ne pas passer leur temps à se cacher derrière des logiciels !

Voici donc venue l’heure du défouloir avec quelques-uns de ces nombreux mythes sur l’IA. Cet inventaire n’est évidemment pas complet et libre à vous d’en ajouter !

1) Les algorithmes de l’IA n’auraient pas évolué en 20 ans

Un lieu commun voudrait que les algorithmes de l’IA n’évoluent pas et que tous les progrès récents soient essentiellement liés à ceux du matériel et à l’abondance de données exploitables.

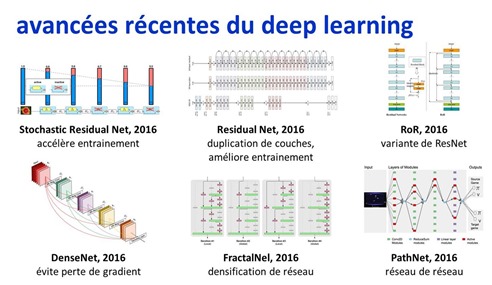

Les progrès algorithmiques sont effectivement faibles dans le machine learning car celui-ci s’appuie sur des méthodes de classification, prédiction et segmentation qui datent d’une à deux décennies. Il en va tout autrement du deep learning. Ses bases modernes datent de 2006 et ses techniques n’ont cessé d’évoluer depuis. Rien qu’en 2016, les réseaux de neurones convolutionnels qui servent notamment à la reconnaissance d’images ont bénéficié de nombreuses nouvelles déclinaisons sans compter les réseaux génératifs capables de transformer et générer des images. C’est seulement depuis 2015 que ces réseaux permettent de tagger efficacement plusieurs objets dans une image ou une vidéo.

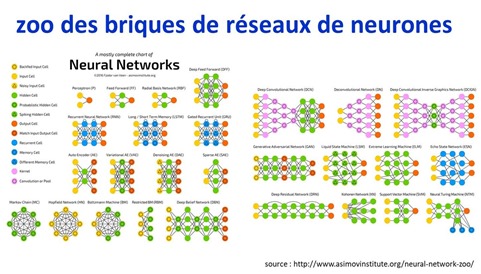

Le “zoo” des réseaux de neurones est complexe (ci-dessous). Le deep learning requiert des techniques d’assemblage de ces briques qui évoluent sans cesse. Elles visent en général deux objectifs complémentaires : améliorer la performance qualitative des réseaux de neurones, notamment dans la reconnaissance d’objets, et améliorer celle de l’entrainement qui est très couteuse en ressources machines, même avec des GPUs et des processeurs neuromorphiques comme les TPU de Google.

Qui plus est, les travaux de recherche publiés dans les grandes conférences internationales de l’IA sont très nombreux, ce que l’on peut constater dans les récentes conférences IJCAI de 2017 et NIPS de 2016. Nombre de travaux portent sur le traitement du langage et le raisonnement automatisé. Celui-ci s’appuie sur de nombreuses variantes de réseaux de neurones dits récurrents et à mémoire.

Les réseaux de neurones à mémoire qui servent surtout au traitement du langage (reconnaissance, traduction, génération) ont de nombreuses déclinaisons avec notamment : Stacked RNN (RNN empilés), MARNN (Memory-Augmented Recurrent Neural Networks), LSTM (Long Short Term Memory), les GRU (Gated Recurrent Units), BLSTM (Bidirectionnal Long Short Term Memory), BPTT (BackProp Through Time) et RTRL (Real Time Recurrent Learning) dont je vous épargne les détails. Ils permettent surtout de tenir compte du contexte dans lequel les objets comme des mots sont détectés pour analyser le sens d’une phrase. L’un des points clés de ces réseaux est leur capacité à mémoriser des contextes

Tous ces travaux de recherche ont une particularité : ils sont exploitables assez rapidement car ils sont publics et relativement facilement reproductibles avec les outils open source du marché tels que TensorFlow ou Torch.

2) L’IA se résumerait au machine learning et au deep learning

Le deep learning est monté en épingle comme la solution miracle à tous les problèmes que l’IA cherche à résoudre. Le “deep” du deep learning est à prendre au premier degré : ses réseaux de neurones sont profonds car multicouches. Cela ne les rend pas nécessairement profonds du côté de l’intelligence même si leur fonctionnement relève d’une forme de biomimétisme du cortex visuel. Seulement voilà, l’intelligence humaine ne fonctionne pas exactement comme les réseaux de neurones du deep learning actuels ! Ces réseaux n’ont qu’une vue statistique et chiffrée des objets qu’ils analysent. Elle n’est ni sémantique ni analytique. Le deep learning est-il l’aboutissement ultime de l’IA ? Non, il ne sert qu’à résoudre certaines classes de problèmes, tout du moins avec l’état de l’art actuel.

Le vaste champ de l’IA comprend d’autres techniques, notamment autour de l’IA symbolique, de la programmation logique et des moteurs de règles. L’actualité les a mis en sourdine en raison du tintouin autour du deep learning. Mais celui-ci a des limites. Les meilleures solutions d’IA intègrent et assemblent souvent plusieurs techniques différentes.

Il faut d’ailleurs y intégrer le vaste domaine des réseaux d’agents qui servent à assembler les briques des solutions d’IA. On les utilise aussi bien pour construire des chatbots que pour piloter des robots.

3) La donnée serait la principale composante de l’IA

Les données sont une des trois composantes clés des solutions d’IA avec la puissance des machines et des algorithmes. Mais elles ne font pas tout. Il s’agit d’une véritable triade. Sans les trois éléments, l’IA ne produit pas grand chose. Certaines études portant sur un seul type de réseau de neurones montrent qu’une IA avec plus de données est plus efficace qu’une IA avec un meilleur algorithme. Mais l’algorithme de départ est déjà bon !

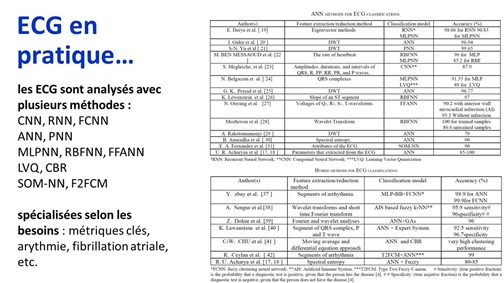

La performance des algorithmes joue un rôle clé dans la qualité des résultats dans le deep learning, et surtout dans leur performance, notamment la rapidité de la phase d’entrainement des modèles. Parfois, comme pour analyser des électrocardiogrammes (ECG), il peut aussi être nécessaire d’associer une bonne demi-douzaine de méthodes différentes pour produire un diagnostic complet !

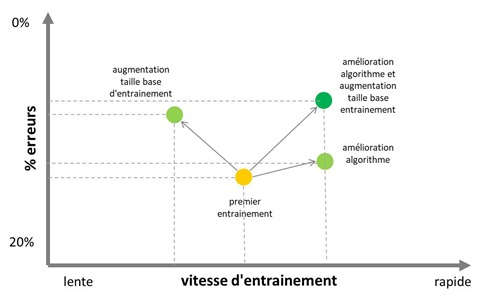

Pour ce qui est de la reconnaissance des images, il faut distinguer le temps d’entrainement et le pourcentage de bonnes reconnaissances. Les progrès des algorithmes visent à améliorer l’une comme l’autre. La taille des jeux de données est en effet critique pour bien entrainer un modèle. Si l’algorithme utilisé n’est meilleur que dans la vitesse d’entrainement, ce qui est souvent le cas dans des variantes de réseaux de neurones convolutionnels, alors, la performance de la reconnaissance ne changera pas lors de l’exécution du modèle entrainé. Par contre, avec plus de données d’entrainement, celui-ci sera plus long.

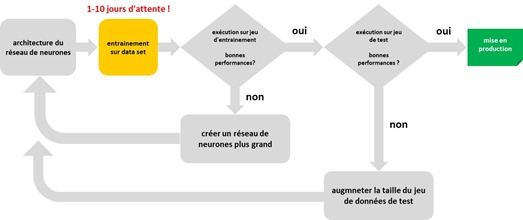

Donc, comme illustré dans mon petit schéma ci-dessus, il faut à la fois de meilleurs jeux de données et de meilleurs algorithmes pour que l’entrainement soit aussi rapide que possible et que les résultats génèrent ensuite le moins d’erreurs possible.

4) L’IA se formerait instantanément

Le temps d’entrainement d’un système mono-fonction de deep learning se compte au minimum en heures ou en jours, voire en semaines, comme pour la reconnaissance d’images pour l’interprétation d’imagerie médicale. Qui plus est, l’IA ne s’entraine pas toute seule. Elle requiert beaucoup d’itérations avec de l’intervention humaine.

La notion de systèmes auto-apprenants dans le machine learning est une vue de l’esprit. Les data scientists doivent faire de nombreux tests et de la supervision pour choisir les bons modèles statistiques de segmentation, classification ou prédiction ! Pour les réseaux de neurones du deep learning, ils doivent réaliser des tests pour en dimensionner les grandes caractéristiques et évaluer leur efficacité avec les jeux de données disponibles. Les itérations peuvent être très longues et laborieuses si les jeux d’entrainement et de tests sont importants. Elles peuvent durer plusieurs jours, ce qui est bien plus long qu’une compilation de code ou l’exécution immédiate de la plupart des codes interprétés utilisés dans le monde du web.

Par contre, il est vrai qu’une fois qu’un modèle de machine learning ou de deep learning a été entrainé avec succès, son exécution opérationnelle est alors très rapide. Dans le cas du deep learning, c’est assez simple à comprendre : un réseau de neurones convolutionnel de reconnaissance d’images peut comprendre des millions de paramètres qu’il faut ajuster en faisant des tests pour chaque objet de la base de test. Cela génère une combinatoire de calcul immense. Lorsque le modèle est entrainé, il suffit de charger les variables en question qui ne bougent plus et de faire passer l’objet à reconnaitre au travers du réseau de neurones devenu ainsi statique. Et comme il s’agit de logiciel, le coût de réplication et d’exécution de la solution est en effet très faible.

Nous avons au bout du compte un entrainement laborieux et une exécution effectivement peu couteuse. Cela explique la présence de noyaux neuromorphiques dans les derniers processeurs mobiles (Kirin 970 pour Huawei et A11 Bionic Neural Engine pour les iPhone 8 et X) : ils sont peu puissants (1 à 2 TFlops/s) mais ne servent qu’à l’exécution de réseaux de neurones déjà entrainés sur serveurs avec des moyens bien plus importants, comme pour la reconnaissance d’images ou de la parole.

On oublie aussi que la majorité des solutions d’IA, comme celles de l’exploitation d’imagerie médicale, s’appuie sur des bases de connaissances qui sont le résultat de longues recherches scientifiques réalisées par des milliers de spécialistes. Quand AlphaGo gagne contre le champion du monde, il exploite aussi 150 000 parties des meilleurs joueurs du monde. Cette connaissance d’origine humaine a mis du temps à se construire. L’IA est souvent un “free rider” qui exploite cette longue accumulation.

Un jour peut-être, certaines IA seront capables d’interagir avec le monde physique et d’accumuler des connaissances de haut niveau basées sur l’expérimentation. Aujourd’hui, ce principe commence à être opérant avec des robots qui apprennent à se mouvoir par apprentissage itératif. L’équivalent intellectuel n’est pas encore là, notamment dans la faculté de raisonner par analogies. Mais des chercheurs et des startups y travaillent !

5) L’IA serait quasiment gratuite

L’IA serait aussi gratuite et abondante. Elle apparait gratuite dans les services en ligne grand public qui sont financés par la publicité. Avec ou sans IA d’ailleurs. C’est le cas des modèles économiques bifaces où l’utilisateur n’est pas l’acheteur. Et ce n’est pas spécifique à l’IA.

De son côté, l’IA en cancérologie n’est pas encore commercialisée gratuitement ! Et pour cause, les sociétés qui en proposent doivent la monétiser et elles ne peuvent pas le faire directement auprès des patients car cela relèverait d’un exercice illégal de la médecine. Qui plus est, comme nous le verrons plus loin, ces solutions ne font pas encore des miracles. Les questions de biologie ne se traitent pas uniquement avec des statistiques ! Ces solutions aident les spécialistes dans les diagnostics et les prescriptions mais ne les remplacent pas encore.

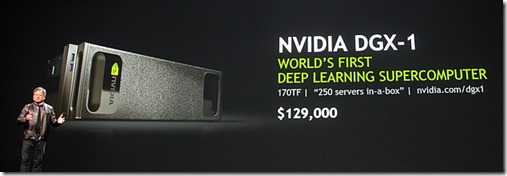

Enfin, l’IA n’est pas du tout gratuite du côté du cloud et des data centers qu’elle nécessite pour son fonctionnement. Un serveur Nvidia DGX1 coute la bagatelle de $129K ! Certes, ces machines bénéficient de la dimension économique de la loi de Moore et leur prix baisse régulièrement. Mais au gré de cette baisse, les besoins matériels des solutions d’IA augmentent et l’ensemble s’équilibre.

Par contre, lorsqu’un logiciel ou une IA peut remplacer une activité humaine, il est fréquent qu’elle soit moins chère que cette dernière et surtout dans les pays développés où le cout du travail est élevé. L’IA n’a pas besoin d’être gratuite pour être compétitive. Si elle est 10 fois moins chère qu’un équivalent humain, c’est déjà une révolution ! C’est d’ailleurs l’argument marketing qui est utilisé par les fournisseurs de solutions de Robotics Process Automation, qui visent à automatiser les fonctions bureaucratiques qui font appel à une multitude d’applications métiers. Elles commencent à être émerger aux USA dans la banque et l’assurance.

6) IBM Watson remplacerait les cancérologues

En fait, pas encore ! IBM a beaucoup communiqué sur des déploiements d’IBM Watson for Oncology, mais derrière un marketing puissant qui a démarré il y a quelques années, les déploiements significatifs ne sont pas encore là pour permettre une mesure réelle des bénéfices. Et ceux-ci sont généralement surévalués. Cf IBM pitched its Watson supercomputer as a revolution in cancer care. It’s nowhere close de Casey Ross., septembre 2017, qui décrit bien la situation.

C’est explicable par au moins trois phénomènes :

- Les bases de connaissances sont biaisées ! Dans How to Make More Published Research True, John Ioannidis expliquaient en 2014 que 85% des ressources des chercheurs sont gaspillées et leurs résultats publiés sont faux ou exagérés. Dans Raise standards for preclinical cancer research, Glenn Begley et Lee Ellis indiquaient en 2012 que 90% des résultats de 53 études majeures dans le domaine du cancer n’étaient pas reproductibles. Donc, si elles sont utilisées par Watson, il ne peut pas en sortir grand-chose d’utile ! Voire, cela peut même être dangereux. Enfin, dans Believe it or not: how much can we rely on published data on potential drug targets?, Florian Prinz, Thomas Schlange et Khusru Asadullah indiquaient en 2011 que 79% des résultats de 67 travaux de recherche en cancérologie et cardiologie n’étaient pas reproductibles chez Bayer. Qui plus est, les recherches qui donnent lieu à des résultats négatifs sont bien moins publiées que celles qui sont concluantes. Ce sont toutes ces études qui alimentent Watson for Oncology ! Le biais statistique qu’elles induisent n’est pas marginal. Il est potentiellement énorme et à même d’influer sur la qualité des résultats alors que des données fausses à quelques % n’auraient qu’un impact limité !

- Les cancers sont des maladies plurifactorielles complexes. Les échantillons de patients pour lesquels on dispose du génotype et du phénotype complets ne sont pas toujours suffisamment représentatifs d’un point de vue statistique pour que l’on puisse en tirer quelque chose pour chaque patient. L’une des approches actuelles est de créer des immunothérapies ciblées autologues, personnalisées en fonction de chaque patient. Ce sont des approches très couteuses, jusqu’à $400K par an de traitement. Et Watson ne contribue pas du tout à en baisser le prix.

- Les projets à base d’IBM Watson démarrent lentement en phase pilote. Le processus est laborieux, sachant que les praticiens ne sont pas bien rapides pour changer leurs habitudes, même aux USA.

Par contre, IBM Watson et de nombreux concurrents sont très efficaces dans l’analyse d’imagerie médicale, qui ne requiert pas de maitriser des paramètres biologiques complexes comme en cancérologie. Il faut donc faire la part des choses entre le diagnostic qui peut faire appel à des analyses génomiques ou à de l’imagerie médicale et à la prescription automatisée et optimale au cas par cas qui est plus difficile à automatiser compte-tenu des données disponibles.

7) Les progrès de l’IA seraient plus qu’exponentiels

Selon Laurent Alexandre (UE MEDEF 2017), l’IA verrait sa productivité multipliée par 100 chaque année. Selon quelle unité de mesure ? Ni l’IA ni la loi de Moore n’évoluent aussi rapidement, même avec les processeurs neuromorphiques et les GPU. Il en va de même sur l’aspect fonctionnel.

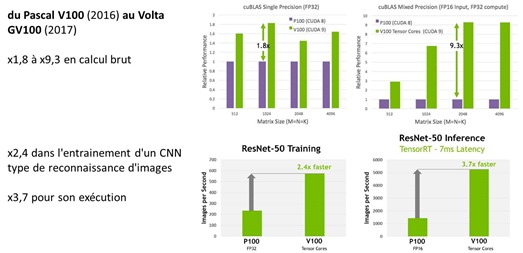

Les progrès dans le matériel sont pourtant bien significatifs. Entre les deux dernières générations de GPU Nvidia (Pascal V100 de 2016 et Volta GV100 2017), le gain de performance brut dans les calculs liés au deep learning vont d’un facteur 1,8 à 9,3. C’est lié à l’utilisation de multiplicateurs de matrices dans cette nouvelle génération de GPU, une technique que l’on ne trouvait jusqu’à présent que dans les processeurs neuromorphiques.

Dans la pratique, l’entrainement d’un réseau de neurones convolutionnel de type ResNet pour la reconnaissance d’images est 2,4 fois plus rapide et son exécution en run-time est 3,7 fois plus rapide entre ces deux générations de GPU. C’est très bien mais on est loin d’un facteur 100 qui permet d’impressionner un auditoire ! Par contre, évidemment, si vous en alignez 40 en parallèle, l’entrainement ira en effet 100 fois plus vite qu’avec un GPU d’ancienne génération dans la mesure où les frameworks de deep learning savent assez bien paralléliser l’entrainement sur plusieurs GPU. Ce, d’autant plus qu’ils sont reliés entre eux par des bus de données très rapides comme NVLink, qui pédale à 300 Go/s avec cette dernière génération de GPU.

Par contre, des progrès matériels et conceptuels pourront intervenir par à-coups dans le futur, notamment avec les processeurs neuromorphiques, les processeurs optiques (cf les premières expérimentations de réseaux de neurones sur processeur photonique ainsi que ce que fait la startup française LightOn) et les processeurs quantiques qui pourront chacun faire progresser significativement la puissance de calcul et surtout d’entrainement des IAs et ouvrir le champ des possibles dans des domaines variés comme la simulation du vivant, la découverte de nouvelles thérapies ciblées et la simulation dans la physique des matériaux et la chimie.

8) L’AGI est la suite logique de l’ANI

ANI (IA étroite), AGI (IA générale) puis ASI (IA supérieure) : c’est la suite logique de l’histoire de l’IA à venir, érigée comme un dogme.

L’un des travers de ce dogme est de s’appuyer sur un prédicat erroné qui positionne l’intelligence humaine et celle des machines sur une seule dimension, celle de la puissance brute de calcul. On compare donc des capacités de calcul du cerveau humain (qui calcule peu et est massivement parallèle et maillé) et de machines (qui, pour faire simple, font des opérations + – / * et des opérations sur des matrices) en négligeant de nombreux points clés comme les entrées-sorties.

L’AGI (Artificial General Intelligence) serait l’aboutissement mécanique de l’application bête de la loi de Moore. Tout au plus doit-on régulièrement en repousser l’échéance du fait des découvertes incessantes sur la complexité du cerveau. Et c’est sans compter l’avènement de l’ASI, une intelligence ultra-supérieure, incontrôlable et unique (ASI) qui serait quasiment instantané après celui de l’AGI.

Les prévisions oublient de mentionner ce que l’on découvre régulièrement sur la complexité du cerveau et de la mémoire. On ne sait d’ailleurs toujours pas décrire avec précision le fonctionnement de cette dernière. Le fonctionnement des neurones pourrait être bien plus complexe qu’estimé il y a 10 ou 15 ans.

L’intelligence humaine est complexe. Elle est liée à la sophistication du cerveau et aussi à nos sens, à notre vécu et à notre perception du monde. Les sens humains et même ceux des mammifères sont encore plus difficiles à imiter par des machines que certaines capacités intellectuelles. On parle toujours du cortex qui gère l’intelligence mais on néglige systématiquement le cervelet, cette partie du cerveau ultra-dense qui comprend quatre fois plus de neurones que le cortex et gère les automatismes appris (marche, mouvements occulaires, conduite, vélo, marche, danse, préhension, …). Qui plus est, les mammifères sont plutôt efficaces côté consommation énergétique : un humain consomme 100 W au repos et son cerveau 20 W, le double d’un laptop d’aujourd’hui. Et les IA du moment sont bien plus consommatrices d’énergie, sans parler des robots.

Les prospectivistes de l’IA adoptent généralement une vision trop linéaire de l’histoire des technologies. Celle-ci suit plusieurs chemins en parallèle. Elle est diverse, même dans les infrastructures matérielles. D’ailleurs, même le Skynet de Terminator n’était pas centralisé mais disséminé dans tous les ordinateurs, propagé par un virus hostile !

Qui plus est, les machines ont presque toujours besoin d’interventions humaines. Leur intelligence mécanique est alimentée par l’expérience et l’intelligence humaines. L’expérience montre aussi que des IA couplées à des hommes sont supérieures aux IA seules. Enfin, les Hommes et les machines n’ont pas les mêmes capacités et se complètent. Les machines dépassent déjà très largement l’Homme dans un tas de domaines sans que cela relève d’une intelligence surhumaine.

9) Les prospectivistes de l’IA seraient des spécialistes de l’IA

En pratique, c’est bien rare ! La plupart n’ont jamais codé quoi que ce soit dans l’IA, moi compris d’ailleurs, même si j’ai examiné de près des exemples de code Torch ou TensofFlow de création de réseaux de neurones convolutionnels.

Nous en avons un bel exemple avec cette conférence parmi d’autres sur laquelle je suis tombé par hasard : Où va nous mener d’intelligence artificielle, d’un certain Georges Mitaut, en décembre 2016, réalisée par un ingénieur en télécommunications retraité, qui ressasse les lieux communs habituels sur l’IA et la singularité sous forme d’une revue de presse bien slidisée. Au milieu de sa présentation et à propos de Google se trouve un logo de TensorFlow. Le conférencier indique alors que cela fait de l’IA mais qu’il n’a aucune idée de ce que cela peut bien faire et comment cela fonctionne ! Ce n’est pas une exception ! La majorité des conférenciers sur l’IA font de la prospective alors qu’ils ne connaissent même pas les mécanismes de l’IA et l’état de la recherche fondamentale. C’est consternant et très courant !

Il est d’ailleurs très difficile d’avoir une bonne vue d’ensemble des techniques de l’IA tellement elles sont diverses et le savoir associé est fragmenté. J’y consacre une bonne partie de mon temps depuis des mois et plus j’avance, plus j’en sais et moins j’en sais ! Une bonne approche consiste à appréhender les caractéristiques et limites des techniques existantes, celles de ses connaissances et d’avoir toujours en tête diverses interrogations. C’est un tonneau des Danaïdes que je remplis et vide perpétuellement ! Il n’y a pas de science sans questionnement.

En matière de prévisions, on se trouve confronté à une opposition classique entre ceux qui adoptent une vision macro et ceux qui en ont une vision micro, comme si la seconde était exclusive de la seconde. Pour sortir des mythes, il vaut mieux écouter ou lire les chercheurs Yann LeCun, Jean-Gabriel Ganascia (auteur du “Mythe de la singularité”), Stéphane Mallat ou Piero Scaruffi qui connaissent bien les arcanes scientifiques des réseaux de neurones et ont une vision plus posée des potentialités de l’IA.

Face à l’argument du “tout est possible”, il est difficile d’argumenter. Les capacités de prédiction de Ray Kurzweil sont souvent enjolivées. Elles sont très biaisées pour ce qui relève du futur lointain. Elles peuvent être correctes pour les sciences et technologies relevant de l’univers possible de l’époque de la parution de ses ouvrages. Sa méthode est assez simple : il fait une pige de la recherche au moment où il écrit ses bouquins et extrapole à partir de là. Quand ces travaux n’aboutissent pas aussi rapidement que prévu, les prévisions font choux blanc, comme dans les nano-technologies, dont le potentiel était nettement surévalué il y a une quinzaine d’années.

10) Les GAFAMI vont tout dévorer

Autre méthode pour se faire peur, exagérer la position stratégique des GAFAMI (Google, Apple, Facebook, Amazon, Microsoft, IBM) et prévoir qu’ils vont occuper tous les pans de l’économie, y compris ceux de la santé, des transports et de la finance. Google deviendrait un laboratoire de pharmacie et un constructeur automobile, sorte de variante américaine des chaebols coréens.

Mais les AFAMI n’ont pas trop de velléités de s’aventurer dans des métiers éloignés des leurs, étant déjà bien occupés. Amazon a ainsi suffisamment de grain à moudre pour se développer dans toutes les facettes du retail, des contenus et du cloud. Et surtout, étant parmi les sociétés les plus profitables du monde en % du CA, ces nouveaux métiers auraient un impact dilutif sur leur modèle économique. Ils auront donc plutôt tendance à se concentrer sur les plateformes technologiques numériques alimentant ces métiers plutôt qu’à en assumer toute la coûteuse chaîne de valeur.

Dans la pratique, Google a bien des prétentions dans la gestion de l’information. Ses serveurs et logiciels sont utilisés par des chercheurs dans les biotechs. Mais ce ne sont pas les quelques dizaines de chercheurs de Calico qui font de Google un leader des biotechs ! Même si ils planchent sur la lutte contre le vieillissement. Quand à Verily, une autre filiale d’Alphabet, elle se positionne dans la gestion des données. Ses deux projets de medtechs de mesure continue de la glycémie ont donné lieu à une industrialisation, toujours en devenir, par deux pure players du secteur : Dexcom et Novartis. Tous ses autres projets de recherche ont donné lieu à des “partenariats” avec des entreprises du secteur de la santé, dont Sanofi, GSK, AstraZeneca, ainsi que Nikon (pour la détection optique de rétinopathie, une application classique du deep learning en vision, aussi réalisée par IBM Watson et diverses startups).

Cette confusion est entretenue par la notion galvaudée de “partenariat”. De nombreuses annonces d’un partenariat entre la société X et Y relèvent simplement du fait que la société X utilise la technologie de la société Y, rien de plus. Ainsi, lorsque Google est partenaire de D-Wave et de la NASA dans l’informatique quantique, Google ne fait qu’utiliser les ordinateurs de D-Wave pour mener des tests avec la NASA. Ensuite, peut-être, décidera-t-il de concevoir ses propres ordinateurs quantiques si le besoin s’en fait sentir et si les économies d’échelle le justifient.

En 2014, Google avait fait coup sur coup l’acquisition de huit startups dans la robotique, dont la fameuse Boston Dynamics mais aussi Schaft, Industrial Perception, Redwood Robotics, Meka Robotics, Holomni, Bot & Dolly et Autofuss. Ca y était : Google allait devenir le roi de la robotique ! Les dés étaient joués. Ils avaient aspiré toutes les compétences du marché dignes de ce nom ! Trois ans plus tard, Google a cédé Boston Dynamics et Schaft à Softbank Robotics qui avait déjà gobé le français Aldebaran Robotics en 2012. Et personne n’avait remarqué que les autres startups étaient spécialisées dans les bras robotisés surtout utilisés dans les voitures qui scannent les rues pour Google StreetView. Ce genre d’entreprise est fluide. Google se lance ici et là et abandonne la mise si cela ne se passe pas comme prévu, comme avec Motorola. C’est l’application du fameux adage de l’échec formateur, un échec d’autant plus toléré dans une société qui croule sous le cash. Et les corrections de tirs sont rapides.

Ces abus de langage sur les GAFAMI contribuent à créer une impression selon laquelle l’AI est réservée à une élite technologique et pour les GAFA. Dans la pratique, l’IA est exploitable par toutes les entreprises, notamment via les nombreuses ressources disponibles dans le cloud. Tout est en open source, les logiciels comme les méthodes de l’IA.

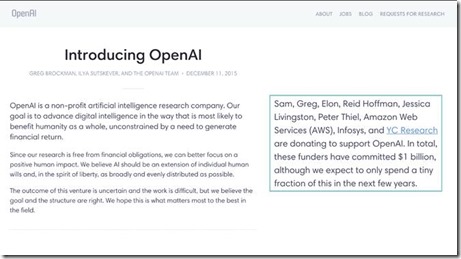

11) Avec OpenAI, les GAFAMI deviendraient responsables

Les dangers perceptibles de l’IA sont à l’origine de la création d’OpenAI, une initiative visant non pas à créer une IA open source – les logiciels de l’IA sont déjà presque tous open source – mais à surveiller et analyser ses évolutions. Il s’agit d’une ONG créée par Elon Musk qui veut s’assurer de manière asez manichéenne que l’IA fasse le bien et pas le mal. Elle est dotée de $1B et doit faire de la recherche. C’est un peu comme si une organisation patronale s’était lancée dans une initiative visant à rendre le capitalisme responsable. C’est d’ailleurs la mission que voudraient se donner différents Etats en orientant la recherche et les investissements vers de l’IA responsable dans la lignée de la « tech for good », la technologie pour le bien de l’Humanité et pas celle qui sert à la publicité ciblée qui est sa contraposée la plus courante.

C’est la forme que prend Partnership on AI, une initiative et association créé en 2016 et rassemblant comme membres fondateurs un bon bout des GAFAMI : Google, Facebook, Amazon, Microsoft et IBM. Il manquait Apple qui les a rejoints en janvier 2017. Donc, ce sont bien exactement les GAFAMI au complet ! L’association est présidée par Eric Horvitz, le patron de Microsoft Research et Mustafa Suleyman de Google, le co-fondateur de DeepMind. Elle doit débattre des questions soulevées par l’IA et des meilleures pratiques à adopter pour en mitiger les risques. Quand on y regarde de près, cette association prend la forme d’une organisation de lobbying avec les méthodes associées : des thématiques à défendre, l’appel à des experts divers, l’organisation de débats et un pied dans la porte des politiques pour éviter des dérives réglementaires gênant l’innovation. Eric Horvitz promeut de son côté l’utilisation de l’IA pour le bien de l’humanité.

Une autre initiative associe deux fondatrices issus de Microsoft Research et Google : ArtificialIntelligenceNow, lancée mi 2016 par Kate Crawford (Microsoft Research) et Meredith Walker (Google Open Research Group). Basée à New York, elle est est focalisée sur l’impact de l’IA sur les droits civiques, sur l’emploi, les biais et la sécurité des infrastructures. Elle a publié un premier rapport en 2016.

Sous des couverts de bonne gestion du principe de précaution, ces initiatives des GAFAMI sont à évaluer sous la loupe des pratiques habituelles du lobbying. Elles visent à calmer les peurs et à assurer les pouvoirs publics qu’une autorégulation de l’IA est possible par les acteurs de l’industrie. Cela vise surtout à éviter que ces derniers s’immiscent dans la stratégie de ces grands acteurs. Et dans le cas où il viendrait à l’idée des pouvoirs publics de réguler l’IA d’une manière ou d’une autre, d’être prêt avec des propositions compatibles avec leurs stratégies. C’est de bonne guerre mais il ne faut pas être dupe ! Les GAFAMI ont plus peur des Etats et de l’utilisations qu’ils pourraient faire de l’AI que de leurs propres AIs.

12) La connexion cerveau – IA serait pour demain

Avec Neuralink, la dernière startup créée par Elon Musk, on va bientôt connecter les enfants à l’IA et l’éducation sera dépassée par l’IA. Neuralink a en effet annoncé en avril 2016 plancher sur des nano-électrodes permettant la connexion du cerveau à un ordinateur. Facebook travaille de son côté sur un casque de télépathie de cerveau à cerveau en 2019 alors qu’au mieux, il permettra de dicter un texte, lettre par lettre. De son côté, la startup américaine OpnWtr planche sur un bonnet doté de capteurs photos et de LED infrarouge permettant de scanner le contenu du cortex et même de l’influencer (cf ma série de trois articles “Ces startups qui veulent bidouiller votre cerveau”).

Va-t-on mettre les microprocesseurs de la technologie d’Elon Musk dans les cerveaux des enfants ? Bien non. Neuralink ne fabrique pas des microprocesseurs à implanter dans le cerveau mais de simples électrodes ! Qui sont plutôt parties pour traiter avec précision des pathologies neurodégénératives diverses. Les entrepreneurs vendent du rêve ou du cauchemar. Dans la pratique, ils se rabattent à la fin sur des solutions technologiquement intéressantes mais pas celles des prospectus de la science fiction.

___________________________________

So what ? En fait, tout ceci n’était qu’un teasing de la sortie en octobre 2017 de mon nouvel ebook sur l’IA “Les usages de l’intelligence artificielle”.

C’est une mise à jour de celui que j’avais publié en mai 2016. J’y rentre dans le lard de ces mythes et décortique l’IA d’un point de vue pratique, sur les techniques utilisées et leur évolution, sur le hardware de l’IA, sur les applications horizontales et verticales de l’IA et sur les méthodes de développement de solutions logicielles et de gestion de projets de l’IA. Bref, on passe de la science-fiction à la réalité d’aujourd’hui. C’est plus pratique pour agir ! Et comme d’habitude, cet ebook est en Creative Commons et gratuit.

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Pour alimenter tes sources en direct de M ! https://myignite.microsoft.com/sessions/56555

Merci Xavier ! Sans compter Microsoft Experience de la semaine prochaine qui j’imagine sera aussi prolixe sur le sujet…

Douze mythes de l’intelligence artificielle selon @olivez. Le 9 est excellent 🙂 https://t.co/Xm7OxSW3BK

Article parfait pour faire un point sur les “mythes” de l’IA #AI https://t.co/jRdQO1BOEC

Tout à fait en phase Olivier. On est dans la classique phase du buzz et des attentes irréalistes. Il y aura des echecs comme tu le soulignes avec les bases de données erronées dont on va réaliser qu’il est utopique d’avoir des données de qualité suffisante pour l’aprentissage.

Restons modeste dans les capacités prédictived car malgrès les super-ordinateurs depuis les premiers Cray, la météo arrive à se planter à court terme localement.

Cependant dans les entreprises la categorisation, l’analyse d’images et du langage sont déjà assez matures pour envisager des applications.

J’attends ton ebook avec impatience!

En effet ! Les mythes ne portent pas que sur les attentes irréalistes. Elles concernent aussi les méconnaissances sur la manière dont sont menés les projets dans l’IA, sur le rôle respectif des algos, des données et du matériel. C’est une phase d’apprentissage normale pour toute technologie, comme pour ce que l’on a connu avec l’arrivée du web en 1995 qui n’est pas devenu “mainstream” instantanément. Il n’en reste pas moins vrai que les applications pratiques sont immenses ! Il faut juste faire le tri entre les surpromesses et ce que l’on peut faire de concret aujourd’hui.

faire la part des choses, vérifier certaines informations… si possible ! Mise au point intéressante d’ O Ezratty https://t.co/oojmVNB67u

Bonjour Olivier,

Excellent article. Effectivement entre mythes et réalités aujourd’hui et les possibles de demain,je pense que tu as vraiment bien décrit un état des lieux en perpétuel mouvement. Les finalités actuelles quand bien même basiques évoluerons, c’est une certitude mais que seront elles advenues après plusieurs itérations d’autosuffisance ? Qui aura initialement choisi un but, une trajectoire et pourra en assurer l’aboutissement ? L’éternelle dualité entre le bien et le mal fera inévitablement surface mais son enfouissement aussi profond soit-il aura toujours la même origine.

Déjà bien des ouvrages de science fiction nous ont promis ou simplement décris des futurs de toutes sortes et les tendances technologiques en manque cruel d’imagination ou de moyens semblent vouloir en atteindre les meilleures pages. Je ne sais ou cela ira certes.

Merci,

JL

Il y a une énorme différence qui entre un cerveau d’intelligence artificielle et le cerveau humain.

Le cerveau de l’intelligence artificiel est minéral, construit une fois pour toute en usine, il est mort.

Le cerveau humain est vivant, après s’être créé seul, il se répare, s’adapte, se re-configure, des nouvelles connexions sont créées, et même contrairement à ce qu’on a longtemps cru des neurones se régénèrent et même se créent.

Tout cela est fondamental pour l’apprentissage.

Ce qui fait que ce n’est pas demain que l’intelligence artificielle égalera celle de l’homme.

Super debunk de l’IA washing “Douze mythes de l’intelligence artificielle” de @olivez sur https://t.co/13yIqvzpSi

ah ça fait plaisir à lire …ça remet en perspective les bêtises que l’on entend sur l’#IA

https://t.co/DGbFJSGAAc

ah ça fait plaisir à lire …ça remet en perspective les bêtises que l’on entend sur l’#IA

https://t.co/IfkMczcdXZ

Au secours Olivier ! ;-)) Merci pour ces éclairages salvateurs et, de façon générale, pour votre disposition intellectuelle qui, déjà en soi, est un gage de confiance. Un béotien de la base.

Très instructif. #IA #Recul

https://t.co/Dq2oSkvzCK

Olivier Ezratty dénonce 12 mythes de l’intelligence artificielle.

Une bonne vulgarisation pour les novices.

https://t.co/LrjnZq6Wqu

@olivez coucou. Adoré ta mise en bouche > https://t.co/M1uFYKYWNN

Je termine “Homo Deus” et lirai ton e-book semai… https://t.co/u237NBREFQ

Merci pour cet article fouillé …

GAFAMI ok mais Quid des géants Chinois absents de l’article ? Baidu, Alibaba et Tencent …Xiaomi …

Un mythe ?

Je ne les ai pas cités dans cet article car il se dit moins de choses décalées à leur sujet.

Voici ce que j’ai écrit au sujet des BATX dans l’ebook “Les usages de l’IA” publié la semaine dernière (http://www.oezratty.net/wordpress/2017/usages-intelligence-artificielle-ebook/) :

“Est-ce que les leaders chinois vont dépasser les GAFAMI ? C’est une hypothèse à la mode. Les grandes entreprises chinoises du numérique et les startups chinoises bénéficient d’un terrain favorable : une masse de chercheurs et développeurs formés en Chine ou dans le reste du monde, un marché intérieur de plus de 500 millions d’Internautes, un marché mobile ultra-développé et une règlementation qui se pose beaucoup moins de questions sur la protection de la vie privée.

Malgré tout, il subsistera encore longtemps un cloisonnement des marchés au niveau des données et des applications entre la Chine et le monde occidental. Sauf accidents de parcours, les grands chinois ne feront pas l’acquisition de GAFAMI. Si Baidu et d’autres font quelques progrès significatifs dans le deep learning, les techniques utilisées qui sont généralement open source ne sont pas des différenciateurs stratégiques suffisants. Seule la donnée acquise dans leur pays l’est et les données captées par les leaders chinois manquent de diversité pour bien couvrir les besoins à l’échelle mondiale.

Ces grands leaders chinois ont recruté des talents chez des concurrents américains. Rien que chez Baidu, Andrew Ng qui était auparavant chez Google tandis que Qi Lu provenait de Microsoft et Yahoo. Quand à Hugo Barra, ex Google passé avec fracas chez Xiaomi en 2013, il les a quittés début 2017 et est devenu VP de la réalité virtuelle chez Facebook. La recherche chinoise fait des progrès mais est encore en « piggy-back » d’une bonne part de la recherche nord-américaine (USA + Canada). Et la recherche ne suffit pas à définir la position stratégique d’un pays.

Bref, comparer la Chine aux USA en matière d’IA n’est pas évident, surtout si les indicateurs sont anecdotiques et pas économiques.”

J’ajouterai qu’il faudrait plus s’intéresser aux entreprises technologiques chinoises qui exportent beaucoup. A ce titre, Huawei est à surveiller de plus près que les BATX.

“Bref, l’IA incarne un déterminisme futur prêt à défier toute forme de sérendipité, de hasard et de libre arbitre p… https://t.co/pAN5MoNnfv

Douze mythes de l’#IA selon @olivez, je recommande vivement cette lecture !

https://t.co/eGpwDTcVUb

#AI

Mythologie et réalité

https://t.co/QI6pi0TUi1

Pour sortir du buzz et se poser les bonnes questions sur l’IA, un excellent papier d’@olivez https://t.co/qUcj8vexzx

Excellent article sur l’#IA :”Douze mythes de l’intelligence artificielle” de @olivez sur https://t.co/zBldmwcas1

IA is too much marketed. https://t.co/oifZe1aUJf https://t.co/E3as3L6Otv

En accord avec cet article.

Ca fait 3 ans que j’interface Watson et ce n’est qu’un NLP plus pauvre que CoreNLP de l’université de Standford et tout un tas de paramétrage qui n’a rien à envier aux systèmes experts d’avant.

Quant à l’IA, j’ai beaucoup de mal avec ce terme. L’intelligence artificielle n’est pas de ce monde, ça restera toujours un algo, aussi évolué soit-il.

Tout ça n’est qu’un processus marketing … qui finira quand les investisseurs se rendront compte des résultats réels et pas ceux communiqués dans la presse.

Par contre j’ai peur de certains usages autonomes ou décisionneles avec ce concept …

@BD_Group, @olivez : Je (re)publie ici un article très intéressant écrit par Olivier Ezratty (que je salue au passa… https://t.co/AiO4MhOAE8