Si vous êtes passionnés de photo, vous n’avez pas pu passer à côté du buzz de la semaine concernant la startup Lytro.

Le buzz autour de Lytro s’explique par l’innovation de cette startup qui pourrait révolutionner le marché de la photographie numérique. Il s’agit d’un procédé permettant de prendre des photos sans se soucier de la mise au point et de la profondeur de champs. Il permet de régler ces paramètres par logiciels après avoir pris la photo, par exemple pour choisir où la mise au point doit être faite comme dans l’exemple ci-dessous. On parle d’appareil photo “plénoptique”.

L’annonce du 21 juin 2011 était double :

- Une levée de fonds qui totalise les investissements dans cette société à $50m. Les investisseurs sont K9 Ventures (amorçage), Greylock Partners (seed), NEA (série A) et Andreeseen Horovitz (dernier tour de $37m). A ce jour, l’article le plus détaillé sur Lytro a été publié dans le New York Times.

- Une annonce du lancement du premier appareil photo de Lytro d’ici la fin 2011. Ce qui veut dire que sa conception est déjà bien avancée.

Je ne peux m’empêcher d’écrire un article sur ce sujet passionnant. Ce, pour au moins trois raisons en plus de ma passion pour la photographie numérique :

- Nous sommes face à un cycle classique “comme dans les livres” de l’innovation technologique qui démarre avec une thèse de doctorat réalisée à Stanford et publiée en 2006, une publication scientifique, un prototypage en laboratoire, la création d’une startup, puis l’industrialisation du procédé. Un procédé “game changer” qui peut potentiellement révolutionner toute une industrie.

- Le procédé est très intéressant d’un point de vue technique. Il faut parcourir les 187 pages de la thèse du créateur de Lytro pour (tenter de) comprendre les enjeux et la praticité de cette invention. Quand on y regarde de plus près, on commence à comprendre comment cela fonctionne, la valeur d’usage du procédé et quelques-unes de ses limitations.

- La société a levé $50m auprès de VCs, en trois tours de financement. On est aux USA, pas en France ! Sky is the limit ! Et la stratégie d’industrialisation de Lytro est intéressante.

Le procédé technique de l’appareil photo plénoptique

On se demande évidemment, “comment ça marche ?”. Après avoir lu la thèse, je pense avoir compris, mais… ne suis pas sûr à 100%. Cela demande des notions d’optique (restes de classes préparatoires…) et de mathématiques (transformées de Fourier et compagnie). Alors, il me faut reprendre par intérim ma casquette d’ingénieur généraliste.

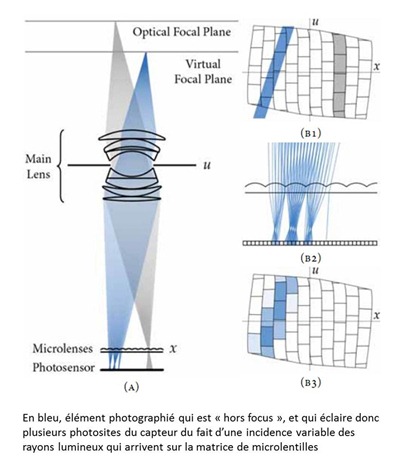

Le principe repose sur le fait que les capteurs photo actuels n’enregistrent que la luminosité qui arrive sur leur plan. La lumière qui arrive sur le capteur comprend bien plus d’informations que cela. Elle est composée de rayons qui arrivent sur le capteur sous plusieurs incidences. Selon l’incidence, le rayon ne provient pas du même endroit et a parcouru un chemin différent qui dépend de la position des différents éléments optiques de l’objectif. Lorsqu’un point qui se situe dans le plan de focale – la zone où l’image va être nette – il émet un cône de lumière qui va entrer dans l’objectif et converger sur un point dans le capteur. Un point (lumineux et visible de l’appareil photo) qui est hors de ce plan va générer un cône de lumière convergeant soit avant soit après le capteur dans l’appareil photo. Au lieu de générer un point sur le capteur, il va générer un cercle flou. D’où les flous d’arrière ou d’avant plan des images prises avec une grande ouverture, surtout sur les réflex.

L’appareil photo plénoptique capte les rayons lumineux qui arrivent sur le capteur (et pour chaque couleur primaire) mais en plus de leur luminosité, l’angle d’incidence des rayons. Ainsi, un point hors du plan de focale va-t-il générer une tâche de lumière dont chaque point présentera une incidence représentant le cône de lumière entrant dans le capteur. La captation des rayons lumineux et de leur incidence sert à enregistrer un champ lumineux dans son ensemble et pas seulement la luminance arrivant sur le plan du capteur.

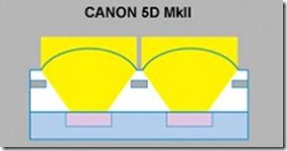

Le procédé exploite un masque de microlentilles qui est placé devant un capteur photosensible CMOS ou CCD classique. Chaque microlentille couvre un carré de plusieurs pixels. Elle va permettre d’enregistrer sur une zone non pas plusieurs pixels, mais la mesure de la lumière sous plusieurs incidences qui arrive à cet endroit là. Une transformée de Fourier logicielle est ensuite appliquée aux pixels enregistrés pour reconstruire l’image correcte et modifier ses paramètres pour contrôler la profondeur de champ et la netteté. Il faut donc un logiciel spécifique pour traiter l’image. Notons que les appareils photos utilisent déjà des microlentilles, mais une seule par pixel, pour mieux concentrer la lumière dessus et gagner en sensibilité (schéma ci-dessous).

Le logiciel de reconstruction des images utilise un algorithme de “ray tracing” similaire à ceux que l’on emploie dans la génération d’images de synthèses. On part du plan du capteur, on lance (virtuellement) des rayons à l’incidence choisie (qui va déterminer ce qui est net et flou dans la photo) et on obtient une luminosité correspondante (et pour chaque couleur primaire).

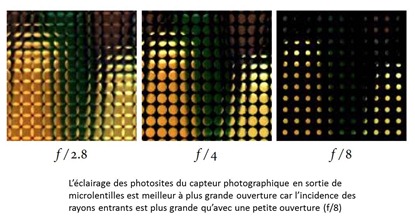

Les photos doivent être prises avec une ouverture autour de f/4 pour bénéficier du maximum de rayons lumineux qui arrivent sur le capteur dans plusieurs directions. Avec une trop petite ouverture, les rayons sont trop directionnels (schéma ci-dessous, à droite) et avec une trop grande ouverture (ci-dessous à gauche), les rayons débordent sur les zones adjacentes. Mais l’ouverture optimale dépend de la focale de l’optique et donc du facteur d’agrandissement dans le cas d’un zoom. Ceci pouvant être calculé automatiquement sans intervention de l’utilisateur. Les photos seront théoriquement plus rapides à prendre car il n’y a pas besoin de faire la mise au point. La mise au point sera peut-être remplacée par un calcul d’ouverture automatique qui va optimiser l’éclairage des lentilles.

L’absence de besoin de mise au point est particulièrement intéressant pour les appareils compacts qui sont assez lents dans ce domaine. Tout devrait être automatique. Et en mode “manuel”, l’utilisateur ne touchera visiblement pas à l’ouverture. Il pourra donc modifier les deux autres paramètres clés que sont la sensibilité (de 100 à 3200 ISO en général) et le temps de pose. Avec une ouverture de 4 en moyenne, on sera souvent un peu juste en basse lumière. Il faudra monter à 3200 ISO et avoir un temps de pose inférieur à 1/60s susceptible de générer un flou de bouger (de l’appareil ou des personnes à photographier) qui n’est pas facile à traiter par logiciel. Pourtant, dans sa littérature, la société indique que l’appareil plénoptique est très performant en basse lumière.

Au passage, la thèse indique que le logiciel de traitement de l’image des appareils plénoptiques permettra de mieux corriger les aberrations des optiques, ce phénomène qui créé des franges de couleurs sur le bord des objets dans certaines conditions.

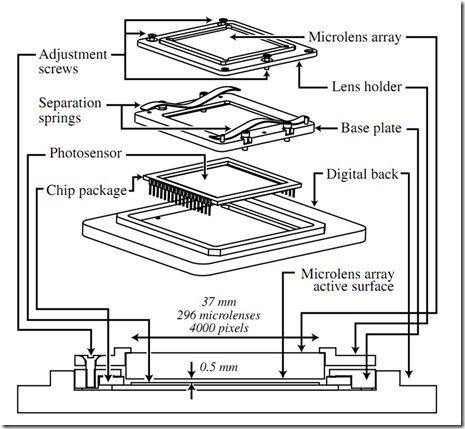

Il semblerait qu’il faille dynamiquement régler la distance entre le capteur et le réseau lenticulaire. Donc un réglage en remplace un autre. S’il est automatique, cela ne posera pas de problème à l’utilisateur.

Est-ce qu’il y aura un impact sur les objectifs ? A priori non car le système sembler fonctionner avec toutes les optiques : télé, grand angle et macro. Par contre, les paramètres précis de chaque optique devront être intégrés au logiciel pour le traitement des photos. Un peu comme le font des logiciels tels que ceux de DxO ou bien Lightroom et Photoshop chez Adobe pour corriger les déformations et aberrations connues des optiques des appareils réflex.

Où est le lézard ?

L’inconvénient principal de cette technologie semble être la faible résolution des images produites. Plusieurs pixels du capteur sont nécessaires pour capter un pixel d’image final. Cette diminution de résolution est envisageable grâce à l’augmentation constante – et parfois absurde – du nombre de pixels des capteurs photo.

Le premier prototype a été réalisé en 2006 avec un appareil photo à grand capteur Kodak de 16 Mpixels, ce qui était le top à ce moment-là. Le test utilisait des microlentilles qui couvraient des carrés de 14 pixels de côté, ce qui donne une résolution de 7 angles différents dans toutes les directions pour la mesure de l’incidence des rayons lumineux. Cela donne 196 photosites par microlentille, ce qui réduisait la résolution de la photo à 87K pixels ce qui est très faible. La thèse évoque le besoin d’avoir des capteurs de 100 mpixels, ce qui donnerait au final 500K pixels, ce qui est assez faible. En passant à 8 pixels de côté pour la taille des lentilles, on aboutirait à une image résultante de 1,5 mpixels ce qui commencerait à être acceptable. Sachant qu’il faut au minimum 1 mpixels pour imprimer une photo au format A5 et 2 mpixels pour le A4.

Mais on est loin d’avoir 100 mpixels sous la main ! On voit là une limite claire du procédé avec l’état de l’art actuel des capteurs photographiques ! Les appareils haut de gamme de studio type Hasselblad grand format ont des capteurs Kodak qui montent à 50mpixels voire 80 mpixels. Canon a aussi annoncé avoir prototypé un capteur de réflex APS-H de 120 mpixels en août 2010, mais sans pouvoir indiquer de date de commercialisation. Quand à avoir 100 mpixels dans un capteur d’appareil compact, beaucoup plus petit, cela donnerait des photosites bien trop petits – aux limites de l’intégration des semi-conducteurs – et surtout très peu sensibles.

Terminons cette description technique sur une analogie avec le procédé des réseaux lenticulaires pour afficher des images 3D sans lunettes, comme chez Alioscopy. C’est en exagérant un peu le même type de procédé mais à l’envers, pour l’affichage au lieu de la capture d’image. Et le réseau lenticulaire des écrans 3D autostéréoscopiques (ne nécessitant pas de lunettes) est constitué de lentilles verticales faisant la hauteur de l’écran, et pas de lentilles circulaires, plus nombreuses.

L’analogie ne s’arrête pas là puisqu’en théorie, la technologie de Lytro devrait théoriquement permettre de reconstruire une vue 3D de la scène puisque chaque rayon peut remonter à sa source en profondeur (Z).

La valeur d’usage et les applications de l’appareil plénoptique

Alors, maintenant que vous avez tout compris sur son fonctionnement (heuh…), revenons-en aux basiques : cette technologie est-elle “Nice to have” ou “must have” et pour qui ?

L’objectif de Lytro est de fabriquer un appareil photo très grand public, plutôt format “compact”.

Et l’on est face à quelques contradictions de ce point de vue là.

- La première est que les notions de profondeurs de champs sont généralement ignorées par les photographes amateurs équipées de compact. Pourquoi donc ? Parce que la profondeur de champs est très grande dans les photos prises sur mobiles et compacts (cf exemple ci-dessous à gauche où tout est net dans la photo). Elle n’est contrôlable qu’avec les appareils réflex et les optiques à grande ouverture (cf exemple ci-dessous à droite, avec réflex plein format). C’est une question de physique et de taille de capteurs et d’optiques. Plus le capteur et l’optique sont petits, plus la profondeur de champs est grande. Ce qui donne des photos où tout est net de l’avant à l’arrière-plan. Avec les réflex et une grande ouverture, on peut réduire la profondeur de champs, ce qui présente deux avantages : l’un qui est artistique et qui valorise ce que l’on photographie en rendant flou l’arrière-plan, et l’autre, pratique, car avec une grande ouverture on peut faire une “bonne” photo sans flash dans des conditions de basse lumière.

- La seconde est que les photos devront être enregistrées dans le format RAW du capteur (et pas le JPEG) puisque le post-traitement de l’image requiert d’avoir une bonne précision dans l’éclairage de chaque pixel. En RAW, on stocke la luminosité de chaque pixel sur 12 à 14 bits selon les appareils alors qu’en JPEG, elle est de 8 bits et que l’image subit un traitement de compression spatiale. Cela va alourdir les traitements, nécessiter de la puissance machine sur ordinateur personnel et de l’espace de stockage. Alors que les utilisateurs d’appareils photos compacts sont habitués à récupérer directement leurs photos JPEG en sortie d’appareils. Quand ce n’est pas pour les publier directement sur Internet lorsqu’elles sont prises avec leur smartphone !

J’ai donc l’impression que le procédé de Lytro fonctionne en fait mieux avec un réflex voire avec des appareils grand format de studio (et qui valent la peau des fesses) qu’avec des compacts. C’est d’ailleurs la seule manière à moyen terme d’employer des capteurs avec la très haute résolution requise par le procédé.

Je ne serais pas étonné que l’appareil qui sortira en fin d’année fasse aux alentours de 20-24 mpixels avec un capteur assez grand que l’on trouve dans les appareils hybrides et plutôt carré vus les exemples fournis sur leur site (à moins que ce ne soit un leurre). Et avec des microlentilles de 6 à 8 pixels de côté, permettant d’impressionner la galerie avec le procédé mais sans pouvoir le gérer avec une grande finesse pour le contrôle de la profondeur de champs. Il y aura en tout cas sans doutes des compromis que nous découvrirons à la sortie de l’appareil.

Signalons au passage que ce procédé ne peut pas fonctionner en mode vidéo. Pourquoi donc ? Parce que les appareils photos qui enregistrent de la vidéo font au mieux du 1080p (1920×1080 pixels), soit 2 mpixels, ce qui est bien insuffisant pour la mise en œuvre du procédé. La super-haute définition du futur de la NHK dite 16K nécessite des capteurs de 33mpixels (avec dématriçage de Bayer). Et elle génère des débits numériques monstrueux impossibles de traiter dans un appareil photo avec l’état de l’art actuel des semi-conducteurs. Mais bon, le contrôle de la profondeur de champs empêche moins de vidéastes que de photographes de dormir.

L’approche industrielle de Lytro

Bonne nouvelle : il ne s’agit pas de l’invention d’un nouveau type de capteur, donc les processus existants peuvent être conservés. A ceci près nous avons vu que le procédé nécessite tout de même des capteurs de très très haute résolution.

Il faut “juste” insérer un filtre devant le capteur, l’histoire ne disant pas s’il faut conserver l’habituel filtre antialiasing qui équipe les appareils photos, sauf exceptions comme dans le LEICA M9. Il semble cependant qu’il faudra pouvoir contrôler mécaniquement et avec précision la position du filtre lenticulaire.

Of course, l’ensemble va nécessiter du logiciel pour récupérer les images et définir mise au point et profondeur de champs !

Pour diffuser la technologie, la société avait en gros deux options devant elle :

- Créer une technologie vendue sous licence aux fabricants d’appareils photos, et aussi la partie logicielle sous licence aux Adobe, Google et autres éditeurs de logiciels.

- Concevoir ses propres appareils photos et aussi les logiciels qui vont avec. Choix cornélien.

Le premier choix est pertinent si la technologie est amenée à se généraliser et devient un “must have”. Mais avant qu’elle le soit, il faut qu’elle soit éprouvée. Le second choix, qui semble a été retenu par la société, consistera à commercialiser un appareil photo compact utilisant le procédé. Et probablement avec une optique zoom non interchangeable. L’appareil sera fabriqué en sous-traitance à Taïwan. Les limites théoriques du procédé cantonneront probablement l’usage de l’appareil à quelques domaines au début de sa carrière. Si l’usage peut être généralisé, les grands de la photo voudront sans doutes s’approprier le procédé pour l’intégrer à leurs appareils. Surtout dans la mesure où cela ne semble pas remettre sérieusement en cause les processus habituels de fabrication d’appareils photos.

Cette aventure intéressante ne semble possible qu’aux USA tellement les moyens nécessaires (et la prise de risque) sont importants ! Ce, d’autant plus que l’industrie américaine est quasiment inexistante dans la photo numérique, dominée par les japonais. Sauf quelques rares exceptions comme avec les capteurs de Kodak.

Imaginez un chercheur de SupOptique qui pondrait la thèse de Ren Ng et qui chercherait à révolutionner la photographie numérique. Il obtiendrait 30K€ d’Oséo pour son prototype, un prêt d’honneur de 60K€ chez Scientipôle Initiative ou dans le Réseau Entreprendre (avec deux associés), puis une avance remboursable de 200K€ et/ou une subvention de 450K€ gagnée au concours de l’entreprise innovante toutes deux conditionnées par des fonds propres équivalents. Il irait voir des business angels qui mettraient 300K€ pour voir, et ensuite des VCs qui iraient jusqu’à 5m€ dans un premier temps. Cela ne serait pas impossible d’obtenir les moyens de Lytro, mais cela serait bien plus difficile qu’aux USA.

L’équipe de Lytro

Terminons avec quelques mots sur l’équipe de cette startup. Son fondateur est Ren Hg, 31 ans, qui est l’auteur de la thèse de Stanford de 2006 décrivant le procédé. Cela veut dire que le gars cravache depuis cinq ans pour avancer et prototyper son appareil photo révolutionnaire.

La société compte déjà plus de 40 personnes. Son CTO est Kurt Akeley, un ancien de Silicon Graphics et de Microsoft Research. L’équipe dirigeante est mixte avec 4 femmes sur 9 personnes.

Petits détails, la société a deux prix Nobel dans son Advisory Board et son Board comprend un cofondateur de TiVO.

Le siège de la société ? Mountain View, à deux pas de Google, Palo Alto et sa pompe à financement de Sandhill Road, Stanford et tout le toutim !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Olivier,

Superbe article, incroyablement documenté. bravo.

Tu poses les bonnes questions – “Nice to have” ou “must have” et pour qui ?

et tu apportes les éléments de réponse – le concept de profondeur de champ – inconnu de la plupart des posteurs de photos sur FB, le premier site de photo (devant Flickr), et le format RAW, itou.

On ne peut que souhaiter bonne chance à Lytro et sa techno, mais basé sur les infos partagées ici, je pense que nous soyons sur un marché de niche plutôt qu’un marché grand public, un vrai marché par ailleurs comme le prouve une société comme DXO.

Mes 0,02 €

Espérons pour eux que leur succès ne sera pas empêché par une erreur de positionnement ! Attendons la fin de l’année pour voir et juger sur pièces ! Je n’ai fait ici qu’essayer de comprendre le contenu de la thèse du créateur de la startup. La thèse datant de 2006, il n’est pas impossible que depuis, ils aient réalisé des progrès significatifs qui ne sont pas encore documentés, et/ou sont dans des brevets en cours de dépôt.

J’ai eu la chance d’ptre l’eleve puis le collegue de Kurt. Un mec incroyablement smart. Il est spécialiste de la 3D, et je pense que les applications 3D e l’outil ne lui echappent pas 🙂

Il a une tendance a être largement en avance de son temps en revanche

Question de néophyte : est-ce qu’un principe du même type (ou même ce principe) ne permettrait pas aussi de gérer les luminosités pour gérer l’effet HDR en post-traitement en une seule photo ?

Sinon, si cette technologie dépasse ses limites, il me semble qu’elle va totalement transformer le marché de la photo en un marché de post-traitement : les artistes / spécialistes / etc. seront ceux qui sont devant leur ordinateur, pas ceux qui tiennent l’appareil. Evolution intéressante !

Merci (et félicitations) pour ce superbe article pédagogique !

Il ne me semble pas que le principe de Lytro permette d’améliorer la dynamique des capteurs et donc de se passer de prendre plusieurs photos de suite pour générer une image à haute dynamique (HDR). Pour faire du HDR en une prise, il faudrait améliorer les capteurs et notamment leur capacité à distinguer encore mieux les nuances de hautes et basses lumières. C’est un problème de photonique et de semi-conducteurs.

Pour ce qui est du marché du post-traitement, la transformation est déjà bien en cours, même si les personnes sont souvent les mêmes au début et à la fin du process. Chez les utilisateurs de réflexes, les manipulations des photos à partir du format RAW apportent une énorme souplesse que l’on n’a pas au moment de la prise de vue. Sans compter le travail des photographes de mode qui passent des heures à retoucher les photos des top-models. Même si celui qui fait les retouches n’est pas forcément celui qui a pris les clichés.

A l’autre extrémité du spectre des utilisateurs, les applications mobiles comme Instagram et compagnie permettent de rajouter des fioritures autour de ses photos avant de les envoyer dans les réseaux sociaux.

La transformation du marché ne serait pas si radicale que cela. L’innovation évite des manipulations irréversibles lors de la prise de vue et apporte plus de souplesse dans l’usage des photos prises. C’est une évolution dans la lignée de l’apparition du format RAW avec les capteurs réflex qui a permis de corriger la luminosité des photos, ou la luminosité dans les hautes ou basses lumières, alors que le JPEG ne le permettait pas aussi bien car il détruisait des informations utiles dans les photos au moment de la compression (du 12/14 bits au 8 bits pour le nombre de couleurs différentes gérées par pixel et couleur primaire). Avec le plénoptique, au lieu de perdre une information captée (du fait de la compression JPEG), on en ajoute (la lumière incidente).

Merci !

Pour l’évolution je suis d’accord qu’elle est déjà bien entamée, mais il reste que l’expertise de l’opérateur (ici : le photographe, qui tient l’appareil) est encore déterminante. Je m’étais une fois amusé à me mettre derrière un photographe de mode pour prendre exactement les mêmes photos que lui … et comparer les différences (très dur pour l’ego ! :-))

Là, on peut imaginer un automatisme complet :

– Plusieurs prises de vue en rafale pour la lumière

– Le système Lytro pour la mise au point

Aura-t-on encore besoin d’un opérateur hautement spécialisé pour la prise de vue ? (pour la mode il restera bien sûr les stylistes décors, les spécialistes lumières, les maquilleurs, coiffeurs, etc. etc.)

Dernière question technique : les demos de Lytro mettent en opposition le flou et le net. Est-ce que le système permet d’avoir tout net (exemple : transformer la photo de chemise noire en l’équivalent du jeune garçon) ? Ou est-ce qu’il recalcule l’ensemble de la photo selon un point de vue unique qui oblige une certaine profondeur de champs et donc à certaines zones floues ?

Ce genre de technologie ne va pas corriger l’un des principaux écueils des photographes amateurs (même équipés de réflexes) : la composition et le cadrage ! Il reste à créer un logiciel intelligent embarqué qui alerterait le photographe des erreurs en cours : visage au centre au lieu d’être en haut de la photo, pas assez de marges, marges pas équilibrées, règles des tiers pas respectée, jambes coupées au mauvais endroit, etc.

Pour ce qui est de la photographie professionnelle, notamment pour de la mode ou des portraits, on a encore besoin de vrais photographes, même si leur métier est de plus en plus difficile. Il ne faut pas négliger un point TRES important : la relation entre le photographe et les personnes photographiées. Cela va de la mise en confiance aux conseils pour la pose, si ce n’est vers une notion de “direction artistique”.

Pour la techno Lytro, il me semble qu’elle permet de reconstituer une vue avec profondeur de champ maximale rendant presque tous les plans nets dans l’image. Cela traînait quelque part dans les exemples fournis.

La partie sur Oseo est tellement réaliste que j’ai rigolé … jaune (étant dans la même situation).

C’est donc tellement connu que les investissements en France sont si…

nulsbas ?Ne crachons pas sur la soupe. Cf le débat du post précédent qui n’est pas terminé d’ailleurs !

La France est à l’image du reste de l’Europe. Je pense que la faiblesse de nos investissements est le résultat direct de la fragmentation du marché européen. Petits marchés locaux => petits marchés pour démarrer => démarrage plus lent => succès plus difficiles + concurrents US qui vont plus vite => plus dur de se faire financer => pas de réamorçage de la pompe privée du financement par les succès. Seconde raison clé : la culture du risque et un manque d’ambition, conséquence de notre géographie. Les anglais sont une exception en Europe et se portent mieux. Probablement parce qu’ils parlent anglais et sont proches culturellement des USA où ils s’implantent plus facilement et plus directement.

Le bazar de nos financements publics est un palliatif aux insuffisances du secteur privé, lui-même lié à ce que je viens d’écrire. Pour en sortir, il faut réamorcer la pompe des succès et encourager plus nos startups à s’ouvrir sur le monde.

Olivier, tu es un génie (si, si) de la vulgarisation !

Pour faire mon focus group (quel jeu de mots…) à moi tout seul : je serai enchanté de retrouver les possibilités de jouer avec les profondeurs de champ que j’ai quasiment abandonnées depuis que j’ai quitté mon reflex argentique pour n’avoir plus que des APN compacts… Le succès des petites applis iPhones Instagram et consorts me laisse croire que les utilisateurs sont nombreux à envie de tweecker leurs photos…

Bravo pour cet article impressionant de détail.

Très intéressant !!!

Je pense également que tout cela est plus pertinent pour des applications spécialisées (scientifiques / militaires)

Erreur de positionnement ? L’avenir le dira …

Je tire mon chapeau à Olivier Ezratty pour cet article d’une très grande qualité, sur la clarté rédactionelle, sur la pédagogie du contenu et sur la pertinence de l’analyse, ça fait plaisir au milieu de la soupe prémachée de dépeches ou de vulgarisation pour bulots décérébrés.

Sur le fond, je rejoins completement la constation du problemen, et l’objectif marketing est contradictoire avec les contraintes techniques :

Sur un portable ou un ultracompact, on a des objectif qui oscillent entre la tete d’epingle et la piece de 10c, donc impossible d’ouvrir grand; et de l’autre coté on a des capteurs de quelques millimetres à peine,

et plus on case de pixels, plus ils sont serrés 😉

sur un compact à 12 Mpixels fermés à f4 ou 5 , il faut savoir que les photosites ne recoivent plus des points mais des taches, qui débordent allegrement sur les pixels voisins ! (cf Tache d’Airy à 7,5 microns sur une ouverture à 4,5)

Donc même en projetant un iPhone8 a 30Mpixels, on restera sur des objectifs tetes d’epingles à mendier du photon, l’equation semble impossible.

Quand je vois des news du type

http://www.mobiles-actus.com/actualite/htc-wp7-16-megapixels.htm , je me fend la poire .. le capteur 16Mpixels de sony par ex est annoncé être un 1/2,8″ (9mm) , soit si mes calculs sont bons, 2 pixels à se tasser comme des sardines dans 1,6 microns..

Même ouvert à f2,8, avec une tache de 3.8 µm, la bouillie qui en résulte ramène physiquement à moins de 4million de pixels effectifs..

Sur un fullframe 24×36 bien ouvert, c’est bien sûr différent , un 50Mpixels fait (optiquement) sens et la techno prendrait alors tout son intérêt.

Pour les petits capteurs, je crois beaucoup plus à ce qui bouillonne en ce moment sur les matrices de capteurs, qui aboutissent au même résultat (choix de la PF après la prise de vue) et bien d’autres (reconstitutions d’images cachées derriere la branche de l’arbuste, mieux que photoshop!) , avec une techno qui est industriellement beaucoup plus facile à mettre en oeuvre sur des APN bas de gamme et autre téléphones portables,.

A lire l’article très interessant sur http://www.jvrb.org/archiv/2578,

et à suivre ce que fait la société pelicanimaging.com sur le sujet.

J’imagine volontier le compact de 2020 intégralement recouvert de petits capteurs sur ce facade, au lieu d’un gros objectif.

– Arnaud

Merci pour cette très intéressante perspective qui explique bien pourquoi la course aux pixels n’a pas de sens dans les compacts et les smartphones. Elle valide indirectement le fait que l’appareil de Lytro sera probablement un hybride (capteur réflex sans miroir).

Je découvre Pelican Imaging. C’est encore une startup basée à Mountain View, comme Lytro, et qui a levé $17m (cf http://www.crunchbase.com/company/pelican-imaging). Mais avec une diffusion de la technologie en OEM visiblement.

Le procédé utilisant une matrice de petits capteurs+optiques semble intéressant. Il faut juste espérer que les problèmes de résolution d’optique ne se posent pas à cette échelle ! Sans compter la précision des processus de fabrication. C’est là que le bât peut blesser !

Une autre société à surveiller est Varioptic, française cette fois-ci. Elle a développé une technologie de lentilles fluides programmables (par champs électrique je crois). Cela fait des années qu’ils existent (2002 + $16m de levés en troisième tour, donc probablement au moins $20 au total). Leur technologie semble avoir été intégrée dans des blocs optiques d’origines variées (http://www.varioptic.com/en/partners.html). Mais dans quels smartphones au final ?

Bizarre de développer ce genre de process : je suis personnellement passé au réflex notamment pour pouvoir jouer avec la profondeur de champ… Si cela ne fonctionne pas sur des APN de base, ceux qui investissent dans des réflex s’intéressent – a priori – aux techniques photos et donc à maitriser ce flou voulu.

Je ne vois donc pas trop l’utilité de cette innovation ? Enfin, ce que j’en dis..

from : une pas trop Photoshopeuse 🙂

Petit auto-commentaire maintenant que l’on en sait plus sur l’appareil qui vient d’être dévoilé et pré-commandable en ligne pour $400 à $500 selon la capacité mémoire : https://www.lytro.com/camera.

– Le capteur : il est bien carré mais fait seulement 11 mpixels. J’avais compris que cela générerait des images d’une définition très inférieure à cause du système de micro-lentilles, décrit dans mon article. Les images publiées sur le site de Lytro sont de petite taille et sur écran uniquement. Quelle est la résolution exacte que permettra ce procédé ? C’est encore une inconnue. Mais peut-être une bonne surprise au bout du compte.

– La taille du capteur n’est pas indiquée ni si c’est un CCD ou un CMOS, et on n’en sait pas plus sur sa sensibilité. Il semble en tout cas que le procédé lui-même permette d’obtenir une très grande sensibilité et de prendre des photos convenables en basse lumière. L’objectif ouvre à 2.0 ce qui en est un bon gage. Et puis, l’appareil n’est pas doté d’un flash !

– Le form factor est curieux. Il n’a pas l’air d’être bien ergonomique pour la prise de photos, ni même pour prendre des vidéos (ce qu’il ne sait pas faire). J’ai l’impression que ce form factor a été choisi pour “faire différent” et aussi parce que son coût de fabrication doit être réduit. Il revient moins cher de plier une tôle en quatre que de créer un moule de fonderie ou pour mouler un plastique quelconque voire pour associer les deux. Autre interprétation : une approche “Apple-ienne” de la boite qui a raison contre la pensée unique du moment. On verra bien à l’usage. Il est aussi possible que cela soit lié à la forme et à la longueur du zoom à l’intérieur du corps de la caméra. Le zoom fonctionne visiblement avec une optique mobile à l’intérieur de l’appareil.

– La précision de la mise au point : dans les exemples du site, on peut effectivement faire la mise au point sur l’avant plan ou l’arrière plan. Il y a quelques cas où l’on peut jouer avec finesse sur des plans intermédiaires. Je me demande encore quelle est la résolution de profondeur. A savoir sur combien de plans peut-on faire la mise au point ? Compte-tenu du procédé, ce nombre de plans devrait être fini (discret) et pas infini (n’importe quel plan).

– Tout est automatique : il n’y a ni besoin d’autofocus ni de gestion de l’ouverture. Finalement, il reste le temps de pose et les ISO.

– Le positionnement : le prix de la caméra et sa simplicité d’usage en font un outil pour les amateurs et résolument pas pour les professionnels. Mais on peut cependant s’attendre à un engouement, au même titre qu’il en existe pour les Lomo, les Polaroid à l’ancienne voire pour des Leica hors de prix.

– Un détail qui compte : le logiciel de traitement des images ne fonctionne pour l’instant que sur Macintosh. Une version Windows est prévue pour plus tard.

Il reste à attendre début 2012 pour en savoir un peu plus.

En tout cas, le lancement par étape suit son cours et le buzz est instantané sur Internet.

A ce stade, le nouveau Canon EOS 1D X me fait plus rêver avec son capteur très haute sensibilité full-frame et une cadence de prise de vues de 12 images/secondes. Mais il est à $6800. Argh ! Ce n’est pas la même cour.

“Mais on peut cependant s’attendre à un engouement, au même titre qu’il en existe pour les Lomo, les Polaroid à l’ancienne voire pour des Leica hors de prix”

Un bon scénario (au sens happy-end) serait que les utilisateurs trouvent à cette technologie un intérêt pas forcément prévu par ses concepteurs qui permettrait par exemple de produire après traitement des images complètements différentesdes photos que l’on peut produire aujourd’hui et très caractéristique de l’appareil. Qui sait ce qu’un créateur saura produire à partir d’une image ou a priori il peut avoir tous les plans(ou presque tous) mis au point ou flou à la demande et les combiner ensemble.

En tout cas mettre leur innovation dans un produit pour la mettre le plus tôt possible sur le marché (vous m’arrêterez si en disant cela je dis une bêtise) sans ce soucier du caractère parfaitement abouti me semble avoir des avantages: feedback rapide des utilisateurs et commencer avec un peu de chance à générer des $ pour poursuivre. Qu’en pensez vous ?

Perso, je scinderai la mémorisation des sources de l’image, de l’image elle-même, ainsi avec un résultat brut, je pourrais effectuer un post-traitement sur ordinateur de cette image, c’est à mon sens tout l’intérêt du dispositif…jusqu’à la 3d.

On peut même imaginer un résultat prétraité et une rétro-ingénierie permettant de revenir à une image non traitée pour lui appliquer ses propres modifications.

Bonjour.

Merci pour cette explication fournie sur le système.

Cependant, il y a quelques erreurs qu’il serait bon de corriger.

La première, qui diminue de beaucoup la compétence de cet article est le mot “résolution” utilisé à la place de “Définition”. Jamais un nombre de pixels n’a constitué une résolution.

La deuxième est une erreur d’un facteur 1000 concernant la définition du futur de la NHK : elle n’est pas de 32kilopixels mais 32 Mégapixels (en fait 33)

Enfin, la troisième est l’abusif “zoom fixe”. Pourquoi pas une montagne plate ? Utiliser plutôt le terme “focale fixe”.

Je pensais (en juin) à une optique zoom non interchangeable, ce qui est bien le cas au bout du compte. Corrigé pour le reste.

Résolution et définition, abus de langage en effet. Pas facile à vulgariser en plus car la définition d’un capteur a un sens différent avec celle des images générées du fait du dématricage de Bayer généralement utilisé sauf dans les capteurs type Fovéon où les pixels RGB sont superposés et non pas répartis dans une matrice de Bayer.

Merci pour votre article. Je pensais avoir compris le truc à la lecture d’un article du magazine de Stanford il y a de cela un ou deux ans. Mais votre article est beaucoup plus détaillé. Veuillez cependant rectifier : Fourier et non pas Fourrier, il serait dommage de ternir le brillant de votre démonstration par cette faute regrettable qui écorche le nom du géant de la physique mathématique (Joseph Fourier, 1768-1830), l’inventeur des fameuses “séries” qui permettent la transformation de n’importe quelle fonction en formes périodiques, et réciproquement.

Avoir des idées, c’est bien, avoir en plus le financement, c’est mieux. Peu importe la technologie, on est fatalement à la traîne…

La taille européenne est indispensable, et au lieu de spéculer sur des marchés financier tentant de nous noyer, l’argent doit être collecté massivement par le biais des états européens pour alimenter le nerf de la guerre économique. Mais on tombe sur un problème politique..

Je vous signale que la seconde occurrence n’a pas été corrigée : “Une transformée de Fourrier logicielle”. Merci (pour lui) de rectifier.

Sur quelle distance de mise au point est réglé l’objectif d’un smartphone ?

J’en sais rien, probablement ” au pif” (tolérances de montage) ou carrément sur l’infini.

• Juste un peu sur la profondeur de champ (champ net sur la photo pour une distance de mise au point):

Elle est régie par les lois de l’optique et de la définition de la plaque sensible.

On peut dire que la profondeur de champ:

– Dépend de la définition de la plaque sensible.

– Qu’elle augmente au plus on ferme le diaphragme: limitation de la taille de la base du cône d’entrée de la lumière (qui dépend lui aussi de la taille de la lentille) .

– Qu’ elle croit si on diminue la focale de l’objectif.

• Dans les anciens appareils “fix-focus” type “instamatic” ou tous ceux qui ont un diamètre de lentilles suffisamment conséquent. Le but était que n’importe qui puisse faire sans tracas des photos nettes: “Clic-clac Kodak !” ( et ici point d’élucubrations sur le cadrage, le positionnement, qui sont d’un autre domaine et pas réservés aux possesseurs de reflex … loin s’en faut) .

Donc, on faisait un choix focale/ouverture . Petit à petit la focale a diminué (pour essayer d’éviter le syndrome de la “femme-tronc”). Et l’ouverture pour essayer d’éviter la photo “fromage blanc” l’été en plein midi ou le “trou noir” dès 5 heures du soir.

Ceci étant fait il fallait encore régler la distance de mise au point fixe (comme sur les smartphone). Les ingénieurs opticiens la réglaient sur la distance hyperfocale.

“Qués aquo ?”

C’est tout simplement la distance de mise au point qui permet (à cette ouverture et focale) d’ obtenir une photo qui soit nette de l’infini au plus proche possible.

Sans calculs, pour exemple, si vous réglez votre appareil sur l’infini la photo ne sera nette que jusqu’à 3,5 mètres de l’objectif, quid des portraits de Mamy ?

Mais si on règle la distance de mise au point en fonction de la profondeur de champ on peut la mettre à 2,5 mètres ce qui permettra d’avoir l’infini net mais de pouvoir photographier la tête de mamy à 90 centimètres, sans qu’elle ressemble à une gelée. (photographier Mamy de plus près relève pour moi de l’inconscience !).

En fin de compte je pense que les objectifs des smartphones sont réglés quelque part entre cette distance hyperfocale et l’infini, a priori, tout le reste étant laissé aux aléa de la fabrication.

C’est justement là que la technique que vous évoquez est révolutionnaire.

Les lois de l’optique ont aussi un impact sur les capteurs des smartphones : la petite taille du capteur, de l’optique et de leur proximité entraîne des photos avec une très grande profondeur de champs, c’est-à-dire que tous les plans sont nets en général. Plus le capteur et l’optique sont grands (et l’ouverture élevée) plus on peut “contrôler” la profondeur de champs. C’est la raison du succès du Canon EOS 5D Mark II pour des tournages de films. Son capteur est deux fois plus grand que celui des caméras vidéos standard pro pour le cinéma dites Super35 mm. Conséquence, avec les optiques Canon à grande ouverture, on peut encore mieux contrôler cette profondeur de champs. Cela donne des effets de flous et nets artistiques. Mais les réalisateurs peuvent en abuser.

Comprends pas.

Puisqu’il y a toute l’information suffisante dans le fichier, pourquoi ne pas construire un JPG nulle part flou ? Les gens aiment qu’il y ait des zones floues ?

Oui pour des raisons “artistiques” et pour bien valoriser un élément de la photo. Un exemple est donné dans l’article.

Grâce à cet article du Figaro de Benjamin Ferran qui pointe sur l’article ici présent, on peut découvrir des versions professionnelles de l’appareil de Lytro avec ceux de la société allemande Raytrix. Cela fournit indirectement des informations intéressantes sur la définition des images qu’un système plénoptique à base de micro-lentilles(lightfield sensor) peut générer. Leur R29 qui est un modèle haut de gamme est doté d’un capteur de 29 Mpixels et aurait une résolution effective de 7,5 Mpixels (oui, c’est bien de résolution qu’il s’agit, Dominique !).

Leur R5 génère quant à elle des images de 1 Mpixels avec un capteur de 5 Mpixels de un demi pouce de diagonale, qui est assez petit et utilisé par peu d’appareils grand public (comme le Fuji F80EX). On retrouve donc un ratio d’environ 1 à 5 entre définition du capteur et celle des images générées. La R5 supporte 32 plans de mise au point ce qui est largement suffisant dans la pratique.

Bref, tout ceci semble indiquer que la technologie de Lytro pourrait bien si elle se développait avec les capteurs les plus récents générer des images avec une définition fort convenable. Et celle du premier modèle pourrait atteindre 2 Mpixels si le ratio capteur/image est le même qu’avec la R5 de Raytrix.

Je ne vois pas l’intérêt qu’offre une mise au point à postiori, les autofocus actuels des réflex sont très performants et si on veut que tout soit net, on se place à petite ouverture f 11 à 16 avec toutefois le rique d’un léger problème de diffraction. A moins que dans l’avenir les capteurs multiplient infiniment le nombre de pixels, dans ce cas ce système électronique pourrait éventuellement remplacer un système mécanique… mais si on veut que tous les plans soient nets, cela serait alors impossible avec ce système qui ouvre à f4…Beaucoup de travail pour un flop?

Ca a l’air d’etre interessant en situation de basse lumiere et a grande ouverture.

Souvent, quand je prends des photos de fleurs ou d’insectes en macro, dans la nature, j’en manque beaucoup faute de mise au point, qui souvent se fait sur un plan de feuilles légèrement en arrière. Avec ce système, quand il autorisera le macro (ce qui semble n’être pas le cas actuellement), tous les amateurs comme moi pourront mieux saisir les beautés de la nature. Mais il y a certainement déjà d’autres applications intéressantes d’un point de vue artistique.

Un article intéressant, qui a le mérite de vulgariser où il se doit et de répondre à certaines questions, même si je continue de rester sceptique sur l’application au grand public pour un certain nombre de raisons (connaissance des aberrations chromatiques, de la profondeur de champ, du développement d’un RAW et de ce que cela implique en connaissance photo).

J’aimerais juste démystifier un point : les photos sur leur site web. Je pense que les photos ne sont qu’une mise en situation, et non des clichés au travers d’un rendu Lytro.

En effet, il suffit de prendre une photo avec une mise au point différente sur 3 plans, de découper le tout sous PhotoShop, puis de les superposer dans Flash et de coder quelques effets pour avoir un effet parallaxe. La preuve est qu’en f/4, on devrait avoir beaucoup plus de profondeur de champ en fonction du point visé, alors que sur leur site, c’est le plan qui apparait.

La photo du papillon illustre bien cela : les fleurs devant le papillon ne sont pas sur le même plan que le papillon. En faisant une mise au point sur ces fleurs, en f/4, le papillon devrait commencer à flouter. Or ici, peu importe où l’on clique, c’est le premier plan (ou défini comme tel) qui apparait.

De plus, la théorie explique que l’on devrait avoir une assez grosse puissance de calcul pour pouvoir changer la mise au point.

Ma conclusion : les photos sur leur site ne sont qu’une mise en situation de ce que l’appareil pourrait faire, et non le rendu réel de l’appareil…

Mes 2 centimes…

Il reste en effet des questions sur la gestion de l’ouverture à éclaircir. Mais les médias à qui l’appareil a été présenté dans la Silicon Valley ont pu tester le procédé eux-mêmes sur l’écran de l’appareil. Des vidéos sur YouTube en attestent. Le procédé fonctionne donc vraiment et les images présentées n’ont pas l’air d’être fake. Ce, d’autant plus, que le procédé plénoptoique est validé scientifiquement et qu’il en existe des variantes de mise en oeuvre avec la société Raytrix.

Moyen de répondre indirectement au commentaire un peu dédaigneux et pas bien constructif de Benoit en [23]…

A moins que ce soit avec un f/2..? J’ai un doute là tout de suite…

Commentaire pas nul mais qui flâte surtout l’égo de son auteur…Typiquement parisien! Quelqu’un pond un truc pas mal dans le monde….mais MOI avec MON dipôooooooome JE … m’enfin. Techniquement ce n’est vraiment pas la peine de parler de fournier, il s’agit simplement d’un algorithme, et vraiment cela n’a rien de compliqué. Pour la taille des capteurs il y aura bien certainement des progrès très rapide et cette nouvelle technologie et simplement une bonne idée. En fait du blablabla habituel e français, moyen donc.

Ce qui est vraiment très “blablabla habituel et français, moyen donc”, c’est d’écrire “fournier” au lieu de Fourier, car cela dénote bien l’attitude “je m’en fous et je vous emm…”, très beauf, typique, revendiquant une inculture.

Sincères et vives félicitations pour les qualités de votre article, clair et conciliant pédagogie et précision. On a l’impression que l’emploi qu’en fera l’usager lambda reste à découvrir. En tout cas il ne s’agit plus d’une photo papier, figée in eternam, mais d’un objet interactif, dont on découvre les multiples aspects sur son écran. Une belle histoire de thèse appliquée en tout cas.

Je me pose des questions sur l’affichage, le traitement et l’impression des photos faites avec le Lytro.

Affichage : le format RAW (dont j’ignore tout) peut-il s’afficher sur les lecteurs de photos usuels de Windows et autres OS ? Ou faut-il convertir la photo en JPEG ? Dans les deux cas, puisque le lecteur actuel n’a pas la fonction permettant de régler la mise au point sur telle ou telle zone, quelles parties de la photo seront affichées nettes par défaut ? Sur les exemples fournis, quel logiciel affiche la photo sur MON écran, qui permet de sélectionner la zone nette ? (je pense, comme l’auteur du message 21, que c’est un trucage rudimentaire ; votre réponse sur “les vidéos sur YouTube” me laisse dubitatif car un écran de 4 cm de large filmé avec une webcam et diffusé sur YouTube ne montre pas grand’chose)

Traitement : pour manipuler les photos faites avec Lytro, faudra-t-il des versions “Lytro” de Photoshop et compagnie ? Ou bien Lytro va-t-il vendre son logiciel “propriétaire” d’édition de photos ?

Impression : question similaire avec les logiciels d’impression actuels : quelles zones seront nettes par défaut ? Et faudra-t-il créer des logiciels “version Lytro” pour imprimer nettes les zones que l’on veut ?

Bonjour,

Même si j’interviens avec 3 guerres de retard dans ce fil, je profite de ces échanges très intéressants pour donner quelques informations supplémentaires.

Informations basées sur le fait que je suis possesseur d’un Lytro.

Lytro a besoin d’un logiciel dédié pour fonctionner: Lytro Desktop. C’est un logiciel assez basique et qui a besoin d’énormément progresser car il n’offre que peux de réglages et rien pour les réglages les plus basiques que sont le contraste / exposition ou saturation.

La gestion de la bibliothèque est également très limitée (impossibilité de copier une photo dans une autre partie de la bibliothèque, à la manière de Lightroom).

Réimporter une photo effacée sur le PC (mais présente sur le Lytro) est impossible.

Etc…

A l’heure actuelle, ce logiciel est le vrai point faible du Lytro surtout si on est habitué à de la grosse artillerie…

Même la fonction d’exportation JPEG est cachée…

Le besoin de puissance de calcul est également non négligeable car vider une trentaines de photos sur un PC équipé un Intel Core i7 prends un temps certains !

Côté prise de vues, l’appareil est délicat à utiliser à cause de son cadrage carré où il faut cohabiter une image qui devrait avoir de la perspective… Il faut avoir l’oeil.

Pour finir, on bute à des lois de la physique concernant la profondeur de champ. Si les sujets sont proches, comme avec un reflex, la photo sera nette sur les deux sujets. Idem s’ils sont éloignés.

Donc afin de tirer au maximum parti du Lytro et de ses Living Pictures un travail de composition est nécessaire et indispensable, sinon on est face à une photo nette de 0 à l’infinie et tout l’intérêt d’une photo plénoptique est balayé…

Bilan pour moi du Lytro: super appareil photo mais qu’il faut acheter en connaissance de causes sinon on se retrouve face à des photos que réussirai le moindre smartphone mais avec une resolution 10x plus faible.

Petite pub pour mon blog où je teste le Lytro: http://richard-olier.dyndns.org

Merci Richard pour ce très intéressant retour d’expérience. Pour l’instant, le bénéfice produit semble encore en retrait par rapport aux limites et contraintes. Cela s’améliorera sans doutes.

De mon côté, je suis plus en attente de progrès dans la sensibilité des capteurs et leur capacité colorimétrique (gamut) que dans cette gestion un peu compliquée de la profondeur de champ.

Côté capteur, j’attends une dynamique en hausse car celle-ci stagne depuis des ans.

Seul fuji tirait son épingle du jeu.

Le RAW ne permet pas tout 🙂

Pour revenir au Lytro, son autre défaut est la nécessité de passer par du tout “Lytro” pour récupérer ou diffuser ses images:

– Application dédiée pour lire les fichiers LPF

– Site web, géré par Lytro, pour diffuser ses photos sur internet.

Un environnement qui reste fermé et fragile car on est face à une startup qui peu disparaître à tout moment…

Reste le côté Fun et magique de réussir une belle Living Picture…

Comme je l’ai écrit…faire “juste une photo” est la quasi certitude de rien tirer de bon. Et d’être déçu…

Le Lytro reste un superbe objet technologique.

J’espère qu’il saura avoir une descendance.

Richard.

progre dans la sebsibilite des capteurs ,et la profondeur de champs