L’IA est un sujet relativement nouveau dans l’actualité des entreprises. C’est même “le” sujet le plus à la mode, après les vagues du cloud, de la mobilité et de la transformation digitale multiforme. Il génère son lot d’IA washing, un phénomène aux contours flous où de nombreux éditeurs de logiciels et startups habillent d’IA leurs solutions. Très souvent, cette appellation correspond à un usage d’une ou plusieurs techniques d’IA qui ne sont malheureusement pas toujours précisées. Les briques technologiques de ces solutions sont soit externes soit internes à la société. Il n’y a pas de mal à ce qu’elles soient externes car on ne reprochera pas à une startup de ne pas réinventer la roue.

Vu des clients, il est critique d’accéder à des études de cas de ces fournisseurs, histoire d’évaluer l’intérêt de lancer tel ou tel projet d’IA dans son entreprise. J’avais évoqué la question du “benchmark de l’IA” dans un post en mai 2017.

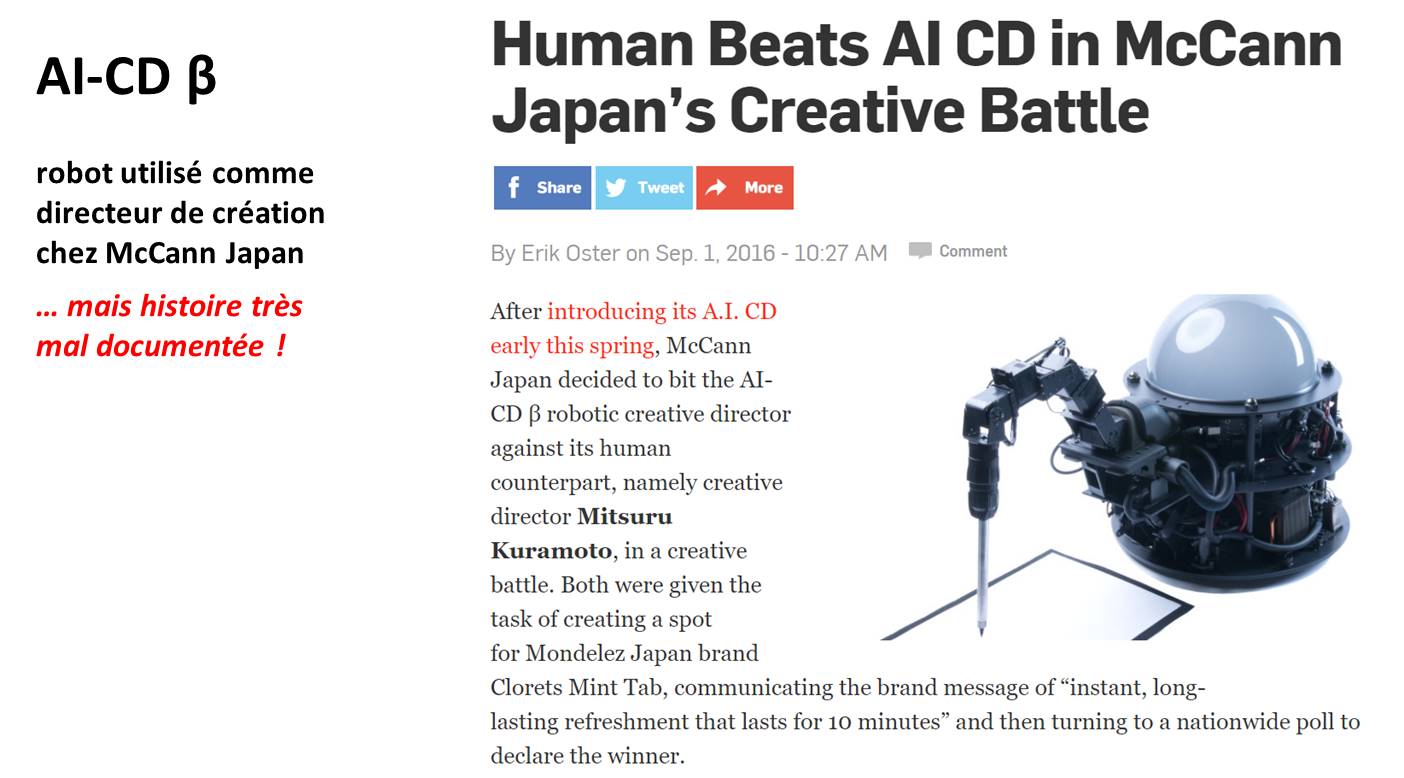

Nous avons grandement besoin de formalisme pour décrire les études de cas. Cela permet par exemple d’éviter les déclarations enflammées relayées par les médias et qui ne sont étayées par rien du tout. Comme l’exemple ci-dessous où l’on apprend qu’au Japon, une IA a été battue de justesse par des créatifs humains dans une agence de communication (source). Mais pas moyen de mettre la main sur les méthodes employées et sur les réponses des créatifs et de l’IA ! Ni, bien entendu, sur les techniques employées ! On ne voit que des clips vidéos produits par une IA et par des créatifs humains.

Voici donc une proposition de modèle de documentation d’étude de cas de projet intégrant de l’IA. C’est un modèle extensif qui sera probablement rarement complètement rempli. Peu d’entreprises ont envie de documenter leurs projets avec ce niveau de détails. Mais ces études de cas peuvent être réalisées par certains éditeurs pour des projets présentés “behind closed doors”. J’ai notamment pu le constater dans une présentation de Justine Baron de Recast.ai (solution de création de chatbots) lors du séminaire Intelligence Artificielle organisé par Frenchweb lors du Cristal Festival de Courchevel les 14 et 15 décembre 2017. Lors de ce séminaire d’un jour et demi, je faisais un tour d’horizon assez large des techniques et usages de l’IA.

Qu’est-ce qui est spécifique à l’IA dans ce modèle ? C’est ce qui est en bleu ci-dessous.

Société cliente

- Secteur d’activité.

- Taille de l’entreprise. Bien préciser la taille de l’entité couverte par la solution. “Total” ou “Orange” n’est pas assez précis. On est souvent trompé par les études de cas qui ne précisent pas leur portée dans une très grande entreprise. Très souvent, les projets n’en concernent qu’une toute petite entité.

- Lieu, ce qui intéressant dans le cas de déploiements internationaux.

Solution

- Description métier du besoin et de la solution. Comment faisait-on avant ? Quelles techniques classiques étaient utilisées ? Quels étaient les surcouts engendrés par l’existant ?

- Description technique de la solution. Quelles techniques d’IA intègre-t-elle : de l’IA symbolique (système expert, moteur de règle, logique floue), du machine learning, des réseaux de neurones simples, du deep learning, des réseaux convolutionnels, des réseaux récurrents ou à mémoire, des techniques de traitement du langage.

- Copies d’écrans de la solution, vue de l’utilisateur. L’interface utilisateur d’une solution logicielle est aussi importante que sa fonction !

- Schémas fonctionnels, un diagramme des flux des données avec leurs sources étant indiqué.

Données

- Nature, volume, origine et coût des données d’entrainement puis de production. Quels capteurs les ont générées (logs Internet, objets connectés, …). Quelles données sont d’origine interne et externe à l’entreprise ? Quelles données exploitées relèvent de l’open data. Quelles sont leurs conditions d’obtention commerciales ou en open data ?

- Fréquence de la mise à jour opérationnelle des données. Comment le modèle est-il réentrainé avec l’arrivée de nouvelles données ?

- Taux d’erreur mesuré de la solution si applicable. Ce taux est mesuré après l’entrainement du système d’IA si celui-ci utilise du machine learning ou du deep learning.

- Anonymisation des données exploitées le cas échéant. Est-ce que les données qui alimentent le machine learning ou le deep learning sont bien anonymisées. Normalement, c’est toujours le cas.

- Vidéo avec témoignage et démonstration, le cas échéant.

Fournisseurs

- Technologies. Au sens : logiciels de base (TensorFlow), d’infrastructure (Spark, Hadoop), progiciels divers et autres.

- Prestataires de services. En indiquant leur apport dans le projet.

- Ressources en cloud si pertinent. Et notamment, si des processeurs spécialisés (GPU ou neuromorphiques) sont utilisés, notamment pour l’entrainement d’un modèle de deep learning.

Dates

- Début du projet.

- Date des premiers tests opérationnels. Ce que l’on appelle un “PoC”, pour proof of concept.

- Date de la mise en production. Et portée de la mise en production en nombre d’utilisateurs.

Economie

- Coût du projet. Ressources humaines consommées en interne et en externe pour créer la solution. Types de compétences : développeurs, data-scientists, etc.

- Durée d’entrainement des modèles, dans le cas de solutions à base de deep learning.

- Nombre d’utilisateurs de la solution. Aujourd’hui et demain.

- Retour sur investissement. C’est la partie la plus difficile à mesurer sur de nombreux projets. Il faut pouvoir y intégrer l’ensemble des coûts relatifs au projet, y compris la formation des utilisateurs.

- Validation du projet au regard de la RGPD, la Règlementation Générale de la Protection des Données européenne qui entre en vigueur le 25 mai 2018.

J’ai aussi proposé le modèle à l’équipe du Hub#FranceAI dans le cadre de ses activités de formation des entreprises.

Est-ce complet ? Que manque-t-il à un tel modèle ?

Un volontaire pour créer une première étude de cas entièrement documentée ? Je la publierai volontiers dans ces colonnes !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

“Modèle d’étude de cas de l’ #iA ” de @olivez sur https://t.co/sBQhgz7qiQ pour @AssoPascaline @CINOV_IT @Lionelhovsepian @iconomie

@olivez #proposition de #modèle d’#étudedecas sur l’#IA

#Intelligence #Artificielle https://t.co/FoBs6ngm91

Modèle d’étude de cas de l’IA: une bonne trame pour les études de cas https://t.co/bPcqQ2BJqG

Bonjour Olivier,

Toujours un plaisir et un enrichissement de lire vos articles.

Dans une étude de cas IA, je rajouterais néanmoins une matrice d’impacts (dont l’humain, trop souvent oublié).

Identifier l’ensemble des répercussions sur la chaîne de valeur de l’entreprise est nécessaire avant l’implémentation et requiert des compétences et une expérience en IA non négligeables.

Egalement, les projets IA que nous menons ont des impacts humains généralement plus forts que les projets de transformation plus “traditionnels”. Un point important à prendre en compte.

Intéressant. Sachant cependant qu’une étude de cas n’est pas une thèse de doctorat en économie ou en sciences sociales !

Bien entendu !

Cependant la matrice d’impacts peut être assez rapidement complétée avec de l’expérience dans les projets IA et une bonne connaissance des métiers de l’entreprise.

Comme vous le disiez très justement dans votre livre sur l’usage de l’IA : l’intelligence artificielle peut faire peur (syndrome de Frankenstein, disparition des emplois…). Il faut alors accompagner les entreprises et leur faire comprendre que loin de faire disparaître des postes, l’IA transforme (notion “d’augmenté”) et crée des nouveaux besoins humains.

Bref, je pense que comme dans tout projet, l’entreprise est intéressée non seulement par la solution (très bien découpée dans votre article), mais également – et de plus en plus – par les conséquences (en particulier RH, culture d’entreprise…) sur l’ensemble de la chaîne de valeur de l’entreprise. On est là sur un grand débat : tsunami technologique, culture d’entreprise, humain vs IA… comment garder le juste milieu? (un nouvel article peut être?)

Je vais m’essayer à votre proposition de modèle en y ajoutant la dimension impact que je décris, et vous ferais un retour quand j’aurai quelque chose de satisfaisant ! 😉

Ready to share a case study on AI? here is the template https://t.co/DfX0ziqWot

Cher Olivier,

Après la lecture très intéressante de la critique du Rapport Villani, il me semble que cette initiative de structuration des études de cas doive être mise à jour avec 2 aspects :

> La contribution d’un cas à l’amélioration des capacités françaises en termes d’IA (ce que l’on a indirectement dans les moyens utilisés)

> Un sujet qui me semble crucial : l’absence de biais ou de renforcement de biais dans les dataset d’entraînement et les algorithmes. Je travaille sur une méthode d’évaluation et de correction de ces biais, tout retour pourra l’alimenter et aller ainsi au-delà de la bienveillante “éthique”.

Luc

Merci pour cet input.

Le premier point serait optionnel car nombre d’études de cas peuvent provenir d’acteurs étrangers, soit à l’étranger, soit réalisées en France.

Le second point est intéressant en effet.

Sachant que pour l’instant, les études de cas courantes sont extrêmement mal documentées et que mon template d’origine relève déjà de la science fiction dans le marketing des principaux fournisseurs ! 🙂

Bonjour Olivier,

Je viens de voir ta demande de use cases.

Je bosse pas pour Deezer,et ils n’en ont pas fait beaucoup de publicité.

Leur outil, utilise TensorFlow.

Ils utilisent le machine learning avec un jeux d’entrainement MUSDB18-HQ

Ce que fais l’outil, c’est de dissocier les différents instruments dans un morceau musical, tu sais que toutes les fréquences sont mélangées dans un moreceau, même en appliquant les transformées de Fourrier, les transformées en ondelettes etc. c’est extrèmement difficile de dissocier les différents instruments.

Ce qui était utilisé auparavent, rien de bien probant que je sache.

J’ai personnellement fait un essai avec un morceau, et c’est assez bluffant.

https://github.com/deezer/spleeter

Je vais essayer de remplir le template avec un cas d’IA dans le Edge (industriel)

Joël