Jâintervenais en ouverture du forum annuel du Cert-IST mercredi 29 novembre 2017 Ă Paris pour dresser un tableau gĂŠnĂŠral de lâimpact de lâintelligence artificielle sur la cybersĂŠcuritĂŠ (prĂŠsentations).

Le Cert-IST – Computer Emergency Response Team – Industrie, Services et Tertiaire – est une association qui ĂŠmane de Thales et qui partage les bonnes pratiques dans la cybersĂŠcuritĂŠ entre ses entreprises françaises membres. On y trouve des banques, opĂŠrateurs tĂŠlĂŠcoms, des services publics et divers industriels, notamment des secteurs de lâaĂŠrospatial et de la dĂŠfense. Mon intervention avait ĂŠtĂŠ proposĂŠe par une autre association, le CLUSIF â Club de la SĂŠcuritĂŠ de lâInformation Français â qui associe des offreurs de solutions de cybersĂŠcuritĂŠ et des utilisateurs de ces solutions. Câest un peu lâĂŠquivalent dâun mixte Syntec NumĂŠrique + CIGREF (club des DSI de grandes entreprises) appliquĂŠ Ă la cybersĂŠcuritĂŠ.

Mon intervention et celles auxquelles jâai pu assister lors de ce forum me donnent donc lâoccasion de faire un point rapide sur ce sujet ĂŠpineux de lâimpact de lâIA sur la cybersĂŠcuritĂŠ. Le forum mettait très bien en ĂŠvidence des aspects très pratiques et concrets des usages ou dĂŠrives de lâIA, bien loin des thèses fumeuses de la singularitĂŠ.

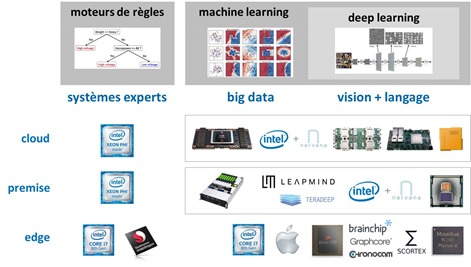

Dans mon intervention, jâai commencĂŠ, comme dâhabitude, par segmenter les technologies de lâIA en grandes composantes : les moteurs de règles, le machine learning, le machine learning Ă base de rĂŠseaux de neurones, puis le deep learning qui utilise des rĂŠseaux de neurones profonds, et enfin, les agents et rĂŠseaux dâagents qui permettent dâassembler les briques de lâIA pour crĂŠer des solutions : robots, vĂŠhicules autonomes, chatbots et autres.

Jâai surtout expliquĂŠ comment fonctionnaient les rĂŠseaux de neurones profonds avec le cas de la reconnaissance dâimages, puis expliquĂŠ comment ces rĂŠseaux de neurones ĂŠtaient mis en Ĺuvre cĂ´tĂŠ matĂŠriel dans des processeurs spĂŠcialisĂŠs (GPU et processeurs neuromorphiques) qui font leur apparition Ă la fois du cĂ´tĂŠ des serveurs, notamment pour les phases dâentrainement des rĂŠseaux de neurones, et du cĂ´tĂŠ des objets connectĂŠs et mobiles, pour leur exĂŠcution. Avec les nouveaux risques que cela peut gĂŠnĂŠrer. Il y a dâailleurs un lien ĂŠtroit, dans la cybersĂŠcuritĂŠ, entre lâIA, les objets connectĂŠs en tout genre et les rĂŠseaux tĂŠlĂŠcoms. Ils constituent un continuum quâil faut sĂŠcuriser de bout en bout ! Et les vulnĂŠrabilitĂŠs Ă traiter sont très nombreuses Ă chacune des ĂŠtapes de la chaine qui alimente les solutions exploitant des techniques logicielles Ă base dâIA. Cela affecte surtout celles qui fonctionnent avec des modèles probabilistes comme dans tout le pĂŠrimètre du machine learning.

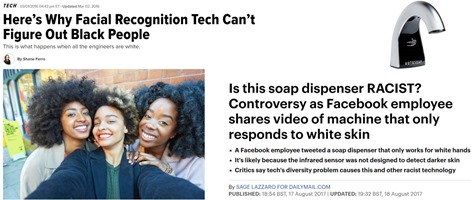

Jâexpliquais aussi ce que lâon appelle le âbiais des donnĂŠesâ, et comment celui-ci peut amener Ă crĂŠer un système dâIA qui ne fonctionne pas bien dans la pratique lorsque ses donnĂŠes dâentrainement ne sont pas reprĂŠsentatives de son pĂŠrimètre dâusage. Lâexemple classique ĂŠtant le système de reconnaissance faciale qui nâa ĂŠtĂŠ entrainĂŠ quâavec des visages de blancs et qui ne reconnait donc pas les visages de couleur. Mais cet exemple, marquant, peut en illustrer dâautres.

Au-delĂ de considĂŠrations humaines et ĂŠthiques, la question qui se pose est purement statistique et probabiliste : un système dâIA Ă base de machine learning et de deep learning ne fonctionnera bien que si les donnĂŠes qui ont servi Ă lâentrainer sont reprĂŠsentatives des donnĂŠes qui seront ensuite exploitĂŠes en production. Câest exactement le mĂŞme problème que dans un sondage politique : lâĂŠchantillon utilisĂŠ doit ĂŞtre reprĂŠsentatif de la population dâensemble. Si vous faites un sondage uniquement Ă Paris, dans le XVIe arrondissement, dans le 93, en Mayenne ou Ă Strasbourg, vous nâaurez pas un ĂŠchantillon reprĂŠsentatif de la diversitĂŠ du pays.

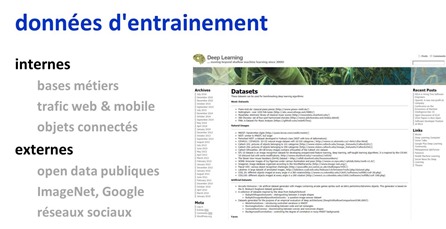

De nombreux systèmes dâIA sont entrainĂŠs avec des sources de donnĂŠes internes et externes Ă lâentreprise. Câest un moyen de crĂŠer des modèles pertinents avec des donnĂŠes complĂŠmentaires, mais cela prĂŠsente aussi une surface dâattaque plus grande par des cyberpirates. Il faut donc en tenir compte dans la conception des modèles.

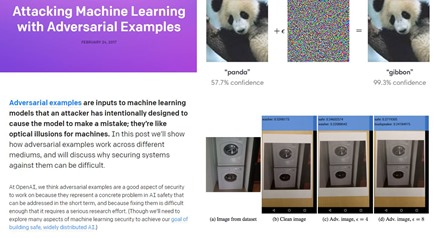

Enfin, jâai fait un rapide tour de quelques nouvelles menaces liĂŠes au machine learning et surtout au deep learning. Montrant par exemple comment on peut tromper des systèmes de vision artificielle en altĂŠrant très lĂŠgèrement les images. LĂŠgèrement mais suffisamment pour modifier la reconnaissance dâimages qui, dans la pratique, sâappuie sur des modèles probabilistes. Cf Understanding the limites of deep learning de Mariya Yao (mars 2017).

Jâai aussi illustrĂŠ cela avec la mĂŠthode de crĂŠation de masques permettant de tromper le login FaceID de lâiPhone X. Cette mĂŠthode digne de la sĂŠrie et des films Mission Impossible, consiste Ă crĂŠer un masque 3D imitant la forme dâun visage standard, sur lequel sont plaquĂŠes les photos imprimĂŠes en 3D des yeux, de la bouche et du nez de la personne dont on veut dĂŠbloquer le tĂŠlĂŠphone. Pourquoi ces parties du visage ? Parce que ce sont celles qui sont reconnues par le système de login dâApple, et par les systèmes dâidentification faciale en gĂŠnĂŠral. Câest lĂ que se situent les traits qui sont transformĂŠs en paramètres mathĂŠmatiques uniques permettant de reconnaitre un individu. Câest une belle vulnĂŠrabilitĂŠ, mais le hack nâest tout de mĂŞme pas facile Ă rĂŠaliser. Seuls les pirates rĂŠellement dĂŠterminĂŠs lâexploiteront et sur des cibles dites âĂ forte valeurâ.

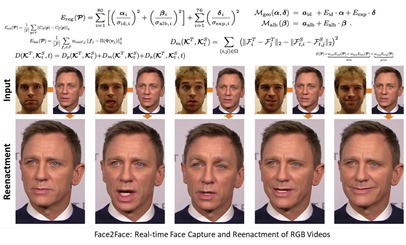

Jâai aussi prĂŠsentĂŠ quelques exemples de âfake newsâ crĂŠĂŠs par des rĂŠseaux de neurones gĂŠnĂŠratifs, comme le projet âface2face reenactmentâ qui permet dâanimer un visage donnĂŠ Ă partir de la captation de la vidĂŠo dâune tierce personne, et celle consistant Ă faire parler Barack Obama avec un texte prĂŠparĂŠ. La technique utilise deux rĂŠseaux de neurones gĂŠnĂŠratifs : lâun pour animer son visage et lâautre pour gĂŠnĂŠrer sa voix, originaire de la startup Lyrebird. Le tout est assez bluffant. Au passage, un petit truc : ces rĂŠseaux gĂŠnĂŠratifs fonctionnent pour lâinstant Ă basse rĂŠsolution. Les images gĂŠnĂŠrĂŠes dĂŠpassent rarement 256 pixels de cĂ´tĂŠ pour des raisons de puissance machine disponible. Mais avec les progrès du matĂŠriel, les faux vont probablement gagner rapidement en rĂŠsolution et en rĂŠalisme.

Juste après moi, jâai assistĂŠ Ă une très bonne prĂŠsentation pratique dâAnaĂŤl Beaugnon de lâANSSI, lâagence du gouvernement qui gère la sĂŠcuritĂŠ des systèmes dâinformation de lâEtat mais prodigue aussi des recommandations aux entreprises. Elle expliquait comment les solutions Ă base de machine learning ĂŠtaient utilisĂŠes pour dĂŠtecter des intrusions. Elle mettait bien en ĂŠvidence les modèles statistiques sous-jacents et leurs limites. Lâenjeu de ces systèmes est de minimiser leur dĂŠtection de faux positifs ou, surtout, de faux nĂŠgatifs, en raison dâeffets de bord. AnaĂŤl Baugnon prĂŠsentait lâoutil SecuML dĂŠveloppĂŠ Ă lâANSSI qui sert Ă diagnostiquer un classifieur de cybersĂŠcuritĂŠ. Il est en open source sur Github. Jâai au passage dĂŠcouvert de nombreux outils du monde de la cybersĂŠcuritĂŠ en entreprise : la base de donnĂŠes de malwares Contagio, les outils de dĂŠtection de fichiers PDF malveillants, le projet ILAB dâannotation de donnĂŠes par les experts pour la dĂŠtection dâintrusion dont AnaĂŤl Baugnon est coauteure, ainsi que le projet ALADIN.

Sa prĂŠsentation faisait bien ĂŠcho Ă une tendance que lâon peut observer du cĂ´tĂŠ des startups du secteur, qui se sont lancĂŠes dans lâutilisation du machine learning (avec ou sans rĂŠseaux de neurones) pour dĂŠtecter des virus, phishings et autres intrusions. La tendance lourde du secteur consiste Ă crĂŠer des modèles statistiques qui dĂŠtectent des âpatternsâ dans les logiciels suspects plutĂ´t que de crĂŠer des bases de signature Ă la main. Ces systèmes exploitent essentiellement des techniques de machine learning.

Dans mon dernier ebook âLes usages de lâintelligence artificielleâ publiĂŠ en octobre 2017 (gratuit, et dĂŠjĂ tĂŠlĂŠchargĂŠ plus de 14 500 fois), je faisais ainsi un inventaire page 177 de quelques startups de ce secteur utilisant des modèles de machine learning : âLes tentatives de phishing sont dĂŠtectĂŠes par GreatHorn (2015, $8,83m) ou avec Lookout (2007, $282m) qui sĂŠcurise les mobiles avec un modèle prĂŠdictif. Les malwares sont dĂŠtectĂŠs avec du machine learning par Cylance (2012, $177M). LâisraĂŠlien DeepInstinct (2014, $32M) protège les systèmes contre les failles de sĂŠcuritĂŠ rĂŠcentes (âzero day threatsâ). Ce serait la première startup Ă exploiter le deep learning – avec des GPU Nvidia – tandis que la plupart utilisaient du machine learning jusquâĂ prĂŠsent pour faire de lâanalyse multifactorielle des menaces en lieu et place de lâutilisation de bases de signatures de virus. Dans le mĂŞme genre, Recorded Future (2009, $33M) utilise le machine learning pour dĂŠtecter les menaces de sĂŠcuritĂŠ en temps rĂŠel. Des startups comme Onfido (2012, $30M) vĂŠrifient lâidentitĂŠ de clients de service en ligne. Câest de la dĂŠtection de fraude basĂŠe sur du machine learning et du prĂŠdictif. LâisraĂŠlien Fortscale (2012, $32M) identifie de son cĂ´tĂŠ les menaces internes dans les entreprises, avec sa solution User & Entity Behavioral Analytics (UEBA). Il va dĂŠtecter des comportements suspects comme la copie de fichiers de grande taille sur des clĂŠs USB ! Dans les pays oĂš ce genre de surveillance est autorisĂŠe !â.

Il faudrait aussi ajouter les outils qui permettent d’analyser les failles de sĂŠcuritĂŠ de ses propres solutions logicielles. Les offres sont abondantes dans ce domaine. On peut notamment citer le framework open source Frame-C dĂŠveloppĂŠ par le CEA-LIST, l’institut de recherche sur les systèmes numĂŠriques intelligents du CEA, qui s’appuie directement sur des mĂŠthodes formelles Ă base d’IA.

Dans la pratique, les modèles doivent cependant ĂŞtre entraĂŽnĂŠs par des bases de donnĂŠes associant de nombreux logiciels et leur niveau de menace. Vincent Letoux dâEngie insistait dans sa prĂŠsentation sur le besoin de ne jamais ĂŠvacuer lâHomme des processus de dĂŠcision dans ces systèmes. Câest un point de vue de bon sens. De son cĂ´tĂŠ, Dimitri Tromboff de Thales expliquait comment le machine learning ĂŠtait utilisĂŠ dans la pratique.

Dâautres interventions portaient sur des sujets de cybersĂŠcuritĂŠ ĂŠloignĂŠs de la thĂŠmatique de lâIA, comme un post-mortem de la lutte contre les ransomwares. Il y avait notamment celle du dynamique Eric Barbry, avocat du cabinet dâAlain Bensoussan que lâon ne prĂŠsente plus. Il expliquait en 45 minutes bien denses les enjeux de lâentrĂŠe en vigueur de la directive RGPD le 25 mai 2018, portant sur la protection des donnĂŠes personnelles et la vie privĂŠe. Les entreprises vont avoir du pain sur la planche ! Il existe dâailleurs une vĂŠritable interaction entre la RGPD et lâIA, notamment autour des notions du droit Ă lâoubli et de celui de la portabilitĂŠ des donnĂŠes. Lorsque vos donnĂŠes personnelles ont servi Ă entrainer un rĂŠseau de neurones, comment fait-on pour faire oublier votre existence Ă ce rĂŠseau de neurones ? La question est mathĂŠmatique et logique autant que juridique !

Bref, comme dans tous les mĂŠtiers du numĂŠrique, la cybersĂŠcuritĂŠ nâĂŠchappe pas Ă la vague de lâIA. LâIA amène Ă revoir les raisonnements, elle change les mĂŠthodes, et permet de se remĂŠmorer que lâIA ne fonctionne pas toute seule. Elle est alimentĂŠe et corrigĂŠe en permanence par des donnĂŠes dâorigine humaine.

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Très intÊressant article de @olivez sur la #cybersecurite et l #IntelligenceArtificielle : https://t.co/WJIPjTu4iW

“Lorsque vos donnĂŠes perso ont servi Ă entrainer un rĂŠseau de neurones, comment fait-on pour faire oublier votre ex⌠https://t.co/jAJE1PDWIJ