Le 21 mars 2017 était présenté devant le Président de la République un plan destiné à faire de la France un leader mondial de l’intelligence artificielle (vidéo). J’avais eu l’occasion pendant l’été 2016 de décortiquer les grands plans technologiques français depuis les années 2000. Cette annonce était l’occasion d’observer la répétition ou pas des patterns qui sévissent lors de la création de ce genre de plans un peu fourre tout. Malheureusement, l’histoire a trop tendance à se répéter. Et nous allons essayer de comprendre pourquoi.

C’est un plan d’ampleur lancé sous l’égide de Bercy et du Ministère de l’Enseignement Supérieur et de la Recherche. 559 personnes ont été interrogées et ont participé à de nombreux groupes de travail : des chercheurs, des directeurs de recherche, des entrepreneurs de startups et des représentants de grandes entreprises. Bref, la crème de la crème avec à sa tête d’éminentes personnalités telles que Cédric Villani (Institut Poincaré), Antoine Petit (INRIA), Rand Hindi (Snips) et tout le toutim.

Un diagnostic convenable

Les travaux de ces centaines de contributeurs se trouvent consolidé dans un épais document de 350 pages. Le rapport de synthèse d’une grosse trentaine de pages est assez concis. Ces documents semblent très exhaustifs. Ils couvrent presque tous les recoins des sujets sur l’IA, tant côté recherche, qu’industriels et sociétaux.

Le diagnostic d’ensemble n’est pas trop mauvais : notre recherche fondamentale est assez dispersée, elle est surtout financée et réalisée par le secteur public, l’investissement dans la R&D en IA provenant du secteur privé et notamment des grandes entreprises étant faible en contrepartie. Et pour cause puisque nous avons peu de pure players industriels dans le domaine. Ce tableau rappelle celui des biotechs où la recherche publique domine largement le paysage français.

Le rapport s’inquiète du manque de transferts technologiques provenant de cette recherche fondamentale, ce qui n’est pas une spécificité de l’intelligence artificielle. Les observateurs semblent engoncés comme d’habitude dans une vision linéaire des processus d’innovation allant de la recherche aux entreprises, via la création d’entreprise ou la valorisation. On retrouve cela dans l’organisation en groupes de travail : recherche amont, formation, transfert de technologies et développement de l’écosystème. Puis des groupes verticaux sur le véhicule autonome, la relation client et la finance (mais pas la santé). Puis sur la souveraineté, la sécurité nationale et sur les impacts économiques et sociaux.

Le rapport évoque aussi plutôt bien le rôle stratégique des données qui alimentent l’IA. Le big data ! L’or noir des données. On en parle cependant beaucoup plus qu’on ne trouve de manières de les valoriser économiquement et de manière différenciée.

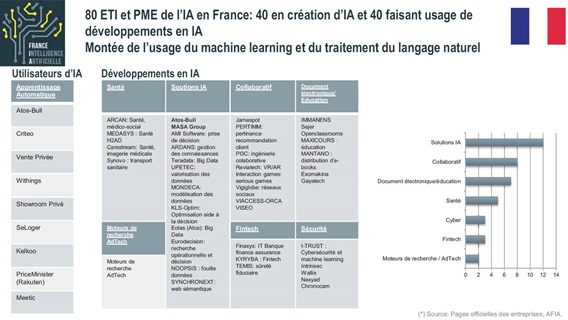

On trouve dans le rapport des groupes de travail un état des lieux formidable. Il comprend une cartographie fouillée de la recherche française en intelligence artificielle, complété par celle des entreprises l’utilisant. Il reprend peut-être l’effort initial de cartographie démarré par Paul Strachman, “France Is AI”, le représentant du fonds d’investissement ISAI à New York. Le rapport détaille aussi les stratégies de grands acteurs américains et chinois ainsi que les plans lancés par différents gouvernements dans le monde. C’est un inventaire très utile pour se faire une idée de la concurrence mondiale.

Le plan IA évoque sinon l’habituelle question de la souveraineté, un sujet classique dans l’univers de l’immatériel. Il s’épanche aussi sur l’impact futur de l’IA sur l’emploi, sans trop rentrer dans le débat politique sur le revenu minimum.

Du côté sectoriel, le plan se focalise sur sept secteurs d’activité : la construction automobile, la la relation client, la finance, la santé, les énergies renouvelables, la robotique et l’éducation numérique. Nous avons en tout 9 pages avec des dizaines de recommandations diverses génériques, ou dans certains seulement de ces secteurs d’activité comme pour le véhicule autonome.

Un inventaire minutieux et bienvenu de l’IA en France

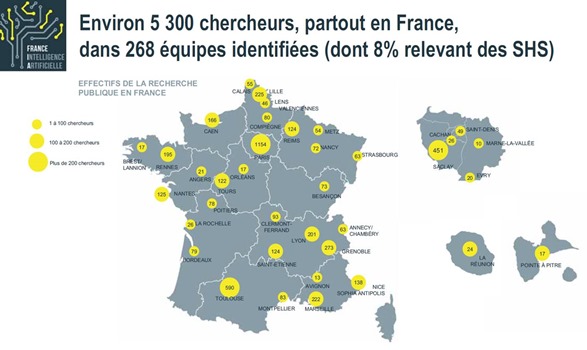

Dans l’inventaire du plan, on apprend que la France comprend 5300 chercheurs plus ou moins spécialisés dans l’IA, un chiffre qui était difficile à obtenir jusqu’à présent. Ces effectifs sont bien répartis dans toute la France, l’Ile de France en représentant “seulement” 1154. C’est un chiffre à conserver en tête lorsque, par exemple, on apprend que Google fait l’acquisition de telle ou telle startup dans l’IA, générant l’impression qu’ils vampirisent toutes les compétences mondiales dans le domaine. Lorsqu’ils ont fait l’acquisition de l’anglais Deep Mind en 2014, la startup représentait 50 chercheurs. Elle en aurait maintenant plus de 200. Mais dans le même temps, Google serait en train de porter à 3000 le nombre de ses chercheurs en IA à Zurich. Oops.

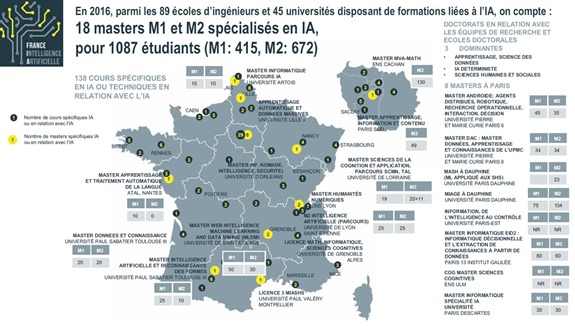

Côté formation, elle répondrait tout juste aux besoins des startups et des entreprises établies avec à peine plus de 1000 étudiants dans le large champ de l’IA dans l’enseignement supérieur. Quand on y regarde de près, on peut observer que la formation est encore trop faiblement verticalisée par domaines d’activités et d’applications (santé, transports, …), ce qui est déjà vrai dans le numérique en général.

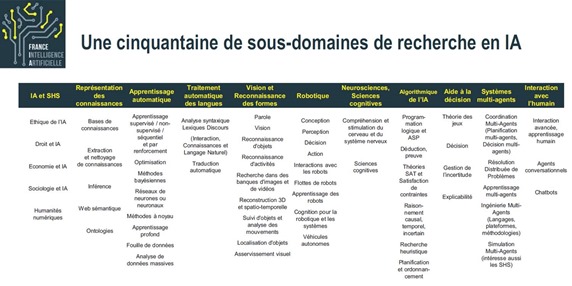

L’autre élément intéressant de ce document est le découpage du vaste champ de l’intelligence artificielle par domaine, correspondant à la vue du sujet par la communauté des chercheurs. Cette vue rappelle, comme je l’avais fait en 2016 dans “Les avancées de l’intelligence artificielle”, que les techniques de l’IA, vues de près, n’ont rien de fantasmagorique ou de magique. Ce sont des techniques mathématiques et logicielles qui, prises isolément, sont relativement simples. Elles sont parfois assez anciennes. La magie vient surtout de leur intégration et de la qualité des données qui les alimente, complétées par la puissance du matériel.

Il existe une autre source qui a du inspirer le groupe de travail sur la recherche, l’inventaire de thématiques réalisé en septembre 2016 par l’INRIA dans un excellent livre blanc en anglais : “Artificial Intelligence – Current Challenges and Inrias’s engagement“.

Enfin, est présenté un panorama des stratégies d’IA des grands acteurs américains (GAGAMI…) et un inventaire de startups, PME et ETI du champ de l’IA en France.

Les déceptions habituelles des plans stratégiques à la française

Bref, les deux rapports France IA constituent un bel ouvrage, un inventaire de bon niveau de l’IA en France et de certains de ses enjeux. Ce plan a été réalisé en seulement deux mois, ce qui est un record de rapidité. Ce n’est probablement qu’une première étape d’un processus itératif.

Et pourtant, il génère en arrière gout bizarre et une grande déception. Malgré toutes leurs qualités et celles de leurs contributeurs (j’ai d’ailleurs été invité à y contribuer, mais n’était pas disponible aux dates proposées), ce plan stratégique n’en est pas vraiment un. On n’y décèle qu’une eau tiède. Rien de bien enthousiasmant ou de mobilisateur, rien de bien différenciant avec les autres pays, surtout les USA ou la Chine. On veut faire de la France un leader de l’IA mais la dynamique industrielle associée semble traitée de manière distanciée, même si elle est couverte.

Pourquoi, après tant d’efforts, en arrive-t-on toujours là ? Cela s’explique par quelques raisons structurelles auxquelles il est difficile d’échapper sans volonté politique forte. Les voici avec quelques pistes pour éviter cette fatalité habituelle.

Le plan conçu par des comités pléthoriques

Le syndrome classique du plan “fait en comité” se retrouve dans sa grande splendeur : pour plaire à tout le monde, on parle de tout. Il n’y a pas une ambition plus haute que les autres. Le niveau hétérogène des intervenants fait que l’on mélange allègrement stratégies et tactiques. Et qui plus est, il n’y a que des français dans le tas, à part quelques rares exceptions, comme Liam Boogar, américain basé depuis quelques années à Paris, et qui représente la startup Algolia.

Un plan agrégateur représente les parties prenantes représentatives qui sont sélectionnées (cf la liste des 559 participants ci-dessous). La sélection était très large, couvrant à peu près tous les métiers et tous les types d’organisations concernées (chercheurs, startups, PME, ETI, grandes entreprises, Etat). Or, la ventilation de ces parties prenantes incarne l’état des lieux actuel, pas forcément un état désirable. Par exemple, au niveau du poids des grandes entreprises ou des entreprises de services face aux éditeurs de logiciels ou aux pure players de l’IA. Plus on a de grandes entreprises impliquées, plus elles influencent les grilles de lecture et génèrent des conservatismes. C’est le phénomène de la VivaTechnologisation de l’innovation. Elle limite la capacité à se remettre en cause.

Cela se retrouvait aussi dans le groupe de travail sur la recherche qui ne comprenait que des chercheurs et quelques hauts fonctionnaires représentant la DGE et le CGI. Pas un seul “client” de la recherche ! Donc, les priorités de la recherche étaient établies dans ce groupe de travail sans les relier à un quelconque besoin stratégique, entrepreneurial ou économique. Ce groupe de travail a défini 36 sujets de recherche disruptifs. Disruptifs ? Les têtes de chapitre sont des généralités (apprentissage profond, recommandations, décision sous incertitude, causalité, optimisation, raisonnement sur l’autre, IA intégrative et robotique, IA embarquée, etc). Cela évoque cependant l’AGI, l’intelligence artificielle généralisée, un Graal de nombreux scientifiques et prospectivistes.

Dans le détail, prenons l’exemple de l’IA embarquée :

”Les réalisations récentes les plus marquantes de l’intelligence artificielle, telles que les assistants personnels (Siri, OK Google, Cortana, …) ou les machines à jouer (AlphaGo, DeepStack, Watson, …) utilisent une puissance de calcul qui ne peut, en l’état actuel de la technologie, être embarquée dans des dispositifs autonomes. Beaucoup d’applications de l’IA, civiles et militaires, seront cependant appelées à fonctionner sous contraintes fortes d’autonomie (absence de communication), de temps de réponse et de confidentialité. De nouvelles architectures de circuits, voire de nouveaux procédés, adaptés aux systèmes embarqués, restent à imaginer.”

Quelle est donc la disruption envisagée face aux mastodontes américains du sujet ? L’état de l’art cite essentiellement des travaux de chercheurs étrangers ! Et la disruption reste… à “imaginer” ! Très fort !

A noter aussi que le plan d’action est sans “owner” des actions, ni budget ou timing. Ça rendra difficile le suivi de son exécution. Qui plus est, un plan réalisé par un gouvernement en fin de mandat a peu de chances d’être suivi d’effets.

Ce poids de la recherche fondamentale dans le plan vient du rôle du Ministère de l’Enseignement Supérieur et de la Recherche qui est l’un des deux co-sponsors du plan IA. Ce plan relève d’un compromis entre la Recherche et l’Industrie à Bercy. Il se cache probablement des guerres de clocher administratives et des luttes d’influences entre les administrations centrales de ces deux ministères, ce d’autant plus que Bercy est un peu fragilisé par un léger remaniement récent, Christophe Sirugue ayant repris au pied levé le portefeuille d’Axelle Lemaire qui a quitté le gouvernement fin février. Or c’est elle qui avait lancé l’initiative IA !

Nous avons aussi un exemple du “chacun voit midi à sa porte” dans le groupe de travail sur la formation. Celui-ci propose que l’enseignement « IA, traitement des données et sciences numériques » soit mis au programme de l’école primaire. C’est dans la lignée de l’apprentissage du code dès le plus jeune âge avec du Scratch. Ils y vont fort. Pourquoi ne pas enseigner en primaire la mécanique quantique, tant qu’on y est, avant l’écriture et le calcul ?

Le groupe dédié au thème de la valorisation industrielle rassemblait des chercheurs et des entreprises de toutes tailles, ce qui était plus équilibré. Mais s’y développait une vision d’utilisation de l’IA et pas de création d’une industrie de l’IA. C’est la même chose que dans nombre de plans numériques du passé où l’on a toujours mis plus l’accent sur les usages du numérique par le grand public, les entreprises et l’Etat que dans la création d’entreprises créatrices de produits dans le secteur. On y trouve d’ailleurs les habituelles propositions de programmes de recherche collaborative et d’appels à projets divers, un vieux marronnier qui permet aux entreprises de toutes tailles de vivre sur des subventions.

Autre bizarrerie liée au casting, l’auto-centrage sur les besoins de l’Etat. Le Rapport de synthèse contient une boite à idées hétéroclites Colbertiennes comme le développement d’assistant conversationnel intelligent en soutien à la modernisation de l’action publique. C’est peut-être le seul projet vraiment ambitieux de tout le plan car la création d’un tel agent est un véritable défi technologique du cinquième ordre !

Bref, quand il y a trop de monde impliqué, on saupoudre, on fait du puzzle, on noie le poisson. Ce genre de plan sert surtout à faire un état des lieux. Or établir une stratégie, c’est faire des choix, définir une ambition et ne pas tout faire. Cela demande du leadership. Visiblement, il n’existait pas du tout à l’échelon politique ou administratif.

L’excellence pas qualifiée

Les documents répètent à l’envie que la France dispose d’une recherche d’excellence. On retrouve cette rengaine dans de nombreux plans industriels. On se pose ensuite la question de la valorisation de cette excellence dans l’industrie.

Cependant, cette excellence n’est pas bien qualifiée. Les rapports mettent en avant différents benchmarks en termes de publications, brevets ou nombre de chercheurs. On se retrouve troisième en nombre d’articles scientifiques publiés. Et en second en Europe en startups financées.

Est-ce la seule mesure de l’excellence ? Comment cette excellence peut-être se développer et être valorisée ? Peut-on se contenter de généralités et d’indiquer que l’enseignement des mathématiques en France est meilleur qu’ailleurs ? L’excellence est une vision statique, pas dynamique. Ne peut-on pas se donner des défis ambitieux ?

Finalement, ou souhaite-t-on être excellent et durablement et avec un impact économique ? Ce n’est pas indiqué dans le plan. C’est un secret d’Etat !

Le gouffre entre produits et services

En page 10 du Rapport de Synthèse, on trouve cette perle sur l’approche service vs produit :

“La France doit faire naître des leaders emblématiques en matière d’IA qui structureront les écosystèmes nationaux et joueront le rôle de figure de proue à l’international pour l’ensemble des acteurs français. De grands intégrateurs en IA proposant des systèmes clés en main peuvent jouer un rôle essentiel dans ce sens. En étant la pièce maitresse du couplage entre l’offre, portée le plus souvent par des startups et des PME, et la demande, tirée par les grandes entreprises et les grands groupes, les intégrateurs sont un élément charnière de la chaîne de valeur.Ils sont à même de devenir des leaders emblématiques de l’IA ou d’en permettre l’essor. Un atout de notre pays est de compter, d’une part, plusieurs entreprises de référence dans les services numériques et le conseil en technologies qui ont le potentiel pour s’imposer comme de grands systémiers de l’IA, et d’autre part, de grands groupes utilisateurs susceptibles de créer des spin-offs qui le deviendront.”

On sent l’influence des grandes entreprises de services numériques, qui pourtant n’étaient pas nombreuses dans les groupes de travail (il y avait surtout ATOS). Cette approche “service” est complètement hors des clous. C’est d’ailleurs elle qui plombe l’industrie du numérique depuis des décennies. Le poids des ESN (Entreprises de Services Numérique) a toujours été élevé dans l’emploi et la valeur ajoutée numériques en France. Alors que le poids des entreprises produits, notamment les éditeurs de logiciels et grands acteurs de l’Internet, est faible. Tout du moins, plus faible et moins influent qu’il ne l’est aux USA ou dans des pays très innovants dans le numérique tels qu’Israël, Taïwan ou la Corée du Sud. La contraposée au manque de GAFA en France est l’hyperprésence des grandes ESN. Elle relève de la lacune industrielle dans l’approche volume et produit vs l’approche projets et services. Ces ESN accompagnent surtout les grandes entreprises dans leurs projets. Mais jouent un rôle marginal dans la création d’une industrie de l’IA en tant que telle, avec des offres de produits. Elle créé d’ailleurs une forte concurrence côté emploi, en aspirant une bonne part des ingénieurs et universitaires qui sortent de l’enseignement supérieur.

Ca continue sur les startups avec une curieuse proposition consistant à faire des ESN des entreprises d’intégration des solutions des startups de l’IA ! Donc, les startups françaises de l’IA vont devenir des leaders mondiaux en s’adossant aux ESN qui eux-mêmes bossent pour les grands comptes français. On est bien partis !

“Les startups et PME françaises fournisseurs de technologies, qui disposent souvent de peu de moyens à consacrer au marketing, sont en effet confrontées à l’enjeu de faire connaître leurs briques technologiques à une audience la plus large possible. Des plateformes mutualisées dans lesquelles ces entreprises mettraient à disposition leurs briques technologiques pour des tests par des tiers pourraient par exemple apporter une réponse concrète à cet enjeu. Ces plateformes devraient être focalisées sur une ou plusieurs thématiques techniques horizontales (par exemple analyse de texte, vision par ordinateur, etc.) et proposer des interfaces documentées permettant une prise en main rapide des briques exposées. Via ces dispositifs, les intégrateurs pourraient avoir une plus grande visibilité sur les solutions françaises disponibles et les tester facilement pour évaluer leur intérêt dans les champs d’application des systèmes qu’ils développent.”.

Pour mémoire, les GAFA sont toutes des entreprises qui dominent le marché grand public ! On peut cependant ajouter le MI pour Microsoft et IBM qui sont plus présents dans le monde de l’entreprise.

L’oubli du hardware

Le plan IA recèle une grosse lacune sur ce qui pourrait être une force française : le hardware et les composants ! Aucune société du secteur ne semble avoir été intégrée dans les groupes de travail.

Or, c’est un domaine où il existe une opportunité autour de l’IA et avec au moins deux technologies clés :

- Les processeurs synaptiques intégrant des réseaux de neurones qui sont notamment utilisés dans la reconnaissance d’images. Il y a pourtant des équipes du CEA qui planchent sur le sujet, en liaison avec STMicroelectronics à Grenoble qui apporte notamment sa technologie FD-SOI permettant de créer des processeurs spécialisés à basse consommation. Des startups se sont aussi positionnées sur le créneau comme Scortex.

- Les processeurs quantiques généralistes qui pourraient transformer radicalement le paysage informatique autour de l’IA dans les deux décennies à venir. C’est probablement l’un des enjeux les plus critiques pour faire avancer l’IA et le deep learning. Les grands acteurs sont américains et canadiens (D-Wave). Des chercheurs travaillent pourtant sur le sujet en France et notamment, encore, au CEA.

Ces investissements dans les composants d’acteurs américains ne sont d’ailleurs pas évoqués dans la cartographie des stratégies des grands acteurs, qu’il s’agisse de Google avec ses Tensor Processing Units (des circuits ASIC implémentant des réseaux de neurones exploitables via les API du SDK TensorFlow) et Intel avec son acquisition de Nervana ou son investissement dans le français Chronocam. Et ne parlons pas de Nvidia qui est en train de se positionner comme le leader des processeurs embarqués dans les véhicules autonomes, notamment via ses accords récents avec les équipementiers allemands Bosch et ZF, ainsi que dans l’équipement de data centers en GPU servant au machine learning centralisé.

Dans ces deux domaines, l’excellence scientifique est pourtant un élément différentiateur clé. Surtout dans l’informatique quantique qui reste très complexe, si ce n’est mystérieuse. Elle a des implications énormes à tout point de vue… y compris au niveau de la souveraineté. Faut-il attendre 2030 pour que l’Etat lance un “ordinateur quantique souverain”, évidemment bien trop tard ?

Le manque d’ambition et d’approche par les besoins

Du fait de l’approche par comité, le travail de synthèse des rapports de ce plan relève d’une approche “bottom-up” qui part des détails. Elle mériterait d’être complétée par une vision “top-bottom” partant des besoins. Cela serait plus lisible, plus facile à communiquer, surtout au grand public. Et cela permettrait d’exprimer des ambitions claires.

Par exemple, en indiquant que la France pourrait être le premier pays à équiper une ville de taille moyenne en véhicules électriques autonomes. A charge d’assembler ensuite toutes les briques technologiques, économiques, d’infrastructures, sociétales et règlementaires pour y parvenir. Idem dans la santé : mettre en place une expérience de médecine prédictive basée sur l’IA et la génomique, en liaison avec le plan France Génomique 2025. Etc.

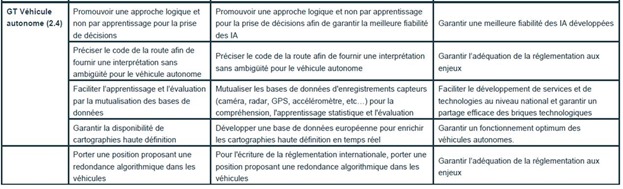

Les conclusions du groupe de travail sur l’automobile autonome sont sidérantes. Le rapport propose une vision bien trop technique et bas niveau du sujet. Il ne comprend pas d’analyse des grands enjeux technologiques et des acteurs. Il n’y est pas fait mention de Nvidia, Mobileye, Velodyne et autres acteurs clés de l’embarqué et encore moins des enjeux connexes de la 5G et du V2X. Il n’y a pas d’indications sur la manière de faire mieux que les autres. Y prédomine une approche scientifique es-abstracto faisant… abstraction de ce que font les autres et de l’état de l’art. La synthèse des propositions associées est édifiante :

L’une des cinq propositions consiste à préciser le code de la route ! On croit rêver ! Ca mérite de gros coups de pieds au cul ! Devenir leader industriel en changeant le code de la route, c’est vraiment de l’innovation de rupture !

Du côté des startups, le plan du groupe de travail “transfert de technologie” propose un plan de financement de 25 M€ pour 10 startups dans l’IA, issu du PIA3 (Programmes d’Investissements d’Avenir). En lisant entre les lignes, on comprend qu’il s’agit de financer une douzaine de startups à ce niveau là sur 10 ans, donc avec 300 M€. C’est pas mal mais dans la pratique, c’est petit joueur par rapport aux startups américaines du domaine qui sont les mieux financées (cf cette petite liste réalisée début 2016). Pour jouer gros, il faudrait d’emblée annoncer soit des partenariats et financements internationaux, soit d’établir des startups à cheval entre la France et les USA.

Ailleurs dans le plan, il est proposé “d’étudier la possibilité et l’intérêt de favoriser, via une défiscalisation, le rachat de startups de l’IA par les grands groupes français afin qu’ils s’approprient plus rapidement des technologies innovantes et pointues pour garder leur avantage compétitif”. Pourquoi donc faudrait-il une fiscalité spécifique ? Pour défiscaliser quoi précisément ? Et pourquoi donc seulement dans l’IA ? Et quels grands groupes français pourraient aider au développement de startups de l’IA ? Surtout sur des sujets horizontaux et de plate-formes ? Ceci est bien absurde quand dans le même temps, on se plaint de manière répétée qu’il n’y a pas assez de startups qui grandissent pour devenir des ETI !

Bref, le plan est à ce stade bien trop sage. C’est le reflet compréhensible du poids des chercheurs qui sont raisonnables dans leur approche. L’inventaire des travaux de recherche qu’ils font dans le rapport de synthèse sert d’ailleurs aussi à démythifier le côté magique de l’IA et les commentaires parfois surréalistes à son sujet dans les médias. Le rapport comprend aussi de sages réflexions sur les usages dans la santé, dans l’industrie, dans les métiers juridiques ou la relation client. Mais cela ne débouche pas sur des paris ambitieux qui permettent de servir d’aiguillon. Donc, ce plan ressemble à celui sur objets connectés de 2014 que je vous avais décortiqué ici en septembre 2016. On veut être leaders mais on ne définit pas la nature du leadership recherché ! On a eu la même chose sur le big data, le solaire photovoltaïque, le cloud et tant d’autres secteurs !

A côté de cela, nous avons Elon Musk qui enfume tout le monde avec sa startup Neurolink dont il se dit qu’elle connecterait directement le cerveau à l’IA. C’est un délire scientifique total, mais au moins, ça bouscule ! C’est un “moonshot”. Et le plan français ne comprend aucun moonshot.

Le manque d’international

Dans ce plan sur l’IA, il y a la France et le reste du monde. David contre Goliath. Mais pas de judo ni d’effet de levier particulier. En fait, les intervenants des groupes de travail n’ont fait qu’enquiller des idées tactiques les unes derrière les autres sans réfléchir un peu côté stratégie. Comment créer une industrie de l’IA ? Comment éviter de se faire déborder par les USA ? Sur quel domaine peut-on devenir excellents non pas simplement d’un point de vue scientifique, mais d’un point de vue industriel ?

Et surtout, avec qui pourrait-on s’allier ? Au niveau Européen ou au-delà ? Quels partenariats stratégiques imaginer pour nos grandes entreprises ou startups. Ce genre de réflexion plutôt confidentielle ne peut évidemment pas être détaillé dans ce type de rapport. Mais au moins peut-on en relever l’importance !

Pourquoi donc ?

Bref, avec ce plan, comme avec les précédents plans industriels, on ne risque pas d’aller bien loin. Je ne jetterai pas pour autant l’opprobre sur l’Etat et les deux Ministères impliqués. Les lacunes proviennent aussi bien de la puissance publique que des institutions et entreprises privées sollicitées dans la préparation du plan.

Pour avoir déjà participé à des groupes de travail de ce genre, cela n’est pas très étonnant. On rassemble jusqu’à plusieurs dizaines de personnes autour d’une grande table pendant 2 à 3 heures maximum. La moitié de la réunion est consacrée au tour de table pour se présenter. Chaque intervenant n’a que quelques minutes pour exposer quelques idées. Les débats sont très policés. Il y aura quelques sous-entendus, mais pas trop de parole plus haute qu’une autre. Qui plus est, les grandes entreprises sont rarement représentées par leurs dirigeants. La parole est contrainte. Des notes de réunions sont prises par des haut-fonctionnaires qui vont ensuite devoir polir tout cela dans un texte revu et corrigé par les administrations centrales et les cabinets ministériels. C’est une machine à broyer les différences et les idées originales. Elle n’a pas forcément été à l’oeuvre dans le cas présent mais c’est souvent le cas.

L’IA est aussi un domaine relativement nouveau dans l’écosystème de l’innovation. Les concepts de base sont encore mal compris par nombre d’entrepreneurs et de grandes entreprises. Faites un test sur la définition du machine learning et deep learning pour voir ! Les chercheurs maîtrisent mieux la dimension scientifique mais pas forcément la dimension entrepreneuriale ou la compréhension des phénomènes de migration de valeur. L’IA est comme le logiciel ou l’IOT (Internet of Things), un domaine technologique éminemment transversal. C’est à la fois un outil pour plein d’entités et potentiellement une industrie à part entière. Cela explique les difficultés à pondre un plan digne de ce nom.

Je vais utiliser une nouvelle fois le framework de plan stratégique, décrit pour la première fois en septembre dernier et testé sur le plan objets connectés de la nouvelle France Industrielle, et évaluer point par point son application dans le cas présent sur l’intelligence artificielle.

Le quoi :

- Il définit une forte ambition avec un leadership affiché, aligné sur un objectif difficile à atteindre et … qui n’est pas déjà atteint par d’autres pays.

Des ambitions sont affichées côté recherche, mais sans casser la baraque. Côté industrie, c’est encore plus timide. Aucun moonshot n’est mis en avant.

- L’objectif part d’un problème complexe à résoudre qui a un impact sur la société à l’échelle mondiale.

Le plan part des détails et pas des objectifs !

- Le plan élabore un logique de plate-forme et d’écosystème liés au secteur visé. Il identifie les éléments de commodité et les nœuds technologiques et de services à même de concentrer la valeur. Il ne le documente pas forcément explicitement, mais cette logique doit sous-tendre les choix stratégiques de positionnement du produit industriel à créer de la chaîne de valeur associée.

Et bien, pas du tout ! On confond l’écosystème d’innovation en général avec l’articulation des différents acteurs allant des chercheurs aux entreprises en passant par la formation, avec un écosystème industriel avec des produits clés qui deviennent des plateformes et des partenariats, si possible à l’échelle mondiale. Encore une fois, la présentation des objectifs sur les véhicules autonomes l’illustre très bien.

Le quand :

- Il prend en compte la notion de timing dans un monde qui bouge très vite et est loin de nous attendre. Il permet au projet d’être en avance sur l’état de l’art mondial, donc d’avancer rapidement. C’est certainement ambitieux mais tout aussi indispensable. Ce n’est pas un plan “de rattrapage”. Ces plans sont généralement dédiés aux usages internes au pays, comme dans l’équipement numérique des PME.

Aucune action du plan n’est timée ni n’a d’ailleurs de responsable. Or le timing sur ce genre de sujet est critique, notamment pour éviter que trop d’emplois soient supprimés par l’IA et pas remplacés assez rapidement par des emplois à forte valeur ajoutée, surtout si nos industries ne “produisent” pas assez d’IA. Un plan d’action sans timing ne peut pas être suivi… dans le temps ! Mais ce plan n’est pas le dernier du genre. Il faut plutôt le voir comme un rapport d’étape d’un projet au long cours.

Le qui :

- Le plan mobilise le secteur privé de manière précise et documentée sachant que cela peut et doit évidemment évoluer dans la durée. Il s’appuie sur des sociétés leaders capables d’entrainer d’autres acteurs avec elles, pas des sociétés en déclin.

Le plan évoque de nombreux acteurs privés, allant des startups aux grandes entreprises. On va dire que c’est OK, mais tout juste.

- Il est de préférence piloté par une forte tête non conformiste, qui n’est si possible pas juge et partie et qui a déjà une certaine légitimité dans le secteur industriel concernés.

Il y avait bien une forte tête dans le comité de pilotage, avec Cédric Villani. Mais il n’a pas pour autant d’expérience industrielle permettant d’apporter un regard critique de ce côté là. Il en allait de même d’Antoine Petit, le patron de l’INRIA.

- Il propose des stratégies d’alliance si c’est nécessaire pour atteindre rapidement la masse critique, si possible à l’échelle internationale et au minimum, européenne.

RAS sur le sujet dans le plan. La dimension internationale est pourtant évoquée côté pays et GAFAMI, mais sans que cela aboutisse à une approche industrielle internationale. Malgré tout, des spécialistes internationaux de l’IA ont été impliqués dans la préparation du rapport, au moins côté recherche.

Le comment :

- Il traite de la question du financement, lui aussi probablement international s’il s’agit de créer des leaders internationaux.

Le sujet est évoqué au niveau des startups avec ce financement de 300 M€ pour une douzaine de startups. C’est mieux que rien mais ne mènera pas forcément très loin, en tout cas comparativement aux nombreuses startups américaines de l’IA qui ne nous ont pas attendus !

- Il propose éventuellement la mise en place d’une grande infrastructure publique, qui peut couvrir la recherche scientifique ou un instrument industriel fortement mutualisé.

Un outil est proposé, côté machine learning. L’informatique quantique mériterait quelques efforts significatifs. Des ressources en cloud ? On a déjà Cloudwatt chez Orange et OVH. Même s’ils n’ont pas encore forcément de datacenters de machine learning.

- Il évoque les compétences à créer et fédérer et des moyens associés.

Ce sujet était plutôt bien traité dans la dimension recherche et enseignement supérieur. Nous avons une belle cartographie et quelques objectifs.

- Il met en branle tout l’appareil d’Etat transversal.

C’est à peu près OK.

- Il propose éventuellement des aménagements réglementaires pour favoriser l’adoption d’innovations.

C’est évoqué comme nous l’avons vu sur le code de la route et autour de la santé. Mais il y a probablement encore fort à faire en règle générale pour dynamiser les entreprises innovantes.

Voilà qui permet de mieux identifier les lacunes dans l’approche, lacunes qui ne sont probablement pas exhaustivement décrites ici. Et ces lacunes sont corrigeables !

On fera mieux la prochaine fois… dans ce long long long processus d’apprentissage ! Et l’innovation se planifie difficilement ni ne se décrète. C’est un processus itératif et parallélisé. Il n’en reste cependant pas moins qu’en matière d’IA, c’est une véritable course internationale qui est lancée. Il ne faut donc pas perdre trop de temps en tergiversations ! Ce plan France IA aura des suites. Donc, stay tuned !

Post Scriptum

Mi avril était publié par l’Office Parlementaire d’Evaluation des Choix Scientifiques et Technologiques ” du Sénat et de l’Assemblée Nationale le rapport “POUR UNE INTELLIGENCE ARTIFICIELLE MAÎTRISÉE, UTILE ET DÉMYSTIFIÉE“. Il est assorti d’une quinzaine de propositions.

Le rapport constitue une très bonne vulgarisation au début sur les grands concepts de l’IA. Les rapporteurs se focalisent ensuite surtout sur les aspects réglementaires (droit des robots, etc). Ils font une quinzaine de recommandations diverses dont la 2) : “Favoriser des algorithmes et des robots sûrs, transparents et justes et prévoir une charte de l’intelligence artificielle et de la robotique.”. On se demande quelle peut-être la signification du terme “favoriser” dans une telle phrase ! Certaines autres propositions sont redondantes avec celles du plan France IA comme celle qui recommande d’enseigner l’IA et la robotique dès la primaire.

Les rapporteurs ont en tout cas rencontré un nombre impressionnant de spécialistes en France et à l’étranger. Cela complète bien le plan France IA du gouvernement. Mais ce rapport fait 500 pages. Celui de France IA faisait 350 pages. Ça créé une belle barrière à l’entrée pour maîtriser le sujet !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Un état des lieux n’est pas une stratégie : https://t.co/UNcaTPwtj7 @olivez décortique le plan #franceia https://t.co/0MqZ49XgWE

Belle analyse critique Olivier, et bravo pour le framework de plan stratégique!

J’ai participé à une session de travail dans le cadre de la voiture connectée, et l’une des idées émergentes dans le cadre de UtopIA fut la suivante :

des navettes de transport autonomes, exploitées tout d’abord dans l’un des évènements phares JO 2024 ou Expo universelle 2025, qui permettent aussi la découverte touristique, en environnement “maitrisé”

puis réutilisées / upgradées en navettes de transport à la demande inclusives (pour personnes handicapées ou personnes âgées en pouvant plus conduire).

Un tel projet pourrait être un marqueur fort, entrainant un écosystème autour de sa réalisation, et avec de vraies collaborations start-ups, recherche, grands groupes.

C’est intéressant, mais ne reflète pas assez bien les enjeux du monde réel et des villes. Et l’expérience est déjà menée ailleurs. Il y a a d’ailleurs celle qui a été lancée sur les quais par la Ville de Paris avec Navya et la RATP. L’enjeu est de sortir justement des environnements maîtrisés.

Cela doit être aussi relié à une approche marketing. Le marché de la ville est plus grand que celui des environnements maîtrisés !

Bonjour Olivier,

Bravo pour cet article très approfondi.

Effectivement, il est très important d’engager, au début de toute démarche d’innovation, une réflexion portant sur le problème que l’on cherche à résoudre. Comme tu le dis, il n’est pas nécessaire de traiter des milliers de problèmes particuliers de différentes entreprises. Ce qu’il faut réussir à faire, c’est identifier quelques problèmes globaux, concernant un milliard d’individus, et voir comment l’IA peut traiter le problème en question.

Ce que je veux dire, c’est que la scalabilité du modèle économique d’une innovation commence dès l’identification du problème. Si on trouve un problème particulier, qui ne concerne qu’une seule entreprise, et qu’on développe une solution ou un service pour répondre à ce problème-là, on crée les conditions pour une crise de croissance de cette innovation à moyen terme. D’où la nécessité de trouver un problème global, concernant un nombre important d’individus ou un nombre important d’entreprises.

À très bientôt,

Guillaume

[#IA] Un critique au vitriol : “Les hauts et les bas du plan France Intelligence Artificielle”… https://t.co/8svDCMPaQq

Les hauts et les bas du plan France Intelligence Artificielle par @olivez Toujours pertinent cher Olivier

Excellente synthèse et analyse du plan France Intelligence Artificielle par @olivez • #IA #France • https://t.co/y6SivHmmh1

Encore du beau boulot de @olivez qui a lu les rapports “Les hauts & les bas du plan France Intelligence Artificielle”https://t.co/YvVMEm7y4g

Belle analyse pertinente réalisée par @olivez sur le plan France Intelligence Artificielle ! Un vrai plaisir à lire https://t.co/ZhA8ydySKY

Le Plan intelligence artificielle revu par @olivez, à lire. Sans surprise, ce Plan est un robinet d eau tiède… https://t.co/IZYbjPfp9X

Belle critique constructive #FranceIA @olivez La course internationale est lancée. Go go go ! https://t.co/Je695PTQoO

Un regard critique sur le plan #IA national #franceia https://t.co/SQmybQHN3I https://t.co/VHx6rghxTJ

Merci Olivier pour cette analyse extrémement détaillée. Une brève question: si je comprends bien (par l’absence du mot dans ton texte), rien sur l’Europe? Symptomatique et grave, non?

Des choses se préparent mais n’ont pas encore été annoncées en détail car pas encore finalisées.

Bonjour Olivier,

Article très intéressant !

Je rédige actuellement mon mémoire de fin d’année, en binôme avec une camarade, sur l’intelligence artificielle et le lien sur le modèle d’affaires des entreprises.

Serez-t-il possible d’échanger par mail afin que nous discussion un peu plus de ces sujets ?

L’adresse mail mise à disposition sur ton site n’est plus valide.

Merci de ton attention.

Laura. E

Très pertinent bien que severe : “Les hauts et les bas du plan France Intelligence Artificielle” de @olivez sur https://t.co/0hTrRT29Ts

Haha la “VivaTechnologisation de l’innovation” ça c’est très bon https://t.co/6wB9iQtENw

Les hauts et les bas du plan France Intelligence Artificielle : très bonne analyse détaillée par @olivez #IA https://t.co/agKekGPCFw

Si j’ai bien compris ce qui s’est passé au récent congrès international dédié à l’AI, c’est que les Chinois ont surpris tous les experts participants par l’avancée de leurs travaux. Ils comptent même devenir les leaders mondiaux en AI en 2020 !

Oui, les chinois communiquent beaucoup sur leurs avancées dans l’IA. Reste à savoir ce qu’ils entendent par devenir leaders mondiaux en 2020. Quelle est l’unité de mesure de ce leadership ?