Après un peu de sémantique, un tour des techniques de l’IA, l’étude de cas d’IBM Watson, un tour d’horizon des startups américaines de l’IA, puis de celles qui sont acquises par les grands groupes, les startups françaises du secteur, l’état de l’art de la connaissance du cerveau, puis les évolutions de la loi de Moore applicables à l’IA, prenons un peu de recul sur la robotisation en marche des métiers.

C’est la dernière partie de cette longue série, la moins technique… et la plus longue.

La littérature sur le futur de l’emploi

Elle est plus qu’abondante ! On y trouve aussi bien de sombres prophéties sur le rôle même de l’Homme dans l’économie que des prévisions plus optimistes, croyant fermement à la destruction-création de valeur schumpétérienne à équilibre positif.

L’une des conséquences des développements récents de l’intelligence artificielle se matérialise dans les multiples prédictions d’automatisation et de robotisation de métiers existants. Au point que les prévisions vont jusqu’à anticiper la disparition du tiers à plus de la moitié des emplois salariés en une vingtaine d’années seulement. En ligne de mire prioritaire : les conducteurs professionnels, remplacés par des véhicules à conduite automatique, les caissières, déjà en cours de remplacement par des automates qui ne font même pas appel à de l’IA, suivis de nombreux métiers de services, notamment dans les professions libérales ainsi que dans la santé.

Ces prédictions ne sont pas nouvelles. Certaines d’entre elles datent même des années 1960 ! Au démarrage des précédentes révolutions industrielles, les métiers disparus comme les nouveaux métiers ont rarement été bien anticipés. Pour ce qui est du futur, à vrai dire, on n’en sait pas grand chose. La principale leçon à retenir des prévisions du passé est de conserver un peu d’humilité ! On peut cependant faire quelques hypothèses. Elles sont notamment utiles pour mener certaines politiques publiques, dans l’éducation comme dans les choix de développement infrastructures et de politique industrielle.

Il faut aussi adopter une vue globale de la question. Certes, certains métiers seront de plus en plus automatisés ou rendus plus efficaces via l’automatisation. Dans le cas des médecins, l’automatisation ne réduira pas forcément l’emploi car le monde manque de médecins et notamment dans de nombreuses spécialités comme en ophtalmologie ou en diabétologie. Les cancérologues ne sont pas non plus remplacés par IBM Watson. Ce dernier leur permet d’affiner leur diagnostic, leur prescription, et des les rendre plus personnalisés. A beaucoup plus long terme, les technologies permettant la prolongation de la vie en bonne santé pourraient cependant réduire le besoin en nombre de médecins, surtout si les maladies dites de longue durée sont éradiquées, cancers, diabètes et maladies neurodégénératives en premier. Certains actes de chirurgie seront aussi de plus en plus réalisés par des robots. Des phénomènes de vases communicants peuvent intervenir. Telle disparition entraîne la création d’emploi dans des secteurs connexes voire entièrement différents des métiers disparus.

Ensuite, on se trompe souvent sur le terme et même la nature des chamboulements. Surestimés à court terme, sous-estimés à long terme, mais surtout mal appréhendés dans leur réalité technique. Ainsi, dans Les robots veulent déjà nous piquer notre job d’Emmanuel Ghesquier qui commente une étude d’un certain Moshe Vardi de l’Université Rice du Texas, il est indiqué que “On a pu voir avec les robots Pepper que certains robots pouvaient donner des conseils de gastronomie ou d’œnologie dans les supermarchés Carrefour ou qu’une boutique de téléphonie allait fonctionner à 100% avec des employés robotisés au Japon”. L’auteur qui relaie cela n’a pas du voir Pepper à l’œuvre car, au stade actuel de son développement, il est encore plus que brouillon ! J’avais même pu le constayer en 2014 dans une boutique Softbank dans le quartier Omotesando (photos) où ils commençaient à être déployés.

En y regardant de près, l’étude en question est un article publié dans The Conversation, Are robots taking our jobs. Il a bien du mal à faire le tri dans les évolutions de l’emploi aux USA entre ce qui provient de l’automatisation, de la globalisation et de la concurrence asiatique dans l’industrie manufacturière et même indienne, dans les emplois concernant les services informatiques. L’emploi a surtout migré géographiquement. Les emplois de perdus dans l’industrie aux USA et en Europe se sont retrouvés en Asie. C’est le “monde plat” de Thomas Friedman.

Une analyse sur l’impact de la robotisation sur les emplois devrait porter sur leur structure. Les métiers sont très divers et fragmentés. Rien que dans la santé, on trouve des dizaines de types d’emplois et spécialités différentes. Il en va de même dans les services. Les startups s’attaquent en général en priorité à des cibles à la fois faciles et volumineuses, là où l’on peut générer une croissance exponentielle et de belles économies d’échelle au niveau mondial. Les kinésithérapeutes seront-ils remplacés par des robots bipèdes ? Probablement moins rapidement que les conducteurs de camions car ils sont moins nombreux, donc ne présentant pas les mêmes économies d’échelle potentielles ! Et l’automatisation du travail d’un kiné est plus complexe que celle d’un conducteur de camion. L’innovation a ceci de particulier qu’elle permet aussi la création de métiers nouveaux, qu’elle recompose le paysage économique entier et celui des métiers.

En tout cas, il ne sera pas nécessaire d’atteindre un quelconque point de singularité où l’intelligence de la machine dépasserait l’homme pour que les tsunamis de l’emploi se produisent. Ils peuvent intervenir bien avant ! Et pour cause : bien des métiers d’exécution relèvent de tâches très répétitives qui sont sujettes à l’augmentation de l’automatisation dans un premier temps, sans passer par la case de l’AGI, l’intelligence artificielle générale, celle qui remplacerait totalement l’intelligence humaine, puis la dépasserait rapidement par la force démultiplicatrice des machines.

Les études de cas mises en avant dans les ouvrages sur le futur de l’emploi collent souvent à l’actualité marketing du secteur de l’IA. Les livres parus après 2011 commencent presque tous par évoquer la victoire d’IBM Watson dans Jeopardy. A partir de 2013, ils passent aux prescriptions en cancérologie, l’une des applications commerciales de Watson. Depuis environ 2011, nous avons droit aux Google Car et autres avancées dans la conduite automatique. Récemment, les agents conversationnels (chatbots) sont revenus au gout du jour, du fait de divers lancements comme chez Facebook.

En quelques années, les études de cas brandies en trophées peuvent perdre de leur substance. Il a été fait beaucoup de cas de la décision du Taïwanais Foxconn en 2011 de déployer un million de robots pour remplacer leurs travailleurs de ses usines en Chine qui demandaient des augmentations de salaire ou se suicidaient. Quatre ans plus tard, seulement 50000 robots avaient été déployés, ce qui ne présage rien de leur capacité à réaliser l’objectif annoncé mais illustre la difficulté à robotiser certains métiers, même répétitifs.

Dans cette abondante littérature sur le futur de l’emploi, les fondements scientifiques et technologiques des prédictions sont rarement analysés. S’y mêlent allègrement la science-fiction, la science et la fiction. Nous avons vu dans l’épisode précédent que la pérennité ou tout du moins la stabilité de la loi de Moore étaient loin d’être évidentes. Les prévisions sont souvent vaguement plausibles mais très vagues côté timing !

Dans le top de l’exagération technique, nous avons par exemple Tomorrowland de Steven Kotler (2015), qui prédit monts et merveilles singularistes allant de l’intelligence artificielle générale (AGI) autoréplicable jusqu’au téléchargement des cerveaux dans un ordinateur : “Yet it is worth noting that Moore’s Law states that computers double in power every twelve months […]. Biotechnology, meanwhile, the field where mind uploading most squarely sits, is currently progressing at five times the speed of Moore’s Law. […] people alive today will live long enough to see their selves stored in silicon and thus, by extension, see themselves live forever.”. Nous avons donc une loi de Moore deux fois plus rapide dans les processeurs que dans la vraie vie (12 vs 24 mois) et des “biotechnologies” qui évoluent cinq fois plus rapidement que la loi de Moore, alors que cette vitesse ne concerne que le cas particulier de l’évolution du coût du séquençage de l’ADN, observée sur la période courte 2007-2011. Evolution qui s’est bien calmée les 5 années suivantes !

Ces livres oublient un autre phénomène induit par le numérique : le transfert du travail non pas seulement vers les machines mais aussi vers les clients, que l’on observe avec les distributeurs automatiques et caisses automatiques, le e-commerce, la SDA (sélection directe à l’arrivée) des centres d’appels, les banques en ligne et les assurances. Comme la valeur économique du temps des gens à faible revenu est faible, elle est absorbée en échange de services en théorie plus rapides. C’est un principe également courant dans l’économie collaborative, qu’elle concerne les professionnels (cas de Uber, version VTC) ou les particuliers (Blablacar, Aibnb).

Du côté de la vision macro-économique, la majorité de ces ouvrages ont une fâcheuse tendance à se focaliser sur la situation aux USA et à ne pas adopter une approche mondiale du problème. Ils n’évoquent pas non plus des fonctionnaires qui sont souvent les derniers a être robotisés car protégés par la lenteur de l’innovation dans les administrations et le manque de courage politique.

Ces livres font aussi peu de cas de prédictions sur le devenir du système financier. Ils indiquent qu’il est à l’origine de la concentration de la richesse sur les plus fortunés, qu’il détourne la valeur ajoutée des salaires vers le capital, et qu’il pousse à l’automatisation, faisant courir l’économie à sa perte. Et pourtant, le système financier est basé sur un point clé, bien mis en avant par Yuval Harari dans l’excellent “Sapiens” qui relate de manière très synthétique les dynamiques de l’histoire de l’humanité : le système financier, surtout celui des prêts, repose sur la confiance dans le futur. Cette confiance est la clé de voûte du capitalisme et du système financier. Or cette confiance est en train de s’effondrer pour tout un tas de raisons (emploi, dette, environnement, …). Cela se retrouve dans les faibles taux d’intérêts actuellement pratiqués. Si la robotisation met à genoux le système financier et l’économie derrière, des freins naturels se mettront peut-être en place. Ou pas, car le pire est toujours probable !

Autre manque de prédiction : l’impact des progrès issus de l’IA sur la démographie ! Si la durée de vie s’allonge et le confort s’améliore, la démographie pourrait voir sa croissance ralentir, comme c’est le cas au Japon isolationniste depuis quelques décennies. Dans la réalité, elle restera inégale. Les technologies issues de l’IA ne se déploient pas à la même vitesse selon les continents et rien ne dit qu’elles éradiqueront les inégalités sur l’ensemble de la planète, surtout si le moteur de leur déploiement est hautement capitalistique.

Les ouvrages n’intègrent pas non plus dans leurs scénarios l’épineuse question de la production d’énergie qui est incontournable pour tout développement économique, y compris dans le numérique. L’énergie ? Elle est là, c’est le soleil ! Le seul véritable problème est d’apprendre à la dompter et à la stocker.

Les matières premières ? On en trouvera en fonction des besoins. Ces derniers font évoluer les techniques de recherche et on trouve de tout, y compris dans le domaine des terres rares.

Et la question environnementale qui nous rattrape à grandes enjambées ? Le passage au solaire réglera naturellement une bonne partie du problème sur le long terme !

Les optimistes de l’innovation estiment que, grâce à l’IA, l’Homme sera capable de résoudre tous ces problèmes, presque d’un coup de baguette magique. En exagérant un peu, l’IA est devenue en quelque sorte la solution de sous-traitance ultime des sociétés procrastinatrices et des fainéants : ne nous attaquons pas aux problèmes qui fâchent et attendons que l’IA et la robotique fassent le boulot à notre place ! C’en est presque un éloge du laisser-aller.

Deux ouvrages intéressants traitent assez bien de ces questions : The beginning of infinity de David Deutsch, qui défend un point de vue selon lequel l’infini et l’innovation sont intimement liés et qu’il ne faut pas de mettre des barrières à notre capacité d’innovation. Et puis The infinite resource de Ramez Naam qui fait un bilan circonstancié des défis qui se présentent pour gérer les ressources en apparence limitées de la planète côté énergie, agriculture et matières première. Il équilibre bien ces difficultés et les progrès techniques à venir qui permettront de les contourner.

Revue de lectures

Aller, c’est parti pour une petite revue éditoriale sur la robotisation des métiers et le futur des emplois !

Rise of the robots and the threat of a jobless future (2016) de Martin Ford est l’ouvrage le mieux documenté de cette série. Il évoque un bon nombre des mécanismes macro-économiques des précédentes révolutions et crises industrielles, et de ce qui pourrait advenir dans le futur.

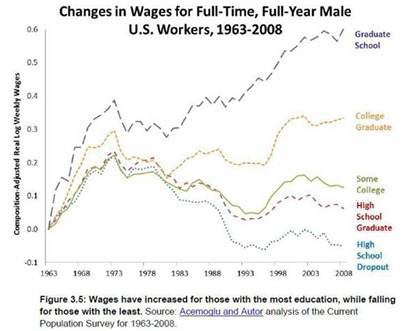

Sa thèse principale est que les révolutions numériques passées et à venir contribuent à réduire l’emploi dans les classes moyennes et à favoriser d’un côté l’émergence d’emplois de bas niveaux mal payés et de l’autre d’emplois de haut niveau bien payés. C’était déjà anticipé dans le rapport Triple Revolution produit en 1964 pour l’administration de Lyndon B. Johnson, le successeur de JFK. Ses auteurs s’alarmaient déjà sur risques les risques de l’automatisation, mettant en avant la difficulté de remplacer les emplois supprimés par la modernisation à un rythme suffisamment rapide. Il était très en avance sur son temps, alors que l’informatique n’en était encore qu’à ses balbutiements. Juste avant la sortie du mythique mainframe IBM 360, en 1965, c’est dire !

Aux USA, les 5% des foyers les plus aisées représentaient 27% de la consommation en 1992 et 38% en 2012. Les 80% les moins aisés sont passés de 47% à 39% dans le même temps. Après la crise de 2008, le top 5% avait augmenté ses dépenses de 17% et le reste n’avait fait que rester au niveau de 2008. D’ou l’émergence de business comme Tesla qui cible, pour l’instant, surtout les 5% les plus riches. Les nouvelles entreprises issues du numérique sont automatisées dès le départ et ont moins de salariés. Elles profitent à plein de la productivité issue du numérique. Les exemples un peu éculés et trop généralisant de Whatsapp et Instagram sont mis en avant pour illustrer le point. On nous bassine un peu trop avec les $16B de “valeur” de Whatsapp générés par 55 employés, alors que lorsqu’elle a été acquise par Facebook, cette société n’avait quasiment pas de revenus.

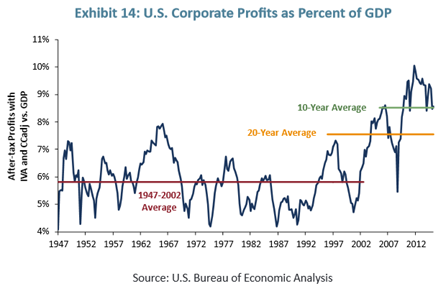

Contrairement à l’après-guerre, les gains de productivité des deux dernières décennies sont allés non pas dans l’augmentation des salaires mais dans la baisse des prix, dans les salaires de métiers techniques qualifiés, et le capital s’orientant vers le financement des nouveaux investissements technologiques. Les technologies sont devenues un facteur d’inégalité au profit des technologues et des détenteurs de capital, tout du moins aux USA. La “finance” réalloue aussi les profits au bénéfice des plus riches. Plus un pays a un système financier développé, plus grandes seraient les inégalités.

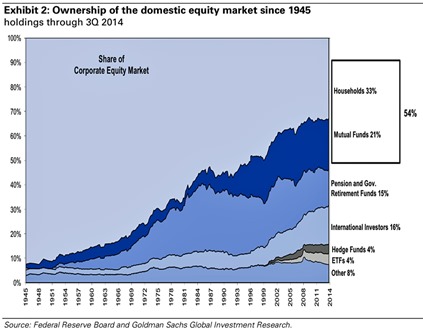

Les profits des grandes entreprises ont augmenté sur 15 ans en proportion du PIB comme indiqué dans le schéma ci-dessus, qui correspond aux données US. Cette réallocation concerne 2,5% du PIB. Je me suis demandé où allaient ces profits (source du schéma ci-dessous). Un tiers alimente les fonds de pension. Un autre tiers va dans les foyers, et probablement avec des inégalités fortes de revenu. Le reste va pour moitié chez des investisseurs internationaux, certains, aussi pour alimenter des fonds de retraite. Les méchants fonds spéculatifs (hedge funds) ne représentent que 4% de l’actionnariat des entreprises américaines !

Et si l’explication était donc toute simple : plus la population vieillit, plus les systèmes de retraites par capitalisation ont besoin de financement, donc de profits des grandes entreprises !

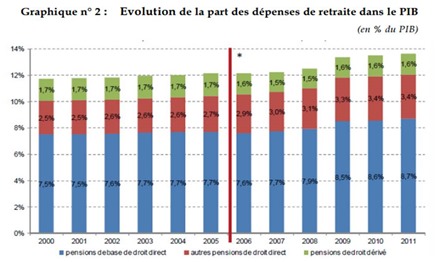

En France, le régime général des retraites a vu son poids dans le PIB évoluer de 11,2% en 1990 à 13,8% en 2008, soient 2,6% de progression. Coïncidence ? Ne serait-ce pas finalement une solution différente au même problème ? A savoir, augmenter les charges sociales et taxes pour financer une retraite par répartition en lieu et place d’une augmentation du profit des grandes entreprises qui rémunèrent un système de retraite par capitalisation ? C’est probablement à moitié vrai et à moitié faux car les profits des grandes entreprises françaises ont aussi augmenté dans la même période. Mais comme les actions du CAC40 sont détenues par des investisseurs étrangers, il se trouve qu’ils alimentent aussi les systèmes de retraite de pays étrangers, notamment anglo-saxons qui en sont friands !

Le paradoxe est que la pénurie de compétences qualifiées ralentit ce phénomène de concentration de la valeur sur les plus riches ! Si on y pourvoyait plus rapidement, cela détruirait encore plus de jobs mal payés, et bien plus que de jobs bien payés de créés. La limitation des visas de travail type H1B1 pour les cadres qualifiés étrangers imposée par le congrès US créerait une inertie souhaitable pour protéger les emplois non qualifiés. En même temps, elle favorise l’offshore de métiers qualifiés en plus des métiers faiblement qualifiés qui sont déjà externalisés à l’étranger.

Autre point intéressant, l’auteur fait état des écueils des MOOCs, présentés comme la solution miracle pour l’enseignement. Deux études menées par l’Université de Pennsylvanie en 2013 et qu’il ne faudrait pas forcément généraliser montrent que les résultats d’étudiants ayant suivi des MOOCs étaient moins bons que ceux d’étudiants passant par des méthodes traditionnels. Il ne faut certainement pas jeter le bébé du MOOC avec l’eau du bain de ces études. Les méthodes mixant MOOCs et enseignement IRL (in real life) sont probablement à favoriser.

Le livre fait aussi état d’opinions divergentes sur l’avenir de l’IA. L’expert en sciences cognitives Gary Marcus trouve que les performances récentes de l’IA sont survendues. Pour Noam Chomsky, qui s’est penché sur les sciences cognitives pendant 60 ans, on est encore à des millénaires de la création de machines intelligentes comme l’homme et que la singularité reste du domaine de la science fiction. Même opinion pour le psychologue cognitiviste Steven Pinker, le biologiste P. Z. Myers et même pour Gordon Moore. Il évoque aussi l’histoire de la National Nanotechnology Initiative lancée en 2000, qui survendait l’idée de créer des nano-machines au niveau des atomes et s’est ensuite rabattue sur des objectifs plus raisonnables.

Martin Ford évoque l’intérêt du revenu minimum qui est souvent présenté comme la solution pour traiter le problème de la disparition trop rapide d’emplois liés à la robotisation. C’est une sorte d’Etat providence générique poussé à l’extrême quand il n’est plus en mesure de créer les conditions d’une activité pour tous. Ces débats émergent avant même que la richesse permettant de le financer ne soit créée et que de nouveaux métiers soient automatisés. La Finlande est parfois mise en avant comme validant le principe alors que le revenu minimum n’y a été ni voté, ni encore appliqué à fortiori !

Les questions clés sont nombreuses. Quel est le niveau de ce revenu minimum ? Est-il là juste pour simplifier les systèmes existants de redistribution ? Comment est-il financé s’il est plus élevé ? Comment est-il différentié en fonction de la situation des foyers ? Comment évite-t-il de décourager les gens de travailler là où cela reste nécessaire ? Quel serait son impact si mis en place dans des pays et pas dans d’autres ? Quel impact sur les flux migratoires qui créent déjà une pression certaine ? Il existera toujours des inégalités marquées entre pays, en plus de celles qui existent entre milieux sociaux. Ce débat a démarré il y a plus de 11 millénaires avec les débuts de l’agriculture. Il s’est poursuivi avec toutes les autres révolutions technologiques et industrielles suivantes et n’est pas prêt de se terminer.

Dans Race against the machine (2012) et The Second Machines Age” (2014), Erik Brynjolfsson et Andrew Mcafee font les mêmes constats que le livre précédent sur la concentration de la richesse sur les 5% les plus aisés.

Ils rappellent qui, si l’on considère aujourd’hui encore que les anciennes révolutions industrielles ont créé tant d’emplois, c’est parce que l’on a enlevé de l’équation les chevaux et autres bêtes de somme qui ont perdu leur utilité et ont disparu au passage, ou bien, ont été transformés en chair à steaks. Ils étaient ce que sont aujourd’hui les travailleurs à bas salaire dont l’activité est en voie d’être automatisée, modulo les steaks. Le bilan écologique est aussi bien connu : c’est la terre qui a payé le prix de la croissance humaine !

Ils décrivent le scénario de l’offshore qui pourrait menacer l’emploi dans les pays à faible cout de main d’œuvre : les métiers délocalisés étaient les plus codifiables et donc, automatisables en priorité lorsque la technologie le permettra. Cela protège pour une part les pays occidentaux. A ceci près que les métiers codifiables non délocalisables pour des raisons physiques sont aussi automatisables. A contrario, le développement des robots réduit l’intérêt des délocalisations dans l’industrie. Il permet en théorie une relocalisation des usines, et la création d’emplois locaux de production, d’installation et de maintenance de robots ainsi que dans la supply chain.

Le scénario des auteurs met en avant les mêmes gagnants et perdants : les personnes à haut niveau de qualification vs les personnes faiblement qualifiées, les entreprises superstars à croissance exponentielle et les autres, et enfin le capital contre le travail. Il s’appuie sur le fait que, ces dernières décennies, les salaires ont déjà augmenté pour les personnes les plus qualifiées et baissé pour les moins qualifiées.

On pourrait ajouter à cette analyse la possibilité d’un ajustement de la population mondiale en fonction des glissements de valeur provoqués par la robotisation. Quelle serait l’influence de la robotisation sur la natalité ? Et surtout de la prolongation de la durée de la vie, sans même parler de vie éternelle. Plus la longévité augmente, comme au Japon, plus la natalité baisse. A court et moyen terme, cela résout le problème de l’emploi par le vide. Mais une société vieillissante peut enclencher son déclin inexorable. L’impact d’un éventuel revenu de base ne serait pas neutre. Avec lui, la démographie n’irait plus naturellement à la baisse.

Les deux auteurs, qui sont de la MIT Sloan School of Management, proposent un plan d’action en quatre points qui s’inspire en partie des propositions du rapport Triple Revolution de 1964 :

- Investir dans l’éducation, en payant mieux les enseignants, en les rendant responsables, et attirer aux USA les immigrants qualifiés. Côté cursus, ils recommandent d’investir dans la créativité, dans l’identification de tendances et dans la communication complexe. Ils font remarquer que l’homme plus la machine sont plus puissants qu’une machine seule. Donc, associer la créativité et la maitrise de l’usage des technologies reste une belle protection. Ils considèrent que tous les métiers qui requièrent à la fois de la créativité et une forte sensibilité motrice ne sont pas prêts d’être automatisés (cuisiniers, jardiniers, réparateurs, dentistes). Les auteurs font aussi preuve de bon sens en rappelant que notre imagination est limitée pour prédire les emplois du futur. On n’anticipe pas assez la nature des problèmes existants et à venir qui vont générer leurs propres métiers.

- Développer l’entrepreneuriat : l’enseigner comme une compétence dans l’ensemble de l’enseignement et pas seulement dans les meilleures business schools, réduire les règlementations qui ralentissent la création d’entreprise, et créer un visa pour les entrepreneurs. Ce visa s’est retrouvé dans l’initiative “Startup Visa Act” lancée en 2011 par l’administration Obama mais qui n’est toujours pas validée par le Congrès US. Ils recommandent aussi d’encourager les innovations d’organisation et du travail collaboratif pour exploiter ce qu’il reste d’utilisable du temps et des compétences des gens inoccupés.

- Développer l’investissement dans l’innovation, la recherche et les infrastructures, notamment dans les télécommunications. Un grand classique des pays modernes comme des pays émergents.

- Côté lois et fiscalité, ne pas alourdir la législation du travail. Rendre les embauches plus attractives que la robotisation des métiers au niveau des charges sociales et taxes, ce qui rappelle une bonne partie de la politique de l’emploi en France, qui ne nous réussit pas si bien. Ne pas réguler les nouvelles activités. Réduire les subventions aux emprunts immobiliers et les réallouer à l’éducation et à la recherche. La propriété immobilière a tendance à réduire la mobilité géographique. Réduire les subventions directes et indirectes aux services financiers. Réformer le système des brevets et réduire la durée d’application du copyright. Enfin, ils ne recommandent pas de créer une allocation universelle mais plutôt un crédit d’impôt pour les bas revenus (negative income tax) dans la lignée d’une proposition de Thomas Paine qui date de 1797 au Royaume-Uni. Pourquoi valoriser le travail ? Parce que, quelle que soit sa nature, en plus de pourvoir à nos besoins, le travail traite deux nuisances : l’ennui et le vice (Voltaire), sans compter les couches hautes de la pyramide des motivations de Maslow.

C’en est presque un plan “à la Macron” : favorisons l’entrepreneuriat et tous les problèmes sociétaux se régleront d’eux-mêmes. Un peu trop classique !

The Second Intelligent Species: How Humans Will Become as Irrelevant as Cockroaches (2015), de Marshall Brain, grossit le trait en annonçant que les scientifiques sont en train de créer une seconde espèce intelligente, les robots et l’IA, qui va nous dépasser et supprimer la majorité des emplois. Les premiers touchés seront les millions de camionneurs, les vendeurs dans la distribution de détail, dans les fast foods et le BTP. C’est un darwinisme technologique provoqué par l’Homme, qui se fait dépasser par ses propres créations.

Le reste est de la non-science-fiction, tablant sur une intelligence artificielle qui régulerait les comportements humains néfastes, comme ceux qui affectent l’environnement. Les emplois non qualifiés disparaitraient à la fin des années 2030, ce qui semble un peu rapide au vu de la progression de la robotique.

Au passage, l’auteur fournit une explication du fameux paradoxe de Fermi selon lequel il est bizarre qu’aucune civilisation extraterrestre ne nous ait approchés à ce jour. “Officiellement”, diraient les conspirationnistes. L’IA développée par ces civilisations serait comme la nôtre : une fois qu’elle serait satisfaite par ses réalisations et par l’équilibre ainsi généré, elle n’aurait pas besoin d’explorer le reste de l’univers. Faut voir…

Jobocalypse (2013) de Ben Way, que je n’ai pas lu (désolé…), part du principe que nous sommes déjà envahis par les robots et que la disparition d’emplois liée à l’automatisation est une histoire ancienne. Il anticipe que même les métiers les plus qualifiés seront remplacés par des robots car ils s’autoalimenteront. Les scénarios envisagés vont de révolutions provoquées par les sans-emplois à des initiatives gouvernementales de formation massive les concernant. On dira que l’on préférera le second scénario au premier même si c’est un peu court !

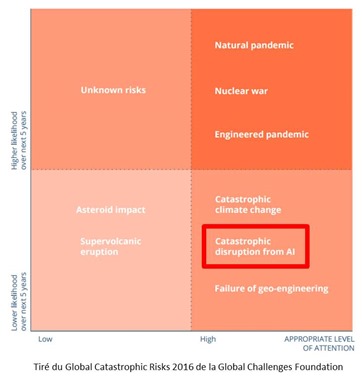

Quand au Rapport Global Catastrophic Risks 2016 de la Global Challenges Foundation, il intègre l’IA dans les risques systémiques que l’humanité et la planète pourraient rencontrer, au même niveau que les conséquences du réchauffement climatique et les pandémies naturelles ou artificielles. Les risques évoqués ne concernent cependant pas les conséquences sur l’emploi mais plutôt la perte de contrôle de l’IA par l’Homme.

L’étude AI, Robotics and the future of jobs du Pew Research Center, parue en 2014, recense de son côté l’avis de divers spécialistes dont certains estiment que la moitié des emplois sont menacés à l’horizon 2025. Ces experts sont très divisés sur la question !

Le pessimisme provient du risque d’impact rapide de l’automatisation sur les cols blancs avec un risque de déclassification pour un grand nombre, qui seront orientés vers des métiers moins bien payés. Enfin, le système d’éducation ne serait pas en mesure de s’adapter aux nouveaux enjeux.

Certains experts sont optimistes car les métiers qui disparaissent sont naturellement remplacés par d’autres, au gré de l’évolution de la demande. La relation avec le travail sera aussi redéfinie de manière plus positive.

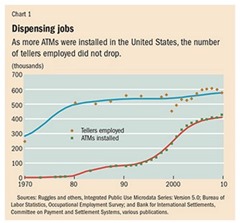

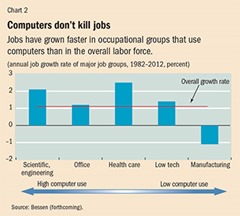

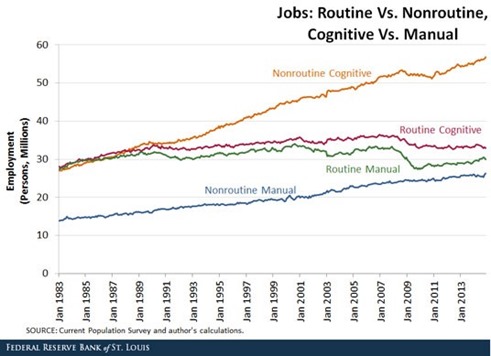

C’est aussi l’avis de Darrell M. West de la Brookings Institution dans What happens if robots take the jobs qui prévoit des créations de jobs dans plein de secteurs et des disparitions dans peu de secteurs. On retrouve cette thèse dans Toil and Technology – Innovative technology is displacing workers to new jobs rather than replacing them entirely (2015) de James Bessen, d’où sont extraits les schémas ci-dessous qui montreraient que les ordinateurs ne sont pas à l’origine de la suppression d’emplois.

Enfin, Humans Are Underrated: What high achievers know that brilliant machines never will (2015) de Geoff Colvin met en avant de son côté l’opportunité de remettre au gout du jour les qualités humaines dans les métiers : l’empathie, l’intuition, la créativité, l’humour, la sensibilité et les relations sociales. Une manière de différentier clairement les machines et l’homme. Elle était reprise par Dov Seidman dans Harvard Business Review en 2014 (ci-dessous). C’est une belle conclusion, même si frisant quelque peu l’utopie.

Les incertitudes sur la vitesse de la robotisation

Il y aura bien de l’automatisation et des pertes d’emploi, mais probablement moins que ne l’annoncent les prévisions les plus alarmistes. Les cycles d’innovation sont lents. Les prévisions oublient souvent d’intégrer la dimension économique et sociale.

Pour qu’un métier soit automatisé, même partiellement, il vaut mieux que cela soit intéressant économiquement, et pas seulement pour la performance technologique. Dans certains cas, l’automatisation de métiers pourrait élargir leur marché en les rendant accessibles au plus grand nombre, comme pour les avocats ou de nombreux pans de la santé. Dans d’autres comme pour les traders, l’impact sur l’emploi sera minime et on ne regrettera pas forcément ceux qui occupaient ces métiers.

(source du schéma ci-dessus qui montre une évolution à la hausse des métiers cognitifs et non routiniers, donc plus difficiles à automatiser)

L’automatisation à venir est incertaine dans son ampleur, dans sa rapidité, dans les métiers qui seront affectés et dans ses effets induits. Elle produit généralement des transferts de valeur. La France a perdu en un demi-siècle le tiers de ses emplois ! Entre 1946 et la fin du 20eme siècle, l’emploi agricole est passé de 36% à moins de 3% de la population ! Une part de cette transformation a eu lieu pendant les Trente Glorieuses (1945-1975), générant de la croissance dans de nombreux secteurs : l’automobile, le BTP, les biens de consommation courante, le commerce, les loisirs, les médias et la publicité. Les automatisations à venir ne pourront pas être amorties de la même manière. La “destruction créative” de valeur pourrait avoir du retard à l’allumage. Mais elle libèrera probablement de la créativité dans d’autres domaines, notamment dans les loisirs.

L’automatisation pourrait être plus lente que prévue, notamment dans les métiers les plus difficiles à automatiser. L’ouvrier de chantier n’est pas facile à robotiser de manière générique. Surtout pour les petites chantiers. Mais certains le seront, par exemple via l’impression de béton en 3D qui permet dans certaines conditions de faire l’économie des coffrages.

Autre point majeur, comment la robotisation interagira avec le réchauffement climatique et ses dégâts ? Est-ce que l’automatisation sera neutre ou positive pour l’environnement ? Sera-t-elle à l’origine de la transformation énergétique nécessaire pour stopper voire inverser le réchauffement climatique ? C’est une question stratégique car le réchauffement climatique pourrait détruire la civilisation actuelle et l’IA comme la singularité pourraient ne rien y faire. L’un des éléments les plus inquiétants est l’impact du réchauffement sur le plancton dans les mers, qui à terme, ne produirait plus une bonne part de l’oxygène nécessaire dans l’atmosphère ! Moins d’oxygène, moins de vie, en tout cas aérobie !

Comment éviter de se faire robotiser

Maintenant que le problème est posé, comment ne pas être remplacé par de robots et de l’intelligence artificielle ? Après l’uberisation qui intermédie les métiers de service, la robotisation peut-elle automatiser ces mêmes métiers ? La robotisation serait-elle l’ubérisation ultime ?

Quelques pistes sont bien connues et déjà cités dans les livres évoqués ci-dessus : choisir des métiers où la créativité, l’initiative, les émotions, l’empathie et l’humanité sont importantes et adopter les nouvelles technologies qui rendent plus productif.

C’est une constante dans l’innovation : dans presque tous les métiers, l’automatisation et la robotisation ne sont jamais totales. Elle nécessite une supervision humaine. Il faut donc s’approprier les outils de cette supervision, voire les créer soi-même ! Donc, de préférence, maitriser à la fois des métiers traditionnels et les technologies numériques qui peuvent les transformer. Malheureusement, les sciences et technologies n’attirent pas tant que cela les jeunes et notamment en France, comme une enquête mondiale récemment réalisée par Randstad le montre.

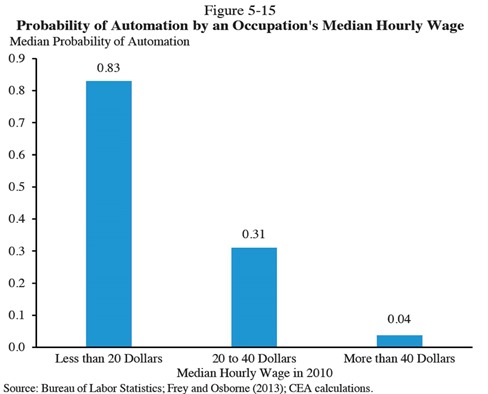

A contrario, il faudra de préférence éviter les métiers répétitifs, routiniers ou à faible degré de créativité et d’initiative et simples d’un point de vue moteur. Ce sont ceux qui présenteraient le plus grand risque d’automatisation. Le schéma ci-dessus issu du Rapport Economique du Président US 2016, déjà cité dans un article précédent rappelle que les métiers à bas salaire, donc en général à faible qualification, sont les plus menacés par l’automatisation.

Dans The Future of Jobs Employment, Skills and Workforce Strategy for the Fourth Industrial Revolution publié en janvier 2016 par le World Economic Forum, les auteurs prévoient que les deux tiers des enfants en école primaire d’aujourd’hui exerceront un métier qui n’existe pas encore. Ils y vont un peu fort car l’échéance n’est pas si lointaine. Ils prévoient que 7,1 millions d’emplois administratifs disparaitront d’ici 2020, et que seulement 2 millions d’emplois seront créés dans les technologies (aux USA). Par contre, des emplois devraient être créés pour combler une partie du trou dans l’énergie, les nano-biologies et le divertissement, et ceux des commerciaux subsisteront. Et oui, les emplois de l’avenir seraient surtout ceux dont le contenu émotionnel sera le plus dense, comme expliqué dans Les 10 compétences clés du monde de demain.

D’un point de vue stratégique, on peut intuitivement privilégier l’enseignement supérieur, la recherche et l’entrepreneuriat dans les domaines scientifiques et technologiques qui génèrent ces automatisations. Il vaut mieux créer ou adopter les outils de l’automatisation que de n’en subir que les effets, comme décrit dans How To Avoid Being Replaced By A Robot paru dans Fast Company en avril 2016.

On pourra aussi favoriser les enseignements pas trop spécialisés et assez diversifiés. Et enfin, ne pas oublier d’exceller dans ce qui fait de nous des Hommes, de belles machines biologiques douées d’émotions.

Et les politiques ?

Un sujet est rarement évoqué dans les ouvrages sur le futur des métiers en relation avec l’IA : quid des organisations politiques et des Etats ? Peuvent-ils se faire eux-mêmes disrupter par de l’IA ? Evitons l’expression “uberiser” qui est à la fois trop précise et trop vague. Il y a bien l’initiative Watson for President mais elle est un peu légère car construite comme une opération de communication d’IBM.

On ne peut qu’aller en conjectures. La première question à se poser sur l’usage de l’IA concerne les élections dans les démocraties. Les dernières grandes élections, notamment américaines, ont montré la force à la fois des réseaux sociaux et de la propagation d’idées véhiculant ou bien du rêve (Obama, Sanders) ou des angoisses (Trump), voir les deux à la fois (H. Clinton). Derrière les deux victoires de Barack Obama se cachent beaucoup de big data et de marketing opérationnel ciblés sur les bonnes audiences.

Que ferait l’IA pour améliorer un tel processus ? Elle collecterait des volumes gigantesques d’informations ouvertes sur ce qui se dit et s’écrit, sur ce que font les électeurs, sur leurs réactions à des discours antérieurs, sur les analyses biométriques (de la captation de pouls avec une montre, des mouvements oculaires avec des capteurs de Tobii, de l’EEG pour la mesure de l’activité cérébrale, etc), sur l’économie ou sur les médias.

Elle les analyserait alors au point de permettre la création de programme politiques appliquant soit la démagogie ultime (celle qui fait gagner les élections mais qui est inapplicable ou qui, si appliquée, mène à une catastrophe) soit la démagogie utile (celle qui fait à la fois gagner les élections et aller dans un chemin non catastrophique et responsable). Le tout en étant conforme à une idéologie de base d’un parti politique donné, avec son système de valeur (partage, social, économie, croissance, environnement, fiscalité, justice, école, selon les cas). Voilà de beaux défis d’optimisation sous contraintes !

Des tentatives de ce genre ont déjà été vaguement lancées. Valentin Kassarnig, chercheur à l’Université Amherst du Massachusetts, a présenté début 2016 un premier générateur de discours politique basé sur de l’IA, et qui dépasse les générateurs de pipeau déjà bien connus. Mais cela reste assez rustique et focalisé sur le langage, pas sur la construction d’un programme politique qui se tienne. La solution est même diffusée en open source ! Malheureusement, en politique plus qu’ailleurs, l’adage selon lequel le contraire de l’IA est la bêtise naturelle s’applique parfaitement. Cette dernière est même plutôt efficace électoralement !

Après les élections se pose la question de la gestion. Est-ce que l’IA permettrait de préparer des choix censés mis ensuite dans les mains d’électeurs dans le cadre de démocraties plus participatives ? Est-ce que l’IA permettrait de bâtir des politiques économiques dignes de ce nom ? Est-ce l’IA permet d’intégrer les complexes relations sociales dans la société ? D’anticiper les réactions des citoyens aux nouvelles lois et réglementations, notamment fiscales ? Est-ce qu’elle permettra de gérer les conflits ? Est-ce qu’elle pourrait permettre d’accélérer la justice ? D’éviter les erreurs judiciaires ? De réformer les systèmes de santé au fil de l’eau des progrès technologiques ? Je n’en sais rien. Il n’y a pas beaucoup de chercheurs qui planchent sur ces questions ! Certains indiquent toutefois qu’une IA impliquée dans le processus apporterait un peu de rationalité et serait capable de prendre des décisions non basées sur le côté obscur des émotions.

Les systèmes d’aide à la décision politique pourraient-ils faire appel à de l’IA intensive ? Y compris lorsqu’il s’agit d’évaluer la position et l’attitude des autres parties prenantes, des agents économiques ou des chefs d’Etat ? Est-ce qu’une IA permettrait à un POTUS de gérer de manière optimale la relation conflictuelle avec Vladimir Poutine, les bras de fer avec les Chinois, ou de résoudre pacifiquement les divers conflits du Moyen-Orient ? Ou à un successeur de François Hollande de se dépatouiller de la situation en France ?

On a bien vu des films de Science Fiction mettant en scène des personnages liés à l’IA comme dans “Her” et “Ex Machina”, mais pas encore dans de la politique fiction. Ca ne serait tarder vu l’imagination débridée des scénaristes !

On en est encore loin. Ce qui démontre par l’absurde que l’AGI (Artificial General Intelligence) n’est pas pour tout de suite. Mais gare à vos fesses les politiques ! La démocratie participative pourrait prendre un visage inattendu !

Epilogue

Nous voici au terme de ce petit voyage dans l’IA. Nous n’avons pas fini d’en entendre parler !

Pour commencer, un grand merci à ceux qui ont commenté les précédents articles et m’ont fourni des pistes de réflexion et de lectures. J’avais posé quelques questions clés dans le premier article et les suivants ont permis d’y répondre en grande partie grâce à ces contributions. De nombreuses startups se sont faite connaitre et ont rejoint au fil de l’eau la sixième partie de la série sur les startups françaises.

Les effets de manche sont nombreux derrière les annonces tant dans l’IA que dans la robotique. Une généralisation et des extrapolations abusives sont souvent construites autour de performances médiatisées comme la victoire d’AlphaGo au jeu de Go ou celle de Watson à Jeopardy. Le phénomène enfle, maintenant que l’IA et le machine learning sont devenus des arguments marketing pour les startups comme pour les grands groupes du numérique. Et les prédictions vont bon train, de la fin des métiers à la fin de l’Homme lui-même.

L’impression subsiste aussi que les prouesses récentes sont bien plus liées aux progrès dans le matériel que dans les logiciels et les algorithmes. Qui plus est, la puissance brute des machines a tendance à rendre les développeurs moins astucieux dans leur manière d’aborder les problèmes. Mais cette impression vient probablement de la difficulté à bien appréhender la nature même des progrès réalisés dans les algorithmes et procédés techniques de l’IA. Leur vulgarisation est très difficile.

Malgré ces nombreux écueils et la bulle médiatique qui l’accompagne, l’IA fait cependant des progrès réguliers et la vague semble aussi importante que les vagues technologiques précédentes qu’ont été le cloud, le big data ou les objets connectés ou même que les BlockChains, un peu trop présentés en ce moment comme la poudre de perlimpinpin universelle de l’économie. Elle est d’ailleurs reliée à ces vagues car elle en fournit des outils permettant d’en améliorer la performance et la valeur d’usage.

Nous avons aussi vu que la loi de Moore était à la fois un peu enjolivée dans les discours et qu’elle pouvait avoir tendance à ralentir, notamment dans la puissante brute des processeurs. Cela n’empêche pas les chercheurs et entreprises du secteur à redoubler d’efforts pour continuer l’aventure. Ce n’est pas parce que c’est plus difficile qu’avant d’avancer que cela ralentit les innovateurs. Au contraire même ! Les perspectives d’atteindre des “moonshots” les motivent. L’Homme est est insatiable dans sa quête de savoirs et d’innovations.

Nous avons pu découvrir de nombreuses startups françaises dans le domaine de l’IA, aussi bien au niveau des techniques horizontales que des applications métiers. Nous avons aussi des talents français également établis aux USA ou dans des entreprises américaines, comme Yann LeCun qui a créé le laboratoire d’intelligence artificielle de Facebook à Paris. Reste à transformer cela en avantage stratégique et en emplois ! Les questions qui se posent sont les mêmes que d’habitude : comment faire en sorte que ces startups grandissent vite, soient bien financées et se développent à l’international.

Une opportunité existe pour bien positionner la French Tech sur ce créneau porteur qui structurera vraisemblablement les plateformes numériques des années à venir. Comme d’habitude, il s’agit d’être les premiers à créer des plateformes mondiales de grande ampleur, pas juste de créer des myriades d’applications métiers disparates. L’excellence en R&D ne se traduit pas nécessairement en innovations et réussites économiques sinon, la France serait championne du monde des industries numériques depuis des décennies !

Enfin, même avec une IA un peu faiblarde et lourdingue, la marche vers l’automatisation totale ou partielle de nombreux métiers est déjà en route. Il faut s’y préparer dès maintenant, ne pas y résister futilement, s’y adapter en se modernisant, en faisant évoluer notre système d’enseignement et en produisant des outils compétitifs. Les civilisations qui ont évité les progrès techniques et les outils de communication dans l’histoire ont systématiquement périclité ou, au mieux, décliné. Les deux exemples les plus connus sont l’empire Ottoman qui a mis trois siècles à adopter l’imprimerie ou la Chine qui a brutalement bloqué ses échanges maritimes aux débuts du 15ième siècle.

Qui plus est, les prévisions des prévisionnistes n’engagent que ceux qui y croient. Elles sont souvent à côté de la plaque. Le futur n’est pas écrit à l’avance, il s’écrit au fur et à mesure.

___________________________

Vous pouvez consulter tous les épisodes de ce roman fleuve de printemps sur l’intelligence artificielle :

Episode 1 : sémantique et questions clés

Episode 2 : histoire et technologies de l’intelligence artificielle

Episode 3 : IBM Watson et le marketing de l’intelligence artificielle

Episode 4 : les startups US de l’intelligence artificielle

Episode 5 : les startups acquises par les grands du numérique

Episode 6 : les startups françaises de l’intelligence artificielle

Episode 7 : la modélisation et la copie du cerveau

Episode 8 : évolutions de la loi de Moore et applications à l’intelligence artificielle

Episode 9 : la robotisation en marche des métiers

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Très intéressant et bien documenté. Merci

Excellente analyse!

Vous posez des questions qui “fâchent”.

A moins de s’y intéresser, les citoyens français n’ont malheureusement pas conscience de ces profonds changements qui vont pourtant impacter leurs enfants. Quant à nos politiques, ils n’en ont soit pas conscience, soit ils n’ont pas intérêt à soulever les gigantesques questions (et donc problèmes) que cela pose.

Je vous rejoins sur les effets de bulle médiatique. Si les progrès technologique sont toujours surestimés à court terme, ils sont sous-estimés à long terme. Ne pensez-vous pas que notre capacité d’apprentissage/adaptation est déjà plus faible que celle des machines ? Le cas échéant à long terme cela ne vous semble pas probable ? Il faut de moins en moins de temps pour former un système expert alors que notre système éducatif reste relativement linéaire.

Enfin une technologie n’est pas adoptée lorsqu’elle est mature mais lorsqu’elle ne fait plus peur. Cette crainte n’est-elle pas induite en partie par notre culture ?

C’est ce que semblent montrer les politiques chinoise, américaine ou anglaise, par exemple, vs la France sur les sujets que vous évoquez.

Je ne suis pas inquiet sur la vitesse d’apprentissage car on ne parle pas de la même chose : les machines n’apprennent pas de nouvelles méthodes plus rapidement que l’Homme, elles vont plus vite à gérer de gros volumes d’information. La créativité, le fonctionnement par analogie, la reconnaissance de patterns (au sens large) sont des compétences transversales qui s’apprennent et que les machines n’ont pas encore. On doit les développer. Qui plus est, les machines font ce que l’Homme lui dit de faire. On gamberge sur la perte de contrôle du processus quand la machine apprend par elle-même. Mais cet auto-apprentissage est pour l’instant limité. C’est le problème de la représentation symbolique dans les machines, un domaine où l’on bloque pour l’instant.

La formation des systèmes experts ? C’est mythe des années 1980 qui s’est bien évaporé depuis. Parce qu’il est difficile d’encoder le savoir des experts. On a remplacé les systèmes experts par la force brute du traitement de données, par le traitement du langage, qui permettent de modéliser le savoir de manière très approximative, comme le fait Watson dans Jeopardy ou bien Google Search.

Mais ces différences de vitesse d’apprentissage se manifestent déjà sans l’IA : dans le monde du travail, la non maîtrise des outils numériques et technologiques est déjà un énorme handicap. Une PME qui n’a pas de site web en anglais ne peut pas exporter facilement, etc. L’Histoire a montré que les économies et civilisation qui progressaient le mieux étaient celles qui s’appropriaient à grande échelle les progrès technologiques, aussi bien dans la production que dans la communication, et qui faisaient évoluer leurs démocraties au passage.

Pour ce qui est de la peur, je suis circonspect. Je ne pense pas que la peur bloque l’adoption tant que la valeur est là. Sinon, personne n’utiliserait Facebook ou Google ou même un micro-ordinateur, tant les risques dans la sécurité ou dans la vie privée sont importants. Oui, la culture française est peureuse dans l’ensemble et cela peut ralentir sa capacité d’assimilation de nouvelles technologies. On l’a vu dans le cas des OGMs ou dans la position de la profession médicale vis à vis de la génomique.

#MustRead “Les avancées de l’intelligence artificielle-9e volet des écrits de @olivez sur IA https://t.co/xYDoCuvqBE https://t.co/RPFyMlxJyx

A nouveau merci pour cette longue analyse. La preuve que sans prendre le temps de se cultiver, de s’interroger sur des problématiques complexes, on bâtit des visions simplistes du monde. Comment les “experts” peuvent-il réintégrer la société et aider aussi bien le quidam que le décideur à comprendre et décider. C’est une question qui me cause souci tant notre monde est en crise, encourageant des populismes qui montent un peu partout. Il n’y a pas une vérité, il a tout de même quelques vérités, et au moins des faits, et même les individus de bonne volonté peuvent se tromper. Désolé pour ce petit message un peu inquiet. les bloggers ont la chance de pouvoir prendre le temps, ce que les autres media ne font plus. Mais sont-ils lus? écoutés? Merci aussi pour m’avoir fait découvrir Tim Dettmers (timdettmers.com) et son article sur la comparaison du deep learning et du cerveau. J’ai l’impression que les bloggers deviennent un peu des personnages comme ceux de Fahrenheit 451, des résistants de la culture, de la connaissance!

Merci Hervé !

Il y aurait matière à gamberger sur le fonctionnement des démocraties dans le monde complexe. La démocratie classique demande de la simplicité dans les messages, ce qui pousse au populisme ou bien, au minimum, à décider des choses contradictoires comme dans le domaine économique.

Comment gérer la démocratie dans une société de plus en plus complexe ? C’est une méga-question. Cela passe par l’éducation et les médias en effet. Egalement, par un développement de la culture scientifique et technologique qui a tendance à aller complètement à vau-l’eau.

Anecdotes :

– D’un côté, Laurent Alexandre (fondateur de Doctissimo et DNAvision) m’a félicité pour ma “synthèse”. Mes 9 articles font 134 pages A4 soit l’équivalent d’un bouquin. Donc, considéré, à juste titre d’ailleurs, comme une synthèse de la question.

– De l’autre, une chaîne de TV m’a récemment demandé de résumer “ma synthèse” en deux minutes. J’ai débordé, et fait 3 minutes.

Tout est dit…

Olivier

[#MustRead] Un update sur l’#IA? #LaBanqueDeDemain >> Les avancées de l#IA – 9/9 @olivez https://t.co/lZbdrBSbgq

Avancées de l’IA et revue éditoriale sur la robotisation des métiers et le futur des emplois @olivez sur https://t.co/39tjiLSxyl

#MustRead Les avancées de l’intelligence artificielle #IA de @olivez https://t.co/EVDMHVhX3d @SeverineLienard https://t.co/Cg2h9mmIaU

Votre série d’article sur les IA sont très instructifs!

Les avancées de l’intelligence artificielle, une synthèse #mustread https://t.co/a3QlgkCJQ0