Après une première partie de sémantique puis une seconde sur les briques technologiques de l’IA, je vais m’attaquer à un troisième pilier : le marketing des offres. Nous allons commencer par étudier le cas d’IBM avec Watson puis élargir la réflexion au marché en général.

La prouesse technique et marketing d’IBM Watson

Dans les années 1960, IBM aurait stoppé brutalement ses travaux de recherche en IA par peur que les postes de managers soient remplacés par des machines. C’était aussi le résultat d’une peur remontée par leurs clients qui avaient peur de perdre leur poste de management. Et oui ! Comme aujourd’hui, où l’on entend les prospectivistes annoncer l’Armageddon dans plein de catégories d’emplois. Comme nous l’avons vu dans l’article précédent, ces craintes étaient alimentées par des prévisions un peu trop optimistes côté timing issues d’experts de l’IA comme Herbert Simon. Prenons-en de la graine ! (source : Humans Need not Apply – 2015, de Jerry Kaplan).

Fast forward. IBM a du faire sa mue de constructeur vers le métier d’éditeur de logiciels couplé à celui de prestataire de services à partir de 1993, au moment de l’arrivée de son nouveau CEO de l’époque, Lou Gerstner. Aujourd’hui, IBM est une société à nouveau en déclin, en tout cas en termes de chiffres d’affaires. Celui-ci est passé sous celui de Microsoft en 2015, une belle barre symbolique, surtout dans la mesure où Microsoft n’est même plus l’étalon de la croissance dans le numérique depuis que Google, Facebook et Apple lui ont damé le pion.

En tout cas, IBM génère maintenant l’essentiel de son profit à parts égales entre logiciels et services. La synergie entre les deux métiers est plutôt bonne même si la branche services d’IBM travaille aussi avec les technologies concurrentes. Ils savent déployer des solutions qui intègrent du Oracle, du Microsoft, du SAP, bref de tout, en fonction des contraintes du client.

La question reste cependant pour tout acteur du marché de ne pas rater les vagues technologiques. IBM s’en était pas trop mal sorti en 2000 en se positionnant dans le e-business. Sa campagne de communication martelait le rôle de “one-stop-shop” provider d’IBM pour ses clients. Pour la petite histoire, elle avait été pilotée par un certain Pierre Chappaz, devenu ensuite créateur de Kelkoo, puis Wikio, intégré depuis dans le groupe Teads.

IBM a petit à petit délaissé ses activités matérielles dans les machines de commodité. Le délestage s’est fait par étapes : les imprimantes avec la création de Lexmark en 1991, les PC cédés en 2004 au chinois Lenovo, et puis les serveurs PC cédés également à Lenovo, en 2014. Par contre, ils ont toujours misé sur les grandes architectures, dans la lignée de leur ligne historique de mainframes. D’où l’importance pour eux du HPC (High Performance Computing) et de l’intelligence artificielle.

La première incartade d’IBM dans l’IA s’est manifestée au grand jour avec la bataille des jeux d’échecs. Durant plusieurs années, elle culmina avec la victoire de l’ordinateur IBM Deeper Blue (ci-dessus) contre Gary Kasparov en 1997. Cela a contribué à relancer les recherches d’IBM sur l’IA dans les années 2000.

La seconde grande étape a été la victoire d’IBM Watson au jeu Jeopardy en 2011. Jeopardy est une sorte de “Questions pour un Champion” américain, sans Julien Lepers. Trois parties avaient été organisées : un échauffement le 13 février, et deux les 14 et 15 février. J’ai regardé l’épisode du 14 février sur YouTube. Il mettait face à face un avatar représentant Watson sur écran et deux champions du jeu : Brad Rutter et Ken Jennings. Dans les trois parties, Jeopardy gagne, fine. On se rend compte que Watson ne répond pas bien à toutes les questions, tout du moins au début. C’est un diésel ! Il est lent au démarrage mais carbure bien ensuite.

J’ai trouvé une autre partie intéressante et moins médiatisée organisée avec comme joueurs Miles O’Brien et David Gondek, l’un des créateurs de Watson. Au départ, Watson ne sait pas indiquer pendant quelle décennie Klaus Barbie a été condamné. OK, ce n’est probablement pas un problème de compréhension mais plutôt de bases de connaissances utilisées ! Il ne sait pas indiquer sur quelle place de Dallas (Dealey Plaza) JFK a été assassiné. La littérature sur le sujet est pourtant abondante aux USA. Il ne sait pas non plus ce qu’est la vermiphobia (la phobie des vers) ni la ailuraphobia (phobie des chats) dont la signification est disponible sur Wikipedia. Mais la reconnaissance vocale est peut-être défaillante sur ces termes peu usités.

Il ne sait pas non plus identifier des recettes de cuisine en fonction de leurs composantes. C’est plutôt décevant. Un peu comme les systèmes de reconnaissance de la parole qui marchotent en situation difficile. Watson a du mal à répondre à des questions formulées avec peu de mots et comprenant des ambiguïtés ou des doubles sens. Watson ne devait pas non plus accéder à des sources d’information suffisamment larges, et en particulier étrangères. Pourtant, il s’agissait tout de même de 200 millions de pages de données structurées et non structurées représentant un total de 4 To. Mais j’ai lu quelque part que dans Jeopardy, les questions n’étaient pas interprétées par Watson par reconnaissance de la parole mais pas saisie humaine. Ce qui induisait potentiellement une source d’erreur externe à Watson.

Pendant la première moitié de la partie, Watson est en retard par rapport à ses deux concurrents. Il commence à battre ses concurrents à partir d’une série de questions visant à déterminer quelle capitale est la plus au nord parmi deux villes. Comme les candidats américains ont l’air d’être nuls en géographie (moi, m’sieu, je savais…), ils ne répondent à aucune de ces questions alors que Watson a une belle base de donnée en mémoire avec les villes et leurs coordonnées géographiques. Dans les questions qui suivent, Jeopardy prend le dessus. On se demande si l’impact psychologique de la remontée de Jeopardy avec les questions sur la géographie joue un rôle. Cette partie méconnue dure moins de 15 minutes en tout. L’un des deux joueurs a empoché $28000 et Watson, $31999. Ils sont au coude à coude.

Il a fallu du temps pour aboutir à ces performances de Watson ! Plusieurs parties d’essais avaient été perdues par Watson avant l’épisode historique de 2011. IBM indique que Watson s’est amélioré au gré des parties, mais il est difficile de faire la part des choses entre les évolutions logicielles, un éventuel auto-apprentissage et la fourniture de nouvelles sources de données. En tout cas, le champion de Jeopardy Ken Jennings témoignait en février 2013 dans TEDxSeattle de cette douloureuse impression de devenir obsolète. A vrai dire, il ne l’est toujours pas. Cinq ans après, le jeu Jeopardy est toujours diffusé sur la TV US et depuis 1964, un record ! De quoi relativiser les prévisions alarmistes sur l’obsolescence des métiers ! Même si joueur de Jeopardy n’est pas à proprement parler un métier.

Cette histoire de Jeopardy est un peu enjolivée et construite par la communication d’IBM qui au passage, a été pilotée à l’échelle mondiale par l’agence Ogilvy. La performance n’est pas si impressionnante que cela. J’aurais été bluffé si Watson avait essayé de répondre à toutes les questions et écrasé ses concurrents à plates-coutures. Cela montre la difficulté d’accéder à des informations faiblement structurées, même si tout est disponible sur Internet. Watson chargeait toute sa base de données interne en RAM et ne tapait pas en temps réel dans Internet ou dans un moteur de recherche pour des raisons de rapidité, d’où ses limites.

A priori cependant, les limitations rencontrées pendant la partie de 2011 ont pu être levées depuis. Ce n’est qu’une question de moyens. Il faudrait probablement organiser une partie “retour” où Watson répondrait (juste) à 100% des questions ! Et trouver des figurants pour le contrer ! Watson fait ce que Google Search devrait peut-être faire un jour, en allant plus loin que ses habituelles méthodes statistiques. Seulement voilà, Watson n’est pas aussi scalable que l’architecture de Google Search ! Pour l’instant. Sinon, Google mettrait probablement en œuvre des méthodes voisines de celles de Watson dans son moteur de recherche. Il en maîtrise très bien les composantes technologiques.

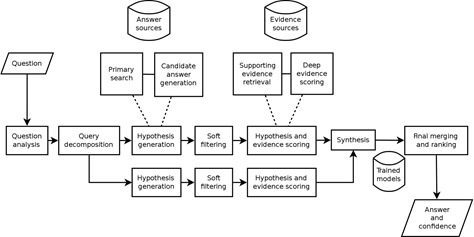

Watson était au départ un projet de recherche baptisé BlueJay (2007) focalisé sur l’exploitation de gros volumes de données non structurées. Il s’intégrait dans la volonté d’IBM Research de s’attaquer à un grand défi, comme passer le fameux test de Turing, ou en dialoguant avec une machine, on ne sait pas distinguer l’homme de la machine. Watson était d’abord présenté comme un ordinateur. Il s’appuie sur une architecture massivement parallèle à base 750 serveurs utilisant des processeurs Power7 octo-cœurs tournant à 3,5 GHz totalisant 16 To de RAM. Cette fameuse RAM chargeant tout le corpus de contenus utilisé pour Jeopardy.

Watson est devenu une plate-forme logicielle, respectant en cela les canons de la réussite dans le numérique. Elle est proposée aux développeurs sous forme d’APIs en cloud. L’histoire est bien racontée ici. Dans la pratique, Watson s’appuie principalement sur la solution DeepQA d’IBM et le framework Apache UIMA (Unstructured Information Management Architecture) qui permet d’exploiter des données non structurées.

Notons que la communication d’IBM est en tout cas très focalisée sur le cognitive computing et que Watson est le produit d’appel phare. C’était le seul sujet de l’intervention en keynote de Ginni Rometty au CES de Las Vegas de janvier 2016. IBM organise aussi chaque année une grande conférence “World of Watson” dont la dernière édition avait lieu à New York du 23 au 24 mai 2016. Les vidéos des keynotes de l’édition de mai 2015 sont disponibles pour la première et la seconde journée.

L’approche écosystème de Watson

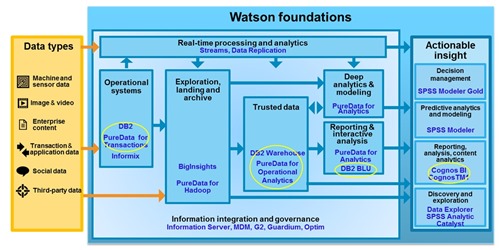

A chaque solution d’IA, son assemblage de composants hétéroclites réalisé sur mesure pour répondre à un besoin. C’est particulièrement vrai d’IBM Watson. Ce dernier est un très bon coup business et marketing d’IBM, qui a réussi à simplifier un sujet très complexe. Ils ont ainsi vulgarisé les capacités de Watson et pu cacher sa complexité, voisine de celle de l’architecture de WebSphere et dans laquelle cohabitent une belle part des techniques évoquées dans l’article précédent.

IBM a annoncé investir plus de $1B sur le Cognitive Computing, un peu comme il avait annoncé au début des années 2000 investir la même somme sur le développement de Linux. C’est donc un beau pari marketing et business qu’IBM fait ici. Et c’est plutôt bien vu car une bonne part du futur des solutions numériques va utiliser les techniques de l’IA. Il faut toujours se positionner sur un futur pas trop lointain pour éviter de rater les trains de la technologie qui passent !

Fredrik Stenbeck a bien décrypté début mars 2016 ce que contient IBM Watson. Il est proposé aux développeurs de solutions sous la forme d’APIs REST (avec des GET et des POST envoyés via HTTP) qui permettent d’accéder à la panoplie de services suivants :

- Document Conversion, un service qui permet de convertir tout document textuel (PDF, Word, HTML) pour les faire ingérer par les services de Watson. C’est l’alimentation de la base de connaissances.

- Le Natural Language Classifier qui permet de classifier automatiquement des données textuelles, issues en général de questions posées par des clients en langage naturel.

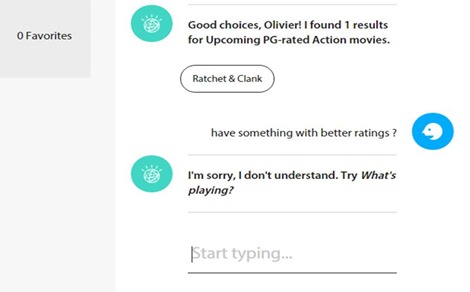

- Dialog, un outil qui permet de gérer des conversations scriptées pour des agents conversationnels, avec des arbres de décision. Ce genre d’outil est mis en œuvre depuis des années dans les systèmes de chat des sites de commerce en ligne. Les dialogues générés sont limités car préprogrammés. Voici un exemple de code et le résultat associé :

- Retrieve and Rank, un service qui s’appuie sur le logiciel open source Apache Solr et qui permet de traiter les requêtes et questions en s’appuyant sur un mix de moteur de recherche et de machine learning.

Créer une application Watson revient donc à créer du code, du contenu et à réaliser un travail d’intégration pour créer un agent conversationnel intelligent. Dans des approches verticales, il faut définir des scénarios de dialogues assez précis et avoir sous la main beaucoup de données exploitables, aussi bien structurées que non structurées.

D’où l’importance pour IBM d’avoir un écosystème de partenaires solutions à même de couvrir les besoins de divers marchés verticaux. Pour ce faire, IBM a lancé un programme partenaire assez classique qui comprend l’accès aux APIs, à une communauté, un programme d’accélération de trois mois et un catalogue de solutions pour promouvoir les partenaires. A ce jour, l’écosystème d’IBM Watson comprend environ 400 sociétés. Le programme d’accélération porte surtout sur l’accompagnement technique mais donne aussi l’opportunité de pitcher son offre pour récupérer un part du fonds d’investissement de $100m créé pour l’occasion.

En plus de son écosystème, IBM développe l’activité de services pour prendre en main de bout en bout les projets de ses grands clients. Alors que l’équipe d’origine de Watson ne faisait que quelques personnes, elle comprend maintenant 2000 personnes ans le monde, principalement des consultants, avant-vente et développeurs. Y compris, un centre d’avant-vente et de support situé à Montpellier. L’ensemble est intégré dans les “IBM Cognitive Business Solutions” avec un focus sur quelques marchés clés : l’assurance, le retail et la santé. Ces 2000 personnes sont un bon début mais encore peu au regard des 270 000 collaborateurs d’IBM Services (c’est une estimation au doigt mouillé). La migration d’IBM vers un business “cognitif” suffisamment différentié des autres sociétés de services globales dans le monde est une course contre la montre. Et ces dernières ne se laisseront probablement pas faire, même si elles auront probablement quelque temps de retard à l’allumage.

Quid du prix de Watson ? Il serait fourni à coup de licence logicielle d’un prix supérieur au million de dollars, mais avec un tarif plus proche de ceux du cloud pour les partenaires. IBM prévoit de générer $10B de CA grâce à Watson d’ici une dizaine d’années. Ce qui ferait plus de 12% de son CA actuel.

Reste à savoir comment se positionne IBM par rapport à l’éventail de solutions du marché. L’impression est donnée d’un spectre fonctionnel assez limité et focalisé sur la création d’agents conversationnels. Les offres ne sont pas applicables au traitement de l’image ni à la robotique. C’est accentué par le fait qu’IBM ne communique pas dans le détail l’architecture des briques technologiques logicielles que contient Watson. Ou alors, on y trouve des briques logicielles intégrées dans l’offre de manière un peu rapide comme les Watson Analytics qui permettent par exemple de segmenter automatiquement une audience client en fonction de ses comportements et d’identifier ceux des segments susceptibles de générer du “churn” (perte de clients).

Avec leur approche service et intégration, IBM pourra cependant toujours affirmer qu’il sait intégrer les autres briques du marché. Bref, Watson est, en l’état, un objet difficile à benchmarker avec sa concurrence !

Les études de cas et projets d’IBM Watson

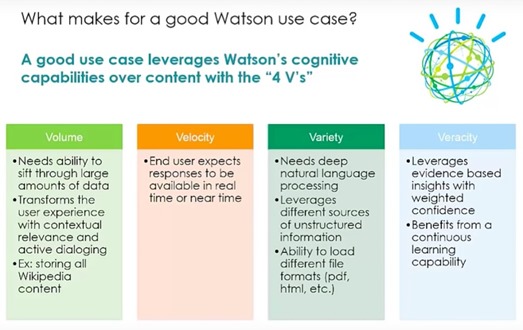

IBM définit dans sa communication ce qu’est un bon projet pour Watson :

- Il doit traiter un gros volume de données. Makes sense !

- La solution doit permettre de répondre rapidement aux questions des utilisateurs, dans cette logique d’agent conversationnel fonctionnant en mode questions/réponses.

- La variété es questions traitées doit être grande grâce à une large palette de compréhension. Le système doit pouvoir traiter en profondeur les questions posées.

- Watson doit être en mesure d’évaluer la validité des réponses, avec un indice de confiance, comme il le faisait dans Jeopardy.

Quand on observe le marketing et les études de cas avancées par IBM, les mêmes ont tendance à revenir systématiquement, notamment le système expert d’aide au diagnostic et de prescription pour le traitement de cancers. Leur montée en puissance commerciale est difficile à évaluer. Les projets doivent être longs à closer et à mener avec les grandes entreprises surtout si elles doivent mettre de l’ordre dans leurs données, comme ce fut le cas avec les projets de systèmes experts dans les années 1980. Ils ont probablement également des clients dans les secteurs militaires et du renseignement US qui ne donnent pas lieu à de la communication marketing. Finalement, les références sont maintenant bien plus nombreuses avec les partenaires éditeurs de logiciels qu’avec IBM en direct.

Voyons donc ce qu’IBM a dans sa besace de références clients et partenaires, par segment de marché.

Santé

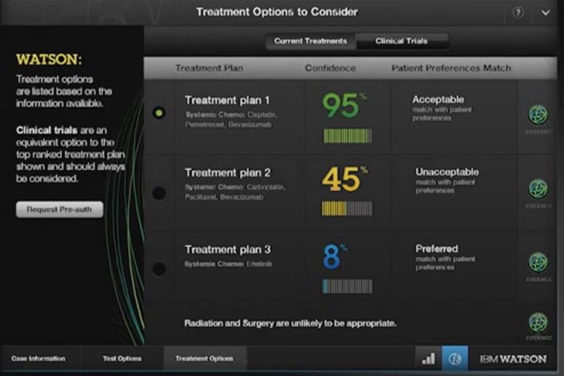

La solution Watson for Oncology a été créé initialement en partenariat avec l’assureur santé Anthem (anciennement WellPoint) et le Memorial Sloan Kettering Cancer Center (MSK) de New York, qui associe un hôpital et un centre de recherche. Elle a ensuite été déployée dans plus d’une quinzaine d’établissements aux USA et ailleurs dans le monde comme en Inde. Elle est fournie sous forme de service en cloud, avec un abonnement dont le prix n’a pas été rendu public par IBM.

La solution analyse les dossiers de patients atteints de tumeurs cancéreuses, y compris le séquençage d’ADN des tumeurs (semble-t-il, et non pas un simple génotypage, mais on peut aussi séquencer l’ARN qui évalue l’expression des gênes dans les tumeurs), aide au diagnostic, détermine des traitements possibles et évalue leur efficacité relative. Il aide notamment à optimiser l’usage de la chirurgie, de la radiothérapie et de la chimiothérapie. Les cancers sont des pathologies idéales pour Watson car elles sont plurifactorielles. Mais ce n’est pas (encore) de la médecine préventive.

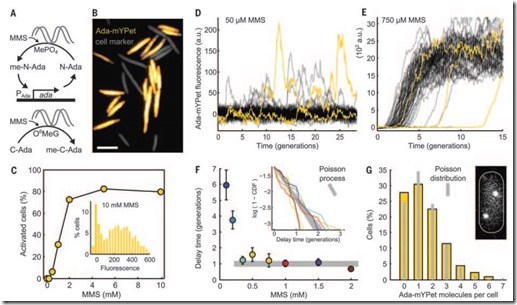

Les études scientifiques publiées sont très nombreuses et toujours fournies avec des résultats statistiques sur des cohortes de patients. Il faut les croiser avec des logiques statistiques bayésiennes et cognitives complexes pour en tirer des conclusions. On connait par exemple le lien entre les mutations des gênes BCRA1 et BCRA2 et les cancers du sein. Des données statistiques peuvent exister qui font le lien entre type de thérapies et types de mutation de ces gênes. On est ici dans le domaine du big data non structuré contrairement au big data dans le marketing qui est basé sur des données bien plus structurées en général (logs Internet, données d’achats ou de consommation, bases de données relationnelles, etc). Il semble que cette partie de la solution ait été développée en partenariat avec Cleveland Clinic.

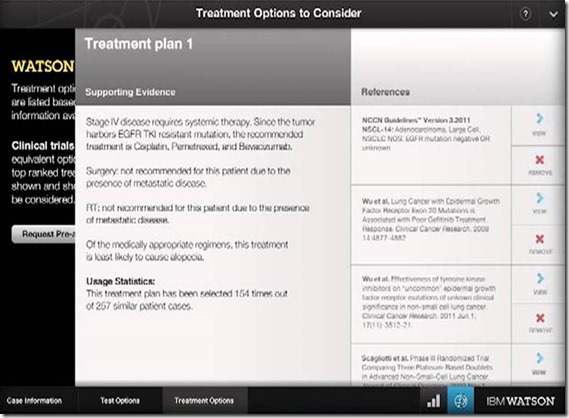

Watson utilise des sources d’informations variées pour faire son diagnostic, et il pioche notamment dans les 44 000 nouvelles publications scientifiques annuelles sur le cancer. Les articles ne sont pas toujours faciles à exploiter : autant le texte relativement facile à analyser, autant les illustrations qui ne sont pas fournies sous format structurées comme dans l’exemple ci-dessous, ne doivent pas être facilement exploitables. Or elles fournissent des données critiques, exploitables statistiquement, à supposer que Watson puisse comprendre leur signification. L’exploitation de la littérature scientifique ne doit donc pas être bien évidente à ce niveau. Par contre, elle est peut-être plus aisée pour les études liées aux AMM (autorisations de mise sur le marché) et autres études épidémiologiques.

Watson fournit au praticien un choix de traitements qui sont fournis avec un indice de confiance, comme la probabilité de survie. Après avoir démarré avec les cancers du poumon, les cancers couverts intègrent maintenant les leucémies, les mélanomes, ceux du pancréas, des ovaires, du cerveau, du sein et du colon.

Dans cette application, Watson bat l’homme dans la force brute : il compulse notamment des bases de données de recherche en oncologie pour aider les cancérologues. Mais d’où viennent ces données ? Fait-il progresser la recherche ? Indirectement oui car il va alimenter ces bases de données qu’il utilise avec des résultats de traitement saisis par les praticiens.

Par contre, il ne fait pas directement progresser la recherche sur les cancers. Il ne faut pas oublier que chacun des articles scientifiques exploité a nécessité de 3 à 7 années de recherche par plusieurs chercheurs ! C’est un travail considérable. Watson utilise les résultats de la recherche existante, recherche qui s’appuie sur des expériences (in-vitro et in-vivo, que l’on ne sait pas encore simuler numériquement) et les résultats statistiques associés. Bref, on a encore besoin de chercheurs ! Pour automatiser ce processus, il faudra passer par plusieurs stades d’évolution de l’IA : ajouter la dimension créative et conceptuelle, automatiser des tests in-vitro et in-vivo avec des robots et en dernier lieu, bien plus tard, réaliser ces tests in-silico quand les algorithmes et la puissance de calcul le permettront.

Dans les applications santé de Watson, on peut aussi citer l’application de GenieMD qui permet aux patients, aux USA, de faire un premier niveau d’autodiagnostic de problèmes de santé courants et d’être ensuite mis en relation avec des praticiens. Il permet aussi de suivre l’observance de la prise de médicaments. La solution exploite les informations fournies par les patients en langage naturel. C’est une application générique qui pourrait être mise en oeuvre dans les stations de télémédecine pour les déserts médicaux.

Enfin, au CES 2016, IBM présentait avec l’équipementier médical Medtronic une autre solution utilisant Watson pour prédire la survenue d’hypoglycémies des diabétiques de type 1. Les données exploitées étaient visiblement moins massives que celles de l’application sur les cancers. L’hypoglycémie est générée par une boucle de rétro-action plus simple qui associe l’activité physique, la prise d’insuline et l’alimentation. Il faut donc mesurer les trois ce qui n’est pas trop compliqué pour les deux première mais moins évidente pour la dernière, même avec les capteurs de type Scio. Cependant, l’application est probablement pertinente pour ceux des diabétiques qui pratiquent un sport intensif et pour lesquels les risques d’hypoglycémie sont importants et répétés.

Distribution

Dans le retail, IBM propose une solution d’analyse des données clients et de sources diverses pour anticiper les besoins du marché et adapter les inventaires et les stratégies de tarification.

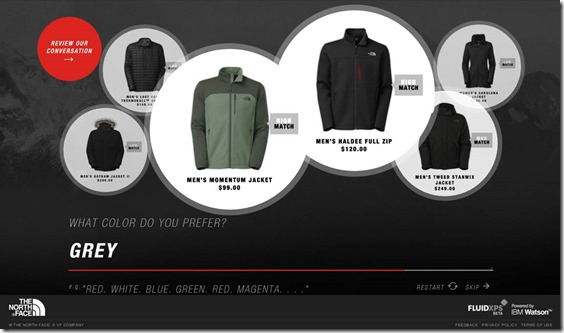

IBM propose aussi un Personal Shopper été réalisé en partenariat Fluid. Le premier client est la chaîne de distribution de vêtements sportifs North Face. Il s’agit là encore d’un agent conversationnel utilisable via le service en ligne du site marchand. Le corpus de données utilisé exploite tout le catalogue du site ainsi que les différents critères de choix des vêtements. Le dialogue proposé est très “scripté”. Son arborescence semble limitée. Le système a été présenté au Big Show 2016 de la National Retail Foundation à New York. Pour en savoir plus voir ce compte-rendu détaillé sur le JDN : Comment The North Face a appliqué Watson à l’expérience d’achat.

L’éditeur de logiciel américain Red Ant a aussi développé une solution de formation des commerciaux, SellSmart, qui accède au CRM de l’enseigne utilisatrice (vidéo).

Juridique

Le secteur juridique exploite de très gros volumes de données qualitatives : les lois et réglementations dans chaque pays, la jurisprudence des tribunaux et la littérature qui les commente. C’est un secteur qui fait appel comme la médecine à des praticiens qui doivent mémoriser de grandes quantités de textes. Watson arrive à point nommé pour les aider à piocher dans l’immensité du savoir de leur profession. Toujours pour les assister plus que pour les remplacer, sauf peut-être pour les tâches les plus élémentaires.

De nombreuses solutions juridiques sont déjà bâties sur Watson, surtout aux USA. Nous avions eu l’occasion d’en décrire certaines dans Les disruptions numériques dans les professions libérales en février 2016.

On compte notamment LegalZoom, un service d’avocat en ligne couvrant à la fois le droit des affaires et le droit civil (cf ce numéro de The American Lawyer qui en parle bien) et l’avocat virtuel de la start-up Ross Intelligence, un agent conversationnel capable de répondre à un éventail varié de questions juridiques. Le débat reste évidemment ouvert dans les professions juridiques pour évaluer la portée des solutions construites sur Watson et l’impact qu’il aura sur les métiers. Comme d’habitude, c’est la partie de ces métiers qui est la plus commoditisée et répétable qui sera automatisée en premier. Pour la partie qui relève plus de la dimension humaine, comme dans pénale, on aura encore besoin d’avocats pendant pas mal de temps. Et heureusement, si l’on parle d’automatiser une partie du travail des avocats, on ne l’évoque pas encore pour ce qui est des juges ! Un scénario avocat-IA contre juge-IA serait en tout cas intéressant à tester !

Divers

Watson a aussi fait son apparition sporadique dans divers marchés :

- Dans les assurances, avec Insurance Assistant de l’USAA (United Services Automobile Association), un agent conversationnel qui permet aux clients de cette assurance dédiée au personnel militaire US de s’y retrouver dans ses offres et services.

- Dans les objets connectés, avec l’ouverture d’un centre de recherche dédié à l’IOT et Watson à Munich.

- Dans les voyages avec la solution Cognintive Travel de la start-up WayBlazer qui est une sorte de concierge numérique commercialisé aux professionnels du tourisme. Une solution équivalente est proposée par GoMoment.

- Thomson Reuters qui automatise la production d’études de marché. Peut-être sauront-ils générer d’autres courbes que les droits dans leurs prédictions et adopter les exponentielles et les gaussiennes !

- Le spécialiste de l’équipement des centres d’appels Genesys va utiliser Watson pour améliorer ses services en analysant le flot de data généré par les appels clients.

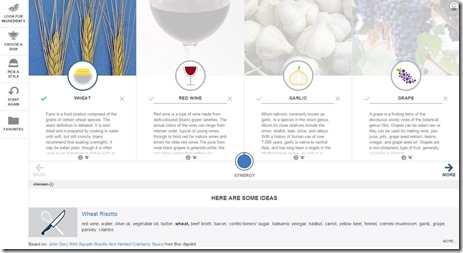

- Le magazine US Bon Appétit utilise Watson pour proposer automatiquement des recettes de cuisine en fonction des ingrédients que l’on souhaite utiliser (ci-dessus). Il ne génère visiblement pas encore de recettes de cuisine automatiquement. Je rêve de mon côté d’une application (qui existe peut-être) qui pourrait me proposer des épices composées en fonction des épices dont je dispose dans ma cuisine !

- La start-up de découverte de musique Decibel utilise aussi Watson dans son application MusicGeek pour faire de la recommandation.

- IBM a fait l’acquisition de Weather Company pour $2B et ainsi alimenter Watson avec des données météorologiques destinées à diverses applications. Les données sont notamment utilisées par les assurances pour identifier les risques météorologiques dans la définition de primes d’assurances dans l’immobilier. Et aussi pour prévoir le trafic de clients dans le retail.

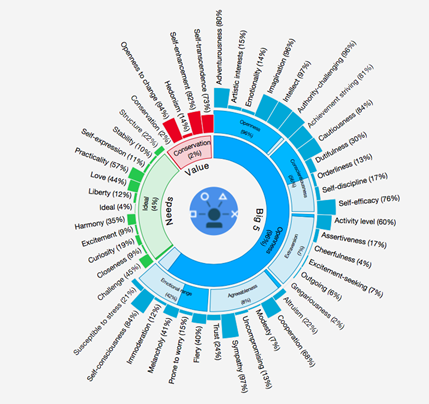

- Watson est même utilisable pour analyser votre personnalité à partir de vos écrits ! Pour l’instant, la solution ne fonctionne qu’en anglais ce qui permettra aux bloggeurs et journalistes français d’éviter la création de classements à la noix ! La solution permet en tout cas de détecter l’humeur de l’auteur, comme sa tristesse. On voit bien Facebook utiliser ce genre de solution pour prévenir des suicides !

Gouvernements

Des études de cas de Watson dans la sécurité doivent bien exister sans être documentées, même si l’offre d’IBM n’est pas forcément ce que l’on peut trouver de mieux pour ces besoins particuliers.

On peut noter la campagne Watson for president qui vise, un peu à la manière de Coluche en 1980, de faire élire Watson comme nouveau président américain en 2016. En indiquant que cela permettrait à la Maison Blanche de prendre des décisions rationnelles. C’est confondre un peu rapidement l’outil de la prise de décision (POTUS) et l’outil d’aide à la prise de décision (Watson et/ou le staff du Président et son administration). Un président fait déjà appel à de nombreux experts pour prendre ses décisions, en particulier dans la diplomatie, les négociations internationales et le pilotage du bras armé des USA. Il a aussi besoin de pas mal d’aide et de tacticiens pour faire voter des lois par le congrès qui est souvent récalcitrant, même lorsqu’il est du même bord que lui. On l’a vu pour l’Affordable Care Act (Obamacare) lors du premier mandat de Barack Obama.

Il faut aussi tenir compte de la connaissance de l’Histoire qui influe sur les décisions des politiques. Le cerveau fonctionne très souvent par analogies. L’IA et Watson n’utilisent pas encore massivement le raisonnement par analogies. Il répond surtout en fouillant dans de vastes dépôts de connaissances et pour croiser quelques informations structurées.

Pourrait-il répondre : si tu envahis tel pays dans telle et telle circonstance, voici ce qui a le plus de chances de se produire en suivant les leçons de l’histoire connue ? Voici ce qui permettrait d’éviter le pire ? On apprend souvent du passé pour (mieux ?) décider du futur. Mais de nouveaux éléments complexifient la donne. Par exemple, doit-on faire une analogie entre la montée du FN et des populismes dans le monde et la situation des années 1930 et d’avant seconde guerre mondiale ? Qu’est-ce qui est similaire et qu’est-ce qui est différent ? Comment anticiper la dimension émotionnelle qui fait bouger un peuple ? Quand est-ce que le peuple est au bord d’une révolte ? Comment l’anticiper ? Autre difficulté à surmonter pour l’IA, mais pas insurmontable : comment tenir compte d’un adversaire qui agit de manière non rationnelle ? La plupart des algorithmes d’IA sont conçus de manière rationnelle ! Exemple : comment réagir quand l’une des parties agit de manière irrationnelle, tel un Saddam Hussein en 1990/1991, voir quand les deux parties sont irrationnelles avec ce même Saddam Hussein et Georges W. Bush en 2003 ?

Je m’étais aussi demandé en 2013, pour les 50 ans de l’assassinat de JFK, si un système de type Watson ne pourrait pas analyser toute la littérature sur le sujet et pondre une synthèse voire résoudre l’énigme qui est bien plus complexe qu’une simple théorie du complot style 9/11. L’analyse des faits et mystères de l’histoire pourrait probablement gagner de ce genre de système. Mais l’intérêt économique de la chose est plutôt marginal !

L’IA mis à toutes les sauces dans le marketing des start-ups

L’IA ou le machine learning deviennent des “selling points” de solutions logicielles et en particulier dans l’univers des start-ups. Ce sont l’équivalent des vrais morceaux de fruits dans les yaourts ! Sauf qu’on ne connait pas bien les fruits, leur origine et leur nature.

Rares sont les start-ups qui expliquent en détail les prouesses qu’elles réalisent grâce à l’IA et l’effort que cela leur a demandé. D’où viennent les logiciels ? Sont-ce des briques open source ou des briques spécifiques ? D’où viennent les données ? Nécessitent-elles de la préparation pour l’ingestion par le système ? Est-ce que le système a nécessité beaucoup de tests pour sa mise au point ? Ou au contraire, en faut-il beaucoup pour chaque projet client ?

Exemple de communication ambiguë de ces points de vue-là de la part d’Yseop, un éditeur de logiciels français spécialiste de la business intelligence et dont l’activité internationale se porte très bien :

“A l’aide d’un puissant moteur d’intelligence artificielle créé par Yseop, Savvy rend les données compréhensibles pour tout le monde. Ainsi, le logiciel peut traduire une représentation graphique, quelle que soit son niveau de complexité, en un texte limpide, en anglais ou en français.”

En fait, Savvy est un plugin pour Excel qui traduit en texte compréhensible les données d’un graphe. Avec la vidéo de démo, on n’est pas plus avancé pour identifier les morceaux de fruits du yaourt d’IA du logiciel ! Il y a probablement un bon savoir faire derrière ce logiciel mais son label “IA” est des plus vague ! Cela donne un petit côté magique et mystérieux au logiciel ce qui lui donne probablement une certaines valeur, le sortant de la vase du logiciel de commodité. J’ai pu obtenir une explication de la société sur le fonctionnement de son logiciel. Seulement voilà, il est difficile à traduire en langage naturel (moteur d’inférence d’ordre 2, …) ! Ca se complique sémantiquement quand des “algorithmes génétiques” sont utilisés. Ca y est, on exploite l’ADN de l’utilisateur ? Que nenni ! Il s’agit d’algorithmes de réseaux neuronaux qui combinent l’état de deux neurones pour conditionner celui de la suivante dans la chaîne de traitement, comme dans la combinaison des chromosomes dans la reproduction sexuée du vivant !

Chez CrowdFlower, on enrichit vos données grâce au machine learning ! Soit. Idem chez Sift Science qui lutte contre la fraude grâce encore au machine learning. On se retrouve à observer un marketing utilisant des mots magiques et où machine learning vient compléter l’arsenal du cloud et autre big data.

Chez Groupe361, on propose la solution Tanukis qui comprend “le premier dispositif e-learning doté d’intelligence artificielle” qui ressemble à un agent conversationnel, ajustant le parcours pédagogique en fonction du comportement de l’élève.

Il faudra un jour inventer des niveaux d’IA ou de machine learning. Histoire de pouvoir évaluer la taille des morceaux de fruits d’IA dans les yaourts à base d’IA ! Car le client et commentateur moyen a bien du mal à caractériser les morceaux de fruits et leur assemblage ainsi que les épaississants ! On peut aussi se demander si et quand les médias spécialisés seront en mesure de benchmarker les logiciels intégrant de l’IA dans leurs labos de tests.

Dans le prochain épisode, nous essaierons de nous y retrouver dans un panorama rapide des start-ups de l’IA. En nous demandant en particulier où sont ou seront les “nœuds de réseaux” ou les “plate-formes” de l’IA. Ces deux derniers épisodes seront publiés mi avril car d’ici-là, il y a pas mal d’actualité à couvrir : le Show Hello d’Orange, la sortie de la 20e édition du Guide des Start-ups et le compte-rendu d’un voyage entrepreneurial dans l’île de la Réunion !

____________________________________

Vous pouvez consulter tous les épisodes de ce roman fleuve de printemps sur l’intelligence artificielle :

Episode 1 : sémantique et questions clés

Episode 2 : histoire et technologies de l’intelligence artificielle

Episode 3 : IBM Watson et le marketing de l’intelligence artificielle

Episode 4 : les startups US de l’intelligence artificielle

Episode 5 : les startups acquises par les grands du numérique

Episode 6 : les startups françaises de l’intelligence artificielle

Episode 7 : la modélisation et la copie du cerveau

Episode 8 : évolutions de la loi de Moore et applications à l’intelligence artificielle

Episode 9 : la robotisation en marche des métiers

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Article très intéressant (comme d’habitude). je n’avais pas trouvé d’article si clair sur ce qu’est Watson.

(je croyais qu’il fallait un Watson pour expliquer Watson)

Article à lire d’O. @olivez sur les avancées de l’IA, avec un focus sur IBM Watson https://t.co/dUrkEG4BYW

Olivier,

Excellent 3ème volet – beaucoup de similarité avec la plateforme Big Data Search & Analytics de Sinequa.

Cdt,

-lf

série sur l’intelligence artificielle consacrée à IBM Watson et ses applications. https://t.co/ZIulNN2nuK

L’intelligence artificielle, on en est ou ? https://t.co/1t5CUl4yXU

#IA

“Les avancées de l’intelligence artificielle”, nouvelle partie pour mieux comprendre où on en est. https://t.co/jkCyHADEop

Olivier, bravo pour cette analyse très poussée (comme d’habitude). J’écris actuellement un article pour la Lettre Calipia sur le Machine Learning et je souhaiterai exploiter certaines de tes recherches sur l’IA (chapitre 1) en donnant bien sûr un lien vers ton blog.

En es tu d’accord ?

Bien cordialement

Pierre