L’intelligence artificielle fait partie de ces technologies qui peuvent générer toutes sortes de fantasmes pour les uns et de craintes pour les autres. Comme de nombreuses technologies, il nous est difficile d’en comprendre le fonctionnement et donc les enjeux associés.

L’actualité technologique nous ressasse des performances d’IBM Watson, des robots quadrupèdes ou bipèdes de la filiale de Google, Boston Dynamics, ou des dernières expérimentations de voitures à conduite automatique, chez Google ou ailleurs. Il est facile de mettre tout cela dans le même sac, sous l’appellation d’intelligence artificielle comme si c’était un tout bien unifié. Il n’en est rien !

L’intelligence artificielle est un pan entier de l’informatique avec sa diversité, ses briques technologiques, ses assemblages et solutions en tout genre. C’est un véritable écosystème hétéroclite. Qui plus est, la grande majorité des solutions commerciales d’Intelligence Artificielle sont faites de bric et de broc, en fonction de besoins très spécifiques. On est loin d’avoir des solutions d’IA génériques. Cette diversité bio-informatique génère pour l’instant une sorte de protection contre les menaces de l’IA évoquées par certains Cassandre de l’industrie.

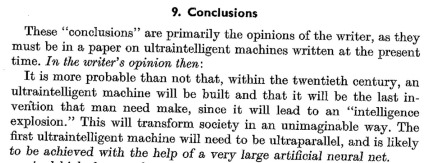

Ceux-ci redoutent une échéance fatidique où l’IA prendra le pas sur l’intelligence humaine. Le célèbre astrophysicien Stephen Hawking n’hésitait pas en 2014 à prophétiser que lorsque l’IA dépassera l’intelligence humaine, ce sera la dernière invention humaine, celle-ci ayant ensuite pris entièrement le pas sur l’espèce humaine ! Il reprend à son compte, en version pessimiste, une citation de Irwin John Good datant de 1965 publiée dans Speculations Concerning the First Ultraintelligent Machine selon laquelle la machine ultra-intelligente sera la dernière invention que l’homme aura besoin de créer.

Bill Joy avait publié “Why the future doesn’t need us” en 2000 dans Wired, tirant la sonnette d’alarme sur les dangers des progrès technologiques dans l’IA, les nanotechnologies et les biotechnologies. C’était bien avant la fin du premier séquençage complet du génome humain qui avait coûté une fortune. On y apprend d’ailleurs qu’il avait rencontré Jacques Attali et que ce dernier avait indirectement influé le cours des événements de Java ! Bill Joy était en fait effrayé des perspectives avancées par Ray Kurzweil qu’il avait rencontré dans une conférence en 1998 et avoir lu son “The age of spiritual machines”, paru six ans avant “The singularity is near”. Puis une grosse décennie de calme côté alertes. Bill Gates et Elon Musk ont repris le flambeau de Bill Joy en 2015 pour demander une pause technologique et une réflexion sur les limites à ne pas dépasser avec l’intelligence artificielle comme avec la robotique. Il existe même des instituts de recherche qui planchent sur cette question : le Center for the Study of Existential Risk de Cambridge et le Future of Humanity Institute d’Oxford.

Dans les optimistes, on trouve bien évidemment le pape actuel de la singularité Ray Kurzweil qui anticipe celle-ci autour de 2030-2014 ainsi que Mark Zuckerberg de Facebook qui pense que l’homme sera raisonnable dans ses usages de l’IA.

Seulement voilà, l’intelligence artificielle n’est pas un produit. Ce n’est pas non plus un logiciel unifié comme un traitement de texte, une application mobile ou même un système d’exploitation. Il n’y a pas de logiciel d’intelligence artificielle mais des solutions d’intelligence artificielle qui s’appuient sur des dizaines de briques différentes qui vont de la captation des sens, notamment audio et visuels, à l’interprétation des informations, au traitement du langage et à l’exploitation de grandes bases de données structurées ou non structurées. Leur intégration reste une affaire de bricolage. Nous en sommes encore à l’âge de la pierre, avec seulement une cinquantaine d’années de recul sur la question.

Dans la lignée d’autres séries d’articles de défrichages de sujets technologiques complexes de ce blog, je me propose ici de décortiquer ce que l’on sait de l’état de l’art de l’Intelligence Artificielle, de ses applications et des progrès en cours.

Je vais notamment tenter de répondre à plusieurs questions clés qui me travaillent :

- Quelles sont les grandes briques technologiques de l’intelligence artificielle ? C’est un domaine un peu fouillis que je vais essayer de segmenter.

- Quels sont les différents usages de l’intelligence artificielle ? Je vais reprendre les études de cas les plus courantes et les commenter.

- Comment les solutions d’intelligence artificielle sont-elles commercialisées, en prenant l’exemple d’IBM Watson ? En décrivant l’approche qui est actuellement à dominante service pour les solutions d’entreprises, mais avec un fort développement d’applications grand public en parallèle.

- Comment se développe l’écosystème de l’intelligence artificielle, des grands groupes comme Google, Facebook, Microsoft et IBM jusqu’aux start-ups du secteur ? Quels sont les enjeux industriels dans le secteur ? Et la position de la France ? Quel est le rôle de l’open source ?

- Comment les briques d’intelligence artificielle progressent-elles ? Est-ce lié à l’invention de nouveaux procédés techniques, aux progrès du matériel ou aux deux, et dans quelle proportion ? Qu’est-ce qui pourrait accélérer ou ralentir ces progrès ?

Comme d’habitude dans nombre des publications de ce blog, il s’agit ici du résultat d’une quête personnelle sur un sujet nouveau, s’appuyant en grande partie sur une recherche bibliographique extensive. Je ne suis pas spécialiste de ce domaine et j’apprends au fil de l’eau tout en partageant le résultat de cet apprentissage. Cette quête est publiée en 9 parties, et en suivant l’ordre des questions ci-dessus.

Vos feedbacks et suggestions sont les bienvenus, c’est l’avantage de la rédaction d’un texte en plusieurs parties !

Qu’est-ce que l’intelligence artificielle ?

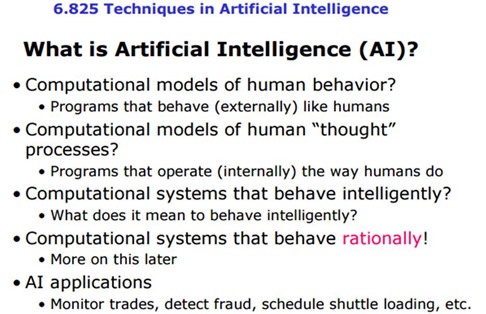

L’Intelligence Artificielle regroupe les sciences et technologies qui permettent d’imiter, d’étendre et/ou d’augmenter l’intelligence humaine avec des machines.

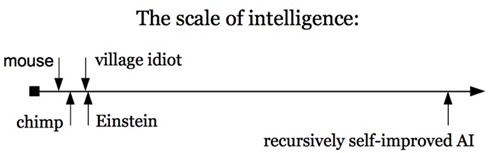

L’IA (AI en anglais) a été conceptualisée en 1956 par John McCarthy, Alan Newell, Arthur Samuel, Herbert Simon et Marvin Minsky, ce dernier étant décédé en janvier 2016. Cela s’appuyait comme toute innovation, progrès scientifique ou nouvelle théorie sur de nombreux travaux et visions antérieurs à 1956 (le concept de calculus ratiotinator de Leibnitz, la machine et le test de Turing, les neurones formels de McCullochs et Pitts, l’architecture de Von Neuman, le théorème de Shanon, etc). L’IA s’inscrit dans une longue tradition humaine d’innovations s’appuyant d’abord sur la force mécanique puis sur la force intellectuelle toutes deux artificielles. Certains scientifiques visent à atteindre dans un premier temps l’intelligence humaine. Mécaniquement, les effets de levier technologiques sont tels qu’un seuil aboutirait au dépassement rapide de l’intelligence humaine par celle de la machine.

L’IA fait partie de ce que l’on appelle aussi les sciences cognitives. IBM intègre ainsi Watson dans son offre de “cognitive computing”. J’ai cherché comment on pouvait la segmenter en domaines. En gros, on trouve d’abord ce qui concerne les sens et la capacité des ordinateurs à lire, voir et entendre, puis à structurer leur mémoire, à apprendre, à raisonner, puis à prendre des décisions ou à aider à prendre des décisions.

J’ai tenté ensuite de segmenter le domaine de l’IA et bien mal m’en a pris. Plusieurs découpages existent, au niveau conceptuel puis au niveau technique.

Au plus haut niveau conceptuel, on segmente l’IA en IA forte qui imiterait le cerveau humain avec une conscience et IA faible, qui évoluerait de manière incrémentale à partir d’outils plus élémentaires. La distinction entre IA forte et IA faible se retrouve dans cette classification de la portée de l’IA avec trois niveaux d’IA :

L’Artificial Narrow Intelligence (ANI) correspond à la capacité de traitement de problèmes dans un domaine précis. C’est l’état de l’art actuel. Cela a commencé avec les systèmes jouant et gagnant aux échecs comme Deep Blue d’IBM en 1997, puis avec des systèmes experts pointus comme dans certains secteurs de la santé.

On peut y mettre en vrac les moteurs de recherche courants, la détection de fraudes bancaires, le credit rating de particuliers, la conduite automatique ou assistée, Apple SIRI, Microsoft Cortana et Google Translate. Si l’IA n’imite pour l’instant pas toujours l’homme, la force brute et l’usage d’éléments techniques dont l’homme ne dispose pas comme la vitesse de traitement et le stockage de gros volumes de données permettent déjà à la machine de dépasser l’homme dans tout un tas de domaines ! Et dans d’autres dimensions que celles qui font que homme est l’homme. Par contre, ne font pas partie du champ de l’IA les problèmes simples qui peuvent être résolus avec de simples algorithmes. C’est le cas des systèmes de pilotage automatiques d’avions.

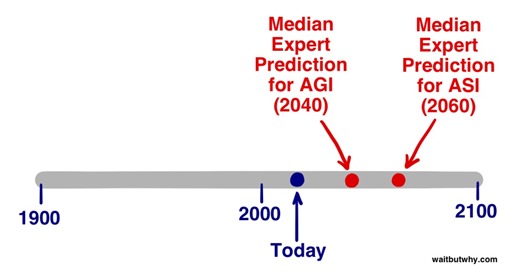

L’Artificial General Intelligence (AGI) correspond au niveau d’intelligence équivalent à celui de l’homme, avec un côté polyvalent, avec la capacité à raisonner, analyser des données et résoudre des problèmes variés. On peut intégrer dans ce niveau un grand nombre des capacités humaines : l’usage du langage à la fois comme émetteur et récepteur, l’usage de la vue et les autres sens, la mémoire et en particulier la mémoire associative, la pensée, le jugement et la prise de décisions, la résolution de problèmes multi-facettes, l’apprentissage par la lecture ou l’expérience, la création de concepts, la perception du monde et de soi-même, l’invention et la créativité, la capacité à réagir à l’imprévu dans un environnement complexe physique comme intellectuel ou encore la capacité d’anticipation. On peut y ajouter la capacité à ressentir des émotions personnelles ou sentir celle des autres (l’empathie), avoir des envies et des désirs et aussi savoir gérer ses pulsions et agir avec plus ou moins de rationalité. Cette liste est très longue ! Pour l’instant, on en est encore loin, même si certaines de ces capacités notamment linguistiques et de raisonnement général sont en train de voir le jour.

L’AGI dépend à la fois des progrès matériels et de notre compréhension toujours en devenir du fonctionnement du cerveau humain qui fait partie du vaste champ de la neurophysiologie, coiffant des domaines allant de la neurobiologie (pour les couches “basses”) à la neuropsychologie (pour les couches “hautes”). Le fonctionnement du cerveau apparait au gré des découvertes comme étant bien plus complexe et riche qu’imaginé. Les neurones seraient capables de stocker des informations analogiques et non pas binaires, ce qui en multiplierait la capacité de stockage de plusieurs ordres de grandeur par rapport à ce que l’on croyait jusqu’à il y a peu de temps. On sait par contre que le cerveau est à la fois ultra-massivement parallèle avec ses trillions de synapses reliant les neurones entre elles mais très lent (“clock” de 100 Hz maximum).

L’Artificial Super Intelligence (ASI) est la continuité logique de l’étape précédente, liée à la puissance des machines qui se démultiplie et se distribue plus facilement que celle d’un cerveau humain avec ses entrées-sorties et ses capacités de stockages et de traitement limitées. A ce niveau, l’intelligence de la machine dépasse celle de l’homme dans tous les domaines y compris dans la créativité et même dans l’agilité sociale. Le point de dépassement est une “singularité”. Il est évoqué dans de nombreux ouvrages comme le fameux The Singularity is Near de Ray Kurzweil. Il l’est également dans cet essai The Singularity – A philosophical analysis du philosophe australien David J. Chalmers qui propose notamment de tester d’abord l’ASI dans un environnement entièrement virtuel entièrement déconnecté du monde réel pour tester ses aptitudes. Si cela peut rassurer !

Dans la pratique, l’IA d’aujourd’hui va déjà bien au-delà des capacités humaines, notamment lorsque la mémoire est en jeu. La capacité des systèmes experts, et notamment d’IBM Watson, à brasser d’énormes volumes d’information fournit des capacités inaccessibles à n’importe quel humain, même surdoué. L’ASI correspond donc à un mélange des genres entre les domaines où l’homme est déjà dépassé et ceux où il ne l’est pas encore et le deviendra.

Vu du versant de l’optimisme, l’ASI aurait un impact indirect : l’immortalité de l’homme, conséquence des découvertes générées par l’ASI. C’est évidemment faire abstraction de ce qui ne peut pas encore se faire de manière entièrement numérique. Les progrès dans la santé sont contingentés par l’expérimentation qui se fait encore in-vivo et in-vitro. L’expérimentation in-silico – de manière entièrement virtuelle et numérique – des processus biologiques est un domaine en plein devenir. Il se heurte pour l’instant à des obstacles proches de l’insurmontable, même en intégrant les merveilles des exponentielles de progrès et de la loi de Moore. La recherche scientifique dans la santé en est donc toujours réduite à mener des expérimentations itératives et plutôt lentes, même avec les appareillages les plus modernes. Avec ou sans IA, cela reste immuable. D’ailleurs, les meilleures solutions d’IA comme l’usage d’IBM Watson dans la cancérologie s’appuient sur le corpus issu de toutes ces expérimentations. Il a une base physique et réelle. On pourra certainement automatiser l’expérimentation biologique encore plus qu’aujourd’hui dans la recherche de thérapeutiques, mais cela restera toujours du domaine du biologique, pas du numérique, donc plutôt lent et pas très scalable.

On arriverait au stade de l’AGI entre 2030 et 2100 selon les prévisions, et de l’ASI quelques décennies après. On se demande d’ailleurs ce qui expliquerait le délai entre les deux au vu du facteur d’accélération lié au matériel.

Poursuivons notre quête de la définition de l’IA dans un cours du MIT. L’IA serait un ensemble de techniques permettant d’imiter le comportement humain, agissant de manière rationnelle en fonction de faits et données et capables d’atteindre un objectif. La rationalité n’est pas l’omniscience mais la capacité à agir en fonction des informations disponibles, y compris celles qui sont ambigües. Cette rationalité est habituellement limitée par notre volonté et notre capacité d’optimisation.

Autre découpage, plus fin, de l’IA, en trois domaines : le symbolisme qui se focalise sur la pensée abstraite, le connectionisme qui se focalise sur la perception, dont la vision, la reconnaissance des formes et qui s’appuie notamment sur les réseaux neuronaux artificiels et enfin, le comportementalisme qui s’intéresse aux pensées subjectives de la perception. C’est dans ce dernier domaine que l’on peut intégrer l’informatique affective (affective computing) qui étudie les moyens de reconnaitre, exprimer, synthétiser et modéliser les émotions humaines. C’est une capacité qu’IBM Watson est censé apporter au robot Pepper d’Aldebaran / Softbank.

L’IA peut notamment servir à automatiser des processus cognitifs et en s’appuyant sur quatre étapes : l’observation des faits et données, leur interprétation, leur évaluation et la décision, avec une action ou une proposition d’actions, souvent basée sur des statistiques.

On parle aussi d’intelligence symbolique et d’intelligence computationnelle. La première résout les problèmes avec de la connaissance (c’est le domaine actuel de l’IA et du machine learning), la seconde avec des données issues d’exemples et de l’apprentissage. Ce dernier domaine intègre notamment les réseaux neuronaux, la logique floue et les algorithmes génétiques.

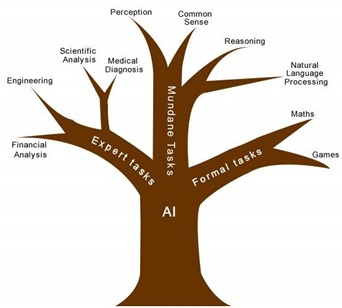

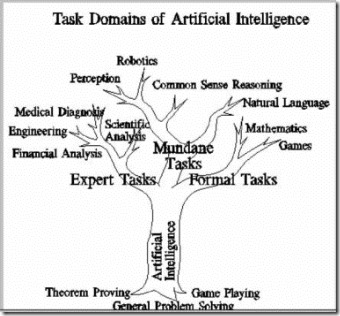

Voici encore un autre découpage : celui de l’arbre avec trois grandes branches : l’une pour les tâches d’expertise, la seconde pour les tâches courantes (perception, sens commun, raisonnement, langage) et la troisième pour les tâches formelles (mathématiques, jeux). Mais cela ne décrit pas les briques technologiques associées pour autant.

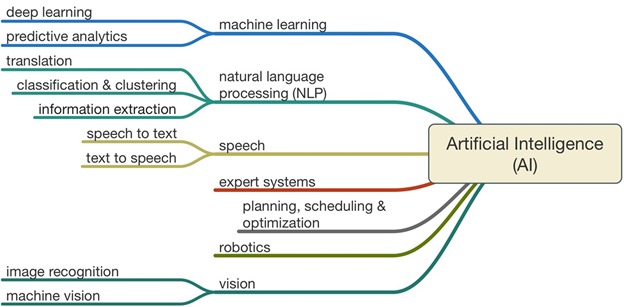

Cet autre découpage, plus terre à terre, comprend le machine learning, le traitement du langage, les systèmes experts, la robotique et la vision. L’architecture est moyenne : il serait plus logique de regrouper les sens avec la parole et la vision. Sans compter l’ouïe qui peut aussi servir. Quand à la robotique, elle a vocation à intégrer tous les autres champs du schéma et à en ajouter d’autres qui lui sont spécifiques comme ceux des capteurs, des matériaux, de la mécanique, des moteurs électriques et des batteries.

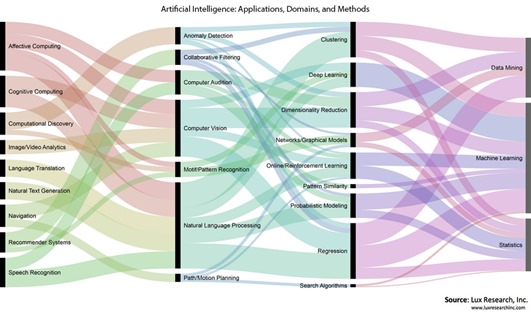

Enfin, ce dernier schéma fait un lien formel entre trois groupes : les applications (affective computing, reconnaissance d’images et vidéos, traduction, …), les domaines d’applications (computer vision, NLP, …) et les méthodes (avec trois grandes catégories : le data mining, le machine learning et les statistiques). Bien bien, mais on peut aussi faire du data mining grâce à du machine learning et ce dernier peut aussi s’appuyer sur des statistiques. Tout cela est bien récursif !

Cela rappelle à bon escient que les solutions à base d’IA ne sont pas “des logiciels” mais l’assemblage de diverses briques logicielles selon les besoins. Et ces briques sont des plus nombreuses. A tel point que leur intégration est un enjeu technique et métier de taille, peut-être le plus complexe à relever. Aymeric Poulain Maybant m’a transmis sa thèse de doctorat sur l’hybridation en sciences cognitives qui date de 2005 et décrit très bien cet enjeu. L’IA intégrative est un des principaux facteurs de développement du secteur. On le retrouve dans l’association de nombreuses techniques dans les solutions d’IA comme le couplage de réseaux neuronaux et d’approches statistiques, notamment dans la reconnaissance de la parole.

Si on demandait à un système d’Intelligence Artificielle de s’auto-définir et s’auto-segmenter en exploitant les données bibliographiques disponibles, il serait bien mal en point ! Un peu comme il est difficile de caractériser une période contemporaine, sans le regard de l’historien du futur qui pourra prendre du recul pour analyser le présent.

Vous êtes déjà paumés ? Moi aussi ! Dans la partie suivante, je vais rentrer dans les couches basses de l’IA et inventorier les principaux outils logiciels qui la composent.

____________________________________

Vous pouvez consulter tous les épisodes de ce roman fleuve de printemps sur l’intelligence artificielle :

Episode 1 : sémantique et questions clés

Episode 2 : histoire et technologies de l’intelligence artificielle

Episode 3 : IBM Watson et le marketing de l’intelligence artificielle

Episode 4 : les startups US de l’intelligence artificielle

Episode 5 : les startups acquises par les grands du numérique

Episode 6 : les startups françaises de l’intelligence artificielle

Episode 7 : la modélisation et la copie du cerveau

Episode 8 : évolutions de la loi de Moore et applications à l’intelligence artificielle

Episode 9 : la robotisation en marche des métiers

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Bon démarrage. J’aurai personellement placé le travail de McCullochs et Pitts de 1943 comme la premiere pierre à l’édifice. Leurs principes de réseaux de neurones – qui étaient déjà erronés si l’on considère les travaux de Helmholtz presque 100 ans plus tôt – sont toujours la base des cours d’IA dans le monde entier.

Merci. Je les ajoute dans les antériorités du concept de l’IA et vais m’intéresser aux réseaux neuronaux dans la seconde partie.

You are welcome. Le titre exact de leur article: “A logical calculus of the idea immanent in nervous activity”. Les concepts introduits ont la vie dure, et persistent tant en IA qu’en neuroscience, malgré leur inadéquation avec les résultats expérimentaux. C’est un dogme. Vous pouvez me contacter offline.

Qui a peur de l’Intelligence Artificielle ?

http://www.latribune.fr/opinions/tribunes/qui-a-peur-de-l-intelligence-artificielle-554890.html

Agreed. On a trop tendance à identifier les métiers qui disparaissent et à ne pas imaginer ceux qui peuvent apparaître !

L’article cité démontre que les hypothèses de Kurtzweil ne sont pas faciles à démonter: les 3 points avancés à propos de la capacité de calcul du cerveau humain sont pour le moins approximatifs.

1) Les connections sont importantes, nonobstant aucune théorie n’a pour le moment permis de rendre compte des observations déjà obtenues, ni de prédire -soit un comportement à partir d’un connectome, soit la structure d’un connectome à partir de comportements connus-, ni d’expliquer les mécanismes en jeu. Des vraies théories: aucune. Des hypothèses non prouvées: pléthore! “It was shown..”? Yeah right. Passez, il n’y a rien à voir.

2) et 3) “Neurons learn”. Wow. Je pense que l’auteur a vulgarisé le concept de plasticity à la limite de l’utile. Il y a d’autres hypothèses: les synapses apprennent et sont entièrement responsables de la mémoire; les gènes sont responsables de la mémoire… Ce sont des hypothèses de travail corroborées par des observations, mais l’élément prédictif est manquant. Une certaine dose de circonspection est donc requise, d’autant plus qu’il est important d’appréhender les concepts “apprentissage” et “mémoire” avec les connotations spécifiques relatives au domaine spécifique de chaque auteur. L’auteur du blog n’est pas tout terrain, et encore une fois il ne démontre rien.

Le presse-purée psychologico-biologique qui constitue la plus grosse partie de l’article ne justifie aucunement la juxtaposition entre deep-learning/GPU et cerveau humain, et encore moins une comparaison.

Il a aussi laissé de côté une intéressante observation biologique que voici. Le système cardiaque de la sangsue médicinale est régulé par une poignée de neurones bien identifiés, qui produisent un rythme cardiaque très spécifique et identifiable. Les électrophysiologistes (planteurs d’électrodes chez les Minimoys) ont noté que les caractéristiques des neurones en question varient allègrement par un facteur 5 d’un individu à l’autre, sans que le rythme cardiaque diffère entre individus. Ils appellent ça “animal-to-animal” variability. Ce phénomène est présent dans tout un tas d’espèces animales dans une variété de systèmes.

En quoi est-ce relevant quand on discute IA? La réponse est évidente pour les familiers des réseaux de neurones et du deep learning: l’output des réseaux de neurones de l’IA n’est pas immune quand on modifie une quantité aléatoire de “poids synaptiques” (pouffons à l’outrecuidance du terme) par des facteurs aléatoires dans [1, 5].

Ceci prouve que les réseaux de neurones actuels de l’IA, ce qui inclut le deep learning, ne peuvent pas être pris comme modèles du système nerveux ou du cerveau. Il suffit de comprendre comment la théorie des SVMs se décline sur un perceptron, pour intuiter le résultat d’une généralisation “par partie” à n’importe quel réseau de neurones.

De la même manière, les réseaux de neurones n’apprennent pas et ils ne reconnaissent pas: ils sont configurés pour des tâches de classification ou de regression, et les résultats sont extrapolés dans le même domaine. Point. Rien à voir avec de la mémoire ou de l’apprentissage tels que définis en biologie ou psychologie. Les seules comparaisons qui existent naissent dans l’esprit des gens qui ne grattent pas plus loin que le vernis, ou des marketeurs de NVidia. Faut les comprendre: c’est pas facile de vendre des CPUs…

Mes excuses. C’est la réponse [3] que je visais.

Bonjour Olivier,

Sur les réseaux de neurones et leur futur, si tu ne l’as pas déjà lu, un lien intéressant

http://timdettmers.com/2015/07/27/brain-vs-deep-learning-singularity/

cdlt

Très intéressant, merci ! Il remet bien les pendules à l’heure sur les visions approximatives de Ray Kurzweil et consorts.

C’est l’un des articles de blog les plus longs que j’ai jamais vu ! D’ailleurs, il date de juillet 2015 et il n’a toujours pas publié la seconde partie annoncée. Il a d’autres papiers intéressants sur le deep learning avec les GPU que je cherchais pour ma seconde partie !

Excellent article d’ @olivez sur les avancées de l’intelligence artificielle. Good job @olivez https://t.co/RKNX5dc5Yi #IA #AI

Bravo à @olivez pour la première partie d’une série d’article sur les intelligences artificielles https://t.co/ljGmp70iOY #IA

#IA a lire “Les avancées de l’intelligence artificielle – 1” de @olivez sur https://t.co/DidiCm6qVm

Les avancées de l’intelligence artificielle – 1er article de la série https://t.co/TtgTYvAYpF

“Les avancées de l’intelligence artificielle – 1” vraiment intéressant, hâte de lire la suite https://t.co/Wfw6FK82Bl

Pas besoin dêtre intelligent artificiellement 🙂 pour lire Les avancées de l’intelligence artificielle 1 de @olivez https://t.co/kqa4XHsQtG

Vous avez épuisé vos séries sur Netflix ?

Suivez celle d’@olivez : Les avancées de l’intelligence artificielle

https://t.co/57RUVI1xhx

L’intelligence naturelle de @olivez a rédigé cet excellent papier sur l’intelligence artificielle.https://t.co/svp8cdrWZY

Excellent état de l’art sur l’Intelligence Artificielle par @olivez – une bonne lecture pour le WE !

https://t.co/x5oNV5zbwi

Série d’articles sur les avancées de l’intelligence artificielle par @olivez https://t.co/Ua9EZqTfst #IA

Blog très riche et complet sur l’Intelligence Artificielle (7 articles) à découvrir !https://t.co/vZTgDB6d7L

#Avenir https://t.co/WIj3rEE2Tg

Les avancées de l’intelligence artificielle – 9 articles par @Olivez https://t.co/xjyXmJcPNR https://t.co/QK6c8NhKz5