Le jour même où je publiais l’édition 2019 de l’ebook Comprendre l’informatique quantique (504 pages), un rapport de recherche était éventé temporairement sur le site de la NASA selon lequel Google aurait atteint la suprématie quantique. Il était d’abord repéré par le Financial Times. J’évoquais bien cette échéance et sa signification dans l’ebook, mais sans date précise. Je me suis alors empressé de mettre à jour l’ebook pour intégrer cette nouvelle significative.

Pour mémoire, on atteint la suprématie quantique avec un ordinateur quantique lorsque celui-ci est capable d’exécuter un algorithme donné (pas tous…) qu’il est impossible de faire tourner avec son équivalent classique dans un temps d’échelle humaine sur les supercalculateurs les plus puissants du monde. L’expression de suprématie quantique a été lancée en 2011 par John Preskill, qui œuvre à l’Université CalTech aux USA.

La notion d’avantage quantique correspond au cas où la vitesse d’exécution est plus rapide qu’un équivalent classique sur un supercalculateur mais où ce dernier peut se faire à une échelle humaine, soit au pire en quelques semaines. On peut aussi parler d’avantage énergétique lorsqu’un calculateur quantique consomme beaucoup moins d’énergie qu’un supercalculateur pour résoudre le même problème.

En 2018, on pouvait anticiper que l’atteinte de la suprématie quantique alimenterait tout un tas de fantasmes. Cela n’a pas manqué de se produire, au moins au niveau de la titraille dans les médias. Nous avons ainsi Google aurait fabriqué l’ordinateur quantique le plus puissant au monde sur Tom’s Guide (une traduction) qui cohabite avec le plus raisonnable Qu’est-ce que la “suprématie quantique”, que Google prétend maîtriser ? dans l’Express. J’en connais qui vont aussi en profiter pour affirmer haut et fort que cela signe une fois encore la supériorité des GAFA et que l’on n’y coupera pas, que l’Europe et la France sont foutues (disclaimer : non !).

On peut lire dans Tom’s Guide que “le processeur de leur machine aurait été capable d’effectuer un calcul mathématique en 3 minutes et 20 secondes que les ordinateurs les plus performants du monde auraient mis 10 000 ans à résoudre”. C’est vrai, mais pas sur “un calcul quelconque”. Vu comme cela, c’est extraordinaire et révolutionnaire à court terme. Nous allons voir qu’il en va tout autrement lorsque l’on creuse la question.

Les circonstances de la publication de cette nouvelle sont faites pour faire gamberger. En effet, le papier avait été publié trop tôt par inadvertance par la NASA et avait été immédiatement retiré du site de la NASA. Entre samedi 21 et dimanche 22 septembre 2019, des spécialistes arrivaient à remettre la main sur la page du rapport en cache sur le web, mais sans les illustrations, puis enfin, sur le PDF complet. Voilà enfin de quoi juger sur pièces ! Il existe même un document complémentaire avec encore plus de détails sur 58 pages, notamment sur l’ingénierie du système utilisé. Ces documents ont été créés par les équipes de John Martinis chez Google, accompagnées de celles de Caltech, Amherst, Urbana-Champaign et UCSB (USA), de la NASA, du laboratoire Oak Ridge du Département de l’Energie US et enfin du Jülich Computer Center et de l’Université d’Erlangen-Nurenberg (Allemagne),

Au même moment, vendredi 20 septembre, IBM annonçait lancer dans le cloud en octobre un ordinateur quantique de 53 qubits. Voir IBM preps 53 qubits quantum computer for launch in October, ExtremeTech, 20 septembre 2019. Comme c’est aussi du supraconducteur transmon (un des trois types de qubits supraconducteurs, explication dans mon ebook), IBM et Google sont à couteaux tirés avec des technologies assez voisines, même s’il doit y avoir des différences dans les détails. Est-ce que Google a manœuvré pour gratter la politesse à IBM ? Pas forcément, dans la mesure où la communication d’IBM ne fait nullement allusion à une quelconque suprématie quantique. IBM est généralement bien moins exubérant que Google dans sa communication sur le calcul quantique.

Le papier de 12 pages est à l’image des publications scientifiques sur le quantique : complètement incompréhensible pour les humains non spécialistes du sujet. Ayant potassé le quantique sous toutes les coutures depuis deux ans, j’ai pu en saisir environ 70%, ce qui est déjà pas mal. Le jargon du papier est tellement hétéroclite que cela me fait marrer. Je ris jaune car j’ai dû compulser des paquets de documents pour comprendre à quoi cela rimait, aussi bien sur la partie physique, électronique, informatique, cryogénique qu’algorithmique, et ce depuis 2 ans.

Voici ce que j’ai pu en tirer…

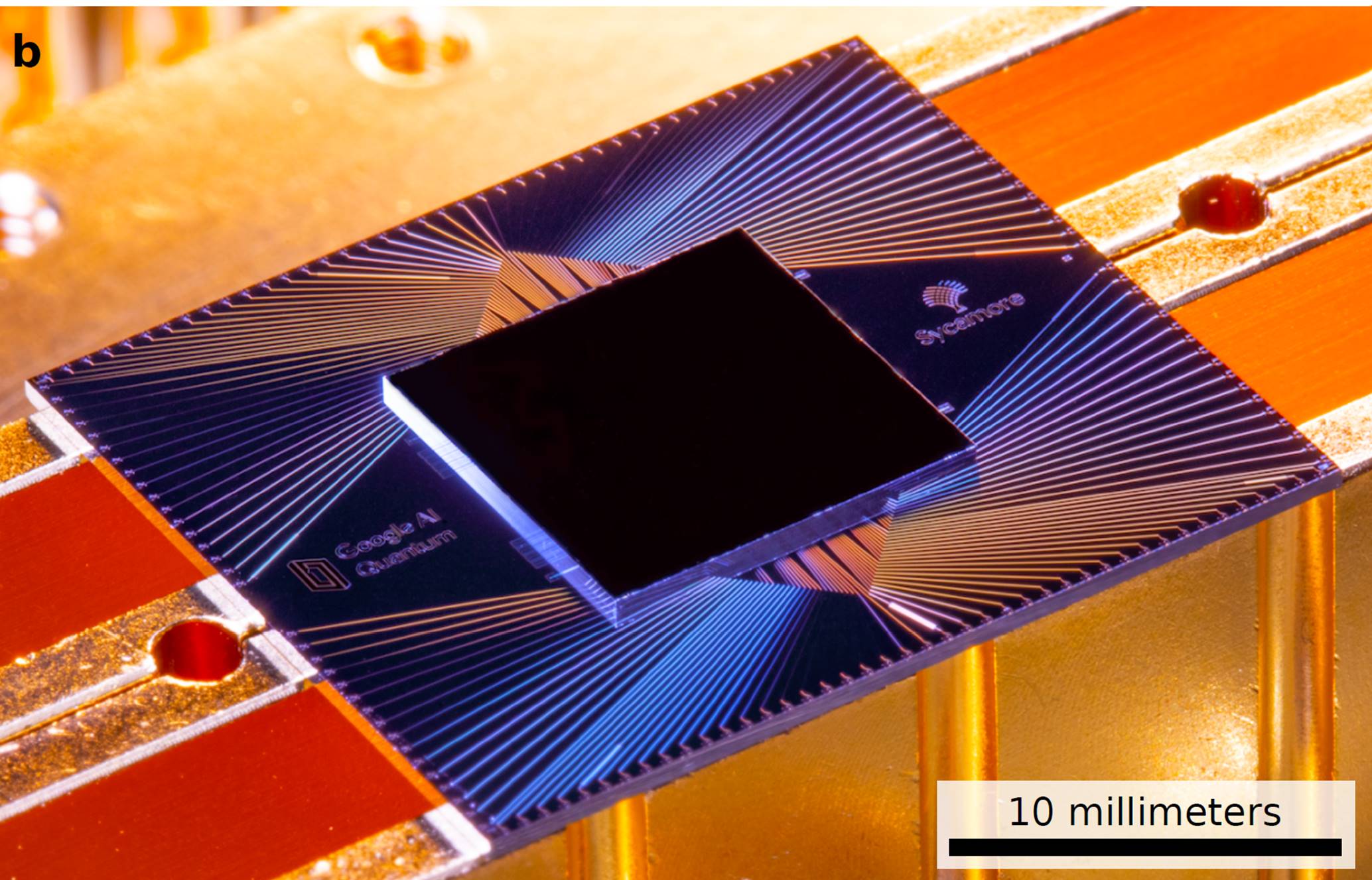

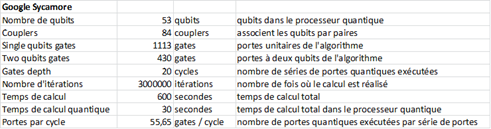

Le processeur quantique de 53 qubits de Google

Le processeur quantique de Google utilisé dans l’expérience est baptisé Sycamore. Il comprend 53 qubits en technologie supraconducteur dite “transmon”. Au départ, il devait faire 54 qubits, mais l’un d’entre eux, au bord, ne fonctionnait pas et ils l’ont désactivé ! Ca fait un peu bricolage… ! Les qubits sont disposés en treillis dans une architecture 2D très classique pour ce genre de qubits. C’est ce qui explique qu’IBM ait aussi un chipset de 53 qubits (modulo celui qui plante).

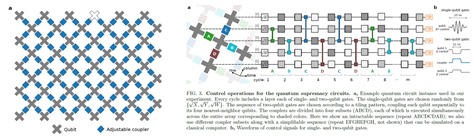

Les qubits sont reliés à quatre voisins via des coupleurs qui permettent de mettre en œuvre la fameuse intrication. Le papier de Google/NASA décrit très bien les mécanismes électroniques de contrôle des qubits, des portes et de la mesure de leur état. Ils ont notamment amélioré les coupleurs qui gèrent l’intrication entre qubits voisins en remplaçant les habituelles inductances par des capacités. Cela leur a permis de créer des portes quantiques à deux qubits très rapides et générant peu de bruit.

En mars 2018, Google avait annoncé avoir réalisé un processeur bien plus puissant comprenant 72 qubits l’année dernière, dénommé Bristlecone. Mais depuis, peu d’informations circulaient sur ce processeur. Google devait avoir probablement du mal à le faire fonctionner avec un taux d’erreurs acceptable. Le processeur Sycamore a l’air de comprendre quelques avancées technologiques par rapport à son compère de 72 qubits. Comme il a moins de qubits, il est cependant moins puissant. La technologie des qubits supraconducteurs domine les acteurs d’aujourd’hui avec Google, IBM et Rigetti (USA) mais ces différents acteurs rencontrent d’énormes difficultés à dépasser 50 qubits dits “stables”. Rigetti a annoncé en août 2018 mettre au point un processeur quantique supraconducteur à 128 qubits, qui serait donc des gazillions de fois plus puissant que le Sycamore de Google, mais on n’a pas de nouvelles de sa part depuis un an.

En gros, donc, Sycamore est une sorte de régression par rapport à la puce Bristlecone de 72 qubits. Intel avait aussi annoncé en 2018 avoir fabriqué 1500 qubits en qubits CMOS, ce qui est énorme. Mais ils sont restés à l’état de puce non fonctionnelle en l’état. Il faut donc toujours prendre avec des pincettes les annonces de fournisseurs et de laboratoires qui annoncent des processeurs à N qubits. Tant qu’ils ne sont pas testés et benchmarkés avec des algorithmes précis et avec une documentation comme celle de Google et de la NASA sur Sycamore, il faut rester prudent.

Le fait que Google se limite à 53 qubits illustre les limites actuelles de la technologie des supraconducteurs. Google semble cependant avoir fait quelques progrès, notamment pour multiplexer les signaux micro-ondes qui circulent entre l’extérieur et l’intérieur de l’ordinateur.

D’autres bossent sur des technologies qui pourraient mieux scaler au-delà de 50 qubits, comme IonQ (plus de 100 annoncés, mais pas encore benchmarkés), les atomes froids, l’optique linéaire et les qubits CMOS. Malgré le boucan généré par Google et IBM, les autres technologies ont encore du mou sous la pédale.

Si l’Histoire se répète, la technologie de Google et IBM pourrait même ressembler aux mémoires à tores magnétiques des années 50/60 qui ont été ensuite remplacées par la RAM en silicium : une technologie intermédiaire avant celle qui décoiffe vraiment.

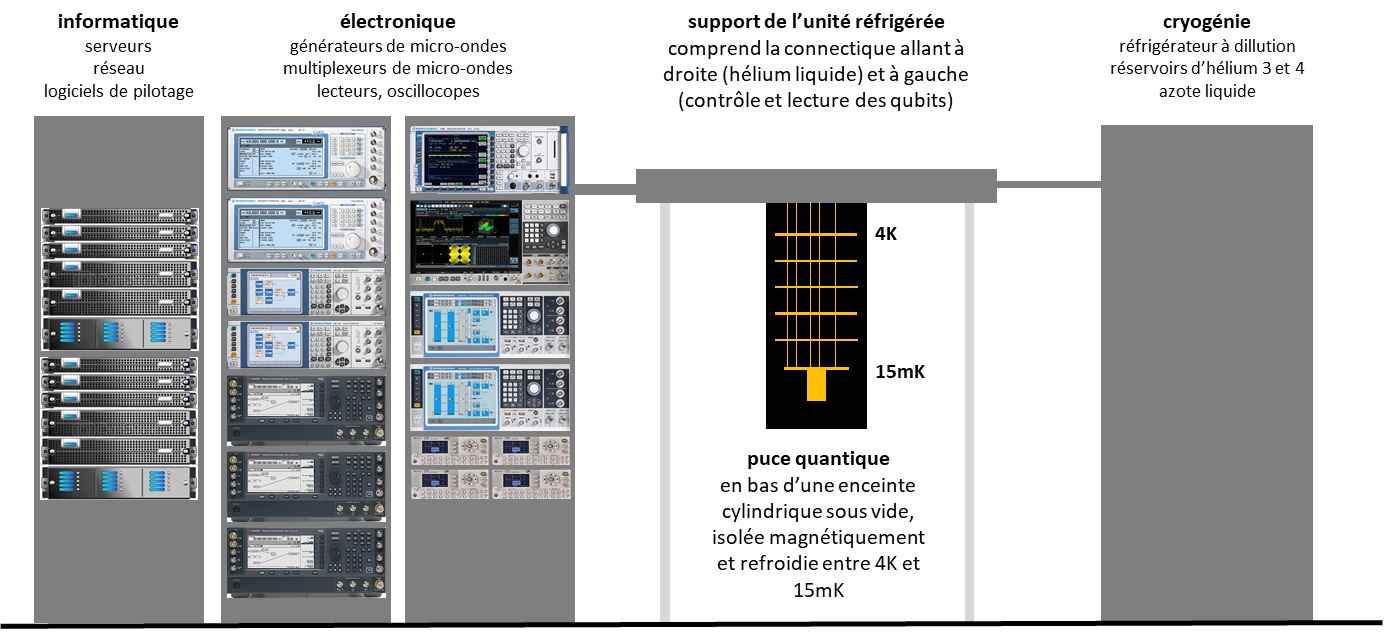

A quoi ressemble l’ordinateur quantique de Google ? Aucune photo n’a pour l’instant circulé, mais il ressemble probablement au schéma maison suivant. Il comprend au minimum deux à quatre racks de datacenters avec une partie qui est remplie d’électronique avec des générateurs de micro-ondes (5 à 7 GHz pour Google), de multiplexeurs, de convertisseurs divers et d’outils de mesure.

Ces instruments sont reliés au processeur qui est situé au bas d’un truc qui ressemble à un chandelier et qui pendouille en l’air. Le processeur en soi est petit et tout plat, faisant quelques cm2 comme indiqué ci-dessous.

Dans le “chandelier” se situent des composants d’électronique de pilotage et de contrôle des qubits et notamment des préamplificateurs de contrôle et de lecture de leur état, le reste de l’amplification étant réalisé à température ambiante. Le schéma ci-dessus explique cela.

Il est placé dans un cylindre qui est sous vide, isolé magnétiquement et refroidi à très basse température. Le refroidissement se fait par étages, le plus haut étant à 4K (-269°C) et le plus bas, au niveau du chipset de qubits, étant à 15 mK. C’est très très froid ! Il faut 24h pour mettre l’intérieur à cette température et généralement des semaines de calibrage pour tout stabiliser. Google indique en fait que l’isolation magnétique principale est faite au niveau du packaging du chipset, via des enveloppes en métal associant de l’aluminium et un blindage en alliage nickel-fer (mu-metal).

Le système de cryogénie utilise un réfrigérateur à dilution qui fait circuler un mélange d’hélium 3 et 4 liquide (3 et 4 sont des valeurs d’isotopes de l’hélium). Tout ceci occupe une pièce qui fait en général environ 20 à 40 m2. Ce qui est raisonnable par rapport aux 500m2 du supercalculateur IBM Summit qui a servi à faire la comparaison avec Sycamore. L’exemple ci-dessous est issu d’IBM.

Par comparaison, voici à quoi ressemble le supercalculateur IBM Summit qui a servi à faire la comparaison. La bébête comprend plus de 35 000 processeurs dont les fameux GPU V100 de Nvidia. L’ensemble consomme 12 MW, occupe 500 m2 et pèse 349 tonnes, hors système de climatisation. En comparaison un ordinateur quantique supraconducteur ne pèse qu’à peine une à deux tonnes. Et encore, c’est avant tout effort de miniaturisation et de packaging. L’autre référence que l’on a est D-Wave avec ses ordinateurs à recuit quantique, une technique différente, qui tient dans quelques mètres cubes.

L’algorithme utilisé pour les tests

Là, cela devient plus compliqué pour moi. En gros, c’est un algorithme qui associe un générateur quantique de nombres aléatoires et d’un système qui permet de vérifier que les nombres générés sont bien aléatoires, avec donc une répartition homogène. Cette dernière partie scanne toutes les valeurs possibles (253) de superposition des qubits.

On peut en trouver l’explication suivante dans Quantum Supremacy Is Coming: Here’s What You Should Know de Kevin Harnett dans QuantaMagazine , juillet 2019 (donc, avant l’information sur Google).

“A simple example of a random sampling problem is a program that simulates the roll of a fair die. Such a program runs correctly when it properly samples from the possible outcomes, producing each of the six numbers on the die one-sixth of the time as you run the program repeatedly.

In place of a die, this candidate problem for quantum supremacy asks a computer to correctly sample from the possible outputs of a random quantum circuit, which is like a series of actions that can be performed on a set of quantum bits, or qubits. Let’s consider a circuit that acts on 50 qubits. As the qubits go through the circuit, the states of the qubits become intertwined, or entangled, in what’s called a quantum superposition. As a result, at the end of the circuit, the 50 qubits are in a superposition of 250 possible states. If you measure the qubits, the sea of 250 possibilities collapses into a single string of 50 bits. This is like rolling a die, except instead of six possibilities you have 250, or 1 quadrillion, and not all of the possibilities are equally likely to occur.

Quantum computers, which can exploit purely quantum features such as superpositions and entanglement, should be able to efficiently produce a series of samples from this random circuit that follow the correct distribution. For classical computers, however, there’s no known fast algorithm for generating these samples — so as the range of possible samples increases, classical computers quickly get overwhelmed by the task”.

Le domaine d’application de cet algorithme serait de permettre de générer des nombres aléatoires certifiés. Sachant que cela existe déjà pour moins cher avec les générateurs de nombres aléatoires quantiques, comme ceux du Suisse IDQ. Mais l’algorithme testé aurait bien d’autres usages pratiques.

Cet algorithme présente plusieurs caractéristiques qui expliquent son choix :

- Il utilise la superposition sur l’ensemble des qubits utilisés (53), ce qui permet d’obtenir une performance maximale au niveau exponentialité de la puissance de calcul. Dans une bonne part des algorithmes quantiques, tous les qubits ne sont pas utilisables pour de la superposition. On doit mettre de côté des qubits qui servent de valeurs auxiliaires (ancilae) ou tampon. Résultat, l’avantage exponentiel diminue d’autant. Un tel algorithme ne pourrait donc pas bénéficier de la superposition de 253 états mais par exemple tomber à 230 états, où l’avantage quantique serait moins fort.

- Il utilise une profondeur de 20 portes quantiques. A savoir que l’algorithme testé à pleine charge n’enchaîne qu’une suite de 20 blocs de portes quantiques exécutées simultanément sur les qubits qui sont physiquement statiques dans leur circui. C’est lié au bruit généré dans les qubits qui limite cette profondeur. De nombreux algorithmes nécessitent un plus grand nombre de portes quantiques, notamment celui de la factorisation de nombres entiers de Shor. Malgré tout, on peut exécuter un grand nombre d’algorithmes utiles avec cette profondeur de portes. Cela ouvre des portes sur des usages pratiques comme dans la simulation chimique.

- L’algorithme a l’air d’être de ce point de vue-là voisin de celui de Deutsch-Josza qui sert à tester si une fonction est équilibrée ou pas (est-ce qu’elle envoie toujours 0 ou 1 ou des 0 et des 1 à parts égales, sachant que c’est l’hypothèse de départ de la fonction). Ce dernier permet de passer d’un temps de classique exponentiel à un temps de calcul fixe. En langage de la complexité, on écrit cela O(2N-1)->O(1). Mais il ne sert pas à grand-chose. L’avantage est que le nombre de portes est fixe et limité, ce qui permet d’éviter le bruit généré par la séquence de portes.

- L’algorithme n’a visiblement pas besoin d’exploiter des codes de corrections d’erreurs qui consomment de nombreuses portes quantiques ainsi qu’un nombre de qubits plus grand de plusieurs ordres de grandeur (x100 à x10000).

Voici les données clés du benchmark que j’ai pu consolider à partir de l’article :

Google utilise sinon la méthode dénommée XEB pour Cross Entropy Benchmarking qui leur sert à calibrer les portes quantiques de leur chipset dans le contexte de l’algorithme utilisé de circuit quantique alératoire (random quantum circuits).

Voir ce fil de discussion US sur Twitter qui commente la performance, avec beaucoup de grains de sel. Avec une vidéo sur la suprématie. J’ai au passage découvert le compte @QuantumBullshit qui indique si une publication scientifique est bullshit ou pas. Marrant.

Enfin, l’algorithmologue quantique Scott Aaronson a publié une FAQ sur la performance de Google qui ne contredit pas tout ce qui est au-dessus (je suis sauf…) : Scott’s Supreme Quantum Supremacy FAQ!.

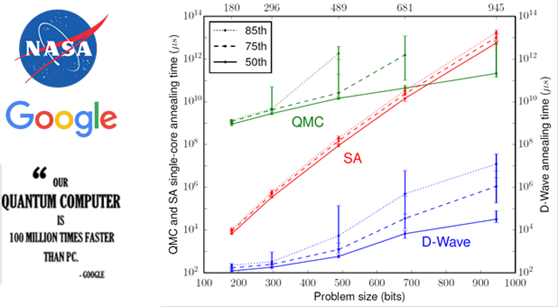

Google et D-Wave

L’épisode récent en rappelle un autre qui date de fin 2015, où Google et la NASA avaient annoncé avoir résolu avec un ordinateur à recuit quantique de D-Wave un problème 100 millions de fois plus rapidement qu’un PC. La comparaison de l’époque n’était pas faite avec un supercalculateur. Qui plus est, quelques mois plus tard, des chercheurs présentaient un algorithme fonctionnant sur ordinateur classique générant la même performance (mais… je ne le retrouve plus).

Il s’agissait de la résolution d’un problème d’optimisation et de combinatoire dans un graphe dont l’algorithme avait été conçu en 1994. Voir Google’s D-Wave 2X Quantum Computer 100 Million Times Faster Than Regular Computer Chip par Alyssa Navarro dans Tech Times, novembre 2015. Et documentée dans What is the Computational Value of Finite Range Tunneling (17 pages).

Les éléments de comparaison portaient sur deux algorithmes leur étant destiné : le “simulated annealing”, simulant l’ordinateur D-Wave sur ordinateurs classiques et une QMC (Quantum Monte Carlo) optimisée pour ordinateur traditionnel, et qui donne de meilleurs résultats en termes de montée en puissance que l’émulation du quantique sur HPC. Les critiques ont été nombreuses sur cette performance. Comme dans Temperature scaling law for quantum annealing optimizers, 2017 (13 pages), qui pointe les limitations du recuit quantique.

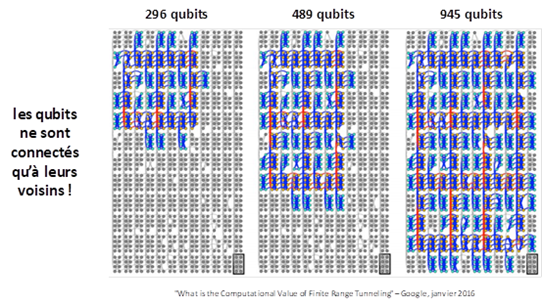

Le layout physique de qubits utilisé pour résoudre ce problème exploitait respectivement 296, 489 et 945 qubits, comme illustré ci-dessous.

Sachant que l’ordinateur le plus récent de D-Wave comprend 2048 qubits. Pour autant, il n’a pas encore permis d’atteindre la suprématie quantique. Pourquoi donc ? Parce qu’il ne s’agit pas des mêmes qubits que ceux de Google et IBM. Pour faire simple et de manière très approximative, 100 qubits de D-Wave équivalent à 1 qubit supraconducteur de Google ou IBM. Pas assez pour exploser l’IBM Summit sur un algorithme donné.

En pratique, la notion de suprématie quantique s’attaque à une cible mouvante : le best-in-class des algorithmes destinés à des supercalculateurs. Ceux-ci s’améliorent aussi régulièrement. Ainsi début septembre, les chercheurs d’Alibaba annonçaient avoir réussi à simuler le même algorithme que celui de Google sur un ensemble de serveurs dans le cloud. Voir Alibaba Cloud Quantum Development Platform Large-Scale Classical Simulation of Quantum Circuits, septembre 2019 (5 pages).

Par le passé, une jeune développeuse de 18 ans, Ewin Tang, avait fait un peu de même en juillet 2018, en publiant un papier démontrant un algorithme de recommandation classique aussi performant qu’un algorithme conçu pour les ordinateurs quantiques de D-Wave et conçu notamment par Iordanis Kerenidis en France. Voir A quantum-inspired classical algorithm for recommendation systems, Ewin Tang, juillet 2018 (32 pages) et Major Quantum Computing Advance Made Obsolete by Teenager par Kevin Harnett, juillet 2018.

Les interprétations à côté de la plaque

La suprématie quantique de Google va générer plein d’erreurs d’interprétation. Certains vont croire que, ça y est, les ordinateurs quantiques vont remplacer les supercalculateurs. Sans se rendre compte que cela ne concerne qu’un algorithme très précis. Même avec des ordinateurs quantiques de milliers de qubits, ceux-ci ne remplaceront pas les supercalculateurs pour des tas de calculs.

Autre exemple, exagéré, vu dans BREAKING: NO MORE SECRETS – Google achieves “quantum supremacy” that will soon render all cryptocurrency breakable, all military secrets revealed de Mike Adams dans Natural News, un site ésotérico-conspirationniste US. Il y est écrit : “Bitcoin’s transactions are currently protected by 256-bit encryption. Once Google scales its quantum computing to 256 qubits, it’s over for Bitcoin (and all 256-bit crypto), since Google (or anyone with the technology) could easily break the encryption protecting all crypto transactions, then redirect all such transactions to its own wallet”. C’est évidemment faux. Les algorithmes quantiques de factorisation de nombres entiers utiles dans la cryptographie ont besoin de bien plus de qubits que la taille des clés binaires à factoriser. Une publication récente de Google indiquait ainsi avoir créé un algorithme nécessitant 20 millions de qubits pour casser une clé RSA de 2048 bits. Avec des qubits bien plus “propres” que ceux de Sycamore !

Ca continue avec : “Google is building a doomsday Skynet system, in other words, and they are getting away with it because nobody in Washington D.C. understands mathematics or science. […] Bottom line? Humanity had better start building mobile EMP weapons and learning how to kill robots, or it’s over for the human race. In my opinion, we should pull the plug on Google right now. We may already be too late”. En gros, les zozos proposent de développer des bombes nucléaires générant une impulsion électromagnétique à même de détruire les data-centers de Google.

La même thèse est diffusée dans le site conspirationniste InfoWars.

Ce n’est que le début. Attendez-vous à bien pire !

En résumé

La prouesse encore non officielle de Google est une étape clé dans les progrès réalisés dans l’informatique quantique. Elle montre qu’un ordinateur quantique peut avoir des capacités qui dépassent celles des supercalculateurs d’aujourd’hui. Elle ouvre la voie pour la suite avec la création de nouveaux algorithmes et l’amélioration des processeurs quantiques pour leur permettre d’augmenter leur nombre de qubits et leur qualité.

Mais il ne faut pas surestimer ce qui a été fait pour autant. L’algorithme choisi était particulièrement efficace sur ordinateur quantique et utilisait à fond la superposition. Les autres algorithmes n’ont pas les mêmes caractéristiques et devront patienter pour trouver des chaussures quantiques à leur pointure. De plus, la technologie des qubits supraconducteurs choisie par Google a peut-être aussi atteint ses limites avec la performance de Sycamore. D’autres technologies pourront peut-être aller au-delà de ce que fait Google. Les dés ne sont pas encore jetés !

Le brouhaha grand public autour de cette annonce arrive à pic au moment où la mission de la députée Paula Forteza termine son rapport et où le gouvernement prépare son plan quantique. Il renforce l’enjeu que cela représente et notamment en matière de souveraineté technologique. Et là, contrairement à ce que vous pourriez penser, la France a encore des cartes à jouer !

Dans la foulée, Fanny Bouton et moi avons enregistré un podcast de 17 minutes qui explique tout cela a capela.

PS : je remercie ceux qui m’ont fourni des pistes à creuser qui m’ont permis de préparer ce post : Harold Ollivier, Vincent Pinte-Deregnaucourt et Christophe Jurczak. Et Fanny Bouton pour la relecture.

PS2 : vous allez bientôt en avoir assez du quantique avec tous ces posts et ebooks. Désolé ! Je me suis attaqué depuis août 2019 à la 4e mise à jour de mon ebook sur l’IA. Cela devrait un peu déplacer le centre de gravité de mes posts, comme pour ceux concernant Cerebras et MemComputing.

PS3 : voir aussi Has Google Actually Achieved ‘Quantum Supremacy’ With Its New Quantum Computer? par Ethan Siegel dans Forbes, 27 septembre 2019, qui est très précis et factuel sur la prouesse de Google.

PS4 : le 21 octobre 2019, des chercheurs d’IBM publiaient l’article On “Quantum Supremacy” où ils remettaient en cause la performance de Google en indiquant pouvoir exécuter leur algorithme en quelques jours au lieu de 10000 ans sur le supercalculateur IBM Summit en adaptant l’architecture mémoire et stockage (en clair, en ajoutant des tonnes de SSD au système, ce qu’ils n’ont pas testé, mais juste évalué en termes de puissance d’émulation disponible). Ils cassent ainsi l’affirmation de la suprématie quantique de Google. Celle-ci deviendrait un avantage quantique en termes de temps de calcul, la différence de temps de calcul étant d’échelle humaine. L’ordinateur quantique présente en tout cas un avantage énorme côté consommation d’énergie dans le cas utilisé, avec un rapport de 1 à 1 152 000 en consommation. Le raisonnement est le suivant : l’ordinateur quantique consomme 15 KW et l’IBM Summit, 12 MW, et le ratio de temps de calcul est de 3 mn vs 3 jours (1/1440). Cela fait une différence non négligeable ! L’article de la suprématie quantique de Google était enfin publié officiellement de son côté dans Nature le 23 octobre. Cf https://www.nature.com/articles/d41586-019-03213-z.

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Merci Olivier pour cette explication de texte, la concordance des temps entre la publication de la dernière édition de ton ebook et la “fuite” de cet article est cocasse :). Le mot “Supremacy” dans le titre était bien (ou pas) choisi par nos amis outre Atlantique.

Quantiquement vôtre.

Bonjour Karim,

Comme je l’explique dans mon ebook, mais pas dans l’article, l’expression de quantum supremacy a été crée par John Preskill (USA, professeur à Caltech) en 2011.

Olivier

@olivez décrypte avec justesse l’actu récente de l’informatique quantique

https://t.co/rHec3WUaIl

@razoor777

Bonjour,

Merci pour cet article très bien détaillé et agréable à lire.

L’article dans Nature :

https://www.nature.com/articles/s41586-019-1666-5

L’interprétation de IBM :

https://www.ibm.com/blogs/research/2019/10/on-quantum-supremacy

@01net Pour rappel aussi, sur le même thème, l’excellent billet de l’excellent Olivier Ezratty (@olivez). Un peu te… https://t.co/UPFtCLWX3U