Je suis en train de passer beaucoup de temps à mettre à jour l’ebook “Les Usages de l’intelligence artificielle” pour publier d’ici novembre une édition 2018 sérieusement mise à jour et complétée. D’où un relatif calme sur ce blog. Bon, depuis 10 jours, après la parution de la compilation de mes 18 articles sur l’informatique quantique sous forme d’ebook.

L’actualité, elle, n’attend pas. Voici donc quelques commentaires à chaud de différents événements récents relatifs à l’intelligence artificielle. Le premier était l’annonce la semaine dernière du plan de la région IDF sur l’IA. Je passerai aussi rapidement sur d’autres événements liés à l’IA comme la belle conférence de FranceIsAI qui avait lieu à Station F les 17 et 18 octobre 2018, une rencontre avec le fondateur d’Element.ai et une embardée de conclusion sur l’informatique quantique à l’occasion du premier meetup quantique organisé à Paris, par le fonds d’investissement Quantonation.

Le plan IA de la Région Ile de France

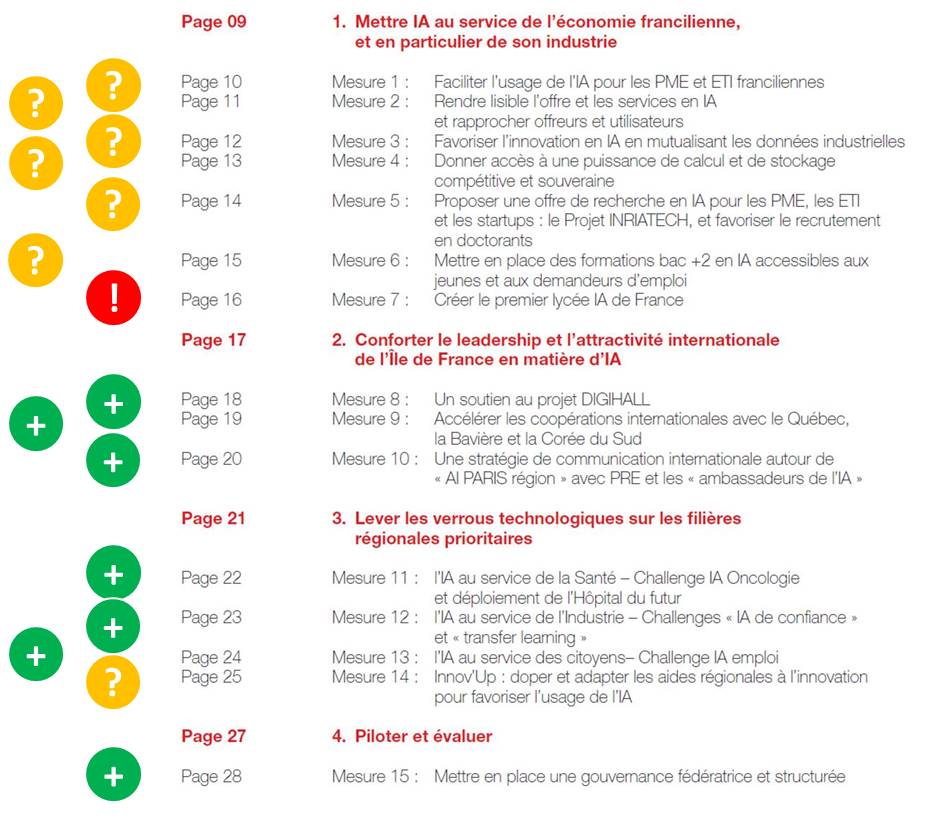

Le 15 octobre 2018, Valérie Pécresse et ses équipes de la Région Ile de France annonçaient un plan pour faire de la Région la capitale mondiale de l’IA. C’était évidemment une intention politique quelque peu grandiloquente mais elle est classique. On n’en attend pas moins des politiques. J’avais été consulté pendant la création du plan, mais cela ne veut pas dire que je souscris entièrement à son contenu. Voici donc les 15 mesures du plan en question et un avis rapide.

Le plan s’articule autour de trois grands axes : l’un pour développer l’usage de l’IA dans les PME franciliennes et développer les compétences associées à l’IA. Le second veut améliorer la position internationale de la région comme productrice d’IA et le dernier vise à développer des filières thématiques de l’IA, essentiellement via des défis thématiques s’adressant aux startups.

La pertinence du plan est variable selon ces trois catégories. Comme de nombreux plans de la puissance publique, celui-ci cherche à traiter deux problèmes distincts et pas forcément dans le bon ordre. Ici, cela commence par l’adoption de l’IA par les PME, et cela continue par le développement de l’écosystème entrepreneurial de l’IA. Bref, cela place la demande avant l’offre et le marché intérieur avant la compétitivité du secteur numérique de l’IA. Ce mélange des genres est classique. Il existait aussi dans les nombreuses propositions du rapport de la mission Villani en mars 2018.

Cette charrue mise avant les bœufs de l’équipement des PME en IA me semble par ailleurs dénué de sens pratique. La première mesure consiste à financer des projets pilotes (“proof of concept”) pour une centaine de PME franciliennes. Soit. Mais ne faut-il pas dans un premier temps faire un état des lieux de la numérisation d’ensemble des PME choisies ? Ou tout du moins avoir un processus de sélection adapté au niveau de numérisation de ces PMEs.

Se pose après la question du choix des intervenants qui feront cette mission. Qui les sélectionne ? La région ? Les PMEs ? Des tiers ? Il semblerait que l’organisation Teralab soit pressentie pour ce faire. C’est une plateforme de services émanant de l’Institut Mines Telecom. Je me demande comment ils pourraient prendre en charge une centaine de PME. C’est pour cela que Syntec Numérique est cité dans le plan. Bref, les ESN (Entreprises de Services Numériques) françaises compétences en IA pourraient servir ces PME dans le cadre de ces PoCs subventionnés chacun à hauteur d’environ x0K€ (ce montant n’est pas précisé dans le plan). Pourquoi pas.

Une autre proposition vise à créer un référentiel de données ouvertes des entreprises industrielles privées. C’est une belle intention mais je vois mal les PME industrielles sauter à pieds joints là-dedans. On a déjà du mal avec les données publiques !

Une offre de recherche pour les PME est également de la partie. Il s’agit de proposer aux PME de faire appel à des chercheurs pour leurs projets. Autant cela peut avoir du sens pour des startups technologiques de l’IA, autant c’est moins évident pour des PME industrielles qui doivent se reposer sur l’état de l’art de l’IA, pas sur des projets de recherche. Dans une PME, le risque doit être industriel et économique, pas scientifique comme dans la recherche ! Surtout lorsqu’il s’agit d’adopter une technologie nouvelle. Les PME ont besoin de compétences en intégration et développement logiciel, pas en recherche dans l’IA. C’est un syndrome classique en France, et en Europe, de vouloir relier un peu trop rapidement la recherche à l’industrie, sans passer par les étapes intermédiaires de l’ingénierie et du produit.

Il y a aussi du cloud souverain, qui vise à aiguiller les PME vers OVH et d’autres offres locales de cloud. Mais si ces PME souhaitent céder aux sirènes d’Amazon, Microsoft, IBM ou Google, personne ne les en détournera ! La force marketing des acteurs fera encore la différence. Rien n’empêche cependant la puissance publique de flécher les choix des PME, tant que cela ne créé pas d’entrave à la concurrence entre les acteurs du secteur.

Suit un effort pour la formation dans l’IA. Le besoin est là, c’est clair. La première mesure est liée à l’école d’IA créée par Microsoft France et gérée par Simplon.co. Il s’agit d’un cursus de formation de 7 mois au développement de solutions d’IA de niveau BAC+2, qui est destiné à des jeunes et à des demandeurs d’emploi. Il en est déjà à sa seconde promotion. Les technologies apprises ne sont pas précisées au-delà du fait qu’il s’agit de développement logiciel de solutions d’IA. Tous les formés de la première saison sauf un ont trouvé un emploi chez les partenaires de Microsoft. Cela ne concerne qu’une cinquantaine de personnes par an, soit une goutte d’eau par rapport aux besoins en Ile de France, même si, heureusement, l’enseignement supérieur privé et public produit bien plus de spécialistes de l’IA que cela. Il est cependant étonnant de voir apparaître de telles initiatives, juste après celle du cloud souverain !

La dernière mesure de cette première catégorie est la plus étrange : la création d’un lycée de l’IA pour former des développeurs d’applications d’IA. N’est-ce pas un peu trop tôt ? Ne faut-il pas passer par les fondamentaux avant de se spécialiser ainsi, notamment en mathématiques ? Cela devrait être une option d’une filière scientifique générale, pas un lycée dédié. Se pose aussi la question évidente du BAC qui est obtenu à la sortie et des formations supérieures auxquelles cela permettra d’accéder. L’intention d’origine était peut-être de former des “ouvriers qualifiés de l’IA”, sorte de CAP d’IA, pour travailler sur des données. Mais on ne fait pas cela en se formant si tôt à des outils de développement de logiciels de machine learning sans avoir un bagage mathématique de base au préalable. La Région a proposé de créer ce lycée de l’IA car les lycées sont dans son périmètre d’intervention. Ce n’est pas le cas de l’enseignement supérieur.

Par rapport à la bataille mondiale de l’IA, j’ai toutefois l’impression que l’on s’y prend avec un lance pierre en se focalisant ainsi sur des formations niveau BAC ou BAC+2. On a surtout besoin de BAC+3 à BAC+7, autant dans les startups que dans les entreprises classiques. J’ai entendu ce son de cloche à Toulouse au printemps dernier dans la bouche d’entrepreneurs qui indiquaient que leur besoin était au minimum d’avoir des BAC+5 scientifiques. C’était aussi lié à l’activité industrielle des entreprises en question.

Toutes ces idées discutables ne viennent pas forcément de la Région. Il faut regarder du côté des personnes consultées pour en déterminer l’origine. On y trouve un mélange de représentants d’entreprises privées françaises (Thales, Atos, Criteo), de Français d’entreprises étrangères (IBM, Microsoft, Palantir, Samsung), de laboratoires de recherche (INRIA, CNRS, CEA), de pôles de compétitivité et d’autres acteurs de l’écosystème numérique.

Les deux autres volets du plan de la Région sont bien plus pertinents. Il s’agit de valoriser l’écosystème entrepreneurial et de recherche de la région. Un pari est fait autour de la plateforme d’innovation Digihall qui va s’installer à Palaiseau dans le grand ensemble de Paris-Saclay. La masse critique de laboratoires de recherche, d’écoles d’ingénieurs, d’universités et d’entreprises dans la zone justifie cette initiative.

Le dernier axe consiste à financer en capital des projets sélectionnés par concours. Ce Challenge IA Paris Region avait déjà une première fournée de gagnants annoncés ce 15 octobre 2018 avec Therapanacea (imagerie médicale et optimisation de traitements en oncologie), LightOn (coprocesseur optique pour l’IA, une technologie très intéressante pour accélérer l’apprentissage du deep learning) , PandaGuide (casque guide audio pour les personnes mal voyantes) et Smartify (reconnaissance visuelle d’œuvres d’art).

L’originalité du concours est son prix : il s’agit d’un investissement en capital dans la startup sous la forme d’obligations convertibles. Donc, ce n’est pas conditionné par un apport équivalent comme nombre de financements publics habituels. Les montants étaient de respectivement 700K€, 350K€, 150K€ et 150K€, investis par PRVF (Paris Region Venture Fund, géré par Cap Décisif) et CEA Investissement. C’est mieux que tous ces concours de startups à la noix où l’on gagne des cacahuètes en visibilité ou des services en nature en sociétés de conseil en accompagnement de startups. Bien entendu, les responsables de ces fonds faisaient partie du jury de sélection des startups !

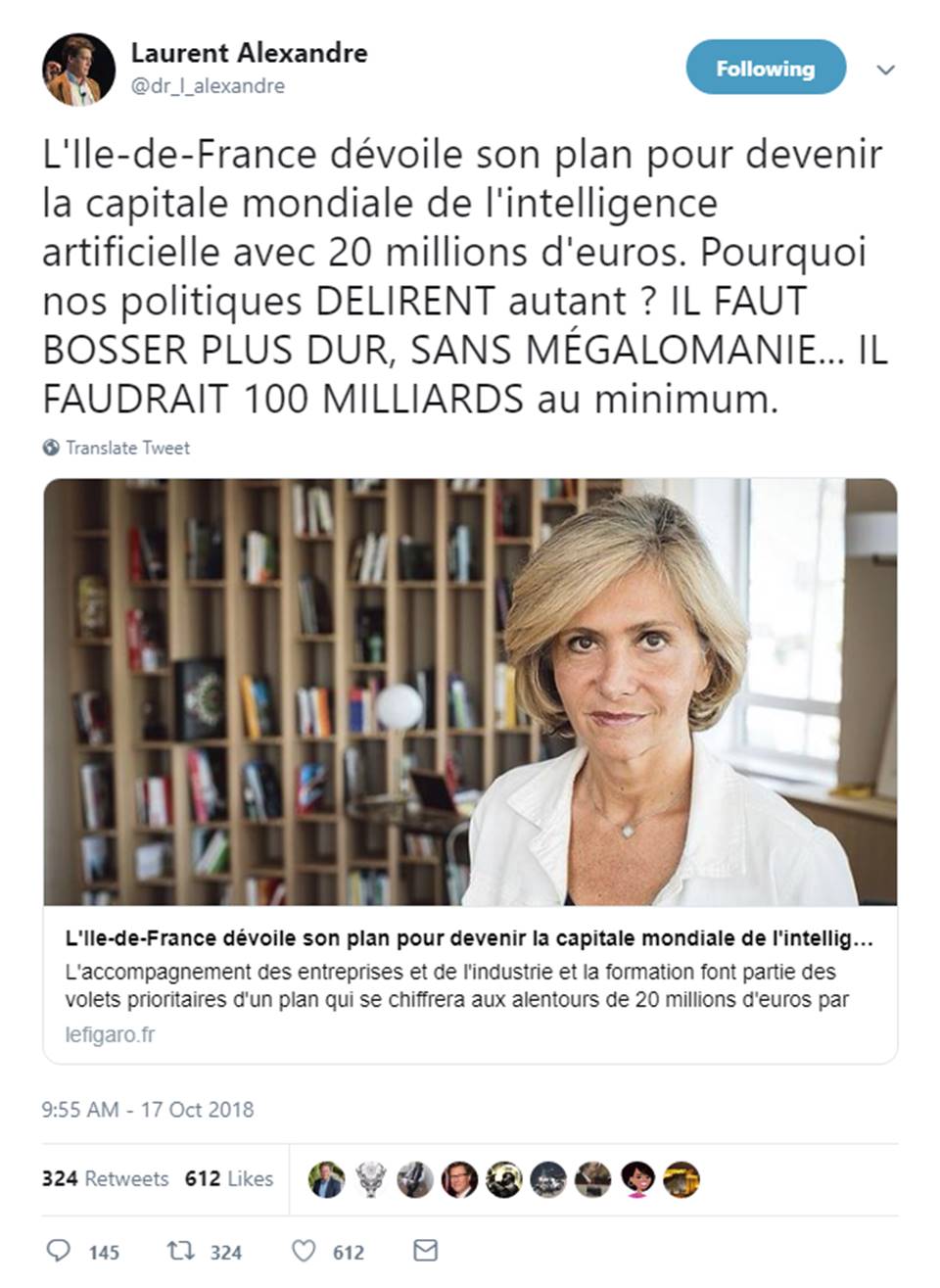

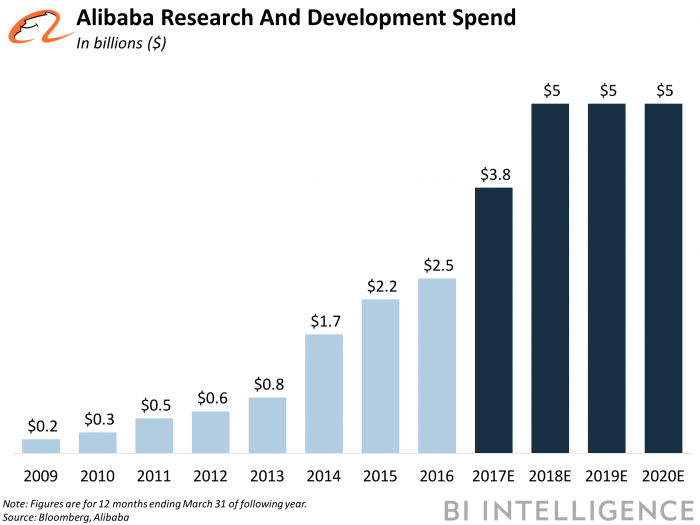

Vient la question du financement de ce plan régional. Il est de 20M€, étalé sur plusieurs années. Ce n’est évidemment pas beaucoup. Laurent Alexandre pense qu’il faudrait 100 Md€ pour combler notre déficit dans l’IA. C’est la folie des grandeurs surtout s’il s’agissait d’une intervention publique, à moins de soviétiser toute l’économie française ou européenne ! C’est deux fois le budget de l’éducation nationale ou des armées ! Et le privé ne peut pas suivre non plus du fait du manque de très grosses entreprises du numérique en France (au sens, produit, industrielle). La plus grande est STMicroelectronics avec environ $10Md€ de CA.

Cela vient du fait qu’il compare ce genre d’investissements avec des montants (pluriannuels) du privé comme les $15B annoncés par Alibababa. Ceci dit, ces $15B sont de la stratégie de communication et de sidération. Une petite part de ces $15B servira à payer quelques centaines de chercheurs en IA. Le reste est une réserve pour faire des acquisitions. Le tout étalé sur 3 ans. Si on essaye de comparer les investissements publics français aux investissements en R&D des GAFAMI (Google, Amazon, Facebook, Apple, Microsoft, IBM), NATU (Netflix, Airbnb, Telsa, Uber) et autres BATX (Baidu, Alibaba, Tencent, Xiaomi), la comparaison sera toujours défavorable, quoi que l’on fasse. Ce ne sont pas les bons repères. Tout du moins, tant que nous n’aurons pas, en Europe, de sociétés “produits scalable” de ce gabarit là.

A la décharge de la Région, ces 20M€ ne sont qu’un petit bout des moyens financiers de l’Ile de France. Il faudrait y ajouter les budgets IA de l’INRIA, du CNRS, les investissements privés dans les startups, l’enseignement supérieur dans l’IA, l’investissement de Xavier Niel dans Station F, les accélérateurs des grandes entreprises, les budgets de R&D des grandes entreprises, etc. Personne n’a d’ailleurs calculé ce montant, pas évident à consolider. Ce qui fait que les pays affichent souvent des montants qui ne sont que des incréments par rapport à un existant. Et on passe son temps à comparer des choux et des carottes. Notamment entre budgets annualisés et pluriannuels.

Les critiques du plan de la Région ont immédiatement fait la comparaison avec l’annonce du MIT de créer un collège de l’IA (équivalent BAC+2) doté de $1B (un milliard de dollars). Voir MIT is investing $1 billion in an AI college. L’annonce est d’ailleurs trompeuse : le MIT n’a pas investi $1B, mais a obtenu un financement privé à cette hauteur pour créer ce collège. Il en a trouvé les deux tiers à ce jour, dont $350M provenant d’un certain Stephen Schwarzman, le CEO du fonds d’investissement Blackstone. Bref, l’annonce “Le MIT investi $1B” est doublement mensongère : ce n’est pas leur argent, et ce n’est pas encore $1B. Comme le veut la tradition dans l’enseignement supérieur US, ce sont les intérêts de ce fonds qui financeront probablement le collège en question qui doit accueillir une cinquantaine d’enseignants et quelques centaines d’élèves. Donc quelques dizaines de millions de dollars par an dans la pratique, ce qui est déjà moins impressionnant. L’intérêt de cette formation est d’associer l’IA avec des sciences diverses, notamment des sciences humaines. C’est un college pluridisciplinaire.

En tenant compte des ratios économiques habituels entre les USA et la France (environ 8 à 1), l’équivalent de ce $1B chez nous serait d’environ 120M€. Xavier Niel a mis le double dans Station F ! Et la moitié (au début) dans l’école 42. On n’est donc pas loin, mais avec des objectifs différents. Arrêtons donc de nous plaindre dès qu’une idée différente des nôtres est lancée ailleurs. On peut s’en inspirer. On peut proposer de créer de tels cursus pluridisciplinaires. Et il ne sera pas nécessaire de collecter un milliard d’Euros pour lancer un tel projet.

Si une critique devait être émise, elle serait à l’intention des milliardaires français qui, à l’exception de Xavier Niel, n’investissent pas leur fortune pour préparer la France aux échéances futures. Les deux les plus connus (Bernard Arnault et François Pinault) donnent plutôt dans le passé avec leurs investissements dans des fondations d’art et des musées. Que font les autres ?

Conférence FranceIsAI

La quatrième conférence FranceIsAI avait lieu à Station F les mercredi 17 et jeudi 18 octobre 2018. C’était une conférence de très bonne facture. Je n’ai pu assister qu’à la première journée, dédiée aux présentations de scientifiques. Et ces présentations étaient d’excellente qualité.

Julie Grollier (CNRS-Thales) présentait la roadmap des memristors, cette voie technologique très importante pour accélérer l’entraînement des réseaux de neurones. C’est compliqué à mettre au point, mais le jour où cela marchera, l’apport de cette technologie à l’IA sera fondamental.

Amélie Corder (Hoomano) faisait le point et un petit fact-checking sur l’état de l’art en robotique. Elle reprenait des éléments qu’elle avait déjà communiqués lors de son intervention à l’Echappée Volée en juillet 2018.

Nikos Paragios (Ecole CentraleSupelec et startup Therapanacea, premier lauréat du Challenge IA de la région IDF) faisait un point de l’usage de l’IA dans l’imagerie médicale et de la discipline des “radiomics” qui quantifie les analyses d’image. Il expliquait la combinaison de réseaux de neurones qu’il faut employer dans des approches multimodales pour bien exploiter les résultats d’imagerie médicale. J’ai adoré son illustration sauce Halloween sur la diversité des données d’entrainement des IA.

Olivier Grisel (INRIA) faisait le point sur Scikit-Learn, le framework issu de l’INRIA qui est très populaire dans le monde même s’il n’atteint pas les niveaux d’usage de TensorFlow de Google. Avec de bons exemples de code !

Emmanuel Bacry (CNRS) expliquait comme l’IA associée aux données de parcours de santé de la CNAM permettait d’identifier des effets secondaires indésirables de médicaments comme pour l’antidiabétique oral Pioglitazone qui a été retiré du marché en 2011 à cause de son incidence sur le cancer de la vessie.

Yves Railmond (Netflix) évoquait l’état de l’art dans la recommandation, l’une des spécialités du leader de la VOD depuis des années. Et notamment les effets de caisse de résonnance dûs à la recommandation. Netflix injecte du hasard dans ses bases d’apprentissage pour limiter ce phénomène et générer de la sérendipité des choix proposés.

Antoine Bordes (Facebook) dirige le laboratoire de recherche en IA à Paris de Facebook depuis que Yann LeCun a pris la tête de l’ensemble de ces laboratoires à l’échelle mondiale. Il montrait comment Facebook combine l’utilisation de deep learning et de l’IA symbolique.

Bernard Ourghanlian (Microsoft) testait une nouvelle pédagogie courte de présentation de l’informatique quantique. C’était bien senti. Il faut tester plein de formules différentes pour voir ce qui passe le mieux. J’y participe comme vous le savez déjà.

Et j’en loupe plein d’autres, tout comme les intervenants de la seconde journée, plus dédiée aux écosystèmes d’innovation.

Element.AI

La semaine précédente, j’avais participé à une rencontre avec le fondateur de la startup canadienne Element.ai, Jean-François Gagnier, organisée à la résidence de l’ambassadeur du Canada. Le débat d’une heure mené par Benoît Georges des Echos était de haute tenue. J’ai surtout confirmé avec Jean-François Gagnier les difficultés de l’approche produit des startups de l’IA. Il a beau avoir levé $102M, sa société est encore loin d’être une véritable startup “produit”.

Il cherche à factoriser des besoins métiers d’entreprises de différents secteurs comme dans la banque et l’assurance, lorsque les entreprises ont intérêt à mutualiser certaines avancées technologiques. Il indiquait surtout qu’aucune startup, à sa connaissance, n’avait à ce jour réussi le pari de créer de véritables produits génériques ne nécessitant pas leur lot de service et de mode projet pour être déployé dans les entreprises.

Premier meetup quantique organisé par Quantonation

Histoire de revenir au quantique, j’ai aussi participé mardi 16 octobre au premier meetup quantique, organisé par le fonds d’investissement Quantonation dédié au quantique, lancé par Christophe Jurczak et Charles Beigbeder. Il y faisait intervenir trois entrepreneurs étrangers : KETS (UK, dans la cryptographie, clé quantique intégrée dans un drone ou des pico-satellites), Heisenberg (Allemagne, applications du calcul quantique dans a chimie) et Beit (Pologne, qui utilise des algorithmes quantiques qu’il exécute ensuite sur des ordinateurs traditionnels pour gagner en performance). Les supports de présentation de la soirée sont téléchargeables. Le prochain meetup du genre aura lieu le 6 décembre à Paris.

A noter une discussion que j’ai eu avec des doctorants dont un de l’Ecole Polytechnique qui m’indiquait qu’il n’y avait pour l’instant aucun cursus sur l’informatique quantique, matériel comme logiciel. Cela donne l’impression de vivre le début d’une histoire comme à la fin des années 1990 sur Internet et les premières startups. Tout est à faire !

Voilà pour une semaine et demi d’actualités ! Entre tout cela, j’ai tout de même pu faire deux conférences chez des clients ! La suite au prochain épisode !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

“A noter une discussion que j’ai eu avec des doctorants dont un de l’Ecole Polytechnique qui m’indiquait qu’il n’y avait pour l’instant aucun cursus sur l’informatique quantique, matériel comme logiciel.”

Et existe-t-il déjà à Polytechnique un cursus sur l’IA ? (pour rebondir sur le sujet principal du post.

Merci.

Il semblerait que oui. Cf https://www.polytechnique.edu/fr/content/lx-lance-un-nouveau-programme-graduate-degree-en-intelligence-artificielle et puis https://www.polytechnique.edu/fr/content/google-et-lx-lancent-une-chaire-en-intelligence-artificielle

Saluons le retour tricennal de la Grande peur de l’IA ! Autour de 1958, en pleine guerre froide, la cybernétique soviétique effrayait bilatéralement DARPA ; en 1988 la Cinquième génération du Japon “qui peut dire non” terrifiait en Prolog les cœurs les mieux accrochés ; aujourd’hui, en 2018, les IA — comme on dit — menacent nos emplois, nos droits, notre modèle social enfin ! Tremblez, humains obsolètes rejetons de Gunther Anders, les robots intelligents se lèvent à nouveau à l’Est (cf. http://knowledge.wharton.upenn.edu/article/ai-china-vs-us/)…

Pour une intelligence artificielle maîtrisée, utile et démystifiée, nous disent la sénatrice et le député, Mme Gillot et M. De Ganay, dans un rapport lénifiant probablement imaginé pour apaiser les foules. Le rapport Villani veut donner un sens à l’intelligence artificielle (vers le fond, sans doute) : l’IA administrative, nationale et républicaine sera éthique.

Vivement le prochain retour en 2048 pour constater qu’on aura eu une IA étique.