Cela fait déjà quelques années que l’informatique quantique m’intrigue. Je l’évoque souvent aux fins fonds de la rubrique des composants électroniques du Rapport du CES de Las Vegas depuis l’édition 2015 tout en admettant, à l’époque, n’y rien comprendre et en mettant sérieusement en doute la compréhension du sujet par les médias relayant diverses annonces sur le sujet.

Je m’étais donné alors comme objectif de comprendre les enjeux scientifiques, technologiques et économiques de cette branche passionnante de l’informatique avec une échéance précise : ma conférence traditionnelle du Web2Day à Nantes en juin. Il y a un an donc, était planifiée la conférence Le quantique, c’est fantastique que j’ai eu l’immense plaisir de délivrer en plénière avec Fanny Bouton le 14 juin 2018 (vidéo). Le Web2day est la grande messe festive du numérique de Nantes et elle fêtait sa dixième édition en fanfare. C’est un lieu unique d’expérimentation de nouveaux contenus et formats. Donc l’endroit rêvé !

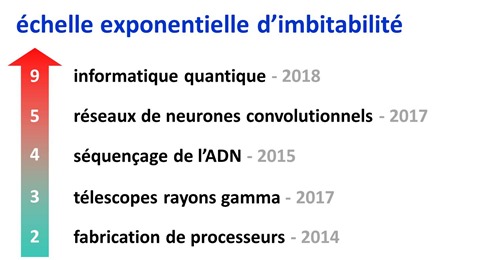

J’avais eu l’occasion d’y défricher d’autres sujets associant les sciences, l’innovation et l’entrepreneuriat : le merveilleux monde des semiconducteurs (2014), les promesses du séquençage de l’ADN (2015), la biologie de la prise de parole en public, en duo avec Annabelle Roberts (2016) puis l’astronomie et l’entrepreneuriat (2017). Je n’ai pas pu y traiter de l’intelligence artificielle mais je me suis rattrapé ailleurs.

Le top du top de l’imbitabilité

Tous ces épisodes peuvent être positionnés sur une échelle exponentielle d’imbitabilité. Après avoir balayé ces différents pans de la science, je peux résolument positionner l’informatique quantique, et la mécanique quantique qui la sous-tend, au top du top de cette échelle. On pourrait juste ajouter un niveau 10 pour un cas particulier de l’informatique quantique, le quantique topologique, que nous aurons l’occasion d’essayer d’expliquer.

Comme l’indiquait il y plusieurs décennies Richard Feynman, lorsque l’on étudie la mécanique quantique, si l’on croit que l’on a tout compris, c’est que l’on n’a pas tout compris.

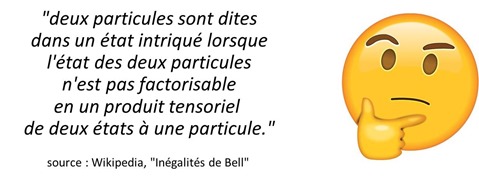

Pour ne prendre qu’un exemple, vous pourriez bien tourner en rond longtemps pour piger cette perle, la définition de l’intrication d’une particule, extraite de la page Wikipedia sur les inégalités de Bell, qui vaut son pesant d’imbitabilité ! Tout ça pour dire que deux particules intriquées portent les mêmes valeurs quantiques au lieu d’en porter chacune une, individuelle et différente ! Cela traduit la difficulté qu’ont de nombreux physiciens de la mécanique quantique à traduire ce qu’ils font en langage naturel ainsi que le lien ténu entre la mécanique quantique et de nombreux concepts mathématiques qui peuvent facilement nous échapper.

La mécanique quantique est le règne physique et métaphorique du “peut-être”, “ou pas” et du “en même temps”, d’une approche probabiliste du monde qui a de ce point de vue quelques vagues points communs avec l’approche connectionniste de l’intelligence artificielle.

La préparation de la conférence de Nantes ne nous a pas épargné ces aléas de compréhension même si, étape par étape, nous avons pu lever de nombreuses interrogations. L’expertise en désimbitabilisation de l’informatique quantique est un véritable tonneau des Danaïdes ! D’ailleurs, nombre de participants à notre conférence étaient ravi de la scénographie mais “n’avaient rien compris”. Il faut l’admettre avec humilité, la pédagogie de l’informatique quantique est un art difficile. Et la méthode “au ralenti”, avec de l’écrit complète les conférences qui vont toujours trop vite pour nos cerveaux embrumés par un trop grand nombre de nouveaux concepts.

Une nouvelle vague pour le numérique

Pourquoi l’informatique quantique est-elle est un sujet important ? D’abord, parce qu’elle commence à faire parler d’elle, au travers d’annonces de grands acteurs du numérique comme IBM, Google, Intel ou Microsoft, avec des annonces impressionnantes qu’il faut cependant prendre avec des pincettes, beaucoup de recul et décoder, si ce n’est “débullshitiser”.

Mais surtout, parce qu’elle pourrait impacter sérieusement de nombreux champs scientifiques puis certains usages du numérique. Elle permettra théoriquement de résoudre des classes de problèmes tellement complexes que les ordinateurs traditionnels, même les supercalculateurs géants, ne pourront jamais traiter.

La préparation de cette conférence de Web2day a pris du temps, presque un an au compteur ! Elle arrive à point nommé tandis que les prises de parole commencent à se multiplier sur l’informatique quantique. Deux sessions sur ce thème font ainsi partie du programme de l’excellente conférence USI des 25 et 26 juin 2018 à Paris organisée par Octo Technology avec Etienne Klein, Directeur de Recherche au CEA sur les sciences de la matière, ainsi que Colin Williams, du Canadien D-Wave.

Une conférence de presse du CEA sur l’informatique quantique avait lieu à Paris le même jour que notre conférence du Web2day pour annoncer notamment la publication d’un numéro spécial de Clefs, leur magazine, entièrement dédié aux applications du quantique et qui est d’excellente facture pour développer votre culture scientifique générale sur le quantique (téléchargement). Le journal La Tribune publiait le même jour un dossier de quatre pages de mon cru sur l’informatique quantique.

Une session sur le quantique avait aussi lieu sur VivaTech fin mai 2018 à Paris avec Bo Ewald, président de ce même D-Wave. Et IBM présentait les entrailles de son dernier ordinateur quantique sur son stand !

Lors de la préparation de cette conférence du Web2day, Fanny Bouton et moi-même avons eu la chance de pouvoir rencontrer des français et étrangers qui comptent dans le quantique : Alain Aspect, le vénérable vérificateur de l’intrication quantique en 1982, Philippe Duluc et Cyril Allouche, qui pilotent la recherche dans l’informatique quantique chez Atos, Daniel Estève, le grand spécialiste des qubits supraconducteurs au CEA à Saclay, Pat Gumann, un chercheur des laboratoires d’IBM à Yorktown aux USA, aussi spécialisé dans les qubits supraconducteurs ainsi que Doug Carmean, un chercheur de Microsoft qui nous a évidemment parlé des fermions de Majorana qui sont l’équivalent quantique de “en attendant Godot”. Nous allons aussi rencontrer Maud Vinet du CEA LETI à Grenoble qui pilote les recherches sur les qubits à base de composants CMOS.

L’autre raison de cet intérêt soudain pour l’informatique quantique est que nous sommes encore aux débuts d’une longue histoire qui va voir la science et l’industrie se sédimenter, avec la création de nouveaux leaders, et le développement d’un écosystème d’acteurs. Le tout dans un domaine où subsiste une énorme incertitude scientifique et technologique. Il est très difficile d’évaluer la faisabilité de la création d’ordinateurs quantiques opérationnels. Les chercheurs que nous avons rencontrés ont bien calmé nos ardeurs. Pour eux, il faudra patienter encore quelques décennies avant d’en voir la couleur ! L’ennemi : le bruit ! Ce bruit qui génère des erreurs dans l’évolution des qubits pendant les calculs quantiques et qui est à la fois difficile à éviter et à corriger.

C’est une étude de cas vivante des plus intéressantes. Les phases d’incertitudes sont les périodes pendant lesquelles certaines formes de leadership se construisent. La France va une fois encore se poser la question de son leadership supposé ou mérité sur le sujet. Sur un sujet encore jeune, sommes-nous prêts à relever le défi ? A investir ? Où faut-il le faire ? Que faudrait-il faire pour y arriver ? Ce sont des questions lancinantes qui ont eu leur lot de réponses sur l’intelligence artificielle, avec plus ou moins de bonheur comme nous avons pu le constater avec le Rapport de la Mission Villani publié en mars 2018, que j’avais décortiqué dans Ce que révèle le Rapport Villani en mars 2018. En prenant un nouveau sujet plus en amont, nous avons peut-être des chances de mieux nous en sortir. C’est en amont des grandes vagues que les positions se prennent. Nous verrons que cela peut être le cas du côté des algorithmes et des logiciels adaptés aux calculateurs quantiques.

Sommaire

Cette série d’articles est longue avec 18 parties. Cela ne vous surprendra pas. Je vais essayer de couvrir tous les recoins du sujet à 360°. Son cœur en est le calcul quantique mais je vais aussi traiter des autres applications numériques du quantique et en particulier la cryptographie quantique et post-quantique. Vous pouvez télécharger l’ensemble dans un ebook récupérable ici.

Voici les parties prévues et leur résumé associé :

1) Pourquoi l’informatique quantique ?

- L’informatique quantique sert à dépasser les limites des processeurs traditionnels pour des applications spécifiques d’optimisation et de simulation dont la complexité croit de manière exponentielle avec la taille du problème.

- Pourquoi les technologies CMOS classiques sont-elles insuffisantes pour atteindre cet objectif ?

2) Les scientifiques de la mécanique et de l’informatique quantique

- C’est le “hall of fame” du sujet où je mettrais en évidence les efforts de dizaines de scientifiques de renom qui ont découvert puis fait progresser la mécanique quantique, puis l’informatique quantique. Cela brossera une chronologie du domaine, une histoire des idées et rendra aux Césars du quantique ce qui leur revient.

3) Les basiques de la mécanique quantique

- Quels sont les fondements de la mécanique quantique qui servent à créer des ordinateurs quantiques ? L’intrication, la superposition, la dualité ondes-particules et l’incertitude de la mesure. Cela ne sera pas un cours de mécanique complet, mais juste les bases permettant de comprendre la suite.

4) Les qubits

- Les ordinateurs quantiques exploitent au niveau le plus bas des qubits, des entités qui ont deux états simultanés (par superposition) et peuvent se combiner via des portes quantiques (intrication). Dans les ordinateurs quantiques, l’information ne bouge pas et reste dans des qubits. Les portes quantiques agissent de manière programmatique sur ces qubits. En fin de calcul, on évalue la valeur des qubits qui n’ont pas bougé physiquement pour lire le résultat.

- Il existe de nombreuses méthodes de création de qubits issues d’entreprises privées (Google, IBM, Intel, Microsoft), de startups (D-Wave, Rigetti) et de laboratoires (dont le CEA). Ils sont à base de supraconducteurs à effet Josephson, d’ions piégés, de phase de photons, de spins d’électrons, de fermions de Majorana ou de cavités dans des diamants dopés à l’azote. Quels sont les avantages et inconvénients de ces voies techniques très différentes ?

- Ces différentes approches sont nécessaires. Il est possible que seule l’une d’entre elle porte ses fruits. On ne sait pas prédire laquelle à ce stade.

5) L’ordinateur quantique

- Nous verrons dans le détail comment est organisé un ordinateur quantique avec ses qubits, ses registres, ses portes et ses outils de mesure.

- Le fonctionnement des ordinateurs quantiques à grande échelle n’est pas encore possible ni assuré mais les progrès sont cependant rapides et suivent pour l’instant l’équivalent de la loi de Moore.

- La majeure partie des ordinateurs quantiques actuels doivent être réfrigérés à 10-20 mK, proche du zéro absolu, ce qui n’est pas évident sur de gros volumes. Certains laboratoires travaillent sur des qubits fonctionnant à température ambiante.

- Nous décrirons ce problème du bruit qui affecte les qubits et comment il peut être évité ou donner lieu à des corrections, que l’on appelle les QEC (Quantum Error Corrections).

- La communauté scientifique n’est pas en phase sur l’éventualité de créer des ordinateurs quantiques avec un grand nombre de qubits. Certains pensent que c’est impossible, d’autres que cela prendra plusieurs décennies, et quelques-uns, que l’on y arrivera dans moins de 10 ans.

- Avec les techniques actuelles, un ordinateur quantique tient dans quelques mètres-cubes et consomme environ 20 KW, ce qui est très raisonnable compte-tenu de la puissance de calcul fournie. C’est un outil destiné aux centres de calcul, exploitable à distance dans le cloud.

6) Algorithmes et applications quantiques

- Les ordinateurs quantiques exploitent des algorithmes quantiques qui servent à résoudre des problèmes de calculs complexes bien plus rapidement qu’avec des supercalculateurs. Ces algorithmes sont très différents de ceux de l’informatique traditionnelle. De tels algorithmes quantiques sont régulièrement inventés depuis le début des années 1990 après ceux de Deutsch-Jozsa, Grover et Shor. Mais il n’y en a pas tant que cela.

- Les grandes applications de l’informatique quantique portent sur la simulation de physique des matériaux, en biologie moléculaire, des optimisations complexes et aussi pour l’entraînement de réseaux de neurones ainsi que pour le machine learning.

- La suprématie quantique qualifie une situation future où des ordinateurs quantiques permettront de réaliser des calculs inaccessibles aux supercalculateurs actuels et pour certaines applications et algorithmes spécifiques. Elle n’arrivera donc pas d’un seul coup et sera progressive, application par application et ordinateur quantique par ordinateur quantique.

- Nous évoquerons aussi les questions des théories de la complexité des problèmes et les limitations des ordinateurs quantiques.

- Nous ferons un tour des applications potentielles de l’informatique quantique dans différents secteurs d’activité comme les transports, la santé, l’énergie, la finance et le marketing.

7) Panorama des acteurs

- Nous ferons le tour des principaux acteurs industriels de l’informatique quantique, par type de qubits avec notamment D-Wave, IBM, Google, Rigetti, IonQ, Intel, Microsoft, Nokia et QDTI. Avec leurs technologies, le point où ils en sont et leurs premières études de cas lorsqu’elles existent.

- Ces acteurs se préparent déjà en créant des outils de développement adaptés à l’exploitation de l’informatique quantique avant même que l’on soit assuré du caractère opérationnel des ordinateurs quantiques. C’est un beau cas d’école de l’innovation où nombre d’acteurs publics et privés avancent de concert dans un environnement très incertain.

8) Stratégies industrielles

- Les pays les plus actifs dans l’informatique quantique sont les USA, la Chine, le Canada, UK, l’Australie, l’Autriche, la Suisse, les Pays-Bas et l’Australie. A part le cas particulier d’Atos que nous décrirons, la France semble peu active du point de vue industriel et devra rapidement rattraper le coup. Sa recherche est cependant au niveau du côté des couches physiques, notamment dans les qubits à supraconducteurs.

- Comment est structuré l’écosystème quantique en France ? Quelle stratégie pour la France et les entreprises françaises dans ce monde scientifique encore très incertain ? Peut-on créer une stratégie européenne ?

9) Les startups de l’informatique quantique

- De nombreuses startups, surtout anglo-saxonnes, prennent déjà leur position sur un marché qui est à peine existant. Notamment, dans la partie logicielle et au-dessus des seuls ordinateurs quantiques disponibles, ceux de D-Wave.

- C’est une étude de cas “in vivo” d’écosystème en cours de constitution, très en avance de phase par rapport à l’émergence du marché correspondant.

10) La cryptographie quantique et la cryptographie post-quantique

- C’est le marché le plus mûr de l’informatique quantique. Il est la conséquence directe des menaces que font peser à long terme les ordinateurs quantiques sur la cryptographie à clés publiques.

- Le marché comprend deux composantes : la cryptographie quantique qui permet de transporter des clés de sécurité sans qu’elles soient violables pendant leur transport, et la cryptographie post-quantique qui permet d’éviter les méfaits de l’algorithme de Shor.

11) Les communications et la téléportation quantique

- Nous revenons sur la fameuse expérience d’Alain Aspect sur la non localité des propriétés des photons intriqués et sur ses conséquences. Pourra-t-on l’utiliser pour transporter de l’information plus vite que la lumière voire pour télétransporter de la matière, qui plus est vivante ? Genre, vous ? Hint : probablement pas.

- Et pourtant, des usages pointent du nez !

12) Ethique et philosophie de l’informatique quantique

- Quels sont les questions éthiques et philosophiques soulevées par l’informatique quantique ?

- Le jargon du quantique et ses dérives. La volonté de puissance sur les données, la nature et la compréhension du monde.

- Les biais et l’explicabilité des algorithmes à l’heure de l’informatique quantique, les grandes différences avec ces mêmes questions lorsqu’elles sont appliquées au deep learning.

Pourquoi l’informatique quantique ?

L’une des motivations de l’informatique quantique est de pouvoir résoudre des problèmes que les ordinateurs traditionnels ne savent pas et ne sauront peut-être jamais traiter. Il s’agit des problèmes de nature exponentielle, dont la complexité augmente exponentiellement avec la quantité des données à traiter.

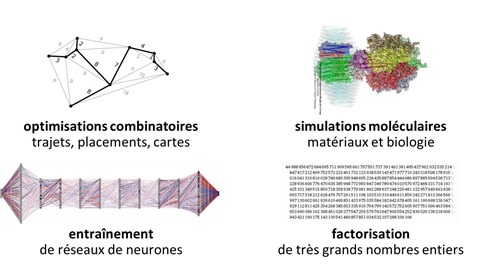

Le schéma ci-dessus présente quelques exemples de problèmes complexes de nature exponentielle.

Cela commence avec divers problèmes d’optimisation comme celui du parcours du livreur ou de véhicules autonomes dans le trafic. Lorsque la combinatoire à optimiser est très grande, les algorithmes classiques trouvent leurs limites sur les ordinateurs traditionnels. Cela se complique avec l’optimisation du trafic de parcs de véhicules autonomes de villes intelligentes du futur. Aujourd’hui, on optimise son trajet avec Google Maps ou Waze en s’appuyant sur l’état du trafic. Celui-ci est variable et la durée du trajet finale n’est pas toujours optimale et ne correspond pas forcément à la durée prévue. C’est un système hautement indéterministe. Avec une flotte intégralement autonome, on devrait pouvoir théoriquement optimiser le trajet individuel de chaque véhicule en fonction de leur lieu de départ et de destination. Les algorithmes classiques pourraient fonctionner avec une quantité limitée de véhicules mais au-delà de quelques milliers, les capacités de calcul traditionnelles seraient largement saturées. Le quantique arriverait alors à la rescousse !

L’entraînement de réseaux de neurones est un second domaine d’application. Il est aujourd’hui à la portée des ordinateurs classiques, équipés de GPU comme ceux de Nvidia ou les processeurs neuromorphiques qui mettent en œuvre dans le silicium des portes logiques dont l’organisation est très proche de la logique des réseaux de neurones. Mais aujourd’hui, la puissance de calcul disponible rend difficile l’entraînement de réseaux de grande taille. Pour ne prendre que l’exemple des réseaux convolutifs de reconnaissance d’images, ceux-ci ont une résolution d’image en entrée généralement limitée à 214×214 pixels.

En troisième lieu intervient la simulation du fonctionnement de la matière au niveau atomique. Elle est régie par les règles de la mécanique quantique qui dépendent d’équations connues mais dont la combinatoire est un problème d’optimisation complexe à résoudre, particulièrement pour comprendre l’interaction de nombreux atomes dans des molécules ou des structures cristallines complexes. Cela concerne aussi bien la simulation chimique que celle du vivant. L’informatique quantique pourrait ainsi servir à simuler le quantique du monde réel dans l’infiniment petit. Rassurez-vous, cela n’ira pas au point de simuler un être vivant en entier. Cela sera déjà une prouesse fantastique que de le faire un niveau du repliement d’une seule protéine sur elle-même !

Enfin, nous pouvons citer la factorisation de nombres entier qui intéresse notamment la NSA et les services de renseignement pour casser les codes de sécurité sur Internet de type RSA qui reposent sur l’envoi de clés publiques. Nous aurons l’occasion de creuser cela en détails.

D’autres applications pourront émerger pour différents marchés comme la finance ou l’assurance. Nombre d’applications métiers sont concernées par les problèmes d’optimisation complexes et restent à inventer, notamment à destination du grand public.

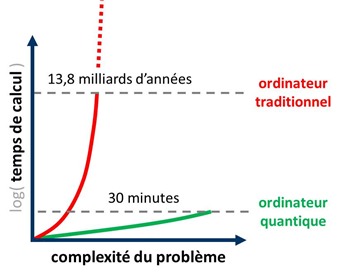

Pour mieux comprendre l’intérêt de l’informatique quantique, voici une mise en abyme du temps de calcul comparé de problèmes très complexes. Dans les cas extrêmes, les temps de calcul sur ordinateurs classiques, même avec les plus puissants des supercalculateurs du moment, dépasseraient l’âge de l’Univers, soit 13,85 milliards d’années sachant que la Terre restera encore vivable dans le meilleur des cas pendant seulement 2 milliards d’années, modulo les effets à court terme – à l’échelle cosmique – du réchauffement planétaire.

Comparativement, des ordinateurs quantiques pourraient en théorie résoudre ces mêmes problèmes dans un temps raisonnable à l’échelle d’une vie humaine, en heures, journées, semaines ou mois. Je raisonne au conditionnel car on n’est pas vraiment sûr d’y arriver. Les barrières technologiques si ce n’est scientifiques à franchir sont encore immenses avant d’y parvenir.

Bref, l’informatique quantique n’est pas juste là pour aller plus vite que l’informatique traditionnelle dans son champ opératoire actuel. Elle sert à résoudre des problèmes inaccessibles aux ordinateurs classiques, même en s’appuyant sur un éventuel mouvement perpétuel de la loi de Moore, qui, on le sait, n’est pas du tout assuré.

On pourrait ainsi affirmer que le potentiel de disruption de l’informatique quantique est “multimooresque”.

Comment augmente-t-on actuellement la puissance des ordinateurs classique ? On s’appuie sur quelques techniques connues, certaines n’ayant pas encore été explorées à fond. Nous avons l’augmentation de la densité des processeurs en transistors qui permet d’aligner plus de fonctions dans un processeur mais sans forcément en augmentant sa rapidité.

Nous créons des architectures multicœurs qui permettent de paralléliser les traitements pour peu que les logiciels associés le permettent.

Nous pouvons passer par l’optronique en remplaçant les électrons par des photons pour faire circuler l’information. Cela permettrait en théorie de créer des processeurs allant 20 à 25 fois plus vite que les processeurs CMOS actuels. Mais ces processeurs sont difficiles à mettre au point et à intégrer, les matériaux utilisés étant différents de ceux des processeurs CMOS. On passerait ainsi du silicium au cadmium, à l’indium, au gallium et autres métaux plutôt rares.

Enfin, subsiste la voie de l’utilisation de processeurs utilisant des tenseurs (multiplicateurs de matrices) ou des processeurs neuromorphiques (imitant le fonctionnement des neurones biologiques, avec une mémoire intégrée comme avec les memristors). Le tout étant intéressant pour l’entraînement et l’inférence des réseaux de neurones du deep learning utilisés notamment dans la reconnaissance d’images et celle du langage.

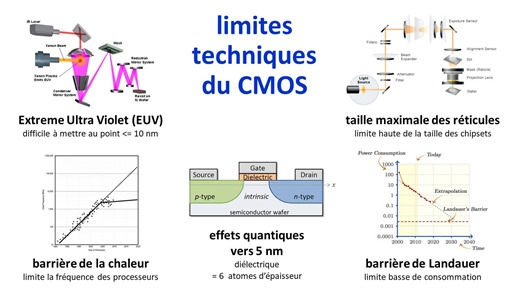

Pour aller de l’avant, il faut trouver le moyen de développer des technologies clés et de contourner des limitations physiques connues.

La barrière de la chaleur limite l’augmentation de la vitesse d’horloge des processeurs. Elle plafonne de manière courante à 4 GHz dans les processeurs Intel du marché et peut monter à 6 GHz avec des refroidissements de compétition.

Pour créer des transistors avec une intégration en-dessous de 10 nm, il faut faire appel à des systèmes de gravure utilisant l’extrême ultra-violet. En effet, leur résolution dépend de la longueur d’onde de la lumière utilisée pour projeter un masque sur une résine photosensible. Pour diminuer la taille des transistors, il faut augmenter cette fréquence pour diminuer la longueur d’onde, et donc passer de l’ultra-violet actuel à l’extrême ultra-violet. Cela fait presque 10 ans que ces machines de gravure EUV sont mises au point, et de manière très laborieuse. Qui plus est, lorsque l’on miniaturise les transistors en deçà de 5 nm, on voit apparaître des effets quantiques indésirables.

Deux autres limites sont à prendre en compte comme la barrière de Rolf Landauer (chercheur chez IBM, en 1961) qui indique le minimum d’énergie nécessaire pour modifier une information. C’est une barrière théorique contestée par certains physiciens. Enfin, il existe une limite de taille des réticules, ces systèmes optiques de gravure de processeurs dont la taille est physiquement limitée. Le plus gros processeur actuel, le Nvidia V100 avec ses 21 milliards de transistors, atteint déjà cette limite.

Bref, l’informatique quantique permettra de passer outre les diverses limitations des processeurs CMOS actuels. Elle ne les remplacera toutefois pas du tout pour les tâches actuellement accomplies par les ordinateurs et mobiles actuels.

Comme ses usages ne seront pas les mêmes, il est difficile d’anticiper le paysage informatique qui germera. Les prévisions de Ray Kurzweil sur la singularité qui s’appuient fortement sur la prolongation ad-vitam de la loi de Moore mériteront en tout cas d’être révisées !

_____________________________________________

Dans la partie suivante, nous irons faire un tour chez les grands scientifiques de la mécanique et de l’informatique quantique et examiner l’histoire des idées de cette branche des sciences.

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Bonjour Olivier

Merci pour ce post et pour ce programme alléchant.

J’attends avec impatience les poste suivants car malgré mes efforts pour comprendre ces sujets, j’avoue que “l’imbitabilite” des explications disponibles sont parfois décourageantes.

A très vite donc!

L’imbitabilité de la mécanique quantique est un phénomène connu depuis les débuts de sa conceptualisation par Planck en 1900 ! Don’t worry. Il faut y aller étape par étape.

Je l’ai d’ailleurs constaté dans de nombreux ouvrages de vulgarisation ou des bouquins de méca quantique pour étudiants qui ne prennent pas la peine de raconter l’origine de certains concepts. Ils te disent, alors, voilà, c’est comme ça, cherchez pas à comprendre.

Le plus frappant est celui de la sphère de Bloch et de la représentation mathématique de l’état des qubits. J’essaye de traduire tout cela en langage compréhensible pour ceux qui ont un référentiel d’ingénieurs ou de développeurs de base. Certains le font bien, surtout aux USA dans certains tutos en ligne. Mais ceux qui font cela en 15 mn sont un peu trop rapides.

Je vais lire avec gourmandise !

Le peu que je sais du sujet date de 20 ans et du remarquable livre “Histoire des Codes Secrets” de Simon Singh.

Je me rappelle sa conclusion assez pessimiste qui était de dire qu’il se passerait longtemps avant que le commun des mortels ne soit au courant des développements et des technos confidentielles issus des labos “régaliens”… mais c’était il y a 20 ans 😉

https://fr.wikipedia.org/wiki/Histoire_des_codes_secrets._De_l'%C3%89gypte_des_pharaons_%C3%A

Bonjour et merci du post..

J’attends la suite avec plaisir..

À bientôt

Jean-Luc

L’informatique quantique a un potentiel de disruption rendant la loi de Moore dérisoire : @olivez initie une série… https://t.co/GgIfFyewAS

#ibm #Quanticcomputing #InformatiqueQuantique pour Dummies pourquoi ?” de @olivez sur https://t.co/UXOGl5qNhJ

L’imbitabilité de la mécanique quantique sera-t-elle battue en brèche par l’informatique quantique ?

Comprendre l’informatique quantique et la riche histoire de cette discipline :

1/ Pourquoi ?… https://t.co/AXHiV11RAx

Comprendre l’informatique quantique – pourquoi ? https://t.co/L1e1fkU8q3 /// Lecture recommandée pour l’été pour co… https://t.co/cHO1MnQfJi

Video de @fannysparty et @olivez sur le #Quantique.

Présentation, dans un style décontracté et documenté (cf série… https://t.co/UhAVcn2xlo

Excellente Série de (longs) Posts par @olivez sur l’Informatique #Quantique : Pourquoi, Scientifiques, Bases Théori… https://t.co/WJSTB6ucKD

Le début d’une belle série d’articles sur l’informatique quantique… à lire … https://t.co/AZ7eI7cSzs