Après une entrée en matière expliquant la grandissante soif de démocratie participative, voici la seconde partie de cette série d’articles qui passe en revue les grandes applications du numérique en politique et dans le fonctionnement de la démocratie :

- La démocratie participative à l’échelle locale : comment fonctionne-t-elle ? Quelles sont les expériences les plus connues ? J’y passe en revue les évolutions légales qui ont encouragé cette mise en place en France puis l’articulation entre les élus locaux, les administrations locales et les citoyens. J’observe qu’au bout du tout processus de démocratie participative, il faut une démocratie représentative pour en prendre le relais et assumer une forme de leadership politique.

- La démocratie participative à l’échelle nationale : où comment elle est mise en œuvre à grande échelle au niveau des Etats, avec des exemples américains, estoniens, français et suisses. Et de montrer que quantitativement en qualitativement, ces nouvelles formes de démocratie ont tendance à créer un corps intermédiaire de citoyens engagés et plus éduqués que la moyenne.

- Le numérique en campagne électorale et l’émergence du populisme 2.0 : où il est plutôt utilisé pour le pire que pour le meilleur, en prenant l’exemple de la campagne présidentielle américaine et la combinaison d’approches top-bottom exploitant les réseaux sociaux et d’approches plus bottom-up passant par la combinaison du terrain et du big data.

- Le numérique dans les programmes électoraux : comment a-t-il fait son apparition ? Comment les politiques s’en emparent-ils ou pas ?

Je ne traiterais pas ici de la manière dont les gouvernements peuvent s’appuyer sur le numérique pour rétrécir le champ démocratique. Cela concerne toutes les méthodes liberticides employées au départ pour prévenir le terrorisme ou lutter contre la grande criminalité et qui débordent parfois sur les ONG, les journalistes et la liberté d’expression. Les cas de la Russie et de la Turquie sont les plus extrêmes de ce point de vue-là mais des dispositions législatives comme la récente Loi sur le Renseignement en France peuvent jouer de mauvais tours à la démocratie, surtout si celle-ci est appropriée par des mains indélicates.

C’est parti pour un “long read” de plus… et vous y êtes habitués !

La démocratie participative à l’échelle locale

De nombreuses expérimentations ont mis en scène Internet pour développer la démocratie participative à l’échelle locale. En France, elles s’inscrivent dans un long processus établi par des lois votées le plus souvent en fin de mandat et en période de cohabitation ces vingt dernières années. Leur apprentissage se fait en parallèle avec d’un côté les processus de la participation et de l’autre, l’exploitation d’outils numériques pour en fluidifier le fonctionnement, le plus souvent avec un effet de relais entre les débats en ligne et leurs pendants “IRL” (in real life). Il est aussi promu par des nombreuses initiatives citoyennes qui font pression sur les élus pour faire évoluer les processus de décisions.

La Commission Nationale du Débat Public (CNDP) a été créée en février 1995, lorsqu’Edouard Balladur était à la fois Premier Ministre et candidat à l’élection présidentielle de la même année. la CNDP s’assure de la bonne information du public lors du lancement de projets d’aménagement ou d’équipement impactant l’environnement. Elle organise les débats publics associés ou bien en fait un simple inventaire, selon les circonstances. Son président est un inconnu, Christian Leyrit, un haut fonctionnaire, ingénieur du Corps des Ponts et Chaussées. Ses 25 membres comprennent des élus locaux et nationaux, des représentants du Conseil d’Etat, de la Cour des Compte, de la Cour de Cassation et des représentants d’associations et de syndicats. La Commission promeut les débats publics côté méthodologie et les consolide sur son site. Ce sont majoritairement des projets d’équipements et d’infrastructure régionaux (routes, autoroutes, transports en commun, lignes haute tension, éoliennes).

La loi relative à la démocratie de proximité de février 2002 arrivait dans des circonstances voisines, avant le crépuscule de l’ère Jospin symbolisé par la fatidique date du 21 avril. Elle instituait les comités de quartiers à vocation consultative dans les communes de plus de 20 000 habitants, rendus obligatoires au-delà de 80 000 habitants, intégrant les élus, des “personnalités représentatives” et des associations locales. Dans les villes de plus de 50 000 habitants étaient institués des missions d’information et d’évaluation des services publics locaux pour peu qu’un sixième des membres du conseil municipal le demande. Au passage, la loi de 2002 transformait la CNDP en haute autorité indépendante, tellement indépendante que l’on en entend quasiment jamais parler !

S’en est suivie une révision constitutionnelle en mars 2003 sous Jean-Pierre Raffarin, introduisant la démocratie directe à l’échelon local avec la possibilité d’organiser un référendum local décisionnel, un droit de pétition des citoyens permettant d’inscrire un sujet à l’ordre du jour d’une assemblée locale et l’organisation de consultations locales en cas de modification de l’organisation des collectivités territoriales, ce que François Hollande s’est bien gardé d’utiliser pour sa réforme des régions en 2015.

Comme les élus locaux sont maintenant obligés de consulter leurs citoyens pour les projets d’urbanisme, on voit fleurir des solutions connectées participatives pour découvrir ces plans et donner son avis. Les élus décident en dernier ressort. Cela permet de prendre en compte les avis des citoyens… ou pas, selon les forces en présence. La consultation en ligne pour des projets environnementaux sera même obligatoire à partir du 1ier janvier 2017, par une ordonnance du 5 août 2016 passée inaperçue, sauf des nombreuses civic techs qui se sont lancées sources créneaux.

Comme l’indique le site de la ville de Québec au Canada, dans la démocratie participative, “La consultation doit être crédible, transparente, utile à la prise de décision, efficace et déterminée dans le temps. La consultation doit satisfaire aux règles de l’art et aux règles éthiques usuellement reconnues, par exemple : accès à une documentation pertinente et de qualité, rédigée dans un langage compréhensible; délai suffisant pour s’approprier l’information; assemblée de consultation en deux temps distincts et se déroulant, au besoin, en plusieurs séances de manière à permettre la présentation du projet, de répondre aux questions du public et de rendre possible l’expression des opinions; rédaction et diffusion d’un rapport de consultation faisant état des opinions et des préoccupations des citoyens à l’égard du projet; diffusion d’une réponse motivée des décideurs et suivi”. La participation est donc pertinente lorsque les avis des citoyens sont véritablement intégrés et de manière argumentée dans la prise de décision. Sinon, c’est de l’enfumage pur et simple pour faire passer une décision déjà ficelée. Et c’est assez courant dans la pratique !

Qui s’exprime dans les consultations publiques ? Ce sont d’abord les gens qui s’en donnent le temps, l’énergie et ont parfois les compétences pour le faire. Ils protègent des intérêts établis ou au contraire, veulent en faire table rase, selon leur obédience.

Qui a du temps ? Ce sont surtout les seniors et ceux dont le métier dégage le plus de temps libre, notamment certaines catégories de fonctionnaires. Il y a aussi les militants associatifs, souvent passionnés, notamment dans les milieux de gauche voire d’extrême gauche et chez les alter-mondialistes et écologistes. Sinon, ce sont des corps constitués existants qui avaient plus ou moins déjà voie au chapitre. Mais cet engagement dépend surtout de la nature des sujets débattus.

Les plus actifs développent des capacités d’obstruction face à des projets immobiliers. Allant de recours en recours, ils en alourdissent les coûts et les délais, parfois de manière déraisonnable. Ces conflits soulèvent la contradiction entre l’intérêt local et l’intérêt général comme pour les riverains des aéroports ou le confort des parisiens face à celui des banlieusards qui traversent Paris pour aller travailler. Il en va de même lorsque l’on construit une autoroute, une ligne de TGV ou une déchetterie. La démocratie locale se heurte souvent aux limites du syndrome Nimby (“Not in my backyard”, soit “Pas dans mon jardin”). A contrario, les riverains de la Seine étaient probablement favorables à la fermeture aux véhicules des voies sur berge, mais pas forcément les banlieusards et autres livreurs obligés de passer par là en voiture. On a donc des pénalisés locaux pour des bénéficiaires globaux ou le contraire. Faut-il un référendum à chaque fois ? A quel niveau de la population ? Cette question reste à trancher !

Pour mener des consultations locales liées à l’aménagement du territoire, les élus locaux peuvent maintenant faire appel à des solutions modernes de réalité augmentée et/ou immersive pour faire découvrir les PLU à leurs citoyens. Nombre de startups se sont lancées dans ce créneau. Elles prennent généralement la forme d’agences de création de contenus qui travaillent en mode projet et avec peu d’économies d’échelle comme chez Artefacto. Au passage, l’agence Héritage Prod avait collecté 2,7 m€ de fonds régionaux de la région Aquitaine pour développer sa tablette Imanaya servant à visualiser le passé à Bordeaux, ce qui ne sert pas à prendre des décisions mais peut être intéressant d’un point de vue culturel et touristique. La société a fermé boutique fin 2015. Ce syndrome est courant dans nombre de startups visant les marchés publics, avec des approches produits déficientes, un manque flagrant d’économies d’échelle, des prétextes culturels, et des pompes à finances publiques qui compensent la difficulté à se financer par de l’equity via des business angels et des fonds d’investissement. Il est bien difficile dans ces conditions d’en faire de véritables startups.

La démocratie participative numérique permet aussi de préparer des budgets de collectivités locales. C’est ce qu’a mis en œuvre la Mairie de Paris en faisant appel à ses administrés pour gérer une partie – environ le dixième – du budget de la ville (500 m€). Ils ont réussi à ce jour à faire participer 500 000 votants. Pour ce faire, il faut à la fois convaincre les citoyens de s’y intéresser et surtout, former l’administration, l’acculturer au numérique, lui montrer que cela améliore la qualité de son travail. En effet, la démocratie participative sert aussi de nouveau mode d’intermédiation non pas entre les citoyens et les élus mais entre les citoyens et les administrations locales et nationales. Elles portent dans ce cas sur les détails opérationnels plus que sur de véritables choix politiques.

D’après Emmanuel Grégoire, adjoint de la Mairie en charge des Ressources Humaines, des services publics et de la modernisation de l’Administration qui intervenait le 8 octobre 2016 au Forum de la Civic Tech organisé par Axelle Lemaire à la Bellevilloise, la chaîne de production des services publics doit être revue. Il faut aussi pouvoir disposer d’outils informatiques pérennes et solides, qui assurent la confidentialité des données personnelles. Les outils numériques ne peuvent pas tout gérer. Et il faut aussi gérer la cohabitation entre anciens et nouveaux systèmes. Ainsi, lors du débat sur la fermeture des voies sur berge de la rive droite, la polémique est venue d’un outil de consultation “ancien”, la Commission d’Enquête alors qu’une majorité de parisiens auraient voté pour. La Mairie s’est alors expliquée sur la raison pour laquelle elle n’avait pas tenu compte de l’avis de la commission d’enquête.

Lors de ce Forum de la Civic Tech, des élus locaux intervenaient pour exprimer leurs besoins vis à vis des startups et PME du secteur. Myriam El Yassa de Besançon voudrait que les outils améliorent la représentativité des citoyens, notamment des femmes qui ne s’exprimeraient pas assez. Elle voudrait disposer d’outils de formation à l’usage des réseaux sociaux. Marc Lecerf de Fleury sur Orne, près de Caen, plaidait pour une solution intégrée et extensible, intégrant des MOOC, agrégeant d’autres applications, avec des outils de modélisation virtuelle en 3D. Il souhaitait aussi associer les différentes classes d’âge aux processus consultatifs, jusqu’aux enfants dans certains cas. Anne Le Henanff de Vannes souhaitait des applications qui ne relèvent pas de l’usine à gaz mais à même de répondre à des attentes métiers spécifiques comme la dématérialisation des services à la petite enfance. Elle veut des outils logiciels modulaires et bon marché, éviter les avenants à répétition et éviter la dépendance d’un prestataire unique. Elle souhaiterait aussi disposer de statistiques socio-démographiques sur les utilisateurs des services. De son côté, Didier Le Bourgeant, de la mairie de Rennes, voulait des solutions de gestion des créneaux des espaces sportifs. Enfin, Pascal Clouaire, de Grenoble, voudrait carrément disposer d’un aspirateur à comptes de réseaux sociaux qui puisse les géolocaliser sur une seule carte, histoire de mener facilement des consultations comme sur le prix du stationnement en voirie. Et d’envoyer ensuite des sondages dans les bons réseaux sociaux.

Les élus réclamaient sans la nommer une offre produit-plateforme-écosystème-architecture composants. Leurs aspirations illustrent le casse-tête des éditeurs de logiciels et des startups de civic tech : les demandes métiers sont multiples, l’approche produit difficile à créer et tout ce qui écarte une société d’une approche produit génère de faibles économies d’échelles et des insatisfactions clients. Cela explique certaines initiatives de création de solutions open source, que nous évoquerons dans l’article suivant.

Pour ce qui est de l’étranger, l’article de Wikipedia sur la démocratie participative met en avant le cas de la ville brésilienne Belo Horizonte. Vérifications faites dans ce document de Héloïse Nez paru en 2006, on se rend compte que le processus participatif s’appuie sur des strates hiérarchiques de réunions de concertation avec des élections de délégués pour aller à la réunion du dessus. Donc, en pratique, Internet n’a pas joué de rôle clé, le processus a remis en branle une forme de démocratie représentative parallèle à celle qui existait déjà et les citoyens ont eu l’impression de valider des décisions déjà prises par la municipalité. Ce résultat n’est pas inéluctable. Il suffit de délimiter les strates et d’afficher la capacité à prendre en compte les demandes des citoyens.

Ces processus de consultation mobilisent une toute petite frange des classes moyennes et aisées, plutôt âgée, et assez faiblement les classes populaires. Hélène Nez remarque que les citoyens impliqués sont “déjà souvent des militants politiques et associatifs, de telle sorte que l’inclusion politique par la participation concerne des citoyens déjà inclus dans le système représentatif”. Un principe que l’on peut déjà observer dans nombre d’autres occasions. Cette forme de démocratie participative fait donc intervenir un nombre réduit de citoyens que la démocratie représentative, même avec un faible taux d’abstention aux élections, mais ils agissent plus en profondeur sur les processus de décision. Enfin, comme l’illustre cette présentation sur des cas d’usage de démocratie participative locale appliqués à Paris, Brest, Grigny, Roubaix, Mérignac, Trémargat, Saillans (Drôme) et aussi Montréal, les formules qui fonctionnent sont très diverses et dépendent du contexte, du sujet et des acteurs locaux.

Cela ne veut pas dire que la démocratie participative est inutile, mais qu’il faut en relativiser l’impact et l’importance au regard de la démocratie représentative. Pour être cohérent, un processus de démocratie participative devrait être complété d’un processus de démocratie directe. A savoir, qu’après consultation, il faudrait des référendums locaux pour valider les décisions finales issues des processus participatifs pour éviter l’abus de pouvoir des élus. C’est une autre forme de “checks and balances” à imaginer. Reste à savoir s’il faudrait réserver cela uniquement à l’échelon local.

Au passage, on notera le paradoxe généré entre les velléités de développer la démocratie participative et celles visant à réduire le nombre d’élus locaux alors que, dans leur grande majorité, ce sont des conseillers municipaux non rémunérés qui représentent bien mieux la société civile que tous les autres élus de l’échelle nationale ou régionale.

La démocratie participative à l’échelle nationale

Des mécaniques de démocratie participative sont également lancées par les exécutifs à l’échelle nationale pour préparer des lois ou les faire accepter par le public.

Aux USA, Barack Obama a utilisé les outils de la démocratie participative pour mieux résister aux lobbies qui luttaient contre le vote puis l’application de l’Affordable Care Act (Obamacare) pendant son premier mandat. C’était un moyen d’organiser un contre-pouvoir populaire face au Congrès récalcitrant.

L’initiative WhiteHouse2.0 modernisait les outils de communication de la Maison Blanche en ajoutant aux traditionnelles conférences de presse, un compte Facebook, MySpace (!) et Twitter, puis ensuite Flickr (à rendre jaloux tout photographe de Pete Souza, celui qui officie auprès de Barack Obama, voir le documentaire de Discovery à son sujet), Vimeo, YouTube (où est notamment diffusée une vidéo hebdomadaire du Président) et même iTunes. Cela reste cependant des outils de communication descendants même si la voix montante est théoriquement possible. C’est un moyen de communiquer directement avec le public sans passer par l’entremise des médias traditionnels.

La Maison Blanche a aussi lancé We the People en 2011, un système permettant de créer des pétitions pour solliciter l’exécutif. Le code source utilisé tournant sous Drupal était symboliquement ouvert en open source sur GitHub. Une fois obtenues 100 000 signatures, la Maison Blanche s’engage à répondre. Ce qui ne veut pas dire qu’elle agira, particulièrement lorsqu’il s’agit de politique étrangère, un thème fréquent des pétitions. La même année, le gouvernement anglais lançait un processus équivalent, la e-petition platform demandant de son côté 10 000 signatures.

En février 2013 était organisé un Hackathon à la Maison Blanche, une initiative renouvelée en juin 2014 ! Le résultat ? Des applettes utilisant les données des pétitions avec un thermomètre du nombre de signatures, une carte géographique décrivant leur origine, diverses statistiques et un plugin WordPress.

Ce n’est cependant qu’un exemple parmi d’autres des initiatives d’open data du gouvernement américain, plutôt en avance de ce côté là, elles-mêmes intégrées dans l’Open Government Initiative. Au moment de la rédaction de cet article, le site data.gov permettait l’accès à 189 773 jeux de données. Le gouvernement français n’est pas en reste, ayant lancé son initiative open data en 2011. Le site data.gouv.fr propose l’accès à 19 215 jeux de données. Et il encourage les startups à les utiliser pour créer des solutions innovantes au service des citoyens.

L’autre best-practice souvent mis en avant est le processus de la e-participation législatif lancé en 2001 en Estonie et baptisé “Today I decide”. Il intègre les citoyens dans le processus de préparation des lois. L’évaluation de ce processus entre 2001 et 2007 par Andrew Glencross montre une certaine usure et décrue des propositions après l’année de lancement. Qui plus est, les participants étaient déçus de voir leurs propositions rejetées en majorité par les fonctionnaires et l’Etat. Environ 3000 citoyens s’étaient impliqués dans le processus sur une population totale de 1,3 millions d’habitants. Mais ce n’était qu’une des nombreuses initiatives de e-government estoniennes. Cet historique les fait remonter à 2001. Et elles continuent avec leur Plan 2014-2016, dans le cadre de l’initiative internationale Open Government Partnership lancée en 2011 par le Brésil, l’Indonésie, le Mexique, la Norvège, les Philippines, l’Afrique du Sud, le Royaume-Uni et les USA sous l’initiative de Hillary Clinton, alors Secrétaire d’Etat. Cette initiative vise notamment à développer la démocratie participative. Le quatrième sommet mondial aura lieu à Paris en décembre 2016. La France y a adhéré tardivement, en 2014, et en assure cette année la Présidence.

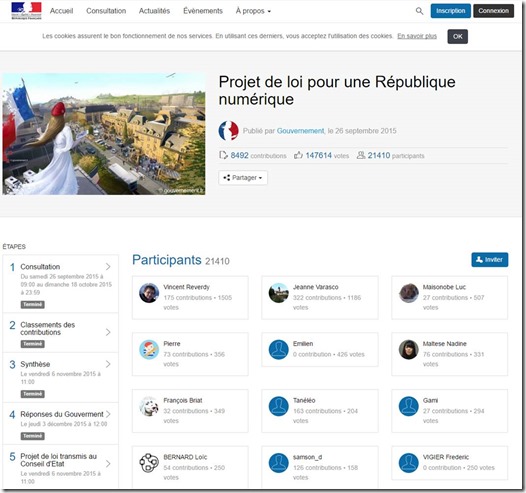

Autre exemple de démocratie participative lancée par un gouvernement, le processus de consultation en ligne lancé en 2015 par Axelle Lemaire sur son projet de loi République Numérique, voté à l’unanimité par le Sénat en septembre 2016 (mais pas à l’unanimité à l’Assemblée Nationale). Le processus de consultation en ligne était classique. Il a rassemblé près de 8500 contributions. Le gouvernement a répondu à ces dernières.

Le site de consultation de la loi République Numérique a été conçu par Cap Collectif, un éditeur d’applications participatives né en 2014 et issu de l’association Démocratie Ouverte qui a en tout près d’une trentaine de références clients, principalement des institutions nationales ou locales. Le développement logiciel proprement dit a été réalisé par la web agency JoliCode. Cette solution est commercialisée auprès des institutions pour 980 € HT par mois, ce qui est tout à fait raisonnable.

Les contributeurs comprenaient notamment des activistes habituels : associations de consommateurs, associations du logiciel libre, associations d’handicapés, et autres spécialistes. Les influenceurs de ce projet de loi n’étaient pas bien différents de ceux qui agissaient sur les lois précédentes. Dans la pratique, la différence portait plus sur l’ouverture et la traçabilité de ces sources d’influences. On peut observer de près la technicité des sujets qui ne sont pas compréhensibles par tous les citoyens. Elle grandit dans sa dimension juridique et réglementaire, par exemple lorsque les réponses du gouvernement font référence à des lois existantes ou à des directives européennes. Les associations ont été à la fois satisfaites et déçues du fonctionnement du processus participatif. Satisfaites quand la loin allait dans leur sens, et déçues dans le cas contraire, notamment sur le logiciel libre, la définition des communs et le droit de panorama. Dans ces derniers cas, le gouvernement a fait marche arrière, soit par réalisme, soit pour tenir compte des lobbies de la culture.

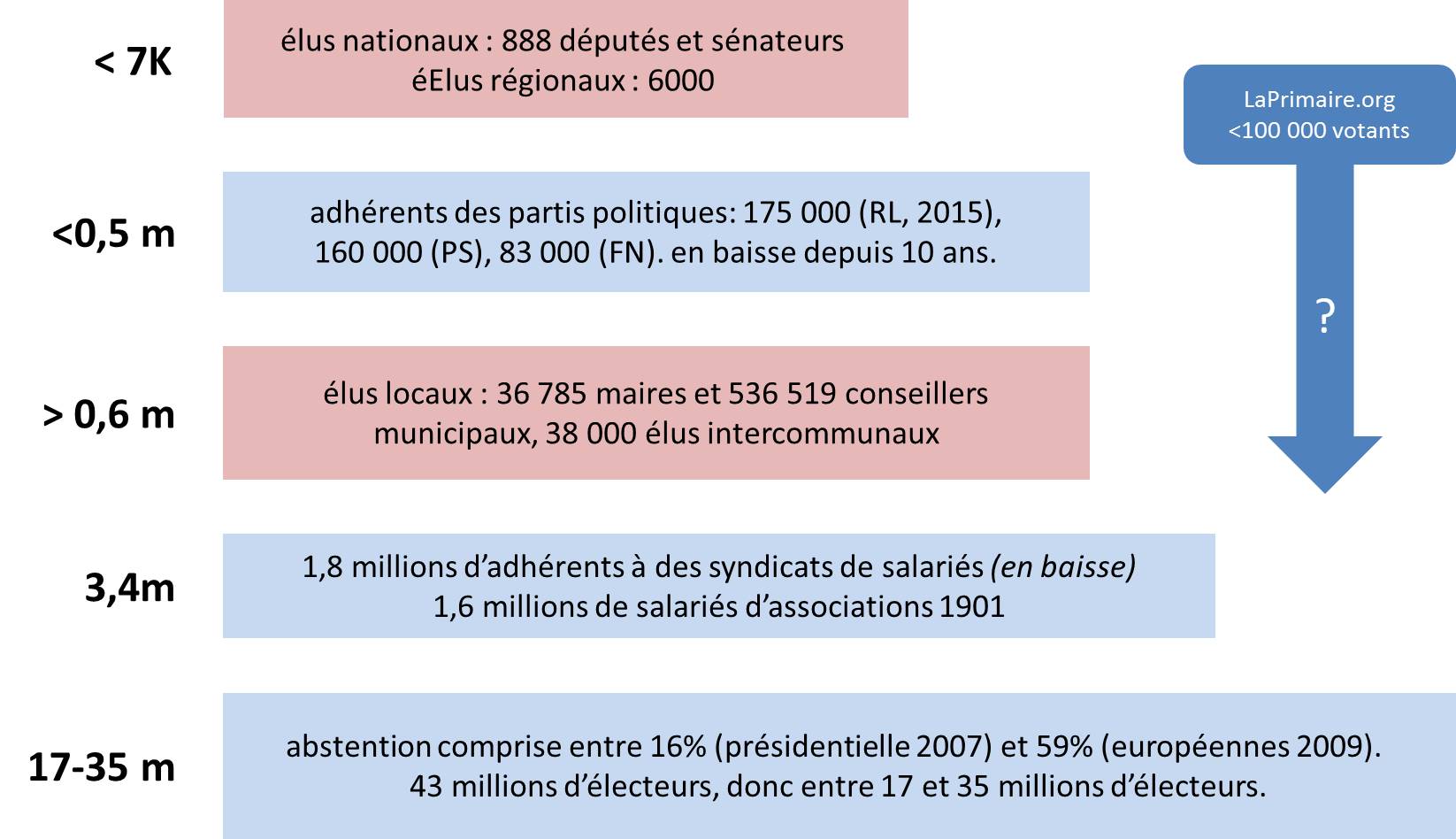

La démocratie participative est dans la pratique utilisée par une élite bien plus éduquée et informée que la moyenne des citoyens. Il n’y a pas de mal à cela. Cela en relativise le positionnement, situé dans la pratique dans une zone intermédiaire entre la démocratie représentative et une démocratie participative extensive, qui à ce jour est plutôt rare. L’un des moyens d’augmenter la proportion de citoyens impliqués est d’investir convenablement dans l’éducation. Et là, il y a aussi fort à faire !

En Suisse, les référendums fédéraux sont fréquents. Ils peuvent être déclenchés sous certaines conditions par les citoyens et cela fonctionne plutôt bien ! C’est un mélange de démocratie participative pour faire remonter les propositions, et de démocratie directe pour le vote de référendums. Les questions sont clairement exposées en ligne avec textes et vidéos. C’est de la sorte que les suisses se sont prononcés le 6 juin 2016 contre un revenu universel de base. Il en va de même dans les états des USA où ont souvent lieu des référendums en même temps que les élections présidentielles. Mais ces processus ne s’appuient pas particulièrement sur les outils numérique, surtout les référendums qui restent classiques.

Le numérique en campagne électorale et l’émergence du populisme 2.0

Les outils numériques ne sont pas utilisés que pour faire fonctionner la démocratie participative. Ils jouent un rôle de plus en plus critique dans les élections et servent surtout aux candidats pour mobiliser l’électorat.

Deux approches de mobilisation complémentaires coexistent : le bottom-up terrain et le top-bottom médiatique.

Le bottom-up permet de labourer le terrain et de faire du porte à porte de manière ciblée. Ce fut l’une des grandes innovations de la première campagne de Barack Obama. Les équipes de ce dernier utilisèrent de nombreux artifices numériques comme la mobilisation de volontaires par les réseaux sociaux et le démarchage ciblé sur le terrain ou via des centres d’appels, construit à partir de data-mining et de géomapping ciblant avec précision les swing voters. Cela avait pour objectif de réduire l’abstentionnisme des jeunes et des minorités et d’augmenter mécaniquement les votes démocrates. Au passage, cela servait à améliorer la représentativité des élus locaux (Sénateurs, Représentants). Le dispositif avait été simple en 2008 et perfectionné lors de la seconde campagne de Barack Obama en 2012.

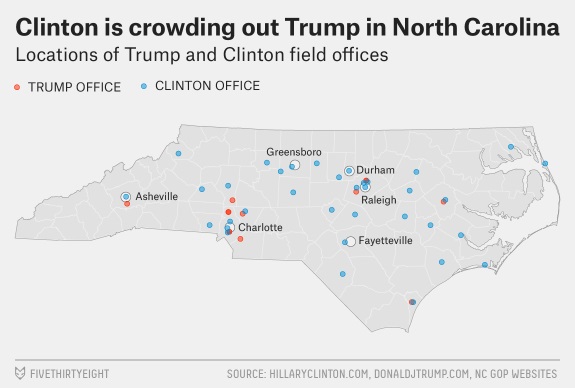

Il est aussi mis en œuvre par l’équipe d’Hillary Clinton pour l’élection présidentielle de 2016. Voir en référence le long read How Obama’s Team Used Big Data to Rally Voters par Sasha Issenberg paru en décembre 2012 ainsi que Where Clinton Is Setting Up Field Offices — And Where Trump Isn’t de Nate Silver avec l’exemple ci-dessous de la Caroline du Nord, l’un des swing states ainsi que Hillary Clinton’s ‘Invisible Guiding Hand’ publié sur Politico. De manière contrastée, ni l’équipe de Mitt Romney en 2012 ni celle de Donald Trump n’investit dans ces méthodes reposant sur les données. C’est dans la lignée d’une idéologie qui laisse peu de place à la rationalité et aux sciences, tout du moins pour Donald Trump.

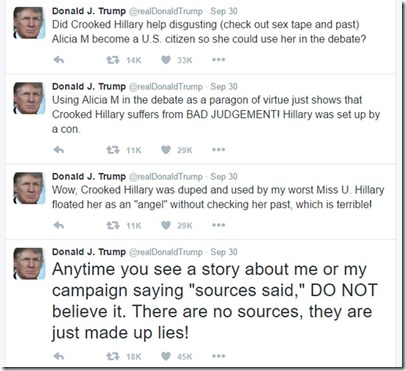

Le top-bottom exploite les réseaux sociaux et les applications mobiles pour faire passer les messages de mobilisation directement à ses supporters et court-circuiter les médias traditionnels. Donald Trump utilise à l’extrême Twitter pour faire passer ses messages simplistes et ses jugements à l’emporte-pièce. Hillary Clinton investit en plus sur la diffusion d’argumentaires et de fact checking sur son site et ses applications.

Nicolas Colin va jusqu’à qualifier Donald Trump de candidat post-fordiste face à une Hillary Clinton dépassée et utilisant de vieux procédés comme l’appel à de riches donateurs alors que son équipe utilise encore plus à fond les outils numérique que celle de Trump. A ceci près que dans le cas de Trump, il fait appel à la bêtise des foules plutôt qu’à son intelligence comme est censé le permettre le web 2.0. Voir aussi son Hillary’s Problem, Explained by Technology dont le titre initial “The case for picking Elisabeth Warren” a été modifié une fois Tim Kaine choisi par Clinton comme running mate. Nicolas Colin indique à juste titre qu’Internet valorise les positions extrêmes et que la modération n’y fonctionne pas, tout comme Trump a écrasé ses concurrents Républicains par ses outrances dans les débats télévisés qui n’avaient rien d’Internet. Donald Trump utilise aussi Twitter pour décrédibiliser les médias traditionnels qu’il accuse de mensonges répétés, et en particulier le New York Times qui est la principale cible de ses critiques. Trump est d’ailleurs à côté de la plaque lorsqu’il affirme que l’Internet est plus fiable que les médias pour trouver “la vérité”, dans la mesure où les médias traditionnels sont aussi largement diffusés sur Internet. Il fait allusion aux médias alternatives qui diffusent diverses théories du complot ! C’est le populisme 2.0 dans sa grande splendeur ! Mais à part cet usage de Twitter, la campagne de Trump est plutôt médiocre côté numérique !

Les grands outils de l’Internet permettent de diffuser des slogans qui tiennent en 140 caractères tout comme des textes approfondis comme The Obama doctrine de Jeffrey Golberg dans The Atlantic en mars 2016 (24 pages) et des contradictions comme Is there an Obama Doctrine? de Anthony H. Cordesman (21 pages). Mais les lois de la gravitation de la connaissance font que les Tweets ont plus d’impact que les longs textes et on retient plus facilement que Barack Obama est “faible” plutôt que “sage”. L’Internet n’a pas réduit la capacité des populistes extrêmes, il en a multiplié l’impact.

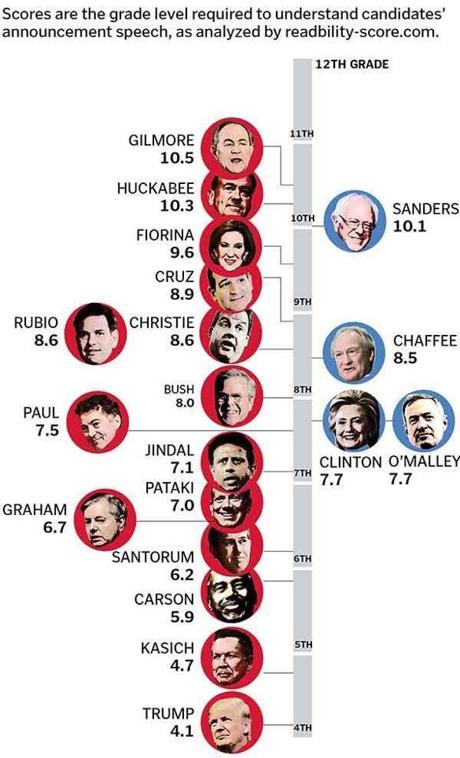

Qui plus est, le populisme est souvent associé à l’usage d’un vocabulaire simplifié à l’extrême. Le Boston Globe avait comparé le niveau de vocabulaire utilisé par les candidats aux primaires de l’élection présidentielle américaine fin 2015, montrant que Trump est au plus bas.

Là-dessus, l’Internet vient encore en renfort dans la bataille du fact-checking. Hillary Clinton a plusieurs fois insisté pour envoyer l’audience du premier débat du 26 septembre et du second du 9 octobre 2016 avec Donald Trump vers les pages de fact checking de son site web. Elle a aussi lancé à l’avance son appât Alicia Machado à Donald Trump qui est tombé dans le panneau en s’enfonçant encore plus… via Twitter ! 40 jours avant l’élection et 4 jours à ne parler que d’une ancienne Miss Universe ! Les bonnes stratégies de communication associent allègrement Internet, surtout Twitter, et les médias en ligne traditionnels et la TV. L’ancien conseiller en communication de George W. Bush, Karl Rove, ne rougirait pas de ces méthodes !

Donald Trump va probablement perdre cette élection présidentielle par les mêmes armes que celles qu’il a utilisées. Ses débordements ont été disséqués par les médias et le camp d’Hillary Clinton, qui l’ont cuisiné à petit feu dans tous les médias traditionnels tout comme sur Internet. Un véritable déluge, qui exploite notamment ses petites phrases dans les débats comme “That makes me smart” pour expliquer pourquoi il ne paye pas d’impôts, éviscérée pendant tout un excellent discours d’une demi-heure par Joe Biden à Philadelphie, et son attitude inadmissible envers les femmes, révélée à à plusieurs reprises.

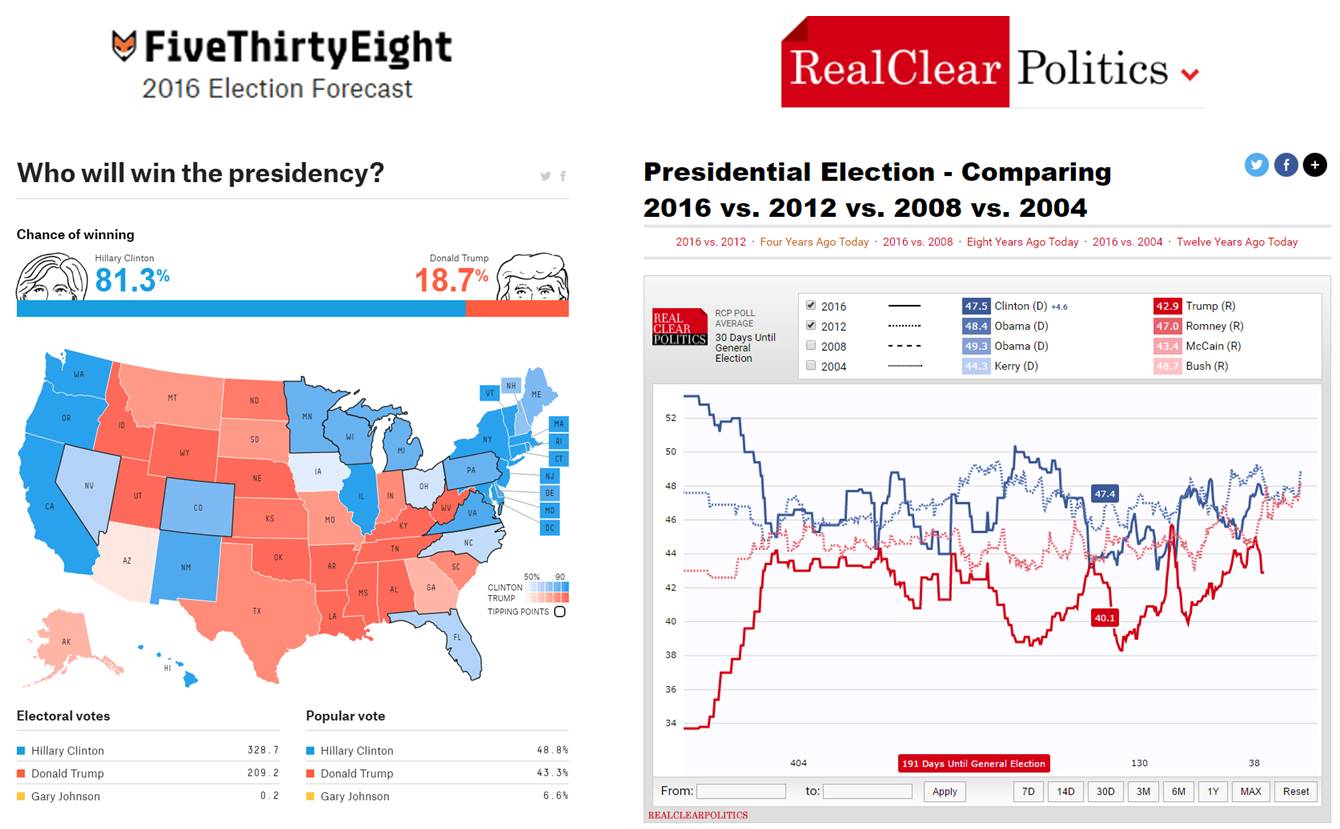

Les outils numérique entrent ensuite en ligne de compte dans l’exploitation des sondages. Le fameux Nate Silver utilise sur son site FiveThirtyEight des outils statistiques et des sondages pour prédire l’issue de grandes élections. Il s’est fait connaitre en prédisant la carte électorale état par état pour la présidentielle 2012. On attend de voir pour sa prédiction pour celle de 2016 (ci-dessus à droite). De son côté, RealClearPolitics fait la synthèse de nombreux sondages pour obtenir un résultat équivalent. Et les données montrent que la victoire d’Hillary Clinton semble aujourd’hui encore plus assurée que ne l’était celle de Barack Obama contre Mitt Romney en 2012, de quoi contredire Michael Moore qui prédisait il y a quelques temps la victoire de Donald Trump avant de présenter ensuite sa méthode pour le battre.

[PS du 9 novembre : bon, oui, les propos ci-dessus me foutent la honte après la victoire de Donald Trump… ]

Plus il y a de données, plus on peut suivre en temps réel l’évolution de l’opinion. On peut aussi critiquer abondamment les sondages alors qu’il faudrait s’intéresser aux sondés qui changent d’avis comme de chemise en fonction des soubresauts médiatiques.

Autre méthode top-bottom, la publication d’un livre diffusé gratuitement, comme vient de le faire Alain Juppé avec “De vous à moi”, une sorte de profession de foi un peu allongée mais pas un livre programme. Et surtout, un moyen de collecter au passage des mails de militants potentiels !

La communication directe via Internet et le relais des médias sociaux permet aussi de propager des idées toutes faites non validées scientifiquement ou historiquement. Il faut beaucoup de discernement et de temps pour séparer le bon grain de l’ivraie. En voici quelques exemples…

Il y a toute la campagne sur le “basic income”, le revenu inconditionnel garanti où il est souvent indiqué qu’il a été testé en Finlande alors que le test ne fait que commencer et à petite échelle. Nicolas Colin a bien démonté les mythes associés. Les argumentaires sur cette nouvelle méthode de redistribution relèvent d’un jeu de bonneteaux complexe à analyser. Notamment pour ce qui est du financement de la couverture sociale des personnes démunies, une partie de celle-ci servant à financer le revenu minimum, selon les formules proposées.

C’est aussi le cas avec les “bullshit jobs” qui seraient créés volontairement par les organisations, y compris les entreprises privées soumises à la concurrence. Cette idée de David Graeber publiée en 2013 n’a aucun fondement scientifique et quantitatif, surtout dans le secteur privé. Mais elle est relayée à de nombreux endroits comme une vérité !

Il y a aussi des idéologues de plateau TV comme ce Etienne Chouard qui déforme à souhait la réalité pour dévaloriser la démocratie représentative et dénoncer deux siècles d’échecs du suffrage universel, pour proposer la création d’une Assemblée Constituante tirée au sort. Cf le fameux extrait de 2014 et son débat face à Jacques Attali qui cherche à démonter son discours conspirationniste selon lequel “C’est une bande de familles très riches qui financent les marionnettes politiques que sont les élus. Le régime de gouvernement représentatif n’est pas la démocratie. Il est anti-démocratique. Il a été construit précisément et sciemment pour interdire au peuple toute forme de démocratie.”. Il idéalise la démocratie athénienne qui ne donnait dans la pratique la parole qu’à une minorité. Et le gars glisse gravement dans ses définitions approximatives de l’extrême droite et du fascisme. Pour lui l’Europe actuelle et même François Hollande sont des fascistes. On n’a pas lu les mêmes livres d’histoire ! Utiliser ainsi des théories du complot pour abaisser la démocratie représentative est plutôt nauséabond !

Le numérique dans les programmes électoraux

Les acteurs du numérique s’efforcent depuis deux décennies à faire rentrer le numérique dans les grands débats politiques. Surtout pour valoriser les opportunités entrepreneuriales associées et la nécessité de moderniser les entreprises françaises, petites, moyennes et grandes, via la “transformation digitale”.

A chaque élection, le numérique gagne quelques points de parts de voix. Il apparaît dans les programmes des candidats et avec des nuances. En 2007 et surtout 2012, il était surtout question de fracture digitale ainsi que d’équipement haut débit et très haut débit. L’encouragement à l’entrepreneuriat n’est arrivé que tardivement dans le débat politique. Le thème avait été quelque peu négligé pendant le quinquennat de Nicolas Sarkozy. C’est de manière imprévue que les gouvernements Ayrault puis Valls s’en sont emparés, à la suite de la révolte des pigeons lancée à l’automne 2012 après la promulgation d’une loi de finances rectificative alourdissant la fiscalité des investisseurs et des entrepreneurs.

Les partis politiques sont de plus en plus perméables aux cercles d’influence entrepreneuriaux et du numérique. En 2012, un collectif du numérique avait organisé un débat entre les représentant des deux candidats du second tour : Nicolas Princen pour Sarkozy et Fleur Pellerin pour Hollande. On avait par contre très peu vu les candidats s’exprimer directement sur ces questions.

La présidentielle de 2017 change la donne. Presque tous les candidats LR (Les Républicains) ont intégré l’entrepreneuriat et l’innovation dans leurs programmes. Après s’être exprimés aux Universités d’été du MEDEF en août, les principaux candidats LR participaient coup sur coup aux Primaires de l’économie organisées mardi 27 septembre 2016 à la Maison de la Chimie par l’ACSEL, Croissance Plus, Meti (qui représente les entreprises de taille intermédiaire), France Biotech et France Digitale. Alain Juppé et François Fillon rempilaient le surlendemain au France Digitale Day dans la grande Halle de la Villette. Comme l’indiquait Nicolas Barré sur Europe 1 avant d’intervenir lors du France Digitale Day, “le numérique plus important que le burkini pour le futur de la France”.

Des candidats actuellement en lice, c’est François Fillon qui a le plus travaillé le thème de l’entrepreneuriat et du numérique. C’est d’ailleurs le plus geek des candidats, ce depuis au moins une vingtaine d’année. Le programme numérique d’Alain Juppé est assez voisin dans l’esprit ? Mais ces programmes ont tendance à enfoncer des portes ouvertes et proposent dans pas mal de cas des mesures qui sont déjà en place et qui peuvent être améliorées à la marge.

La mode est à l’apprentissage du code à l’école ? C’est dans les programmes… alors que Najat Valaud-Belkacem a déjà lancé la machine de l’Education Nationale autour de cet objectif. Nicolas Sarkozy fait un peu bande à part avec une attitude plutôt rétrograde. Il veut protéger à tout prix le salariat et lutter contre la concurrence déloyale du travail non salarié. A gauche, Benoit Hamon veut lancer le revenu universel garanti en s’appuyant, dans son raisonnement, sur le fait que l’intelligence artificielle et la robotisation vont supprimer des millions d’emplois. Mais c’est mettre la charrue avant les bœufs car ces suppressions d’emplois sont des hypothèses qui dans le meilleur des cas se réaliseront lentement. On entendait la même prédiction dans l’événement de En Marche du 4 octobre, selon laquelle 50% des emplois seraient automatisés dans les 10 ans qui viennent ! Un prévision qui date de 2013 mais n’est pas encore validée dans la pratique ni d’un point de vue technologique. Et pour cause, puisque l’étude repose surtout sur des hypothèses statistiques et pas sur la réalité technologique de l’automatisation des métiers. Oui, l’IA fait de grands progrès en ce moment et j’en avais fait un inventaire dans un dossier récent. Mais pas au point de remplacer la moitié des métiers, même en extrapolant ce qui pourrait se passer avec les experts-comptables et les centres d’appels !

Les grands partis ont cependant compris la colère qui montait sur le fonctionnement de la démocratie. Certains candidats proposent des ajustements dans son fonctionnement, y compris d’augmenter le poids de la démocratie participative. Arnaud Montebourg a lancé un processus participatif en ligne pour créer son programme.

Sans que cela en prenne la même forme, les candidats de droite mènent des consultations assez larges dans l’industrie pour consolider leurs propositions et construire leurs programmes. Par rapport aux processus ouverts de consultation, cela présente l’inconvénient de ne pas pouvoir disposer d’une traçabilité des propositions. En même temps, un bon leadership politique relève de la capacité à intégrer des idées d’origines disparates et d’en faire un tout cohérent.

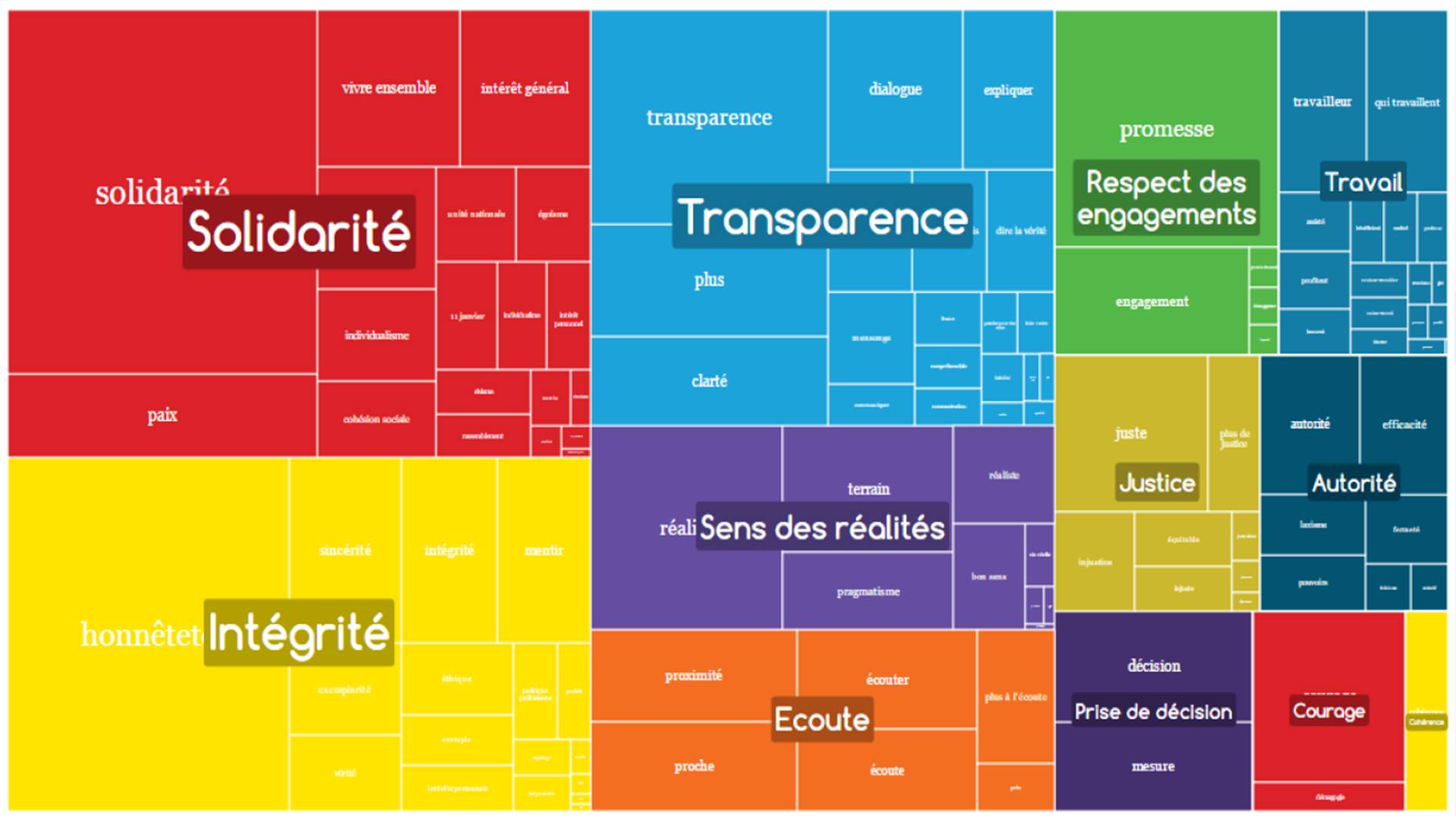

Avant les propositions, il faut faire un diagnostic partagé. C’est ce que se propose de faire Emmanuel Macron pour son mouvement “En marche” qui a sillonné la France dans sa “grande marche” pour faire parler “la France qui subit”. En est sorti un diagnostic consolidé de 176 pages produit via la solution de la startup Proxem qui édite un logiciel d’analyse sémantique et présenté à Strasbourg le 4 octobre 2016. C’est cette solution qui permet par exemple de générer un diagramme à la Mondrian (ci-dessus) des valeurs exprimées par les dizaines de milliers de personnes interrogées dans toute la France. En pratique, ce qui a été produit décrit des symptômes consolidés sous forme de verbatim. Reste à expliquer pourquoi ça va mal puis à passer à une proposition de prescription. C’est là que la politique, les idéologies et la vision que l’on a de l’économie mondiale font diverger les avis.

Ceci étant dit, on attend le jour où le programme numérique des candidats sera évoqué dans le débat d’entre les deux tours entre les candidats finalistes. Comme il y a fort à parier que ce soit un débat entre Marine Le Pen et un candidat de droite, il portera plus sur l’Europe, la sécurité et l’immigration que sur les enjeux économiques liés aux technologies. Il faudra attendre 2022 voire 2027 pour que cela change.

____________________________________

Dans la partie suivante, nous ferons le tour des civic techs spécialisées dans les applications de démocratie participative.

____________________________________

Voici toutes les parties de cette série d’articles :

Partie 1 : les limites de l’action traditionnelle de la société civile, démocratie représentative, participative et directe, l’impact sociétal du numérique.

Partie 2 : la démocratie participative à l’échelle locale, à l’échelle nationale, le numérique en campagne électorale et le populisme 2.0, le numérique dans les programmes électoraux.

Partie 3 : l’essor des civic techs, les mouvements associatifs citoyens, les civic techs de la démocratie participative, petit tour aux USA.

Partie 4 : quand la démocratie participative se veut représentative avec notamment un passage en revue des candidats de LaPrimaire.org et d’autres initiatives du même genre.

Partie 5 : les grands du numérique privatisent-ils la démocratie ? L’intelligence artificielle au secours du politique ? La constructions citoyenne de plans structurés. L’arbitraire séparation entre citoyen actif et politiques. De la démocratie participative au leadership 2.0.

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

En complément de ta longue analyse, pour l’utilisation du numérique dans la campagne électorale US par Trump et Clinton, je recommande les articles totalement neutres politiquement sur le blog de David Meerman Scott: http://www.webinknow.com.

Il faudrait en fait aussi ajouter une autre question : nos démocraties peuvent-elles fonctionner sans croissance ? Les réflexions sur les adaptations à envisager débutent malheureusement à peine (par exemple : https://yannickrumpala.wordpress.com/2015/06/07/conclusion-sur-laccompagnement-democratique-dune-sortie-de-la-croissance/ ).

En effet.

Il y a plein d’autres questions de ce genre :

– Les démocraties face à l’IA et à la robotisation.

– Les démocraties face à la crise environnementale.

– Les démocraties face aux GAFA…

Article très fourni, il va être intéressant de regarder comment cela va fonctionner sur la France avec les primaires puis les présidentielles.

Je vous invite à découvrir mon article sur les CivicTech rédigé sur le blog du MBAMCI de l’Institut Léonard de Vinci et épinglé sur mon compte twitter http://www.mbamci.com/civictech-redonne-pouvoir-aux-citoyens/

Au plaisir de lire la suite 😉

Je traite de la présidentielle dans la partie 4 de la série, me penchant sur les programmes des candidats qui sortent de processus participatifs comme celui de LaPrimaire.org. Dans l’ensemble, je trouve la méthodo intéressante mais le résultat décevant. Les citoyens de base ne sont pour l’instant pas bien meilleurs que les politiques professionnels. Ils ont ce côté frais et naïf qui plait au premier abord. Mais quand on creuse, on a du mal à dépasser les discussions de salon. Il leur manque une vue d’ensemble, surtout pour une présidentielle. Certains ne savent même pas comment fonctionne l’exécutif, comment est votée une loi, comment on gère le temps long et le temps court. Aucun n’émet de vision de politique étrangère. Rare sont ceux qui intègrent les enjeux technologiques à venir et engagent une réflexion sur l’avenir du travail avec la robotisation.

Oui évidemment. J’ai aussi regardé c’est très juste je vous l’accorde.

Mais sans aller jusqu’à se présenter, les citoyens lambda peuvent avoir de bonnes idées. Avez vous vous vu hier dans l’Emission politique le coup de gueule d’Alexandre Jardin face à Bruno Lemaire ? Il était furieux car il ne comprend pas pourquoi les politiques veulent imposer leur vision et programme sans proposer de travailler des solutions avec les citoyens. Une piste intéressante

Bon oui ils vont tous nous dire qu’ils écoutent, échangent, etc avant de proposer mais quid de deux notions du monde de l’entreprise appliquées à la politique : Je pense à la co création et à l’intelligence collective. Et si un politique le mettait vraiment en place ?

Je n’ai pas vu cette passe d’armes mais l’intervention d’Alexandre Jardin dans le meeting d’Emmanuel Macron du 12 juillet à la Mutualité (en streaming). Je trouve qu’Alexandre Jardin en fait un peu trop. Il mélange l’activité terrain d’association, souvent de l’entrepreneuriat social et solidaire et la politique générale du pays. Il y a toujours de très bonne idées venant du terrain bien évidemment, mais elles ne se transforment pas en politique nationale pour autant. D’autant plus qu’une fois fonctionnarisées ou généralisées, elles perdent de leur fraîcheur et de leur naturel.

Par exemple, Alexandre Jardin s’intéresse à l’exclusion, mais pas à l’enseignement supérieur, à la recherche, à l’innovation technologique ou à la politique étrangère, qui sont aussi du ressort de l’Etat et des politiques.

Bref, c’est un peu un dialogue de sourds qui ne sont pas sur le même registre.

Très intéressant

Bravo pour cette analyse détaillée

A nous de faire émerger toutes ces idées pour que cela change bien avant 2022 ou 2027

@axellelemaire @bfmbusiness Version longue par écrit… (4 parties) https://t.co/l7gEVOiL4Z