Après un peu de sémantique, un tour des techniques de l’IA, l’étude de cas d’IBM Watson, un tour d’horizon des startups américaines de l’IA, puis de celles qui sont acquises par les grands groupes et enfin, des startups françaises du secteur, je vais m’intéresser d’abord au fonctionnement du cerveau pour en évaluer la complexité et la difficulté à en modéliser le comportement dans de l’IA.

Imiter ou s’inspirer du cerveau humain

Le concept même d’IA ne fait pas l’unanimité dans sa définition. Pour les puristes, un simple réseau de neurones ou un système de reconnaissance d’images ne relève pas à proprement parler de l’IA. Tout dépend de la définition que l’on se donne de l’IA, et notamment si la définition est anthropocentrée ou pas.

C’est un peu comme la magie. Tant que l’on ne connait pas le truc, c’est de la magie voire de l’art. Une fois qu’on le connait, c’est une technique, souvent très simple, si ce n’est évidente. L’intelligence humaine est un peu du même ressort quand on n’en connait pas le fonctionnement exact. Elle préserve ce côté mystérieux et inimitable, presque immatériel, comme une âme qui n’aurait pas d’existence physique.

Au gré des découvertes en neurobiologie et en sciences cognitives, cette magie perd petit à petit de son lustre. L’homme n’est après tout qu’une machine biologique très sophistiquée issue de l’évolution. Certes, une machine complexe, une machine dont le fonctionnement dépend d’un très grand nombre de paramètres environnementaux et de l’accumulation d’expériences, mais une machine tout de même. C’est la première d’entre elles qui soit d’ailleurs capable d’en comprendre son fonctionnement interne !

Doit-on absolument chercher à copier ou imiter le cerveau humain pour créer des solutions numériques ? Dans quel cas l’imitation est-elle utile et dans quels cas l’inspiration seulement nécessaire ? Doit-on chercher à créer des machines plus intelligentes que l’homme dans toutes ses dimensions ?

L’exemple de l’aviation peut servir de bonne base de réflexion. L’avion s’inspire de l’oiseau mais ne l’imite pas pour autant. Les points communs sont d’avoir des ailes et d’utiliser la vitesse et la portance des ailes pour voler.

Le concept diverge alors rapidement : les avions n’ont pas d’ailes mobiles faites de plumes ! En lieu et place, leurs ailes sont généralement fixes et les moteurs sont à hélice ou sont des réacteurs. L’avion dépasse largement l’oiseau dans la vitesse (supersonique pour les avions militaires), la taille (B747, A380, Galaxy C5, Antonov 124), la capacité d’emport (qui se mesure en dizaines de tonnes), l’altitude (10 km pour un avion de ligne) et la résistance du froid (il y fait environ -50°C, ce qu’un organisme biologique développé peu difficilement supporter longtemps, même avec un bon plumage). Les avions sont par contre très inférieurs aux oiseaux côté efficacité énergétique et flexibilité, même si la densité énergétique de la graisse animale est voisine de celle du kérosène (37 vs 43 Méga Joules/Kg).

Le bio-mimétisme a été utile au début pour conceptualiser l’avion, que ce soit dans les schémas de Léonard de Vinci ou de l’avion de Clément Ader qui étaient très proches de l’oiseau. Si la motorisation d’un avion est très différente de celle des oiseaux qui battent de l’aile, les plumes se déployant au moment de l’atterrissage et du décollage sont cependant réapparues sous la forme des volets hypersustentateurs, inventés par Boeing pour ses 707 lancés à la fin des les années 1950 (description) et dont la forme la plus élaborée a été intégrée aux Boeing 747 (ci-dessous), dont les premiers vols ont eu lieu en 1969.

L’aigle est l’un des oiseaux les plus rapides au monde, atteignant 120 Km/h. Un avion de ligne classique atteint 1000 Km/h et il touche le sol, volets hypersustentateurs déployés, à environ 200 Km/h. Un A380 décolle en 2700 m et atterri sur 1500 m. Un aigle se pose en quelques secondes et presque n’importe où ! C’est la puissance contre la flexibilité. Il faut se pencher du côté des drones de poche pour retrouver une part de la flexibilité des oiseaux mais leur autonomie est généralement bien plus limitée que celles des oiseaux, surtout les oiseaux migrateurs qui peuvent voler plusieurs heures d’affilée avant de se reposer au sol.

L’IA suit un chemin voisin dans le biomimétisme : certaines caractéristiques du cerveau des mammifères sont imitées dans les réseaux de neurones, le machine et le deep learning. Mais des différences fondamentales font diverger intelligence humaine et de la machine : à la fois ses entrées et sorties tout comme la structure de sa mémoire et du raisonnement. La machine se distingue pour l’instant par la capacité de stockage et d’analyse d’immenses volumes d’information et par sa puissance de calcul brute.

L’homme dispose de capteurs sensoriels en quantité astronomique qu’aucun objet connecté n’égale à ce stade, ce qui, associés au cortex, lui procure une mémoire sensorielle qui accumule les souvenirs pendant toute son existence, provenant des entrées/sorties que sont les nerfs optiques, auditifs et olfactifs, ainsi que ceux qui gèrent le toucher, faits de millions de neurones irrigant en parallèle notre mémoire sensorielle. C’est une force et une faiblesse. Nos émotions liées à cette mémoire sensorielle génèrent la peur de certains risques et des prises de décisions pouvant être irrationnelles. Ensuite, le niveau de complexité du cerveau dépasse l’entendement.

Il n’empêche que, par la force brute, l’IA dépasse déjà l’homme dans tout un tas de domaines, notamment lorsqu’il faut “cruncher” de gros volumes de données qui nous échappent complètement. Quand elle a accès à de gros volumes de données comme dans l’oncologie ou en exploitant les données issues d’objets connectés, l’IA peut faire des merveilles.

Elle est d’ailleurs plutôt inopérante sans données. Elle ne sait pas encore quoi chercher ni prendre d’initiatives. Et les algorithmes sont encore très limités car les données de notre vie ne sont, heureusement, pas encore consolidées. Cela explique les limites de ces algorithmes de recommandation qui ne savent pas ce que j’ai déjà vu ou fait et ne sont pas prêts de le savoir. Ils ne peuvent donc pas faire de recommandation totalement pertinente. Le jour où toute notre vie sera suivie par des objets connectés depuis la naissance, il en sera peut-être autrement.

Qu’en est-il du raisonnement humain ? Celui-ci ne semble pas hors de portée des machines. On arrive petit à petit à le modéliser pour des tâches très spécialisées. Mais l’IA manque encore de souplesse et de capacité d’adaptation à une grande variété de situations. Bref, de jugeote ! Mais il n’est pas inconcevable d’arriver à fournir une intelligence générique à une machine. On y arrivera pas tâtonnements, par intégration de briques algorithmiques et logicielles disparates, et pas seulement via la force brute de la machine.

De grandes initiatives de recherche cherchent à décoder le cerveau

Comprendre le cerveau en modélisant son fonctionnement reste cependant un objectif de nombreux chercheurs. L’idée n’est pas forcément de le copier, mais au moins de mieux connaitre son fonctionnement pour découvrir des traitements de certaines pathologies neurodégénératives.

De nombreuses initiatives de recherche nationales et internationales ont été lancées dans ce sens. Inventoriées ici, elles sont issues d’Europe, des USA, mais aussi du Japon, d’Australie, d’Israël, de Corée et d’Inde.

Le projet européen Human Brain Project vise à simuler numériquement le fonctionnement d’un cerveau. Lancé après la réponse à un appel d’offre par Henry Markram de l’EPFL de Lausanne, un chercheur à l’origine du Blue Brain Project lancé en 2005, qui vise à créer un cerveau synthétique de mammifère. Construit à partir d’un supercalculateur Blue Gene d’IBM et faisant tourner le logiciel de réseau de neurones de Michael Hines, le projet vise à simuler de manière aussi réaliste que possible des neurones.

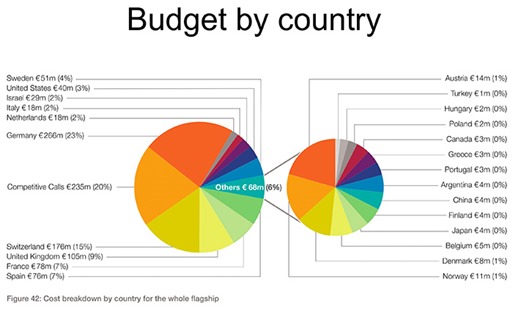

Disposant d’un budget communautaire de 1Md€ étalé sur cinq ans, le Human Brain Project ambitionne de manière aussi large que possible d’améliorer la compréhension du fonctionnement du cerveau, avec en ligne de mire le traitement de pathologies neuro-cérébrales et la création d’avancées technologiques dans l’IA. Il est critiqué ici et là. Il fait penser un peu à Quaero par son aspect disséminé. Les laboratoires français ont récolté 78m€ de financement, notamment au CEA, tandis que ceux d’Allemagne et la Suisse se sont taillés la part du lion avec respectivement 266m€ et 176m€. On se demande qui fera l’intégration !

Dans la pratique, c’est plutôt un projet de big data qui s’éloigne du cerveau. En effet, les modèles de simulation ne s’appuient plus du tout sur la connaissance biologique actualisée que l’on du fonctionnement des neurones dans le cerveau.

Les USA ne sont pas en reste avec la BRAIN Initiative annoncée par Barack Obama en 2013. Elle vise à mieux comprendre le fonctionnement du cerveau. L’objectif annoncé semble plus opérationnel que celui des européens : mieux comprendre les maladies d’Alzheimer et de Parkinson ainsi que divers troubles neuronaux. Le budget annuel est de l’ordre de $100m, donc, in fine, du même ordre de grandeur que le Human Brain Projet. Parmi les projets, on trouve des initiatives en nano-technologies pour mesurer l’activité individuelle de cellules nerveuses, à commencer par celles des mouches drosophiles.

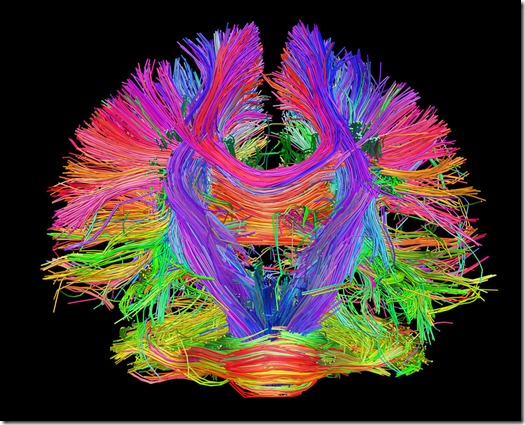

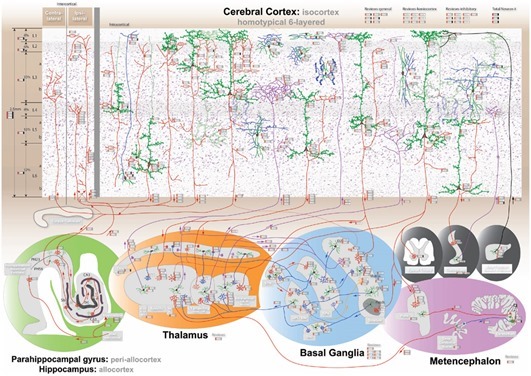

On peut aussi citer le Human Connectome Project, lancé en 2009, un autre projet américain, financé par le NIH comme la BRAIN Initiative, et qui vise à cartographier avec précision les différentes régions du cerveau (exemple ci-dessus avec les principales liaisons nerveuses internes au cerveau).

De son côté, le projet Allen Brain Atlas planche sur la cartographie du cerveau de différentes espèces dont l’homme et la souris, au niveau de l’expression des gènes de ses différentes cellules nerveuses. La plateforme et les données associées sont ouvertes. Des chercheurs de l’Université de Berkeley ont même réussi à créer une cartographie précise de la sémantique du cortex.

Reste aussi, côté neurobiologie, à comprendre le processus d’’apprentissage des enfants en bas âge et jusqu’à 20 ans. Comment le cerveau se câble-t-il pendant les phases d’apprentissage ? Comment séparer l’inné de l’acquis dans les processus d’apprentissage ? On dissèque les souris, mais bien évidemment pas les enfants en bas âge. Donc, on ne sait pas trop. Et l’IRM est insuffisante. Les chinois et les japonais planchent sur une voie intermédiaire en cartographiant le cerveau de singes qui sont plus proches de l’homme que les rongeurs.

Pour résumer, un bon nombre de recherches portent sur le fonctionnement du cerveau, avec une intersection avec les recherches en intelligence artificielle.

La copie du cerveau n’est pas pour demain et heureusement

Dans “The Singularity is Near”, Ray Kurweil fantasme sur la capacité à venir de transplanter un cerveau dans une machine et d’atteindre ainsi l’immortalité, incarnation ultime du solutionnisme technologique qui cherche à trouver une solution technologique à tous les problèmes ou fantasmes humains.

Le dump du contenu d’un cerveau dans un ordinateur fait cependant face à quelques obstacles technologiques de taille. Heureusement d’ailleurs !

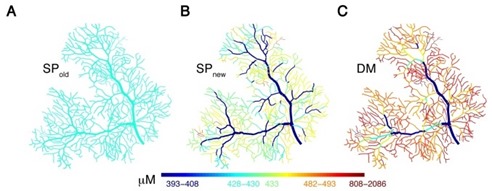

Quels sont-ils ? Tout d’abord, on ne sait pas encore précisément décrire le mode de stockage de l’information dans le cerveau. Se situe-t-il dans les neurones ou dans les synapses qui relient les neurones aux axones d’autres neurones ? Dans “Memories may not live in neurons synapses” paru dans Scientific American en 2015, il est fait état que l’information serait stockée dans les neurones et pas au niveau des synapses. Ce stockage est-il du même ordre dans le cortex et dans le cervelet ? Qu’en est-il du cerveau limbique qui gère les émotions, le bonheur et la peur, en interagissant à la fois avec le cortex et avec les organes producteurs d’hormones ? On cherche encore !

La science progresse aussi pour cartographier le cerveau politique. Ici, sur le clivage républicains et démocrates aux USA qui est toujours d’actualité. Source.

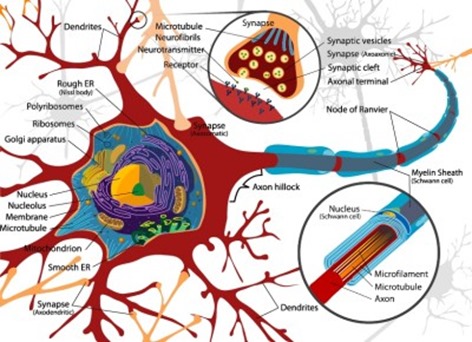

Quoi qu’il en soit, l’information est stockée sous forme de gradients chimiques et ioniques. Probablement pas sous forme binaire (“on” ou “off”) mais avec des niveaux intermédiaires. En langage informatique, on dirait que les neurones stockent peut-être des nombres entiers voire flottants au lieu de bits individuels. Il n’est pas exclu non plus que les neurones puissent stocker plusieurs informations à différents endroits (dendrites, synapses, axones). Et il n’y a que quelques nanomètres entre les dendrites et les terminaisons des axones ! La communication entre les deux est chimique, via un potentiel d’ions calcium, sodium et potassium, et régulée par des hormones de régulation de la transmission nerveuse telles que l’acétylcholine, la dopamine, l’adrénaline ou des acides aminés comme le glutamate ou le GABA (acide γ-aminobutyrique) qui bloquent ou favorisent la transmission d’influx nerveux. A cette complexité, il faut ajouter l’état des cellules gliales qui régulent l’ensemble et conditionnent notamment la performance des axones via la myéline qui l’entoure. La quantité de myéline autour des axones est variable d’un endroit à l’autre du cerveau et module à la fois l’intensité et la rapidité des transmissions nerveuses. Cela fait une complexité de plus dans le fonctionnement du cerveau !

Et si la mémoire n’était constituée que de règles et méthodes de rapprochement ? Et si le savoir était en fait encodé à la fois dans les neurones et dans les liaisons entre les neurones ? En tout cas, le cerveau est un gigantesque puzzle chimique qui se reconfigure en permanence. Les neurones ne se reproduisent pas mais leurs connexions et la soupe biologique dans laquelle elles baignent évoluent sans cesse.

Comment détecter ces potentiels chimiques qui se trouvent à des trillions d’endroits dans le cerveau, soit au sein des neurones, soit dans les liaisons interneuronales ? Comment le faire avec un système d’analyse non destructif et non invasif ?

Il n’y a pas 36 solutions : il faut passer par des ondes électromagnétiques, et avec une précision de l’échelle du nanomètre. Aujourd’hui les scanners utilisent généralement trois technologiques : la tomodensitographie qui mesure la densité de la matière par rayons X, les PET scanners qui détectent des traceurs biologiques radioactifs par émission de photons et l’IRM qui détecte les corps mous par résonnance magnétique nucléaire, qui n’irradie pas le cerveau mais doit le plonger dans un bain magnétique intense. Ces scanners ont une résolution qui ne dépasse pas l’ordre du millimètre et elle ne progresse pas du tout en suivant une loi exponentielle de Moore ! Il serait d’ailleurs intéressant d’évaluer la quantité d’énergie qu’il faudrait envoyer dans le cerveau (rayons X, magnétisme, etc) pour réaliser ce genre de détection 100 à 1000 trillions de fois, soit le nombre de synapses dans le cerveau, et avec une résolution de l’ordre du nanomètre. Si cela se trouve, cette énergie électromagnétique serait suffisante pour faire cuire le cerveau comme dans un four à micro-ondes, ce qui ne serait pas du tout un effet désiré ! Sauf peut-être pour traiter de manière un peu radicale certains abrutis.

C’est une loi connue dans la physique : plus on explore l’infiniment petit, plus c’est couteux en énergie. Le LHC du CERN près de Genève a permis de détecter les bosons de Higgs. Il consomme la bagatelle de 200 mégawatts avec des pointes de 1,3 gigawatts, soit plus que la puissance générée par une tranche de centrale nucléaire ! Le LHC a couté $9B et le prix de ce genre d’instrument scientifique ne suit pas du tout la loi de Moore comme le séquençage de l’ADN !

Des capteurs d’électro-encéphalogrammes existent bien (EEG). Ils sont placés à la périphérie du cortex sur la tête et captent l’activité de grandes zones de contrôle psychomotrices du cerveau avec un faible niveau de précision. C’est très “macro”. La mémoire et le raisonnement fonctionnent au niveau du “pico”. Qui plus est, si on sait cartographier approximativement les zones fonctionnelles du cerveau, on est bien incapable de capter le rôle de chaque neurone prise individuellement. Pourra-t-on connaitre avec précision la position de toutes les synapses dans l’ensemble du cerveau et à quels neurones elles appartiennent ? Pas évident ! Autre solution : cartographier le cortex pour identifier les patterns de pensée. Si on pense à un objet d’un tel type, cela rend peut-être actif des macro-zones distinctes du cerveau que l’on pourrait reconnaitre.

Dans The Brain vs Deep Learning Part I: Computational Complexity — Or Why the Singularity Is Nowhere Near, Tim Dettmers avance que la machine ne pourra pas dépasser le cerveau pendant le siècle en cours. Il démonte les prédictions de Ray Kurzweil. J’avais moi-même émis des doutes sur les exponentielles qui sont la primitive des raisonnements de Kurzweil en avril 2015 dans trois articles sur les dérives des exponentielles.

(source schéma ci-dessus sur quelques exemples de neurones cérébrales : http://neuromorpho.org)

Mais poursuivons dans la découverte fascinante de la complexité du cerveau. Celui-ci contient plusieurs centaines de types de neurones différents (source), les illustrations précédente et suivante n’en présentant que quelques grandes variantes. Le cervelet contient notamment ces étonnantes cellules de Purkineje, avec leur arbre de dendrites reliées avec jusqu’à 200 000 autres neurones, qui contrôlent les mouvements appris.

(source de l’illustration ci-dessus)

Cette complexité se retrouve aussi au niveau moléculaire avec de nombreuses protéines et hormones intervenant dans la transmission d’influx neuronaux, comme décrit dans Deep Molecular Diversity of Mammalian Synapses: Why It Matters and How to Measure It. Parmi les 20 000 gênes de nos cellules, 6000 sont spécifiques au fonctionnement du cerveau et leur expression varie d’un type de neurone à l’autre et en fonction de leur environnement ! C’est dire la richesse de la soupe de protéines qui gouverne le cerveau, dont l’actine qui structure la forme mouvante des neurones !

Le cerveau d’un fœtus comprendrait plus de mille milliards de neurones, qui meurent rapidement. On perd en fait des neurones dès sa naissance, comme si une matrice s’évidait pour prendre forme progressivement au gré des apprentissages. Le cerveau d’un enfant comprendrait plus de 100 milliards de neurones, et plus de 15 trillions de synapses et 150 milliards de dendrites.

Un cerveau adulte comprend environ 85 milliards de neurones dont 30 dans le cortex, 10 trillions de synapses (liaisons neurones / neurones via les terminaisons multiples des axones qui sortent de neurones et se connectent aux dendrites proches du noyau d’autres neurones), et 300 milliards de dendrites (les structures des neurones sur lesquelles ne trouvent les synapses). Il consomme environ 20 Watts fournis sous forme d’hydrates de carbone (glucoses) via la circulation sanguine, ce qui en fait une “machine” très efficace côté consommation énergétique. Dans son développement à partir de la naissance, le cerveau perd des neurones mais gagne des liaisons entre elles, et ce, toute la vie, même si le processus se ralentit avec l’âge, même sans maladies neurodégénératives.

Un neurotransmetteur arrivant via une synapse peut déclencher une cascade de réactions en chaines dans le neurone cible qui va réguler l’expression de gênes et produire des protéines de régulation qui vont modifier le comportement des dendrites dans la réception des signaux issus des axones. Qui plus est les dendrites – les récepteurs dans les neurones – ont des formes et des comportements variables. Bref, nous avons un système de régulation des plus complexes qui n’a pas du tout été intégré dans les modèles Kurzweiliens !

Plus de la moitié des neurones du cerveau sont situées dans le cervelet. Il gère les automatismes appris comme la marche, la préhension, les sports, la conduite, le vélo, la danse ou la maitrise des instruments de musique. Un neurone du cervelet contient environ 25 000 synapses le reliant aux terminaisons d’axones d’autres neurones. Ceux du cortex qui gèrent les sens et l’intelligence comprennent chacun de 5000 et 15 000 synapses.

Le cerveau est aussi rempli de cellules gliales qui alimentent les neurones et en contrôlent le fonctionnement via la myéline qui entoure les axones et divers autres mécanismes de régulation. Il y en a au moins autant que de neurones dans le cerveau, ce qui ajoute un niveau de complexité de plus. Il faut ajouter le rôle de buffer de mémoire de l’hippocampe, le vidage de ce buffer pendant le sommeil ce qui rappelle que une bonne qualité et durée de sommeil permet d’entretenir sa mémoire. Enfin, via le système nerveux sympathique et parasympathique, le cerveau est relié au reste des organes, dont le système digestif ainsi qu’à tous les sens et notamment le toucher.

(source du schéma qui l’explique très bien)

Le cerveau est imbattable dans sa densité, sa compacité et son parallélisme. Par contre, les ordinateurs nous dépassent dans leur capacité de stockage et de traitement de gros volumes de données. Si l’on aura bien longtemps du mal à scanner un cerveau au niveau des neurones, il n’en reste pas moins possible d’en comprendre le fonctionnement par tâtonnements. Les neurosciences continuent de progresser régulièrement de ce point de vue-là. On comprend petit à petit comment fonctionnent les différents niveaux d’abstraction dans le cerveau, même si les méthodes scientifiques de vérification associées restent assez empiriques, réalisées le plus souvent avec des souris.

Mais il n’est pas nécessaire de maitriser le niveau d’abstraction le plus bas du cerveau pour en simuler les niveaux élevés, sans passer par un clonage. Comme il n’est pas nécessaire de maitriser les bosons de Higgs pour faire de la chimie ou comprendre la manière dont l’ADN sert à fabriquer des protéines au sein des cellules !

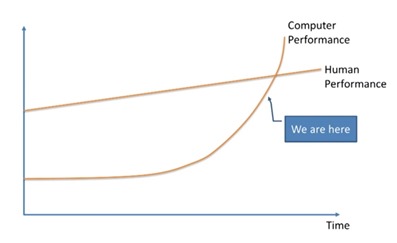

Placer l’intelligence de la machine dans la prolongation de celle de l’homme et sur une simple courbe exponentielle n’a pas beaucoup de sens, comme dans “The AI Revolution: Our Immortality or Extinction” de Tim Urban (ci-dessus).

En tout cas, quoi qu’il arrive, l’intelligence d’une machine hyper-intelligente n’aura pas une intelligence similaire à celle de l’homme. Elle sera probablement plus froide, plus rationnelle, moins émotionnelle et plus globale dans sa portée et sa compréhension du monde. L’intelligence artificielle sera supérieure à celle de l’homme dans de nombreux domaines et pas dans d’autres. Elle sera simplement différente et complémentaire. Tout du moins, à une échéance raisonnable de quelques décennies.

Dans la partie suivante de cette série, nous verrons quelles évolutions technologiques matérielles et logicielles pourraient permettre à l’IA de réaliser des sauts quantiques en termes de performance.

____________________________________

J’en profite pour signaler discrètement que ce blog fête ses 10 ans révolus d’existence en ce mois d’avril 2016. Pas besoin d’en faire toute une histoire avec un bilan, des chiffres, des retours d’expérience ou un livre d’or ! Toutes les archives du site sont en tout cas disponibles, le site n’ayant pas changé d’URL ni de plateforme (WordPress) pendant cette décennie. C’est toujours un défi que de se renouveler. Mais je compte bien continuer à vous surprendre en traitant un nombre aussi varié de sujets associant de manière variable numérique, technologies, sciences, biologie, entrepreneuriat, économie et politique.

_____________________________________

Vous pouvez consulter tous les épisodes de ce roman fleuve de printemps sur l’intelligence artificielle :

Episode 1 : sémantique et questions clés

Episode 2 : histoire et technologies de l’intelligence artificielle

Episode 3 : IBM Watson et le marketing de l’intelligence artificielle

Episode 4 : les startups US de l’intelligence artificielle

Episode 5 : les startups acquises par les grands du numérique

Episode 6 : les startups françaises de l’intelligence artificielle

Episode 7 : la modélisation et la copie du cerveau

Episode 8 : évolutions de la loi de Moore et applications à l’intelligence artificielle

Episode 9 : la robotisation en marche des métiers

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Happy Birthday ! Et merci de nous régaler depuis 10 ans. Longue vie.

Bon bloganniversaire, Olivier !

On l’écrit quand ce livre passionnant sur ta vie, ton œuvre ? 😉

Olivier,

Super, as usual!

Un fan 😉

Jean-François David

Cà fait 10 ans que .@olivez nous éduque, guide et inspire avec son #blog. Bravo & Merci Olivier. https://t.co/trbxPCYXaH

[#DataScience] #IA Les avancées de l’IA : le fonctionnement du cerveau by @olivez https://t.co/TVMd3LjjN6 https://t.co/klsCKP3Esw

Un article très bien documenté (comme toujours) d’@olivez sur les avancées de l’intelligence Artificielle. A lire po…https://t.co/ICsW5JyP8v

Félicitations pour cet article et pour les nombreux autres !

Merci ! Vous aidez beaucoup de gens !

C’est en voyant des publications comme les votres que je me suis mis à écrire.

Mon blog c’est http://www.antoinebachelinsena.com dans lequel j’évoque mes principes et mes visions d’investisseur et d’entrepreneur.

J’écris afin de créer l’envie d’entreprendre chez mes lecteurs et je souhaite vous remercier vous-même pour être aussi actif sur la toile.

A bientôt de vous lire.

“Les avancées de l’intelligence artificielle – #Level7 ^^ ” by @olivez c’est ici : https://t.co/FKNlC37k3u #IA #AI

Merci pour ces analyses fines et synthétiques. Vraiment merci! Et avec un peu de retard, félicitations pour les 10 ans de contributions régulières. J’aimerais te tester sur un sujet connexe que je découvre en ce moment, à savoir les thèses de Brynjolfsson et McAfee sur l’impact des machines (dont l’IA) sur l’économie. Je suis resté un peu sur ma faim en lisant leur essai de 2011 (The race against the machine) et je ne fais que commencer The Second Machine Age. J’ai vu que tu les as mentionnées brièvement il y a 2-3 ans. Mais as-tu un avis sur leur thèse et surtout sur leur optimisme très américain?

Ah ! Je viens de terminer ces deux bouquins et vais en faire une petite synthèse dans l’article suivant (le 9e) et dernier de la série sur l’impact de l’IA et de la robotique sur l’emploi. J’ai parcouru comme cela un grand nombre de livres sur ce sujet.

Dans ma synthèse, j’indiquerai ce qui peut éventuellement manquer de manière générique dans leurs analyses. En général, un manque d’approche macro à l’échelle mondiale. Ces bouquins sont un peu trop US-centric. Ils évacuent aussi un peu rapidement les aspects énergie – matières premières – environnement – démographie. Enfin, ils ne s’attardent pas du tout sur la réalité scientifique et technique du sujet qu’ils abordent. C’est un “given” pour eux, sans beaucoup d’analyse critique.

Je vais donc passer à la partie 9 et je suis entièrement d’accord avec toi. J’ai trouvé qu’il manquait bcp de choses dans l’analyse. A suivre donc…