Voici venu le temps de la détente et des fêtes de fin d’année. C’est aussi celui des prévisions, et, donc, de mes habituelles métaprévisions qui me permettent de vagabonder sur plusieurs thèmes mêlant technologies, sciences et géopolitique.

Depuis quelques temps, les sciences et technologies quantiques occupent 100% de mon temps professionnel (livre de 1132 pages en anglais, plus de 90 podcasts réalisés avec Fanny Bouton, lancement de la Quantum Energy Initiative avec Alexia Auffèves et al, enseignement à l’EPITA, formation, veille technologique, etc). Je garde cependant l’œil – critique et distant – sur d’autres domaines technologiques qui sont soit adjacents comme celui de la fusion nucléaire ou de l’IA, soit plus éloignés, dans la vaste sphère du numérique.

En revenant sur les prévisions de l’année dernière pour 2022, le compte n’y est pas vraiment. Je ne suis pas bien sûr d’avoir vu prédire l’invasion de l’Ukraine par son voisin Russe ni sa vaillante résistance aidée par les pays occidentaux, la crise énergétique qui en a résulté, l’inflation, la mort d’Elisabeth II, le prix Nobel de physique d’Alain Aspect, et dans le plus léger, la France en finale de la coupe du monde de football ou le rachat de Twitter par Elon Musk et le bazar qui en a résulté.

Pour ma part, la seule chose valable que j’ai vaguement pu prédire est que, du côté de l’IA, je voyais du potentiel du côté du traitement du langage et c’est ce que nous avons avec la déferlante de ChatGPT et de du playground GPT d’OpenAI sans pour autant que cela fasse de moi un devin. J’anticipais aussi que les NFT, métavers et autres cryptos auraient du fil à retordre. Les médias craignaient la production de deepfakes en politique. On n’en a pas eu besoin tellement les politiques réels sont parfois tellement hors sol. Et, encore, c’est pire aux USA qu’en France.

Je vais ici me concentrer sur l’actualité scientifique et numérique dans cet exercice de style orienté “devoirs de vacances scientifiques”, et avec une tentative de prise de recul. Pour l’astrophysique, le quantique ainsi que la fusion nucléaire, mes observations mettent en valeur le temps long qui prévaut. On y trouve un mélange de belle science, d’espoirs énormes mais aussi de survente ambiante surtout pour ces deux derniers. Nous ferons aussi un petit détour par l’IA, les cryptos et le CES 2023.

Ne me tenez pas rigueur si vos propres sujets fétiches n’y sont pas. Je ne prétends pas du tout être exhaustif. Donc, je ne parlerais pas cuisine sous vide, topinambour, mi-cuit au chocolat, politique française, santé et covid, no-code, sport, musique et médias. Entre autres.

Les merveilles du James Webb Space Telescope

C’était l’attente scientifique de l’année 2022 après le lancement réussi du télescope par Ariane V à partir de Kourou en décembre 2021. Il a fallu attendre de longs mois pour qu’il arrive au point de Lagrange L2, déploie l’ensemble de ses miroirs et instruments puis soit refroidi et calibré. Ce fut un sans faute étourdissant qui tranche avec les retards d’autres projets technologiques (EPR, etc) ! En juillet 2022, les premières photos arrivaient et la moisson cosmologique pouvait commencer. Elle a ravi les amateurs de très belles images, telle cette nouvelle version de la Nébuleuse de la Carène dans la Voie Lactée obtenue en associant les images de plusieurs télescopes spatiaux JWST (dans l’infrarouge), Hubble (dans le visible et l’ultraviolet) et Chandra (dans les rayons X).

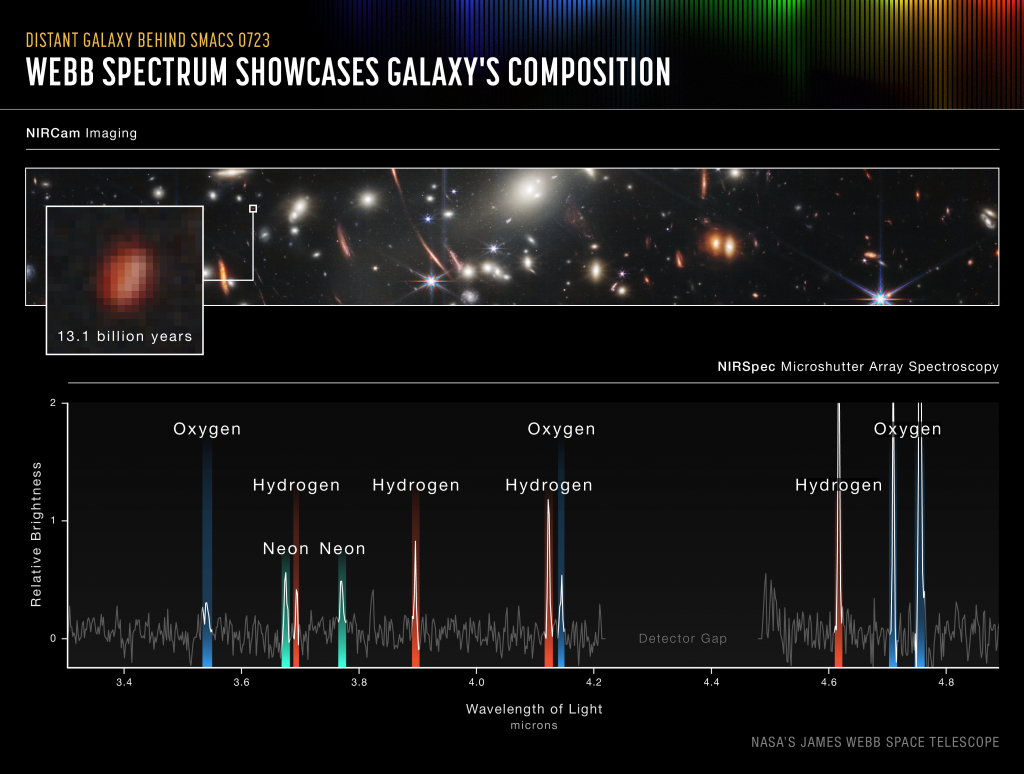

Les astrophysiciens peuvent exploiter les données de spectrographie dans le proche infrarouge de l’instrument Nircam qui permettent par exemple d’analyser la composition atomique de galaxies éloignées de plus de 13,1 milliards d’années lumières.

Dans les découvertes obtenues en un semestre d’activités, on compte entre autres une galaxie située temporellement entre 300 et 350 millions d’années après le Big Bang (GLASS-z13), l’observation plus précise des Piliers de la Création dans la Voie Lactée grâce à l’instrument d’observation dans l’infrarouge moyen MIRI créé par le CEA (instrument qui avait connu un incident qui a été finalement résolu), l’observation plus précise de la création d’une étoile (L1527), l’analyse spectrale de nouvelles exoplanètes (comme WASP-39b), et même leur photo, certes très floue (HIP 65426 b, dans la Voie Lactée, of course) tout comme de nouvelles observations des planètes de notre système solaire (telle la lune Triton de Neptune).

Le projet du JWST avait germé en 1989 et a été véritablement lancé en 2003. Son coût a explosé en route entraînant un projet d’annulation par le Congrès US en 2011, qui venait alors de passer du côté Républicain au début du premier mandat de Barack Obama. Une mobilisation internationale l’a évité. L’addition a finalement atteint $10B, comprenant les provisions pour la gestion de ses opérations pendant sa durée de vie. Comme la fusion nucléaire ou le calcul quantique, le lancement de grands instruments scientifiques pour l’astronomie relève toujours du long terme. Il en va de même pour l’Extremely Large Telescope de l’ESO qui est en cours de construction au Chili avec son miroir de 39 mètres. Le projet lancé en 2014 doit être terminé en 2027. C’est presque du cours terme !

Parmi tous les projets scientifiques d’envergure, ceux qui touchent à l’astronomie ont l’air d’être les moins contestés par l’opinion publique en général malgré des recherches dont les impacts sur la vie courante sont très indirects. Comment expliquer cela ? Par l’émerveillement que les observations génèrent ? Par leur côté fédérateur ? Par la soif de connaissance de l’Humanité, toujours à la recherche d’explications sur sa position dans l’immense univers ? Par la beauté visuelle des images diffusées qui permettent de nous échapper du train train quotidien ? Par une bonne communication des scientifiques du secteur ? Aussi, par la belle leçon d’humilité associée, la Terre étant finalement si peu de chose dans l’Univers. A vous de voir. C’est probablement un mix de tout cela.

On peut en tout cas facilement anticiper pour 2023 de nouvelles découvertes qui enchanteront les amateurs. D’autres galaxies très éloignées pourraient être découvertes tout comme des exoplanètes proches de la Terre.

Pour en savoir plus, direction par exemple How JWST revolutionized astronomy in 2022 par Alexandra Witze, Nature, décembre 2022 (2 pages) et JWST’s best images: spectacular stars and spiralling galaxies, Nature.

ChatGPT est performant mais mythomane

L’actualité de l’IA de cette fin 2022 se concentre quasiment autour de ChatGPT et de Playground lancés par OpenAI. Ils sont basés sur la version 3.5 du modèle GPT entraîné avec des tombereaux de données issues d’Internet fin 2021 (dont tout Wikipedia, des bibliothèques entières, les articles scientifiques publiés, etc). Cela s’appuie sur un réseau de neurones géant de 175 milliards de paramètres. Le chatbot à mémoire épisodique est capable d’entretenir la conversation et se rapproche du passage du fameux test de Turing. Playground génère aussi du code. Dall-E, qui est aussi issu d’OpenAI, génère des images à partir de simples descriptions textuelles.

Dans la partie chatbot, on trouve le meilleur comme le pire.

C’est d’abord un moteur de recherche très amélioré qui répond aux questions en clair et peut tenir la conversation. Je l’utilise maintenant souvent dans le domaine du quantique pour décrire des concepts comme des types d’algorithmes (QUBO, QAOA, etc). Cela fonctionne plutôt bien. La raison est simple : les contenus de qualité et scrapables sont nombreux sur Internet sur ces sujets. Ses réponses ouvrent parfois des voies intéressantes à creuser. Pour les “cols blancs” qui recherchent de l’information mise en forme, ces chatbots pourraient rapidement devenir des outils de productivité incontournables. Il faudra apprendre à les dompter et aussi à voir évoluer graduellement leurs capacités. On doit tenir compte de ce que le moteur a été entraîné sur des données de fin 2021. Il n’est donc pas à la page. Je serais curieux de savoir si ce genre de moteur pourrait être régulièrement mis à jour avec des outils de type “Transfer Networks”.

Par contre, il ne faut jamais oublier que le système est probabiliste, qu’il a des capacités de raisonnement symbolique limitées, qu’il faut presque tout vérifier, et enfin, que les sources d’information qui ont servi à l’entraîner ne sont pas forcément fiables. Certains comme l’artiste-chercheur Olivier Auber torturent Playground pour en tester les limites, un exercice pédagogique bien utile. Va-t-il tuer le métier d’enseignant comme certains osent l’avancer ? Je n’irai pas jusque là. Par contre, en étant plus cadré, ce genre de chatbot pourrait remplacer pas mal d’agents de services clients. N’oublions jamais que ces IA sont entraînées avec du contenu d’origine humaine. Pas d’humain, pas de savoir d’origine humaine, pas d’IA !

Les choses empirent sérieusement lorsque l’on commence à poser des questions sur qui fait quoi. Exemple avec ce qui me concerne où en gros, le système invente n’importe quoi. Rien de ce qui est écrit ci-dessous n’est vrai. Sachant que les données qu’il utilise datent de 2021, au moment où le moteur a été entraîné avec des tombereaux de données scrappées sur Internet.

Il fait de même lorsque l’on demande la même chose sur ce que font deux personnes ensemble. Il invente des couples qui n’existent pas et des entreprises qui n’existent pas plus. Et si on lui demande où il a trouvé l’information, il a le toupet d’indiquer des sites web inexistants. Il répond sans réserves ni précaution d’usage, ni d’indication de probabilité de succès ou d’erreur. Certains appellent cela des “hallucinations”. Si le chatbot ne connait pas la réponse à une question, il l’invente de toutes pièces. C’est une IA générative et prédictive après tout !

Bien entendu, il s’agit d’un logiciel “en bêta test”. Mais lorsque l’on se rappelle que la société à son origine, OpenAI, avait été créée pour développer une sorte d’intelligence artificielle responsable, on est en droit de se poser des questions.

En 2023, selon Forbes, OpenAI devrait remettre le couvert avec GPT4, une version améliorée et à jour, avec encore plus de paramètres. Certains s’attendent à une onde choc économique majeure impactant tous les métiers du savoir. J’ai quelques doutes. Si la large disposition de savoir sur Internet rendait en moyenne les gens plus éduqués et autonomes, cela se saurait. Combien de fois n’avez vous pas dépanné vos proches qui vous posaient une question technique facile à résoudre en faisant une simple recherche sur Google ?

Sinon, en 2023, Google sortira son chatbot LaMBDa ce qui permettra peut-être de l’intégrer dans Google Search d’une manière ou d’une autre. Et Open AI envisage de réaliser $1B de chiffre d’affaire en 2023 avec ses systèmes. On verra bien avec quel modèle économique !

Passionnante et incertaine informatique quantique

Le champ des technologies quantiques et aussi celui d’une belle science en perpétuel renouvèlement. En s’y plongeant, on en apprend tous les jours. On peut découvrir de très nombreux domaines scientifiques allant de la physique fondamentale à l’informatique en passant par l’ingénierie, et même les sciences humaines. Cela titille les neurones et nos modèles de compréhension du monde et questionne sur le sens des innovations dans le numérique.

Le quantique est aussi le champ de l’incertitude. Pas seulement celle de la mesure de variables ou observables complémentaires en physique quantique comme la vitesse et la position d’une particule, mais aussi des technologies associées et des annonces des uns et des autres qui sont toujours aussi délicates à interpréter. Cette difficulté se retrouve dans les prévisions des intervenants du secteur qui sont volontairement des plus floues quand ce n’est pas complètement à côté de la plaque. Elles révèlent aussi leurs propres biais et intérêts.

Matt Swayne de The Quantum Insider propose Top 11 Predictions for 2023’s Quantum Technology Industry. Il prévoit des startups à cours de cash, des fusions-acquisitions, notamment autour du HPC, des CEO business qui vont remplacer des CEO scientifiques pour accélérer la croissance (s’il y a des choses à vendre…), des surprises scientifiques potentielles (ça ne mange pas de pain) et de la PQC (cryptographie post-quantique). Bref, rien de très original docteur.

Stephen Ibaraki compile dans Forbes des prévisions d’experts, issus principalement d’acteurs industriels. Alan Baratz, CEO de D-Wave, prévoit que la commercialisation d’ordinateurs quantiques va réellement démarrer en 2023. Ce qui présuppose qu’ils arrivent à vendre leur système Advantage lancé en 2020. Il prévoit aussi que les calculateurs bruités de type NISQ ne pourront pas avoir d’applications pratiques. C’est le consensus chez pas mal de spécialistes en théories de la complexité et algorithmes quantiques. Sinon, comme tant d’autres, il prévoit l’arrivée d’ordinateurs quantiques à tolérance de panne d’ici 2030 sans préciser leurs caractéristiques (nombre de qubits logiques, fidélités apparentes, …).

Sebastian Weidt, le CEO d’Universal Quantum (UK, qubits à ions piégés) prévoit une guerre quantique d’ici 2030 sans en préciser les contours. C’est surtout une métaphore de la concurrence exacerbée entre les pays qui investissent dans les technologies quantiques.

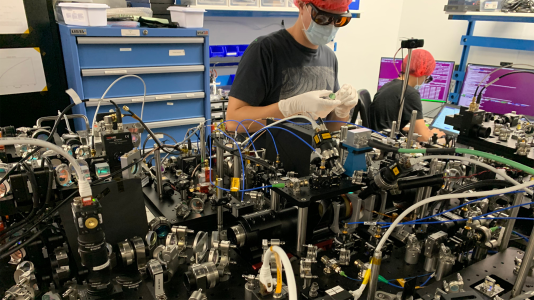

Mark Saffman, Chief Scientist de ColdQuanta prévoit qu’en 2023, les ordinateurs quantiques à atomes neutres scalables verront le jour. Que fait ColdQuanta ? Surprise, des ordinateurs quantiques à atomes neutres (ci-dessus, qui ressemblent encore à des expériences de laboratoire), comme le Français Pasqal (qui a poussé bien plus loin l’intégration de son ordinateur) ! Et d’ici 2030, nous aurons les habituels 100 “qubits logiques corrigés” mais aussi des centrales inertielles à atomes neutres permettant de se passer de GPS. C’est aussi l’une des activités de ColdQuanta, qui dans ce domaine, est concurrencé par Exail (France, ex ixBlue, qui avait acquis Muquans en 2021 et qui a aussi dans ses cartons de telles centrales inertielles).

Scott Aaronson, de l’Université du Texas, pense plus prudemment qu’en 2023, nous serons en mesure de prouver un avantage quantique avec des ordinateurs de type NISQ (sans préciser si cela comprend les simulateurs quantiques analogiques) et que dans le même temps, des codes de correction d’erreur plus efficaces verront le jour. Et 2030 ? C’est trop loin pour qu’il se prononce. Sage décision !

Stefan Woerner d’IBM Research Europe parie sur la mitigation d’erreurs pour les ordinateurs NISQ et sur l’arrivée d’avantages quantiques démontrables. C’est une possibilité, si IBM arrive à sortir sa puce Heron de 133 qubits avec des fidélités de 99,9% (pour les portes à deux qubits). En 2030, il anticipe la capacité à résoudre des problèmes d’optimisation dans la logistique et l’industrie. En 2030, nous disposerions de 300 qubits logiques. Au vu de la roadmap d’IBM, c’est très optimiste puisque cela nécessiterait au moins 300 000 qubits physiques, regroupés par paquets de 4500. Donc, avec 66 ordinateurs quantiques reliés entre eux via une interconnexion à base de photons intriqués. Dans 7 ans ? On se calme !

D’autres prédictions ne valent pas un clou vu les bêtises qu’elles contiennent sur le présent. Ainsi, dans Top 10 Quantum Computing Trends To Watch In 2023, Evelyn Addison dans “The Next Web” indique que la santé sera le premier domaine d’application du calcul quantique. Jusque là tout va bien. Sauf que c’est basé sur une affirmation à faire bondir tout spécialiste du calcul quantique sur sa chaise : “The technology is superfast, with the super frequency and high-efficiency reading capability, quantum computers are 158 million times faster than the current supercomputers and classical classified computers” (référence à Sycamore 2019, sachant que depuis, des chercheurs français et américains ont pu simuler Sycamore sur une machine QLM d’Atos en quelques heures). Et “super frequency” et “reading capacity”, ça c’est du nouveau !

En matière de cybersécurité, ce n’est pas mieux avec “many helpful methods are being evaluated (nearly 65 new methods developing) to make quantum computing safe and secure for public transactions using quantum cryptography (a method of encryption to secure and transmit data using properties of quantum mechanics)”. Il s’agit d’une erreur courante consistant à confondre la cryptographie post-quantique (qui est classique, où le NIST avait sélectionné 69 et pas 65 protocoles en 2018, depuis réduits à 4 en juillet 2022), la cryptographie quantique (qui ne s’appuie pas sur des ordinateurs quantiques mais sur des liaisons photoniques) et les méthodes pour rendre le calcul quantique sécurisé (qui existent, mais sont d’un autre ordre comme le “quantum blind computing” coinventé par Elham Kashefi). Le reste des prévisions est à l’encan avec du routage de véhicules autonomes et des prévisions météo. C’est la rengaine d’un futur lointain abusivement conjugué au présent. C’est rageant de voir des journaux soi-disant technologiques propager de telles balivernes. C’en est au point où l’on pourrait croire que ces prévisions ont été générées par ChatGPT dans sa version mythomane.

En 2022, nous avons aussi eu droit aux trous de ver réalisés avec un ordinateur quantique, par les équipes de Google. Cela donnait lieu à pas mal de confusion dans la couverture du sujet, noyé dans un ensemble scientifique assez complexe. Le sujet est bien traité par Sean Bailly dans A-t-on créé un trou de ver sur un ordinateur quantique ? dans Pour La Science (22 décembre 2022). En pratique, l’expérience relevant du calcul quantique consistait à vérifier qu’un calcul réalisé avec 9 qubits donnait de bons résultats par rapport à son équivalent classique. 9 qubits sont émulables dans un ordinateur classique capable de manipuler un vecteur de 2048 nombres flottants. Si cela se trouve, on pourrait faire cela sur un Apple II de 1977 ou un IBM PC de 1981 ! Donc, pas de quoi sauter au plafond du calcul quantique.

Comme c’est mon domaine de prédilection, je vais cependant jouer le jeu et proposer quelques prévisions pour 2023, avec une marge de 12 mois, en me basant sur des informations déjà disponibles car c’est plus sûr !

- IBM va sortir comme prévu deux processeurs clés : Condor avec 1121 qubits mais qui ne servira pas à grand-chose, comme Eagle (127 qubits, 2021 et récemment mis à jour dans sa version r3 Sherbrooke avec des fidélités améliorées) et Osprey (433 qubits, 2022), parce que ses fidélités ne seront pas suffisantes. Cela sera cependant un bon test de scalabilité de ce qui est autour, notamment une cryogénie de compétition avec un cryostat géant KIDE de Bluefors. Le second processeur, Heron, déjà cité, pourrait avoir de très bonnes fidélités. Je doute qu’elle atteigne véritablement les 99,9% qu’IBM ambitionne d’obtenir. Si ils y arrivent, cela permettra de commencer à faire des choses intéressantes avec ce processeur.

- Google va annoncer son premier qubit logique ayant une fidélité supérieure aux qubits sous-jacents, avec une nouvelle version de Sycamore dotée d’un peu plus de 100 qubits. Il ne s’agira pas encore d’un calcul à qubits logiques à tolérance de panne puisque le système ne contiendra qu’un seul qubit logique.

- Le débat va continuer sur la capacité ou pas d’obtenir un avantage quantique avec des machines à qubits bruités NISQ. On aura la confirmation que les ordinateurs quantiques analogiques type Pasqal et D-Wave sont plus prometteurs sur le court et le moyen terme que les ordinateurs programmables par portes dans le régime bruité NISQ.

- La grande majorité des startups du calcul quantique du monde entier va continuer de se fourvoyer à vendre des “cas d’usage”, y compris pour “lutter contre le réchauffement climatique” alors qu’elles n’auront des machines véritablement utiles que dans environ 10 ans, au mieux. Dans la majorité des cas, les solutions présentées seront émulables sur des serveurs classiques, dès lors qu’elles exploitent moins de 30-40 qubits, qui sont par essence bruités.

- OVHcloud va devenir le premier opérateur de cloud européen privé à proposer plusieurs ordinateurs quantiques différents dans son offre, tous Français. Dans le même temps, dans le cadre du projet HQI géré par GENCI, le TGCC déploiera des machines équivalentes pour les chercheurs (HQI : initiative nationale de calcul hybride lancée en janvier 2022, GENCI : centrale d’achat des supercalculateurs du secteur public, TGCC : très grand centre de calcul géré par le CEA à Bruyère le Chatel en région parisienne).

- Les spécialistes de la cybersécurité vont continuer d’agiter le chiffon rouge de l’algorithme de Shor pour justifier l’accélération du déploiement de la cryptographie post-quantique (PQC).

- Nous pourrions avoir des surprises du côté des algorithmes classiques dits quantum inspired. On pourrait aussi découvrir que l’algorithme de Shor n’est pas forcément le plus performant pour factoriser des nombres entiers. Voir par exemple Factoring integers with sublinear resources on a superconducting quantum processor par Bao Yan et al, Chine, décembre 2022 (32 pages) qui présente un algorithme quantique capable de factoriser le nombre 261980999226229 avec 48 qubits supraconducteurs. Ils pensent qu’une clé RSA serait factorisable avec 372 qubits physiques (et plus d’une série de 1000 portes quantiques, avec des fidélités cependant hors de portée aujourd’hui). C’est un game changer qui pourrait justifier le chiffon rouge précédent !

- Des avantages quantiques seront encore et toujours mis en avant sur des cas particuliers incompréhensibles de simulations physiques et très éloignés des besoins des entreprises. Mais ils feront toutefois avancer la science dans différents domaines.

- Au moins une startup française du calcul quantique réussira à lever en tout plus de 100M€. Laquelle, c’est une autre histoire !

- Avec Alexia Auffèves, Robert Whitney et Janine Spettstoesser, je vais continuer à plancher sur l’énergétique des technologies quantiques et surtout du calcul quantique dans le cadre de la Quantum Energy Initiative. Cette communauté internationale de chercheurs va progressivement prendre forme en 2023. Stay tuned!

- Enfin, il y a des chances non négligeables que je publie une sixième édition de mon livre Understanding Quantum Technologies vers septembre 2023, qui sera donc la troisième en anglais.

L’ambition très long terme de la fusion nucléaire

Le 13 décembre 2022, le Département de l’Energie US annonçait une avancée majeure dans la longue route vers la fusion nucléaire contrôlée. Pour la première fois, un système générait plus d’énergie qu’il n’en avait consommé. L’expérience était menée le 5 décembre 2022 au National Ignition Facility (NIF) du Lawrence Livermore National Laboratory (LLNL). La fusion était alimentée par 2,05 mégajoules provenant de près de 196 lasers et générait 3.15 mégajoules d’énergie. Alors, ça y est ? Le problème de la fusion nucléaire est cracké ? On peut tout arrêter du côté d’ITER à Cadarache ? La course à la fusion nucléaire est gagnée par les Américains ?

En pratique, pas du tout ! Ce n’est pas encore l’événement “game changer” que certains espéraient. Jugez-en plutôt…

- Les lasers du National Ignition Facility du LLNL sont alimentés par a minima 300 mégajoules d’énergie par impulsion, donc le rendement énergétique du système est inférieur à 0,3%. Il pourrait être amélioré avec des lasers plus récents mais seulement de quelques dizaines de pourcents. On est très loin d’un bilan énergétique positif.

- Cette opération est un fusil à un coup qui ne dure moins d’une nanoseconde et ne produit que 300 Wh, soit une heure de fonctionnement d’un serveur dans un datacenter.

- Elle ne peut être reproduite qu’à raison d’une expérience par jour avec un consommable coutant plus de $10K. Les faisceaux des lasers de très haute puissance convergent vers une minuscule capsule contenant du tritium et du deutérium, deux isotopes de l’hydrogène. La capsule implose, la fusion opère et libère de l’énergie et puis c’est fini.

- Le tritium utilisé dans l’expérience est très rare et très cher ($30K le gramme). Le deutérium est plus abondant et peut notamment être extrait de l’eau de mer.

- L’énergie n’est pas récupérée dans l’expérience pour produire de la vapeur et alimenter une turbine produisant de l’électricité, elle est juste détectée.

Ce système du LLNL est surtout conçu pour simuler à petite échelle la fusion qui opère dans des armes thermonucléaires. Le processus n’est pas continu et ne peut donc pas servir à générer de l’énergie pour alimenter le réseau électrique.

Pour en savoir plus sur ce vaste sujet qui me titille depuis quelque temps, j’ai trouvé plusieurs ressources intéressantes comme Introduction to Fusion (Energy) par Zach Hartwig, MIT Plasma Science and Fusion Center, Juin 2022 (74 slides) qui met en avant la notion intéressante de connaissance inconfortable (‘uncomfortable knowledge’) sur les obstacles scientifiques à relever dans un domaine et qu’un écosystème technologique peut avoir tendance à masquer. Et There is no “breakthrough”: NIF fusion power still consumes 130 times more energy than it creates par Tom Hartsfield dans TheBigThinK qui débunke la prouesse récente du DoE ainsi que The Nuclear Fusion Bubble Is Going to Burst par Steven B. Krivit, New Energy Times, avril 2022 (26 pages) qui se concentre de son côté sur les surpromesses d’ITER.

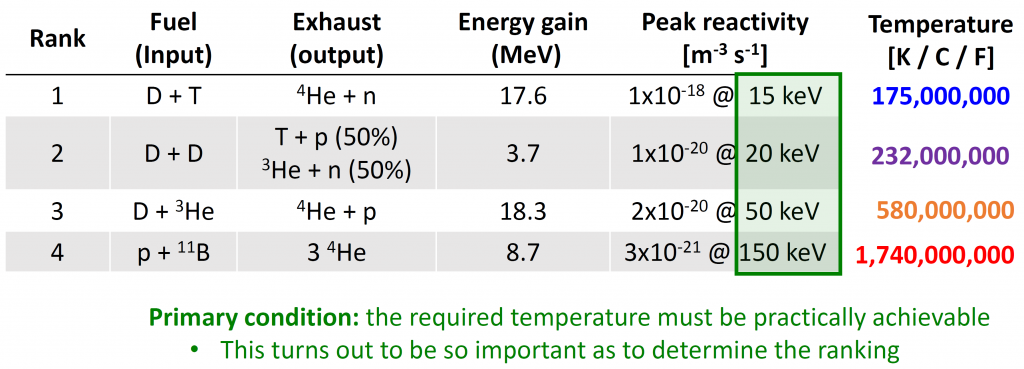

La présentation de Zach Hartwig met bien en évidence les enjeux technologiques de la fusion nucléaire. Il identifie quatre principales combinaisons de “carburant”: deutérium+tritium, deutérium, deutérium et hélium 3 puis proton et bore.

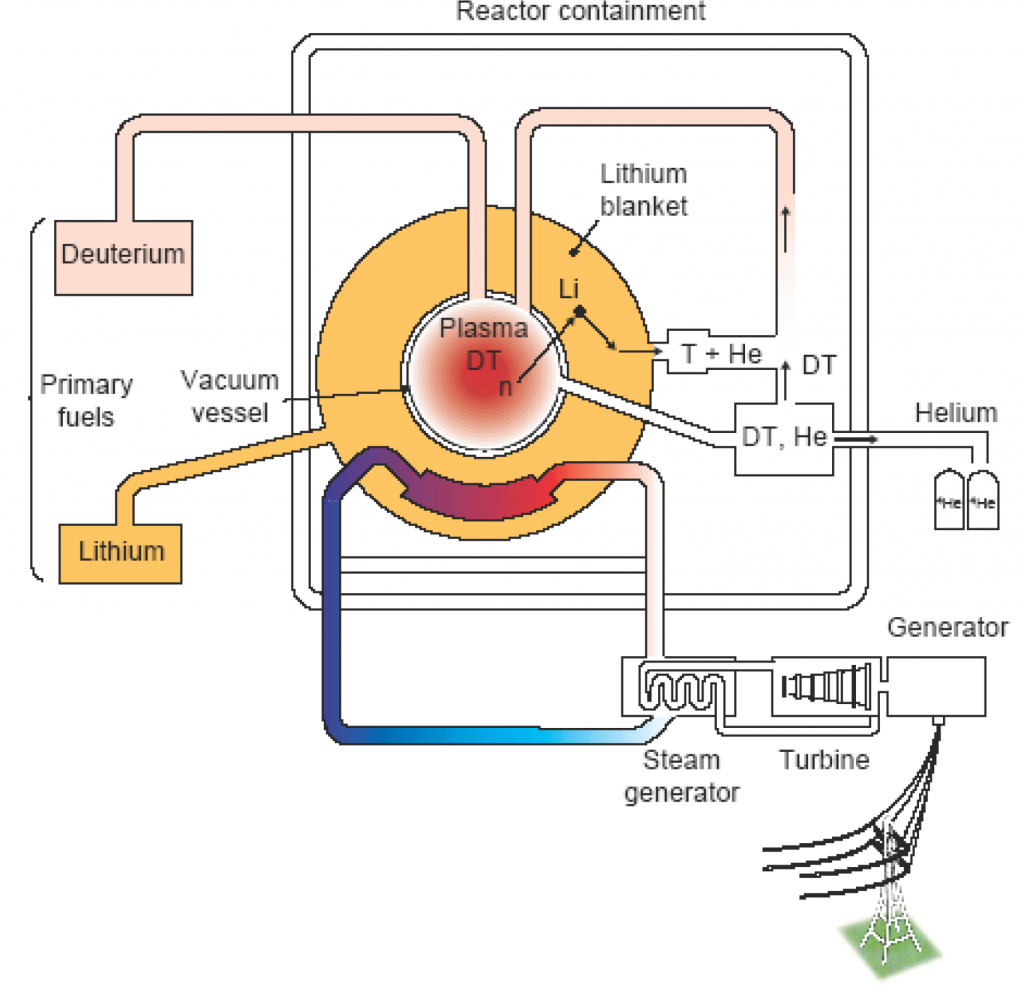

Les conditions d’obtention d’une fusion contrôlée sont une température atteignable (on voit le niveau ci-dessus qui se chiffre en centaines de millions de degrés), la réactivité et le gain énergétique. Le problème de fond est que le plus facile à mettre en œuvre est le couple deutérium-tritium mais ce dernier est rare et cher. Le tritium peut être un sous-produit de la fusion elle-même, en exposant du lithium à des neutrons issus de la fusion. Ce choix technologique est sujet à caution, la quantité de lithium requise étant très importante, et en plus, avec son isotope le plus rare, le lithium 6. Le couple proton-bore demande de son côté des températures énormissimes très difficiles à obtenir. Les paramètres de fonctionnement de la fusion contrôlée sont la densité du plasma, la température du plasma et le confinement de l’énergie. Le confinement permet de contrer les forces de Coulomb qui créent une répulsion entre particules de charges similaires (protons et ions positifs).

Plusieurs méthodes sont envisagées pour gérer ce confinement :

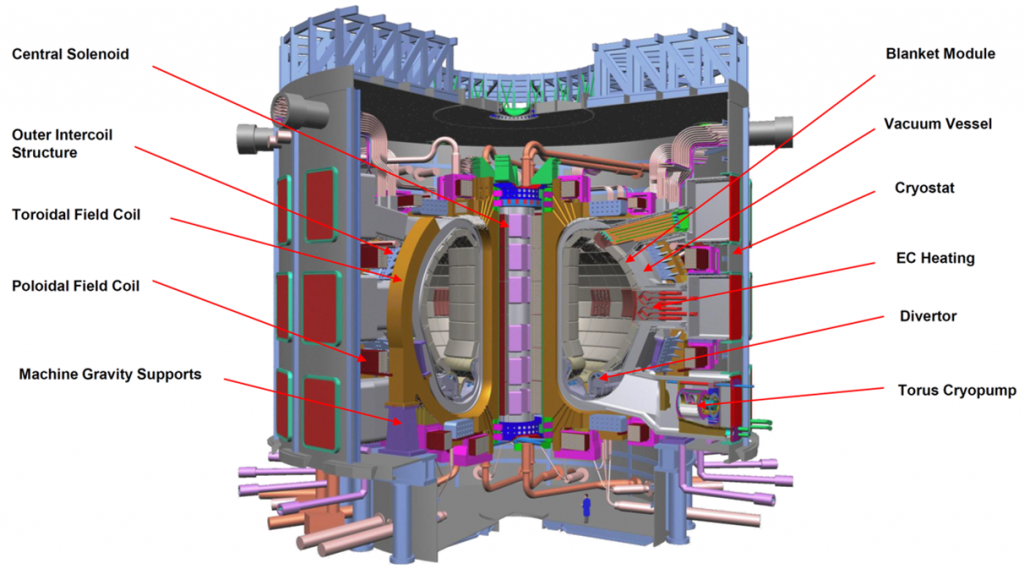

Confinement magnétique à la tokamak (MCF pour Magnetic Confinement Fusion), qui nécessite des aimants supraconducteurs très puissants refroidis par hélium liquide pour contrôler les plasmas. C’est la solution la plus proche de la faisabilité, correspondant au projet ITER et au Joint European Torus (JET, UK), mais elle est très lourde à mettre en œuvre. Et il ne s’agira, une fois opérationnel, que d’un réacteur prototype, pas d’un système prêt à être branché sur le réseau électrique. Les startups dans cette catégorie sont Commonwealth Fusion Systems (USA, fabrication de tokamak low-cost, $2B), Tokamak Energy (UK, tokamaks sphériques, £123M), Zap Energy (USA, $202M), Type One Energy (USA, deutérium, avec un “stellarator” qui créé un champ magnétique rotatif utilisant un procédé différent de celui des tokamaks) et Renaissance Fusion (France, également avec un stellarator). A noter que les premiers tokamaks datent de la fin des années 1950 et que le projet ITER a été lancé à la fin des années 1980.

source : Nuclear Fusion Energy by Odd Erik Garcia (71 slides).

Confinement inertiel (ICF pour Inertial Confinement Fusion) qui utilise un moyen de compression et de montée en température d’une cible, souvent sphérique, principalement à base de lasers à haute puissance. Cela correspond à ce que le DoE vient de démontrer au LNLL. Les startups correspondantes sont Focused Energy (USA, $15M), First Light Fusion (UK, issue d’Oxford University, $108M), Marvel Fusion (Allemagne, proton-bore). C’est dans cette catégorie que l’on trouve le plus souvent la fusion aneutronique, qui ne génère pas de neutrons (<1% de l’énergie générée) mais des particules ionisées et des rayons alpha. Elle évite de rendre la structure du réacteur radioactive et la conversion de l’énergie produite en électricité est plus directe. Mais la réaction est plus difficile à générer et à contrôler et nécessite une température très élevée. Les startups correspondantes sont HB11 Energy (Australie, $22M) et LPP Fusion (USA, proton-bore).

Magnetized Target Fusion (MTF), un système hybride et complexe à maîtriser associant un confinement magnétique et une compression utilisant du métal liquide. On trouve cela chez Generafusion (Canada, plasma magnétique, $322M) et Hyperjet Fusion Corp (USA, canons à plasma).

Field-Reversed Configuration (FRC à base de plasmas intégrés dans des cylindres et générés par des courants toroïdaux). On y trouve TAE Technologies (USA, éléments imprimés en 3D métal, $1.2B) et Helion Energy (USA, deutérium-hélium 3, $577M).

Et plein d’autres méthodes comme le confinement inertiel de type Z-pinch retenu par MIFTI (USA).

S’y ajoutent des projets de systèmes de propulsion spatiale à base de fusion nucléaire chez Princeton Satellite (USA) et Helicity Space (USA).

On peut aussi citer la fameuse fusion froide (eCAT) qui ne marche pas et que Zach Hartwig caractérise comme étant une “pathological science : research that continues in an enthusiastic minority long after scientific consensus establishes it as false“.

Ces startups de la fusion nucléaire ont plusieurs points communs avec celles du calcul quantique. Leur TRL est très bas (technology readiness level), les surpromesses dantesques et les enjeux technologiques énormes, les perspectives de réalisation concrètes sont très long terme, les financements sont voisins (un total d’environ $5B dans les deux cas), une communication mettant plus en avant les bénéfices génériques de leur solution (ici, énergie clean et décarbonée) plus que leur technologie et enfin, une très grande diversité technologique. Autre point commun : le recours à des technologies d’aimants supraconducteurs et à des cryostats refroidis par hélium. D’ailleurs, ITER héberge la plus grande centrale de froid au monde à base d’hélium, construite par Air Liquide. Et pour cause, l’ensemble du réacteur est placé dans un cryostat géant à 4,5K pour y refroidir les aimants supraconducteurs et des pompes cryogéniques à ultravide, tout en y faisant circuler un plasma à plus de 100 millions de degrés !

Les différences ? La fusion nucléaire requiert des infrastructures bien plus lourdes que le calcul quantique (ci-dessus, le site d’ITER à Cadarache). Le calcul quantique s’appuie sur le contrôle de particules ou quasi-particules très sensibles alors que la fusion relève d’une force brute visant à créer des températures et pressions extrêmes à une échelle plutôt macroscopique. Une blague court chez les physiciens selon laquelle le calcul quantique est situé entre la fusion froide et la fusion chaude !

Le quantique et la fusion nucléaire vont se croiser car le calcul quantique permet potentiellement de simuler la physique de la fusion nucléaire, notamment la mécanique des fluides des plasmas à très haute température qui sont sujets à de très fortes turbulences. Mais des chercheurs font déjà cela avec DeepMind. Voir ainsi Quantum Computing for Fusion Energy Science Applications par I. Joseph et al, Lawrence Livermore National Laboratory, décembre 2022 (42 pages). Ce sont deux domaines passionnants où la patience sera de mise pendant plusieurs décennies.

En 2023, comme dans le quantique, ces startups vont communiquer sur des réalisations qui feront prendre des vessies pour des lanternes en exagérant les résultats obtenus. Et alors, Ségolène Royal se fendra d’un beau tweet pour demander au gouvernement de rapidement brancher Cadarache au réseau électrique au début de l’hiver 2023 alors que la guerre en Ukraine sera toujours en cours et que Vladimir Poutine voudra “ouvrir des négociations”.

Malgré toutes ces réserves et leur potentiel impact très long terme, les recherches sérieuses dans le domaine de la fusion nucléaire sont louables et intéressantes. La domestication de cette énergie n’est pas théoriquement impossible. Elle comporte d’incroyables défis technologiques à relever. Cela vaut le coup d’essayer.

Dans le domaine énergétique, les solutions ne sont malheureusement pas nombreuses pour produire et stocker des énergies renouvelables. Par exemple, comme un rapport récent de l’Académie des Technologies le démontre, les solutions de stockage des énergies renouvelables intermittentes ne sont pas évidentes, notamment celles qui reposent sur l’hydrogène. En attendant, la bonne vieille énergie nucléaire restera une solution incontournable, certes imparfaite, comme source d’énergie primaire, en complément des autres sources d’énergie, notamment dites renouvelables.

Souveraineté technologique et écosystèmes

La souveraineté numérique était une rengaine en 2022 et cela va continuer en 2023. Sa recherche est souvent justifiée par le besoin de sécuriser les informations sensibles de l’État, des hôpitaux, des entreprises et des particuliers. La souveraineté technologique est derrière de nombreuses stratégies d’accélération de France 2030 (quantique, IA, cybersécurité, cloud, 5G, …).

Pour autant, il n’est pas possible de fonctionner en autarcie totale sur l’ensemble des technologies numériques. Un pays moderne doit donc équilibrer ses paris et relations de dépendance technologiques. Dans certains cas, il est justifiable stratégiquement et économiquement d’être autonome. Dans d’autres cas, il vaut mieux se contenter de s’assurer que la technologie étrangère sera disponible et que l’on pourra en contrôler les usages et les données utilisées.

La naïveté qui prédomine est d’oublier les facteurs clés de succès des grandes plateformes logicielles américaines : leur masse critique et leur écosystème. Dès le moment où une solution domine le marché par la force de son écosystème, elle devient inévitable et s’érige en standard de facto. Ce n’est pas la meilleure solution qui prévaut mais celle qui a le plus bel écosystème de briques complémentaires. Si un pays pousse coûte que coûte une solution interne qui est sous-critique du point de vue de son écosystème, il est condamné à le faire à perte d’un point de vue économique, fautes d’économies d’échelle.

C’est un peu ce qui nous menace dans l’informatique quantique. Même si nous avons quelques chances de voir se développer quelques-unes de nos belles startups du calcul quantique côté hardware, elles risquent d’être très dépendantes des plateformes logicielles quantiques US, aussi bien côté outils de développement (frameworks à la Qiskit) que services en cloud.

NFT – Cryptos – Metavers – Web3

Vous le savez, je reste dans le camp des sceptiques sur ces technologies à l’exception peut-être de la Blockchain sur certains cas d’usages. Je dénonçais les discours associés dans mes prévisions 2022: “Si la tendance 2021 se confirme, 2022 sera une belle année de “bullshit techs”, avec en premier lieu les NFT, le Web3 et les métavers“.

2022 était bien au rendez-vous et nous a bien gâtés en déconvenues dans ces différents domaines.

Nous avons pour commencer la faillite de FTX engendrée par la mégalomanie et la kleptomanie de son créateur SBF (Sam Bankman-Fried). Pour faire court, FTX était à la fois une place de marché de cryptomonnaies et un fond spéculatif. La société avait été fondée en 2019 et son siège était aux Bahamas, on se demande bien pourquoi. Elle avait créé sa propre cryptomonnaie, le FTX Token. L’histoire est des plus compliquée et met en jeu des fusions-acquisitions, de la sous-traitance de placements dans une société tierce et la perte en fumée de plus de $10B d’actifs de clients… pas clairement identifiés. Cette affaire rappelle une fois encore que les promesses de décentralisation des crypto s’arrêtent aux interfaces entre les cryptos et le reste de la finance. On nous promet que cela sera corrigé avec le web3 mais lui-même voit émerger un tas d’intermédiaires en tout genre qui peuvent créer de nouvelles positions dominantes. Le Web3 reste pour moi une soupe utopique, indigeste et incompréhensible.

Le cours du Bitcoin a joué au yoyo et surtout au tobogan ! Il a en gros perdu près de deux tiers de sa valeur en un an. Lorsque l’on cherche à savoir pourquoi, on découvre que c’est lié à des effets macroéconomiques, à la hausse des taux d’intérêt et à l’inflation. Cela rappelle que les cryptomonnaies ne fonctionnent pas dans un écosystème financier isolé qui protègerait leur détenteurs des soubresauts de l’économie dite réelle.

Et les NFT ? Il s’en lance encore régulièrement. Mais divers indicateurs laissent à penser que le soufflé NFT semble se dégonfler. Les NFT sont des jetons virtuels qui constituent des preuves numériques de possession de biens divers, surtout virtuels. Malheureusement, ce qui en est fait n’est pas bien glorieux. C’est l’apanage de cartes de collection (Sorare) et autres goodies numériques. On navigue dans l’univers du symbolique et de l’accessoire. L’actualité met régulièrement en avant des œuvres numériques échangées à coups de dizaines de millions de dollars, ce qui n’a aucun sens pour le commun des mortels et ne peut pas servir de démonstration de leur utilité sociétale.

Le pire du pire vient d’être réalisé par l’empereur galactique du narcissisme Donald Trump qui lançait mi-décembre 2022 ses propres cartes NFT à son effigie. Il s’en est vendu 45000 générant $4.5M de CA en une journée (45 car il était le 45e Président des USA). Elles étaient vendues à $99 l’unité. Les détails sont à l’image du personnage : les images enfreignent la propriété intellectuelle de diverses marques, la société qui gère cette opération est connue pour son activité de blanchiment d’argent sale et le seuil de 100 cartes achetables est juste en dessous du plafond de $10K de déclaration de transactions financière aux USA. Quand on pense que Trump pourrait redevenir POTUS en 2024 ! 2016 semblait être un remake d’Idiocratie. Là, cela devient une série, et allant de mal en pis.

Du côté des métavers, la confusion continue de battre son plein. On nous promettait monts et merveilles et des marchés en centaines de milliards de dollars. En pratique, les gens n’en veulent pas vraiment. Est-ce à dire qu’au sortir du covid, nous apprécions des relations en vrai avec les autres ? J’ose le croire. En novembre 2022, Facebook annonçait ses résultats et la déception initiale de leur offre de Metavers qui n’est peut-être que passagère. Et au passage, cependant, 11 000 licenciements (13% des emplois). Ces mauvais résultats n’étaient cependant pas imputables au métavers qui ne faisait que démarrer chez eux mais à la reprise économique post-covid affectant tous les acteurs de l’Internet. Facebook avance ce chiffre d’un investissement de $100B dans le métavers dont $15B en 2022. Cela représente environ 42% de ce que leur R&D engloutira en 2022 (environ $35B). Par comparaison, $15B représente à peu de choses près l’investissement mondial du secteur public public sur 5 ans dans les technologies quantiques. Et $100B ? C’est cinq fois le budget d’ITER à Cadarache.

Je me demande ce que peut faire Facebook en dépensant $15B de R&D par an. Pour l’instant, cela prend la forme des casques de VR Meta Quest (avec de meilleures optiques et un format bien plus compact, ce qui est une bonne chose) et de leur métavers Meta Connect qui est une place de marché d’applications de VR, principalement des jeu vidéo, et Horizon Worlds, leur réseau social 3D qui n’aurait à ce jour attiré que 200 000 participants et surtout… de l’ennui. De la belle technologie “à impact” qui va surtout pomper du temps autrement plus productif de nos enfants ! Cela peut cependant aussi servir aux applications de fitness. Meta propose même une Fitness API ! Why not.

La keynote 2022 de Facebook sur Meta Connect contient son pesant de cacahuètes de baratin marketing qui mériterait un décorticage en règle par des sociologues de l’innovation. C’est idéologique à souhait et rempli de poncifs lénifiants, sachant que c’est le lot commun des keynotes à l’Américaine dans presque tous les domaines. Cela fait écho à Comment l’idéologie de la tech a conquis le monde (et pourquoi ce n’est pas une bonne idée) dans ADN, par Marine Protais qui interview Adrian Daub, décembre 2022 sur la manière dont l’idéologie de la tech et de la Silicon Valley imprègne notre monde.

Les nouveautés chez Meta ? Des avatars complets avec leurs jambes animées. Un prototype de création d’avatar 3D de votre tête capable d’être ensuite animé en temps réel après une saisie de quelques secondes avec son smartphone. Mais pourquoi se créer un avatar photoréaliste au lieu d’être enregistré en vidéo ? Surtout vu ce que cela doit coûter énergétiquement. Tout cela semble un tantinet absurde. Enfin, si vous souhaitez ressembler à autre chose, vous pouvez faire vos emplettes dans l’Avatar Store. Et pour les entreprises, Microsoft est de la partie avec l’intégration du métavers Meta avec Teams et Accenture créé des lieux de rencontre en VR qui rendraient les participants plus attentifs. Bref, du solutionnisme technologique dans sa grande splendeur.

Et 2023 dans tout ça ? Je n’en sais rien et ne veux pas savoir.

Tech en vrac

Je suis allé faire un tour des prévisions dans le monde de la tech et ça envoie du rêve ! Cisco nous parle de transformation digitale et de nouvelles menaces dans la cybersécurité, le Gartner Group de “sustainability” de l’IT, le Forrester pense que la résilience dépassera la créativité, IDC prévoit de l’optimisation du cloud en tout genre, pas mal d’analystes évoquent des points d’inflexion dans l’IA et la robotique, le cabinet d’avocats TaylorWessing prévoit l’adoption du métavers par les entreprises ce qui est quelque peu prématuré, etc. D’autres utilisent ChatGPT3 pour faire des prédictions sur 2023, qui génèrent des lieux communs à la pelle décrivant de vagues avancées dans tous les domaines (IA, robotique, cybersécurité, drones, matériaux, énergies renouvelables, quantum computing, etc). Du côté de l’énergie et des transports, nombreux sont ceux qui prévoient une belle croissance des ventes de véhicules électriques.

Et pour Twitter, cela pourrait aller de mal en pis. On est bien loin du garage de 10 personnes que j’avais visité à San Francisco en 2007 (en groupe), ci-dessous, Jack Dorsey !

CES 2023 de Las Vegas

Je n’ai pas prévu d’y aller en 2023. Je reçois bien les annonces des exposants et j’ai l’impression que l’histoire se répète à l’infini avec ces startups qui veulent révolutionner le monde avec des concepts qui pas bien nouveaux (comme la “mobilité intelligente”), ou ces grands groupes qui veulent créer un monde meilleur, “éco-friendly” et “plus smart”.

Il y aura donc des voitures électriques, des écrans géants micro-LED ou OLED et des bidules connectés en tout genre ! Les awards 2023 déjà annoncés ? Il y en a plusieurs centaines avec notamment des oreillers connectés et autres machins pour mieux dormir, plus de medtech, y compris pour suivre les ennuis cardiaques de son toutou, un scanner de pied, un robot de récolte de piment, des machines à cocktail, des accessoires pour la réalité augmentée (aka les métavers), des chargeurs de batteries en tout genre, un robot pour vous entrainer à jouer au tennis, une caméra de surveillance dédiée à la détection d’ours, des capteurs de qualité de l’air, une (autre) machine à café connectée, et j’en passe.

En visitant le salon, on y trouvera heureusement des choses et des gens intéressants. Bon courage à mon amie Fanny Bouton qui sera de la partie !

Je serais cependant bien à Las Vegas en 2023, mais en mars, pour participer au congrès APS March Meeting. C’est le plus grand congrès de physiciens, notamment quantiques, au monde.

Conclusion

En 2023 autant qu’avant, il faudra toujours exercer sa curiosité et son sens critique pour évaluer les progrès scientifiques et technologiques annoncés, autant dans l’IA, que dans le calcul quantique ou la fusion nucléaire. C’est aussi vrai de la santé, même si je n’ai pas abordé le sujet ici-même, et où des progrès intéressants semblent être réalisés pour le traitement de certains cancers.

Dans la majorité des cas, les annonces impressionnantes cacheront des détails scientifiques et technologiques “inconfortables” cachés. Elles donneront l’impression que la solution est bien plus proche qu’elle ne l’est réellement. Elles génèreront de faux espoirs notamment au regard de ce qu’il faut faire dans l’immédiat pour limiter les dégâts du réchauffement climatique en cours. La loi de Brandolini sera toujours à l’œuvre, requérant des efforts disproportionnés pour remettre les pendules à l’heure. Tout cela mettra notre rigueur scientifique tout comme notre éventuel optimisme à rude épreuve. Mais cela n’empêche pas d’avoir confiance, en moyenne, dans la science et les scientifiques.

Bonne année 2023, pleine d’amour et de découvertes !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles