Version rapide : non.

Version longue : quelques digressions dans ce qui suit qui font une compilation de l’actualité récente.

Depuis quelques mois sévit une petit musique récurrente et parfois redondante : l’IA n’existe pas (Luc Julia en février 2019), les startups de l’IA ne font pas d’IA (étude MMC Venture en mars 2019), l’IA cache un esclavagisme moderne de la labellisation des données (reportage de Cash Investigation en septembre 2019), l’IA ne fonctionne pas sans ceci ou cela (données et compétences), les projets d’IA n’aboutissent pas dans les entreprises, l’IA est une escroquerie et l’IA est surtout dangereuse, exemple en date, l’interdiction de la reconnaissance faciale dans certaines villes (à San Francisco en mai 2019 et à Portland en décembre 2019). On pourrait extrapoler tout cela en prévoyant que l’IA serait quasiment sur une pente glissante, avec largement de quoi entrer dans un troisième hiver de l’IA après ceux des années 1970 et des années 1990.

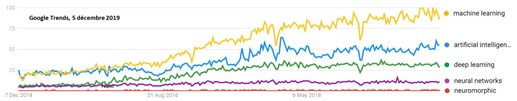

Pour savoir si l’IA était toujours dans l’air du temps, j’ai fait un petit tour chez Google Trends. On peut y constater sur les termes clés du domaine que l’intérêt sur le sujet a bien grandi entre 2016 et 2018 et que l’on est arrivé depuis à un certain plateau. Ce n’est pas encore une demi-gaussienne, mais cela pourrait à terme le devenir.

Mais comme nous allons le voir, l’IA n’est pas encore sur une pente glissante… vers le bas ! Ou alors, on devrait considérer que les smartphones sont en déclin puisque leurs ventes sont en décroissance depuis deux ans dans le monde (du fait d’un taux d’équipement élevé) !

B2Bization de l’IA

Le désamour potentiel de l’IA peut se manifester dans les entreprises qui commencent à accumuler des retours d’expérience. Ainsi, même si c’est encore bien caché, les chatbots réalisés à la va-vite ne fonctionnent pas si bien que cela. Seuls ceux qui ont été créés avec force moyens et des objectifs clairs donnent de bons résultats. Les projets d’IA n’aboutiraient pas dans la moitié des cas et en plus, il serait difficile de mesurer leur retour sur investissement. Ces études empiriques sont intéressantes mais il leur manque généralement une perspective comparative par rapport aux projets numériques habituels. Et si ces échecs étaient la norme et non une exception de l’IA ? Et par ailleurs, les projets d’IA bien documentés dans des études de cas sont bien rares. C’est dommage.

Au même moment, tous les métiers se mobilisent pour intégrer l’IA dans leurs activités, comme ils l’ont fait par le passé avec la micro-informatique, Internet ou la mobilité. Santé, éducation, RH, agriculture, BTP, médias, banques et assurances, télécoms, tout y passe ! Et certains trouvent même que cela va trop vite !

En pratique, ces organisations et métiers ont plutôt l’embarras du choix des projets à lancer qui intègrent des briques d’IA. Le plus souvent, il s’agit de briques de traitement de l’image, du langage, du bruit ou de données structurées. On assiste à une “B2Bization” de l’IA après une inondation dans le grand public avec la gestion de la photo dans vos smartphones (tout ça pour faire des selfies…) et la commande vocale (Alexa, Google Assistant, Siri, …).

L’IA actuelle, fondée principalement sur le deep learning est en train de se banaliser. Au passage, plus on l’utilise, plus on sort des visions fantasmagoriques et mystiques d’une IA qui dépasserait l’Homme après avoir atteint et dépassé le seuil de son intelligence. L’IA est en train de perdre son petit côté magique.

Démocratisation de l’IA

L’IA est aussi en train de se démocratiser grâce au nombre croissant d’outils pour sa création, et qui sont de plus en plus haut niveau. Après Google, Microsoft, DataRobot et Prevision.io et tant d’autres, c’était au tour d’Amazon de se lancer avec SageMaker Autopilot dans l’AutoML ou AutoAI, cette catégorie d’outils logiciels qui savent déterminer automatiquement les modèles de machine learning et de deep learning pour exploiter de gros volumes de données, notamment pour faire de la classification, de l’identification de corrélations entre données d’observation et pour faire des prévisions.

L’IA se dissout progressivement dans tous les logiciels qui gèrent des données, ce qui fait du monde ! Il reste d’ailleurs encore énormément de choses à inventer, notamment dans le traitement du langage et le travail collaboratif. Certaines de ces nouveautés peuvent ainsi tarder à voir le jour lorsqu’elles s’adressent à des niches de marché. Cela explique la variabilité de la densité d’innovations entre secteurs d’activité.

La quête des données reste un enjeu qui préoccupe pas mal d’organisations et a même tendance à les bloquer dans leur créativité autour de l’IA. Elles ont trop gobé le message selon lequel seuls les GAFA disposaient des volumes de données adéquats pour faire de l’IA. J’avais essayé de relativiser cette crainte dans Les GAFA, les entreprises et les données de l’IA publié en juillet 2019. La tendance est même à la création de modèles de deep learning qui requièrent des volumes de données plus raisonnables pour s’entraîner.

Dans la santé, la branche de l’IA qui fonctionne le mieux est la reconnaissance d’image. Les annonces se ressemblent et se succèdent de performances d’IA qui reconnaissent et caractérisent des pathologies, souvent cancéreuses, dans des radios, IRM et autres biopsies. Elles commencent maintenant à peine à être déployées ! C’est donc plutôt la fin du début que le début de la fin de cette Histoire.

Progrès du hardware de l’IA

Les progrès algorithmiques continuent d’avancer dans le deep learning, mais aussi dans le matériel aussi bien côté serveurs et entraînement et pour l’embarqué, le edge et le endpoint computing (IA dans ou proche des objets connectés). De nouveaux processeurs extraordinaires ont fait leur apparition en 2019 comme celui de Cerebras. Les processeurs à neurones à impulsion (IBM TrueNorth, Intel Loihi) se développent aussi en parallèle. Sans compter les approches originales des Français LightOn et AnotherBrain que j’aurais l’occasion en 2020 d’analyser en détail.

Qualcomm annonçait cette semaine doubler encore la puissance d’inférence de son dernier chipset de smartphone le Snapdragon 865, avec une puissance de 14 TOPS (tera-opérations en entiers par seconde). En 2020, on pourrait voir Nvidia changer encore la donne avec le successeur du légendaire GPU V100 utilisé massivement dans les data-centers et pour l’entraînement de modèles de deep learning.

Ces avancées technologiques permettent de répondre partiellement à une objection face à l’IA qui est son empreinte carbone. Elle n’est pas négligeable mais se noie pour l’instant dans la consommation générale d’outils numérique dont elle n’est qu’un aspect.

Impact de l’IA sur les emplois ?

Cette anticipation d’une chute de l’IA cohabite avec celle, totalement inverse, des emplois qui seraient inexorablement remplacés par des IA, au point que presque toutes les tâches humaines seraient menacées, y compris les métiers de chercheurs. Comme on aime bien les symboles, celui de la retraite prématurée du champion de Go Lee Sedol (36 ans) a marqué les esprits. Il la prend plus tôt qu’un joueur de football professionnel ! Et cela n’est pas à cause des plus jeunes, mais parce qu’il juge qu’il ne peut plus se battre contre l’IA. Heureusement, le métier de joueur de Go professionnel n’étant pas courant, l’impact de cette nouvelle est totalement anecdotique et sans importance sur l’emploi mondial. Les joueurs de Go sont-ils couvert par un régime spécial de retraite ? L’annonce me fait le même effet que si on décidait de ne plus apprendre à compter à l’école à cause des tableurs, ou à lire et à écrire du fait du déploiement de la commande vocale ! Ceci étant dit, plusieurs états des USA ont décidé d’arrêter l’apprentissage de l’écriture manuscrite cursive il y a quelques années.

Dans Why The Retirement Of Lee Se-Dol, Former ‘Go’ Champion, Is A Sign Of Things To Come (Forbes, novembre 2019), Aswin Pranam nous incite en tout cas à revisiter nos activités professionnelles : “we need to reassess the beliefs, values, attributes, and skills that make us who we are. Otherwise, we fall victim to hard questions about meaning when the next AI wave arrives.”. Bonne question. Longues réponses, à trouver tâche par tâche et métier par métier !

Si des entreprises annoncent encore licencier, c’est rarement à cause de l’IA, tout du moins directement. Lorsque les banques licencient, c’est du fait du passage d’un métier d’agences à de la banque en ligne. Certes, elle peut s’appuyer en partie sur des chatbots comme le fait Orange Bank, mais ce n’est pas suffisant. IBM aurait réduit la taille de sa RH grâce à l’IA, mais cela concerne peu de monde. Et s’ils licencient, cela sera surtout pour des questions de manque de compétitivité par rapport à d’autres acteurs du marché des services informatiques. On évoquait il y a quelques années le malheureux sort des avocats. Pour l’instant, l’irruption de l’IA dans les cabinets de juristes ne semble pas avoir généré de victimes humaines. Les conséquence de toute automatisation sont toujours moins directes qu’il n’y paraît. Elle peut ainsi contribuer à élargir un marché en rendant certaines prestations plus abordables. C’est assez délicat à prévoir.

Par contre, on n’est pas à l’abri d’un autre phénomène : aujourd’hui, les compétences techniques autour de l’IA manquent. Les entreprises ont du mal à recruter. Dans tous les pays, un grand nombre de formations supérieures sont mises en place pour y pallier. Il n’est pas impossible que dans quelques années, elles génèrent des profils à contre-courant de la demande. On a déjà connu cela dans les années 1990 et 2000.

IA éthique

Les initiatives et conférences sur l’IA éthique pullulent. Dernière initiative en date, l’UNESCO qui lançait en décembre 2019 la création d’un “instrument normatif international sur l’éthique de l’intelligence artificielle” en novembre 2019. L’organisation internationale va créer un groupe d’experts qui donneront un avis d’ici septembre 2020. Le texte sera ensuite adopté en 2021. Il est probable que ce texte ressemblera de près à d’autres textes et chartes d’éthique de l’IA comme la Déclaration de Montréal de fin 2018.

On s’inquiète bien des robots tueurs (Stuart Russel) ou des fake news générées par des réseaux de neurones génératifs. Mais cela n’empêche pas d’avancer sur le reste. Trop d’éthique de l’IA ne tuera pas l’IA. Elle contribuera plutôt à la rendre acceptable et à la développer. De là à faire du “Human centric machine learning” comme le propose la conférence NeurIPS 2019 ? L’ethics washing de l’IA guette à nos portes !

Au-delà de la querelle sémantique de l’IA

La vague de la querelle sémantique sur ce qu’est l’IA est loin d’être étouffée. Je vous rappelle ma définition extensive : l’IA regroupe l’ensemble des techniques qui visent à émuler, imiter ou étendre, généralement en pièces détachées, des composantes de l’intelligence humaine. C’est ce que l’on trouve dans la littérature scientifique sur l’IA depuis les années 1950. Cela comprend techniquement un champ scientifique très large qui a plus de six décennies d’ancienneté avec les outils du raisonnement logique, l’apprentissage automatique (machine learning, réseaux de neurones et deep learning) et les systèmes multi-agents. Certaines briques de l’IA sont de nature assez anthropomorphique comme le traitement du langage ou la vision et d’autres dépassent déjà de très loin les capacités humaines, lorsqu’il s’agit de cruncher de très gros volumes de données.

La bataille entre connexionnistes et symbolistes semble avoir été récemment relancée par Yann Le Cun, au moins via un tweet qui a généré une réaction acerbe de Gary Marcus, un scientifique et entrepreneur américain de l’IA qui souhaite rapprocher les méthodes symboliques et connexionnistes de l’IA. En tout cas, l’association trop directe entre l’IA et le machine learning et le deep learning est bien réductrice.

Lorsque dans To Understand The Future of AI, Study Its Past, Rob Toews écrit que “Neural networks do not develop semantic models about their environment; they cannot reason or think abstractly; they do not have any meaningful understanding of their inputs and outputs. Because neural networks’ inner workings are not semantically grounded, they are inscrutable to humans”, il confond les méthodes actuellement utilisées dans les réseaux de neurones (convolutifs, à mémoire) et leur principe général que rien ne devrait empêcher théoriquement de manipuler des symboles, comme le cerveau humain. Ce dernier, jusqu’à preuve du contraire, est aussi un (grand) réseau de neurones ! La séparation entre IA symboliques et connexionnistes devrait plus porter sur la comparaison de l’efficacité de méthodes différentes pour obtenir un résultat équivalent. On peut aussi bien manipuler des graphes et des ontologies avec de l’IA symbolique et logique qu’avec des réseaux de neurones. Tout ceci explique l’intérêt de poursuivre les recherches sur le fonctionnement du cerveau humain qui s’appuient sur différentes techniques comme l’IRM fonctionnelle, qui sert à détecter les zones d’actives du cerveau en fonction des tâches qu’il exécute. C’est un moyen d’éviter de se retrouver dans l’impasse que certains ressentent dans la recherche sur le deep learning, comme Jérôme Pesenti de Facebook, qui est moins optimiste que Yann Le Cun sur ce point (il est son N+1 au FAIR).

Observation et simulation

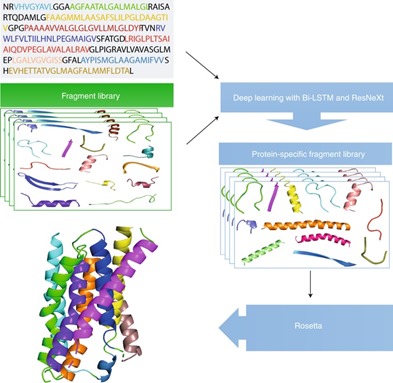

L’une des remises en cause sérieuses de l’IA viendra peut-être du calcul quantique. Non pas parce que l’on pourra exécuter certains algorithmes de machine learning plus efficacement sur un ordinateur quantique que sur un ordinateur classique (ce sera possible), mais plutôt parce que ceux-ci permettront pour résoudre certains problèmes de sortir des logiques d’observation connexionnistes du deep learning. Le meilleur exemple est celui de l’évaluation du repliement des protéines sur elles-mêmes.

Avec le deep learning, incarné depuis fin 2018 par la méthode AlphaFold de DeepMind, on évalue ce repliement en exploitant un réseau de neurones entraîné avec la connaissance que l’on a du repliement de protéines connues. Avec du calcul quantique, on pourra utiliser directement les lois de la physique quantique pour déterminer ce repliement. C’est encore sujet à caution mais cela permet de comprendre la différence : entre évaluation probabiliste et calcul direct. Lorsque les lois de la physique newtoniennes ou quantiques peuvent être mises en œuvre dans le calcul, on peut se passer de l’approche probabiliste. Surtout dans la mesure où celle-ci est contrainte par notre connaissance de l’existant et peut difficilement en sortir contrairement à la simulation. A la clé : l’invention de nouvelles thérapies. Le délai : parfaitement impossible à déterminer et probablement de plusieurs décennies.

En tout cas, l’IA comme le calcul quantique ne permettront pas de créer un monde parfaitement déterministe et c’est tant mieux.

Startups de l’IA

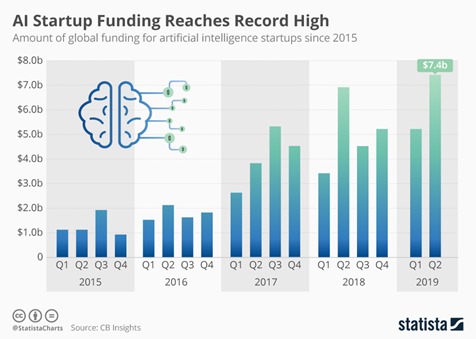

L’autre indicateur à exploiter pour analyser les vagues est celui de l’investissement dans les startups. Il semble pour l’instant que 2019 soit encore une belle année en croissance pour les startups de l’IA et des deux côtés de l’Atlantique ainsi qu’en Chine.

Même si ce sera probablement une année dominée par des “série C”, ces tours de financement de plusieurs dizaines voire centaines de millions de dollars, comme ce dernier tour réalisé par Dataiku (2013, $146M) auprès de Google Ventures. Une startup française qui a compris le jeu et se présente maintenant comme une startup New Yorkaise ! Les investissements en amorçage dans les startups de l’IA ont par contre tendance à se calmer.

On verra ce que donnera 2020. Il est possible que l’on assiste à une décrue du nombre de startups de l’IA financées. Cela pourra s’expliquer par plusieurs facteurs : un calme dans le financement des startups en général, la banalisation de l’IA chez toutes les startups qui font du logiciel, ou l’émergence de vagues technologiques plus importantes même si l’on n’en voit encore ni la couleur ni la masse (Blockchain, VR/AR).

Géopolitique

Autre signal que l’IA est toujours bien vivante, la poursuite de la bataille géopolitique qui l’entoure. Les chercheurs Américains du domaine poursuivent leur lobbying pour la création d’un Artificial Intelligence Initiative Act, qui toujours débattue au Congrès (en décembre 2019). Les Russes qui se réveillent et viennent de formaliser leur propre plan de l’IA, avec une connotation militaire assez forte. Quant aux Chinois qui ont claironné leur objectif de dominer le monde de l’IA avec leur recherche et leurs entrepreneurs, ils n’investiraient pas tant que cela dans le domaine. Ce qui donne d’ailleurs du grain à moudre pour les Américains qui utilisent l’épouvantail chinois pour obtenir des crédits comme ce fut le cas pour les $1,25B du National Quantum Initiative Act validé en décembre 2018.

Bref, la vague de l’IA ne semble pas épuisée. Elle se fondra tôt ou tard avec l’ensemble des technologies numérique et en deviendra une composante banalisée. Finalement, l’IA, c’est juste du logiciel avec des données !

Le débat reste cependant ouvert ! A vous de jouer !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Le vague de l’IA est-elle terminée ?

Un article documenté qui compile l’actualité récente sur le développement de l… https://t.co/BsHbiQcBwE

Merci Olivier de cet article très complet et très intéressant (comme toujours). Toujours un plaisir que de lire tes chroniques. Si je peux te suggérer une prochaine chronique, c’est de développer ton parallèle entre IA et calcul quantique sur lequel j’aurai besoin de plus d’éclairages ! Maintenant, c’est plus une envie de mieux comprendre…

Hello ! Je traite de ce sujet dans mon dernier ebook sur le quantique. https://www.oezratty.net/wordpress/2019/comprendre-informatique-quantique-edition-2019/, pages 178 à 183.

Merci Olivier pour ce très bon article.

J’aurais simplement changé la dernière phrase en « Finalement, l’IA, c’est juste du logiciel avec des mathématiques et des données ! » car la contribution des mathématiques est nécessaire en IA. Même si on peut considérer que les mathématiques sont embarquées dans le logiciel, la construction des algorithmes d’IA nécessite un savoir-faire mathématique rarement nécessaire pour la construction des algorithmes de l’IT.

A ce détail près, j’adhere à la conclusion (je devrais dire à la prédiction) que l’IA sera à terme (mais à quel terme ?) intégrée dans l’ensemble des technologies numériques.

Pour autant, les entreprises vont devoir utiliser cette technologie dans des formats plus rudimentaires si elles veulent l’utiliser des maintenant pour construire ou affirmer leur avantage concurrentiel. Cet état des lieux des technologies disponibles pourrait peut-être faire l’objet d’un futur post ? Je vais aller voir dans les e-books au cas où…

Gravi encore une fois pour ce post.

” la vague de l’IA ne semble pas épuisée. Elle se fondra tôt ou tard avec l’ensemble des technologies numérique et… https://t.co/CsIRw5mkNL

[#IA] La vague de l’IA est-elle terminée ?

Elle ne semble pas épuisée ! Elle se fondra tôt ou tard avec l’ensemble… https://t.co/LPlapDm0eh

En informatique, l’intelligence artificielle (IA), parfois appelée intelligence machine, est l’intelligence démontrée par les machines, contrairement à l’intelligence naturelle affichée par l’homme. rooftop snipers jeu.

l’ #IA n’est pas encore sur une pente glissante https://t.co/AuB4XBmcnK #IntelligenceArtificielle