J’ai passé une journée et demie à Grenoble, en participant à un workshop sur l’informatique quantique organisé par le CEA-Leti sous la houlette de Maud Vinet. La parole y avait été donnée à près de 30 chercheurs d’horizons divers, aussi bien issus des laboratoires de recherche de Grenoble (CEA-DRF, CEA-Leti et CNRS Institut Néel).

Avec Christophe Jurczak du fonds d’investissement Quantonation, je suis intervenu à la fin du workshop pour partager quelques réflexions sur la construction de l’écosystème français (voire européen) du calcul quantique.

C’était la seconde fois que je rencontrais sur place les équipes de Grenoble, où j’étais passé, avec Fanny Bouton, en juillet 2018. J’en suis sorti enthousiasmé sur la capacité potentielle de la France de tirer son épingle du jeu et de produire un jour des ordinateurs quantiques compétitifs.

D’une mission parlementaire à un plan industriel

La mission parlementaire lancée en avril 2019 et pilotée par Paula Forteza a terminé ses auditions. Elle devrait remettre son rapport d’ici septembre-octobre 2019. Le gouvernement devrait emboîter le pas immédiatement et proposer un plan quantique pour le pays reprenant tout ou partie des propositions de la mission parlementaire.

Au minimum, nous aurons probablement les figures de style habituelles :

- Le plan devrait couvrir tous les pans technologiques des applications du quantique, comme ceux des autres pays. En plus du calcul quantique sous toutes ses formes, nous aurons donc aussi la métrologie quantique (mesure de précision), les télécommunications et cryptographies quantiques.

- L’excellence de la recherche française sera mise en avant pour légitimer une place de choix dans ce nouveau secteur. On se la raconte sur chaque nouveau plan. Il faut certes investir dans la recherche et si possible revaloriser la rémunération des chercheurs qui est un véritable cache-misère. Mais ce n’est pas assez.

- Le financement des deep techs du secteur sera évidemment à l’ordre du jour dans la lignée des plans lancés par Bpifrance entre mi 2018 et janvier 2019. Voir mon post de février 2019, La France des deep techs.

- Il faudra aussi former les jeunes et les moins jeunes, surtout dans la création de solutions logicielles quantiques, sachant que dans le cadre du quantique, la barrière intellectuelle est bien plus élevée, en tout cas, avec les outils de développement actuels. La question est de savoir comment l’Etat pourra accélérer le lancement de ces formations post-BAC.

- L’Etat sera un client de technologies quantiques, notamment au niveau de la défense et du renseignement. Il pourra jouer le rôle d’aiguillon pour encourager la création d’acteurs du logiciel, concomitamment avec les grandes entreprises de marchés divers (énergie, transports, santé, finance, télécoms) que l’Etat ne pourra pas forcément activer directement.

- Il faudra éventuellement construire une stratégie européenne. On peut rêver d’un Concorde ou d’un Airbus du quantique. Le premier pour sa symbolique d’excellence technologique et le second pour sa réussite industrielle. Reste à assembler les bonnes briques technologiques et acteurs du privé pour bâtir cette stratégie et créer des offres commerciales. Le seul acteur de poids européen véritablement engagé dans cette filière est Atos.

- L’annonce du rapport et du plan gouvernemental associé devrait générer une visibilité médiatique sur le sujet. C’est toujours bon à prendre pour développer un intérêt chez les entreprises et aussi pour susciter des vocations.

Mais tout cela sera insuffisant pour faire émerger un véritable écosystème industriel du quantique. On l’a bien vu avec l’intelligence artificielle où la France rame globalement derrière les pays leaders (USA, Canada, UK, Chine). La France va produire son plan quantique bien après les autres pays développés (UK = 2013, Canada = 2015, USA = 2016 et 2018, Chine = 2015).

Il y a plein de raisons pour lesquelles les plans du passé ont échoué à générer un leadership français digne de ce nom. J’ai notamment en tête le plan objets connecté de 2014. Son principal dispositif était la Cité des Objets Connectés d’Angers que le monde entier devait nous envier. Début 2019, elle changeait de main en passant de celles d’Eolane au cluster technologique WE Work dans le cadre de la création d’un “Technocampus” de l’électronique, mutualisant des moyens industriels et d’innovation de l’industrie d’assemblage électronique avec la participation notable du groupe Lacroix. Entre temps, le marché mondial des objets connectés ne s’est pas développé aussi vite que prévu et très peu d’acteurs français ont réussi à percer à l’échelle internationale, surtout dans les marchés grand public.

Les plans industriels échouent souvent dans la jonction entre la recherche, l’industrialisation et les marchés. On croit naïvement que l’excellence de la recherche se transforme magiquement en succès commercial. Et qu’il suffit de greffer des commerciaux ou des “business developers” pour arriver à percer. Ce n’est bien entendu pas le cas.

Dans les deep techs, comme ailleurs, il faut créer un produit, être différencié et compétitif par rapport au reste du monde, offrir une solution pertinente à des segments clients identifiés et bien entendu bien marketer et vendre sa solution à l’échelle mondiale, le marché US étant souvent critique pour réussir à l’échelle. Une fois cela réalisé, le nirvana de la création d’un produit-plateforme et d’un écosystème associé peut s’en suivre. Bref, un bel alignement de planètes.

Le cas du calcul quantique

Le chantier à mener pour y parvenir dans le calcul quantique est probablement l’un des plus tortueux qui soit. Malgré l’existence d’offres commerciales chez des acteurs américains et canadiens tels qu’IBM, Rigetti et D-Wave, on est loin de disposer d’ordinateurs quantiques viables et notamment, permettant d’obtenir ce que l’on appelle la suprématie quantique. A savoir, une performance permettant de réaliser des traitements impossibles à exécuter sur des ordinateurs traditionnels, y compris sur les plus grands supercalculateurs mondiaux. La question ne porte pas du tout, comme avec l’intelligence artificielle, sur l’accès à de gros volumes de données. Ce n’est pas trop le champ d’action du calcul quantique.

Le chantier du quantique est immense. Il est pour l’instant à la croisée des chemins de la science et de l’ingénierie. Il faut pouvoir d’abord créer des qubits physiques présentant des caractéristiques uniques appelées “figures de mérite” par les chercheurs :

- Stabilité dans le temps qui est aujourd’hui de l’ordre de 100 micro-secondes pour les ordinateurs à base de qubits supraconducteurs. On appelle cela le temps de cohérence.

- Fidélité : avec des taux d’erreur aussi faibles que possible lors des calculs, qui sont bien trop élevés aujourd’hui. On peut compenser cela avec un grand nombre de qubits avec ces taux d’erreur mais on ne sait pas encore les fabriquer.

- Echelle : le tout avec un grand nombre de qubits.

- Intrication : entre les qubits, ce qui qui permet de réaliser des calculs quantiques avec des portes quantiques logiques.

Quelle que soit la technologie employée, aucun laboratoire de recherche ou industriel n’est aujourd’hui parvenu à satisfaire ces différentes contraintes. Elles sont de nature scientifique et technologique. Nombre d’annonces récentes : les 20 qubits d’IBM Q, les 72 qubits de Google, les 129 qubits d’IonQ, les 18 qubits optiques des Chinois, relèvent tous du cache-misère et de solutions bâclées qui ne fonctionnent pas bien et surtout, ne peuvent pas “scaler”.

L’enjeu du calcul quantique est de créer une filière qui permette de réussir dans les figures de mérite citées ci-dessus, et surtout, de “scaler” en nombre de qubits. Pour y parvenir, il faut résoudre des casse-têtes nombreux.

- Pour tout un tas de raisons, les qubits supraconducteurs qui ont été choisis par IBM, Google et Rigetti ne pourrons pas scaler au-delà de quelques centaines de qubits. Ils le savent. IBM a mis la charrue avant les bœufs en annonçant son Q System One en janvier 2019, avec 20 malheureux qubits bruyants et doté d’un design de musée. Pourquoi faire ? Pour l’y exposer rapidement ?

- Les qubits réalisés en photonique sont séduisants mais leur circuiterie limite statiquement le nombre de portes quantiques que l’on peut exécuter, donc, la longueur d’un algorithme, appelée “profondeur” en calcul quantique. C’est une technique utilisant des qubits volants, des photons, qui se dégradent sur leur trajet.

- Les qubits à ions piégés présentent des limites physiques diverses, surtout en nombre de qubits alignables.

- La filière des atomes froids, poursuivie notamment par la startup française Pasqal, est prometteuse pour créer des simulateurs quantiques adaptés à la résolution d’équations de la physique quantique.

- Enfin, les fermions de Majorana visés par Microsoft semblent pour l’instant être une voie de garage.

Restent les qubits en silicium à spin d’électrons (ou quantum dots, ou CMOS selon les appellations). C’est la voie hardie choisie par le CEA au Leti et en collaboration avec le CNRS. Elle est poursuivie par un nombre relativement faible d’acteurs : Princeton, l’UNSW en Australie, le CEA-Leti et le CNRS en France, et Quantum Motion Technologies au Royaume Uni. Ce n’est pas une voie simple mais, si elle aboutit, elle sera la seule à “scaler”. Il est tentant de… tenter le coup ! Sachant que l’affirmation que je partage ici ne fait pas forcément l’unanimité chez les physiciens.

Dans son discours introductif du workshop quantique du 28 juin 2019, Cédric Villani revenait sur le rôle des erreurs dans l’histoire des sciences. C’était un peu le pendant scientifique du droit à l’échec dans l’entrepreneuriat. La science relève d’une lutte interminable contre l’inconnu. Le meilleur chemin est inconnu. L’incertitude règne. Les scientifiques font beaucoup d’erreurs. Il cite les plus connues comme Lord Kelvin qui s’était trompé sur l’âge de la Terre ou Henri Poincaré sur la stabilité du système solaire. Les bons scientifiques doivent savoir se remettre en cause et reconnaître leurs erreurs. C’était le cas de Poincaré qui corrigea son papier.

La science est affaire d’allers et retours permanents entre construction de théories et expérimentation. Les premières expliquent les secondes et ces dernières valident les premières, jusqu’au prochain cycle. Et le cycle est parfois long comme ce siècle qui a été nécessaire pour vérifier l’existence des ondes gravitationnelles ou les 50 ans pour valider l’existence des bosons de Higgs. Tout cela était un encouragement bien vu à la prise de risque scientifique autour du quantique, qui doit explorer de nombreuses voies et pas une seule.

Le calcul quantique est situé dans cette zone d’ombre de l’inconnu et des limites de la physique. Il oppose des optimistes, que j’ai rencontrés à Grenoble, et des pessimistes, comme Gil Kalai en Israël ou le chercheur russe Mikhail Dyakonov né en 1940 en URSS et qui officie dans le Laboratoire Charles Coulomb (L2C) du CNRS et de l’Université de Montpellier. Il a exprimé son point de vue dans un article largement relayé dans le monde fin 2018, The Case Against Quantum Computing, 2018. Lui ont répondu Scott Aaronson dans Happy New Year! My response to M. I. Dyakonov et Skepticism of Quantum Computing ainsi que par Ben Crige dans The Case Against ‘The Case Against Quantum Computing’ en janvier 2019. Bref, ayons confiance ! Il faut toujours être un peu dingue par rapport à son temps pour réussir ensuite.

Dans une stratégie, il faut aussi planifier quelques coups d’avance. Pour sécuriser une éventuelle avancée française dans la concurrence mondiale, il faudra s’assurer que les entreprises françaises ou européennes du secteur le restent, que l’approvisionnement en matières premières est bien garanti (silicium purifié d’isotope 28, niobium-titane pour les câblages supraconducteurs, hélium 3 pour la cryogénie), qu’un bon mix de brevets et de secret industriel protège la propriété intellectuelle et que l’on conserve les outils industriels de production des composants clés.

Les atouts de Grenoble

Avant même de parler de packaging ou de design de produit, il faut pouvoir créer des ordinateurs quantiques fonctionnels “top to bottom”, y compris les nombreuses couches logicielles nécessaires pour les piloter et les programmer. C’est un défi scientifique et d’ingénierie qui nécessite de croiser de très nombreuses disciplines.

Un ordinateur quantique peut difficilement sortir d’un simple garage comme le furent les premiers micro-ordinateurs d’Apple. Ces derniers utilisaient d’ailleurs des processeurs Motorola, sans lesquels rien n’aurait été possible, et qui nécessitaient déjà des salles blanches bien équipées pour les fabriquer. Idem pour la mémoire RAM !

C’est dans cette intégration de compétences diverses que les équipes de recherche françaises peuvent faire la différence. Dans le quantique, la recherche collaborative prend tout son sens. Elle implique de nombreux laboratoires et de nombreuses disciplines.

A Grenoble, la recherche quantique est pilotée par différentes branches du CEA (Leti en nanoélectronique et IRIG en physique) et du CNRS (dans l’Institut Néel). Tous ces laboratoires sont situés sur la presque-Île de Grenoble qui regroupe une bonne part les laboratoires de recherche du coin.

Elle est structurée autour de trois initiatives : QuEnG, QuantECA et QuCUBE qui se sont d’ailleurs pas du même niveau.

QuEnG ou Quantum Engineering Grenoble, est un écosystème qui va du philosophe à l’industriel. C’est l’initiative chapeau trans-laboratoire, trans-disciplinaire et trans-sectorielle par excellence. Elle s’attaque à la réalisation de qubits en CMOS et électrons piégés. Les équipes travaillent en physique sur de nombreuses autres filières : en photonique, sur des qubits supraconducteurs en CMOS et sur des aimants moléculaires. Même en étant rivées sur les qubits CMOS, ces autres branches peuvent l’accompagner. Ainsi, la photonique peut permettre la création de liens entre processeurs quantiques pour distribuer les traitements ou de créer de la mémoire quantique, utile pour certains algorithmes quantiques.

Le travail sur les capteurs joue un rôle pour mesurer l’état des qubits, quels qu’ils soient. Ils planchent aussi sur les questions de thermodynamique. Alexia Auffeves, du CNRS Institut Néel, en est une grande spécialiste. Ils s’intéressent aux capteurs, aux codes de correction d’erreurs et aux algorithmes quantiques, notamment en partenariat avec Atos. Des équipes font aussi le lien entre physique quantique et philosophie avec Vincent Lam. L’initiative comprend aussi la formation d’ingénieurs en physique et en calcul quantique avec des formations diverses dont un projet avec l’Ensimag, la grande école d’informatique de Grenoble. Ils sont aussi partenaires d’IBM.

QuEnG est financé notamment par l’IDEX (Initiative d’Excellence) des Programmes d’Investissements d’Avenir (PIA) de l’UGA (Université Grenoble-Alpes) avec 1,7M€ complétés par un financement européen FP7 de 1,9M€ couvrant notamment des bourses de thésards. Le tout bénéficie aussi du financement de 14M€ de l’ERC Synergy Grant obtenu par l’équipe QuCube en 2018 (financement européen de recherche d’excellence). En tout, l’initiative a bénéficié de 23M€ de financements publics étalés sur 3 ans. QuEnG regroupe une centaine de chercheurs en sciences fondamentales. S’y ajoutent ce qu’ils appellent des avantages en nature avec l’accès aux salles blanches du CNRS, du CEA-Leti, de SOITEC à Bernin et de STMicroelectronics à Crolles près de Grenoble qui permettent la fabrication de nombreux composants critiques : wafers SOI (silicon on insulators), prototypes de composants et industrialisation de leur fabrication.

QuantECA ou Quantum Electronic Circuits Alps est une initiative qui se situe au-dessous de QuEnG et couvre la partie intégration à grande échelle de qubits dans des puces. Elle regroupe le CEA-Leti, le département de physique de l’IRIG (ancien INAC) et le CNRS Institut Néel. Leur champ d’action est la création de circuits de qubits stables, scalables et bien intriqués. Ils planchent aussi sur les technologies de stockage et de transport de l’information quantique. Ils s’appuient sur trois branches technologiques (supra-conducteurs/optique/spin d’électron spin). Ils maîtrisent en particulier une technologie unique au monde : l’optomécanique intégrée dans des circuits CMOS. Le CMOS est une partie de l’effort.

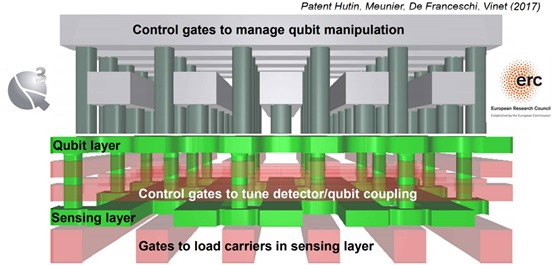

QuCUBE est l’initiative qui a récupéré le financement ERC Synergy Grant de 14M€ en 2018. Son objectif est de créer un ordinateur quantique avec plus de 100 qubits d’ici moins de 10 ans en technologie CMOS / spin d’électron. Les qubits auront une taille de 100 nm avec la possibilité à terme d’en intégrer des millions dans un chipset. L’une des technologies clés à miniaturiser sont les briques de conversion du spin des électrons piégés en charge électrique. Les capteurs associés sont placés dans une couche qui est située en-dessous des qubits. Les éléments de contrôle des qubits (initialisation, portes quantiques) sont placés au-dessus des qubits (source du schéma ci-dessus).

Le workshop quantique du 28 juin 2019

Ce workshop voyait se succéder presque une trentaine d’intervenants dans des interventions de 10 à 15 mn dans la belle salle de conférence de Minatec. La diversité des travaux de recherche et technologies présentés était saisissante. Elle associait des chercheurs de laboratoires divers de Grenoble et d’ailleurs en France, essentiellement de région parisienne. Les présentations du workshop sont disponibles ici.

Il n’était cependant pas évident de reconstituer le puzzle constitué de toutes ces briques. De nombreuses pistes de qubits différentes étaient présentées alors qu’au bout du compte il faudra en choisir une. C’est déjà un moyen d’explorer plusieurs voies possibles. Mais ces travaux peuvent aboutir à des bouts de solutions périphériques au type de qubit qui sera utilisé, que ce soit pour les contrôler, en mesurer l’état ou les relier entre eux. Ce qui suit intéressera surtout les spécialistes du sujet. Si vous n’avez pas encore lu Comprendre l’informatique quantique (novembre 2018, 342 pages) ou d’autres ouvrages de vulgarisation sur le calcul quantique, cela ne sera pas évident à suivre. Je planche en ce moment à la mise à jour de cet ebook, avec parution prévue d’ici la fin de l’été 2019.

Fabrication

Dans une première partie dédiée aux technologies, Fabrice Nemouchi du CEA-Leti mettait en avant le rôle de la plateforme de fabrication de la salle blanche du Leti à Grenoble en wafers de 300 mm. Celle-ci est utilisée pour créer des prototypes de qubits supraconducteurs, semiconducteurs, à photons et même à ions piégés. Même en se focalisant sur les qubits CMOS, l’investissement dans la photonique au silicium est utile, comme par exemple pour des détecteurs de photons uniques. En effet, elle est incontournable pour créer des solutions de communication quantique aussi bien pour de la cryptographie que pour connecter des unités de traitement quantiques entre elles. Cela préfigure les architectures multiprocesseurs quantiques. En photonique, ils travaillent en relation avec le laboratoire Thales TRT conjoint avec le CNRS, situé à Palaiseau et que je vais visiter en juillet 2019.

Le processus de développement utilise des wafers SOI (silicon on insulator, avec un isolant en oxyde de silicium) sur lesquels est déposé une fine couche de silicium d’isotope 28 purifié à 99,992%, à spin de noyau d’atome nul et qui n’interagit pas avec le spin des électrons piégés. Cette fine couche est obtenue par un processus de dépôt sous vide de silicium 28 gazeux (chemical vapor deposition = CVD). Ce gaz provient de Russie. La gravure sur ces wafers est réalisée avec du “deep ultra violet” dans la bande de fréquence de 193nm qui est un procédé standard et éprouvé utilisé depuis le début des années 2000. Le principal dopant utilisé ensuite lors de la gravure est le bore.

Mathieu Desjardins présentait CNT Nanotech, un projet du LPA (Laboratoire Pierre Aigrain) de l’ENS Paris devenu une startup en phase de création, crée avec Michael Rosticher et ayant Maud Vinet comme scientific advisor. Leur piste consiste à utiliser des nanotubes de carbone pour piéger les électrons utilisés dans des qubits CMOS. Cela permettrait d’améliorer leur isolation et leur temps de cohérence d’un facteur 100 atteignant une seconde. Ils se contrôleraient par couplage spin-photon. Les défis se situent au niveau des matériaux, du design, de l’électronique de contrôle, de la connectivité, d la topologie et des codes de correction d’erreurs. Les nanotubes sont intégrés au circuit mécaniquement à la fin du processus de fabrication. Les nanotubes de carbone proviennent de la société allemande Micromotive. La liaison entre deux qubits s’appuie sur des cavités à micro-ondes, exploitant le principe de la cQED (cavity Quantum Electrodynamic). A Grenoble, intervenait aussi Takis Kontons, également du laboratoire LPA de Paris. Il traitait des circuits quantiques hybrides exploitant des nanotubes de carbone. Voir Highly coherent spin states in carbon nanotubes coupled to cavity photons, mars 2019 (13 pages).

Types de qubits

S’en suivaient dans une seconde partie des présentations sur différentes pistes de types de qubits.

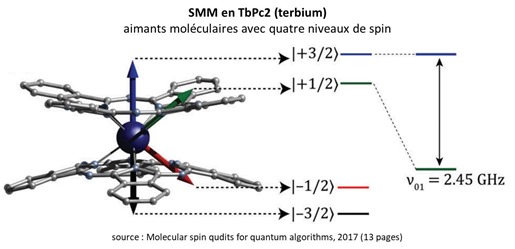

Franck Balestro du CNRS Institut Néel présentait les travaux sur des qubits à base d’aimants moléculaires dont certains fonctionnent à température ambiante. Ils sont fabriqués avec du terbium et ont quatre niveaux quantiques possibles. Le petit nom de ces aimants est SMM pour Single Molecule Magnets. Ils permettent donc de créer non pas des qubits mais des qudits, avec d=4. La molécule utilisée est du TbPc2 aussi dénommée bis(phthalocyaninato)terbium(III) (source). On mesure leur état avec un interféromètre de mesure de phase. L’avantage de ces qudits est qu’ils sont très stables. L’inconvénient est qu’il est relativement difficile de les contrôler. Voir Molecular spin qudits for quantum algorithms, 2017 (13 pages). Ces travaux sont réalisés en partenariat avec L’institut Technologique de Karlsruhe en Allemagne.

Silvano De Franceschi du laboratoire IRIG du CEA de Grenoble (ex INAC) présentait pour sa part les travaux sur les qubits silicium “classiques”. Il rappelait qu’ils étaient démontrés pour la première fois en 2012. Ils sont donc plus récents que les autres types de qubits comme les supraconducteurs, qui existent depuis 2000. Mais il met en évidence qu’ils progressent plus rapidement que ces derniers. Il indiquait que les qubits spin silicium avaient des temps de cohérences longs et une bonne fidélité supérieure à 99%. Comment mesure-t-on l’état de spin de ces qubits utilisant un seul électron ? On exploite de la réflectométrie radiofréquence (RF gate reflectometry). Cette mesure est indirecte et exploite la modification d’amplitude ou de phase d’une onde radiofréquence réfléchie par le quantum dot comprenant l’électron à mesurer.

Pascale Senellart (Quandela et CNRS) présentait la piste des qubits à base de photons circulants. Voir à ce sujet Quatre startups quantiques françaises (mai 2019) où je décrivais déjà son activité. A noter que les circuits photoniques peuvent fonctionner à une température ambiante (300K, soit 27°C) mais les sources de photons doivent être à 10K et les détecteurs à 2K, des températures cryogéniques qui sont cependant moins exigeantes que celles des qubits supraconducteurs et semiconducteurs (15mK à 1K). Résultat : pas besoin d’hélium 3 pour le refroidissement. On se contente d’hélium 4 avec des systèmes de cryogénie un peu plus simples. Ces qubits à photons présentent des limites comme le nombre de portes exécutables mais ils sont intégrables dans des solutions de calcul distribué. Ils peuvent aussi servir à créer de la mémoire quantique pour un processeur quantique.

Zaki Leghtas également du laboratoire LPA de l’ENS Paris présentait ses travaux dans les qubits supraconducteurs et notamment la manière de les protéger contre les erreurs avec un plus faible nombre de qubits physiques intégrables dans un qubit logique en 1D au lieu d’être en 2D comme avec les surface codes classiques. On distingue plusieurs types de bruits, essentiellement le “bit flip” (changement d’amplitude) ou le “phase flip” (changement de phase). Les codes de correction d’erreurs Cat-Qubit fonctionneraient avec seulement 9 qubits physiques et apporteraient un gain exponentiel dans la suppression des erreurs. Ils permettent aussi de se passer de la “magic state distillation”, une technique complexe de codes de correction d’erreurs. Les travaux sont pilotés par une équipe mixte associant l’ENS, Inria (l’incontournable Mazyar Mirrahimi) et l’Ecole des Mines de Paris. Cette présentation était complétée par celle de Jérémie Guillaud de l’Inria.

Voir à ce sujet l’excellente présentation de diverses techniques de codes de corrections d’erreurs quantiques : An introduction to quantum error correction de Mazyar Mirrahimi (31 slides) ainsi que Repetition cat-qubits: fault-tolerant quantum computation with highly reduced overhead, de Jérémie Guillaud et Mazyar Mirrahimi, avril 2019 (22 pages).

Large scale qubits

La partie suivante du workshop de Grenoble était dédiée à la montée en puissance des processeurs quantiques (“Towards Large Scale”).

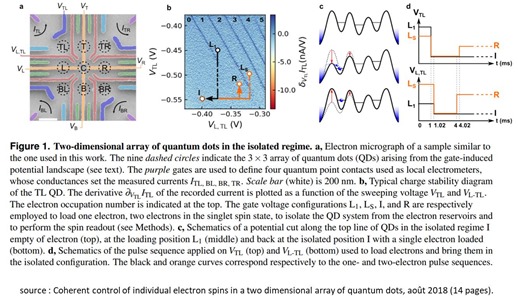

Pierre-André Mortemousque de l’Institut Néel du CNRS à Grenoble présentait des 2D-arrays exploitant du silicium dopé avec des composants III-V (matériaux semi-conducteurs différents du silicium comme le gallium) comme l’AsGa (arséniure de gallium) et de l’AlGaAs (avec en plus de l’aluminium). Ils sont arrangés dans des boites de 9 quantum dots. C’est une base de départ importante pour créer une architecture scalable sur laquelle ensuite mettre en place des codes de correction d’erreurs. Voir Coherent control of individual electron spins in a two dimensional array of quantum dots, août 2018 (14 pages).

Tristan Meunier, également de l’Institut Néel, présentait l’architecture 2D à plusieurs couches intégrant les qubits en silicium avec l’électronique intégrée de contrôle et de mesure d’état. Les qubits sont répartis en 2D, mais l’intégration des composants est également verticale dans les composants (illustration déjà vue plus haut sur QuCube). La couche de mesure est située en-dessous des qubits tandis que la couche permettant d’activer les qubits avec des portes quantiques est au-dessus. Pour N2 qubits, il leur faut 2N lignes de contrôle (horizontale, verticale). Le grand défi de ces architectures est leur variabilité, à savoir les différences de comportement d’un qubit à l’autre et d’un circuit à l’autre. A noter qu’ils utilisent des matériaux supraconducteurs pour la couche métal de ces circuits, à base de nitrate de titane. Cela procure une faible résistance et réduit le bruit de mesure de l’état des qubits. Il y a donc aussi de la supraconductivité des les qubits au silicium !

Suivait Antoine Browyaes, de l’Institut d’Optique et cofondateur de la startup Pasqal (processeur quantique à base d’atomes froids), qui décrivait la manière dont on manipule des atomes de Rydberg pour créer des simulateurs de physiques quantiques aussi appelés ordinateurs quantiques analogiques. Les atomes de Rydgerg sont des atomes placés dans un haut niveau d’excitation et dont les électrons de valence (couche externe de l’atome) sont de nombre quantique supérieur à 1 (atomes à plus d’une couche d’électrons). La durée de vie de l’état de Rydberg est d’environ 100 μs. Le record d’interaction entre de tels atomes est de 50 atomes.

Mathias Urdanpilleta, un collègue de Tristan Meunier et Antoine Browyaes de l’Institut Néel évoquait la manière de déplacer à longue distance des spins d’électrons (“Long distance coherent spin shuttling”). Ici, une longue distance signifie 5 μm ! Mais cela fait de quoi relier des qubits entre eux, donc cela vaut le coup. Voir à ce sujet Coherent long-distance displacement of individual electron spins, 2017 (27 pages).

Thibault Jacqmin du laboratoire Kastler Brossel (LKB) de l’ENS Paris présentait des travaux sur la génération de photons micro-ondes par des NEMS. Traduction : NEMS = MEMS mais au lieu de l’échelle micro, c’est de l’échelle nanoscopique. Ce sont des dispositifs nano-mécaniques tels que ceux que l’on trouve dans les nombreux capteurs qui équipent nos smartphones. Pourquoi générer des micro-ondes de cette manière ? C’est probablement pour permettre le contrôle de qubits de types divers, notamment supraconducteurs, avec des dispositifs miniaturisés.

Romain Maurand est un post-doc du laboratoire IRIG du CEA de Grenoble décrivait des circuits de couplage entre spin d’électrons et photons (“Spin-Photon Coupling”). Cela doit servir à créer des systèmes de couplages entre qubits distants. Les photons micro-ondes utilisent des bandes de fréquence comprises entre 5 et 10 GHz (cela recouvre des fréquences de la 5G entre 5 et 6 GHz, mais qui sont utilisées via des ondes hertziennes, ici, on passe par des matériaux conducteurs). Ces micro-ondes peuvent servir à concevoir des bus quantiques de données entre processeurs quantiques. Ils exploitent des résonateurs micro-ondes supraconducteurs. A ce stade, ils ont pu relier des matrices de 4×4 qubits avec ce genre de technologie.

Cryogénie

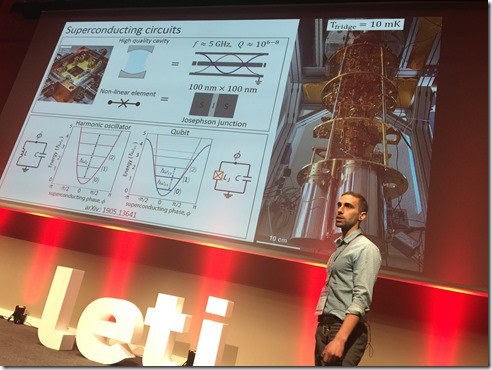

La partie suivante du workshop portait sur le fascinant domaine de la cryogénie et de la cryoélectronique, des disciplines qu’il faut absolument maîtriser pour pouvoir créer un ordinateur quantique dans de nombreux cas (supraconducteurs, semiconducteurs). La discipline comprend la cryogénie proprement dite, qui consiste à refroidir les circuits quantiques à une très basse température mais aussi la création de composants fonctionnant bien à cette température.

Ce refroidissement utilise des systèmes de réfrigération à base d’hélium 3 et 4 (isotopes différents) et d’azote (pour le filtrage). Sur place à Grenoble, j’ai pu découvrir des systèmes de cryogénie maison créés par le CNRS à l’Institut Néel, capables de descendre à moins de 20 mK. Le CEA-IRIG est de son côté en train de déployer deux systèmes commerciaux du leader mondial du secteur, Bluefors (Finlande). Ce dernier système contient le système de réfrigération au-dessus de la colonne blanche (ci-dessous). Il est couplé à des réservoirs et outils techniques dans une salle adjacente (ci-dessous, l’équipement lié à deux systèmes de cryogénie). Ce sont des systèmes à environ 1M€ la pièce. Ils refroidissent l’installation par étages en partant du haut dans l’installation ouverte que l’on appelle parfois le chandelier quantique. On démarre en haut à 4K, puis descend à 1K et enfin, on se retrouve à moins de 20 mK.

La thermalisation, ou la baisse de température à moins de 20 mK dure au minimum 24 heures pour une installation à température ambiante. Mais les équipes du CEA ont installé un dispositif qui permet de changer l’échantillon testé en seulement 7 heures. La thermalisation peut ainsi être déclenchée pendant la nuit et au petit matin, les expériences peuvent reprendre.

Gaël Pillonnet du CEA-Leti décrivait dans le workshop la manière de concevoir et répartir des circuits électroniques cryogéniques (“CryoCMOS Circuits”). Il montrait notamment comment on rapprochait progressivement les circuits de contrôle des qubits dans l’enceinte thermalisée. Il faut en effet répartir des générateurs de courant continu et des démodulateurs (à température ambiante), des amplificateurs et mélangeurs (à 4K), des résonateurs utilisant une technologie Cryo CMOS (fonctionnant à 1K) et des composants électroniques devant tourner à moins de 1K.

Denis Basko du CNRS décrivait l’attirail de génération de micro-ondes dans la bande des 5-10GHz, plutôt dédié aux ordinateurs à qubits supraconducteurs. Et notamment des amplificateurs paramétriques utilisant l’effet Josephson. L’effet Josephson est utilisé dans les qubits supraconducteurs mais a d’autres usages comme celui-ci.

Architecture et systèmes

Alexia Auffeves de l’Institut Néel du CNRS de Grenoble évoquait les questions de consommation d’énergie des processeurs quantiques en rappelant qu’en théorie les portes quantiques étaient réversibles et que cela procurait un avantage énergétique certain par rapport aux ordinateurs traditionnels qui utilisent des portes logiques non réversibles. La réversibilité permet de consommer beaucoup moins d’énergie. Les arbitrages sont complexes à réaliser : la correction d’erreurs génère de l’entropie car on fait un reset des registres quantiques à chaque correction d’erreur et cela consomme de l’énergie. La consommation d’énergie des portes quantiques actuelles est de l’ordre de 10-17 Joule. La limite basse théorique régie par la fameuse loi de Landauer est de l’ordre de 10-21 Joule. Autre contrainte thermique à prendre en compte : le “budget” de chaleur qui peut être généré par les circuits quantiques et ce qui les accompagne. A 50 mK, il n’est que de 1 milliwatt. Il monte lorsque l’on atteint 1K. On peut alors dépenser environ 100 milliwatt. Or un transistor classique consomme 10 microwatts et il est actif environ 1% du temps. Ce qui donne un budget d’environ 106 transistors. Voilà une autre limite en nombre de qubits… !

Je tire de mes discussions avec Alexia la confirmation d’un point clé : même sans avantage quantique (calcul plus rapide sur ordinateur quantique que sur supercalculateur), avec juste une “égalité quantique”, à savoir la capacité à traiter certains calculs uniquement réalisables sur les plus grands supercalculateurs, les ordinateurs quantiques pourront procurer un avantage énergétique. En effet, un calculateur quantique consomme environ 15 KW, dont 14KW uniquement pour la réfrigération.

Les plus grands supercalculateurs du monde consomment plusieurs MW (mégawatts), dont deux ordres de grandeur de plus que les ordinateurs quantiques. Et ils prennent bien plus de place. L’IBM Summit consomme ainsi 13 MW pour une puissance crête de 200 petaflops et dont 3,9 MW pour le refroidissement (source). Ces MW consommés nécessitent un complexe système de refroidissement par eau qui pompe deux tonnes d’eau par minute. Le Summit occupe 500 m2 et pèse 349 tonnes. A comparer à environ 2 tonnes pour un ordinateur quantique qui tient dans une pièce à température ambiante faisant à peu près 25 m2, ce qui donne aussi un “avantage masse” et un “avantage surface”.

Yvain Thonnart du CEA-Leti traitait des architectures d’ordinateurs quantiques au niveau du packaging des composants. J’attends d’obtenir les illustrations pour commenter cela.

Philippe Duluc d’Atos évoquait enfin les plans de sa société pour créer des ordinateurs quantiques. Leur offre actuelle est un émulateur d’ordinateur quantique à base de processeurs Intel qui peut monter jusqu’à 41 qubits et coute environ un demi-million d’Euros. Cet émulateur a été commercialisé auprès de plusieurs entreprises privées comme Total en France et auprès de laboratoires de recherche comme celui d’Oak Ridge aux USA (géré par Batelle pour le Département de l’Energie). A terme, Atos fabriquera probablement des ordinateurs quantiques utilisables comme coprocesseurs de leurs supercalculateurs. Ils n’ont pas encore choisi la piste technologique à adopter. Et pour cause, puisqu’il faut encore attendre un peu avant de se fixer.

Algorithmes et logiciels

Cette partie était traitée plus rapidement dans ce workshop et mériterait certainement un workshop dédié d’une journée. Le sujet avait été abordé sous l’angle des applications d’entreprises dans la conférence Quantum Computing Business organisée le 20 juin 2019 à Paris, avec les témoignages d’Airbus, Total et EDF.

Dominic Horsman de l’Université Grenoble Alpes traitait des compilateurs et des systèmes de correction d’erreur, indiquant comment ils permettaient de simplifier l’exécution d’algorithmes quantiques. Il traitait des “ZX quantum compiler”, un sujet qu’il me reste à creuser !

Christian Gamrat du CEA List à Palaiseau mettait en avant le besoin d’obtenir des langages et compilateurs de haut niveau, qui n’existent pas encore. Il existe aujourd’hui 137 émulateurs logiciels de calcul quantique, une soixantaine de classes d’algorithmes quantiques. Christian rappelait que l’avantage quantique avait un horizon variable lié à l’augmentation de la puissance des supercalculateurs et à celle d’algorithmes classiques qui évoluent aussi. Au point que l’horizon de l’avantage quantique pourrait se déplacer de 50 à 100 qubits.

La jeune américaine Ewin Tang de 18 ans (ci-dessus) avait ainsi publié en juillet 2018 un papier démontrant un algorithme de recommandation classique aussi performant qu’un algorithme conçu pour les ordinateurs quantiques de D-Wave et conçu notamment par Iordanis Kerenidis en France. Voir A quantum-inspired classical algorithm for recommendation systems, Ewin Tang, juillet 2018 (32 pages).

Christian évoquait aussi le domaine en devenir du calcul hybride et réparti s’appuyant sur des calculateurs quantiques.

Ecosystème

Le workshop se terminait par une discussion sur la construction de l’écosystème français du quantique avec Christophe Jurczak de Quantonation et moi-même.

Nous mettions en avant le fait que la France avait une place à prendre et que les dés n’étaient pas joués comme dans l’IA. Le travail collaboratif des chercheurs illustré dans ce workshop en était une excellente démonstration. Le tout adossé à la capacité industrielle du CEA-Leti et celle de ST-Microelectronics qui n’a qu’un équivalent en Europe, l’IMEC en Belgique qui est un peu l’équivalent du Leti.

Christophe a insisté sur la création de startups et les méthodes associées. J’ai rappelé aux physiciens qui constituaient une bonne part de l’audience que nous allions aussi devoir construire un écosystème de compétences en développement de logiciels quantiques. Nous avons aussi insisté sur le besoin d’éduquer le marché, les élites et les jeunes aux enjeux de ce secteur nouveau. En soulignant le fait qu’il devrait théoriquement générer moins d’inquiétude que l’intelligence artificielle et la robotique. En effet, le calcul quantique permettra de résoudre des problèmes “positifs” comme autour de la santé et du réchauffement climatique.

L’autre point clé est de bien appréhender le séquencement des étapes pour créer des ordinateurs quantiques. Le workshop rappelait que ce n’était pas une science magique ni un travail de laboratoire isolé, mais plutôt le rassemblement de talents très divers apprenant à travailler ensemble autour d’un même but. A la fin néanmoins, il faudra transformer tout cela en entreprises et en business, un changement culturel important.

Et je n’ai pas terminé de vous en parler !

_______________________________

PS : dans cette semaine bien chargée, j’ai aussi assisté à la très belle conférence USI organisée par Octo Technology au Carrousel du Louvre. Au menu, de belles intervention et par rapport au sujet de cet article, il y avait surtout celle de Julien Bobroff, un scientifique qui s’est lancé dans la vulgarisation de la physique quantique avec une pédagogie extrêmement efficace. Voir la version longue de cette intervention donnée à la Cité des Sciences (vidéo, 1h53).

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Le chantier du #quantique est immense. Il est pour l’instant à la croisée des chemins de la #science et de l’… https://t.co/8yoOT2COR6

Les points de vue et situation #QuantumComputing d’une conf. fin juin https://t.co/lzVxZtcQsh #quantique

Le calcul quantique est l’utilisation de phénomènes de mécanique quantique tels que la superposition et l’intrication pour effectuer le calcul. Un ordinateur quantique est utilisé pour effectuer un tel calcul, qui peut être implémenté théoriquement ou physiquement.

tank trouble

Arrêtez ce non-sens s’il vous plaît, mon rouleau d’objets était plus élevé que le vôtre, cet arc m’appartient!

Basketball all stars game, Alchemy game free