Dans cette troisième et dernière partie de mon voyage dans le très haut-débit chez Alcatel-Lucent, nous allons faire un petit tour aux Bell Labs de Villarceaux où j’y ai vu différentes équipes de recherche planchant aussi bien sur la fibre optique que sur les applications du très haut-débit.

Cet article fait suite à un premier qui couvrait le dimensionnement et les enjeux du très haut débit côté opérateurs et un second sur les technologies de fabrication des composants de l’optronique qui sont critiques pour les réseaux backbone de fibre optique pour les opérateurs télécom.

Mes photos de cette visite de Villarceaux sont ici.

Les Bell Labs

L’historique des Bell Labs remonte à l’époque d’AT&T d’avant le démantèlement de 1982. Il s’agissait du plus important laboratoire de recherche de télécoms au monde, créé en 1925 dans le New Jersey aux USA. De nombreux chercheurs de renom y sont passés tels que Alan Turing, Claude Shannon, Dennis Richie et Brian Kernighan, les créateurs du langage C et aussi Bjarne Stroustrup, celui du langage C++. Et en tout sept prix Nobel et des dizaines de milliers de brevets déposés. Ce sont un peu les analogues américains du CNET de France Télécom (intégré dans FT R&D). L’histoire du démantèlement d’AT&T a fait que ces laboratoires se sont retrouvés chez l’équipementier Lucent, puis dans Alcatel-Lucent depuis 1998.

Les Bell Labs était historiquement situés très en amont de la recherche. Chez Alcatel-Lucent, ces laboratoires gèrent maintenant l’ensemble des cycles de la recherche : de la recherche fondamentale aux cycles très longs à de la recherche appliquée, aux cycles plus courts.

Du côté français, les Bell Labs intègrent l’historique de la Compagnie Générale d’Electricité puis d’Alcatel (à Villarceaux et Marcoussis). Mais maitrise de l’anglais aidant, les américains ont petit à petit pris le pouvoir dans le groupe. En plus des USA et de la France, les Bell Labs sont répartis dans plusieurs pays tels que la Chine, l’Inde (à Bengalore), l’Irlande, l’Allemagne, la Belgique et la Corée du Sud. Les Bell Labs ont adopté une logique de recherche plus distribuée dans ces différents pays et aussi, les nouveaux canons de l’open innovation et la recherche partenariale, comme nous l’avons vu à Marcoussis dans l’épisode précédent.

Les Bell Labs en France comprennent environ 250 personnes. Ils sont relativement préservés des plans de restructuration grâce au Crédit Impôt Recherche qui en réduit le coût apparent. Les équipes des bell Labs sont concentrées dans un bâtiment du site de Villarceaux qui comprend plus de 2000 personnes et où seront visiblement regroupées les équipes qui sont actuellement sur le site de Vélizy. Une cinquantaine de personnes sont sinon situées sur le site de Marcoussis, qui est commun avec Thalès et le CEA.

Les domaines couverts par les Bell Labs sont assez larges et couvrent aussi bien les technologies d’accès réseaux et opérateurs que les thèmes et technologies liés aux usages des liaisons télécom : les mathématiques, la sécurité, le big data, le multimédia ou encore les objets connectés.

Dans les télécoms, ils planchent comme nous l’avions vu avant sur la fibre optique à très haut débit mais aussi sur les améliorations de la boucle locale en ADSL avec le développement du la “Vectorisation VDSL2” qui permet d’atteindre des débits de 100 Mbits/s sur paire de cuivre. Cette technique repose sur l’envoi d’un signal dans une paire de cuivre dédiée de l’abonné en plus de la principale et qui annule le bruit provenant des autres paires aboutissant à un DSLAM. La technologie qui est à l’état de test chez quelques opérateurs dans le monde permet en pratique d’à peu près doubler le débit de liaisons ADSL. Les Bell Labs travaillent aussi sur le “roaming du futur” qui permettra de passer du fixe au mobile et réciproquement sans que l’utilisateur s’en rende compte. En France, ce sont des dizaines de projets de recherche qui sont menés dans tout un tas de domaines dont voici un aperçu.

Le 400 GBits/s sur une longueur d’onde

Nous avons vu que pour générer des transmissions ultra haut débit sur des fibres optiques, on pouvait associer deux principales techniques : la combinaison phase/polarisation/amplitude pour multiplexer plusieurs flux binaires et ensuite le multiplexage de longueurs d’ondes (WDM : Wavelength Division Multiplexing).

J’ai visité le laboratoire de Sébastien Bigo (ci-dessous) de Villarceaux qui planche sur le “High Capacity WDM Transmission” et plus précisément sur le transfert de 400 GBits/s par longueur d’onde. Ce 400 Gbits/s est à comparer aux actuels 10 à 100 Gbits/s qui sont en production dans les infrastructures des opérateurs télécoms.

Sébastien Bigo planche depuis plus de 15 ans sur ce sujet. Il a reçu en 2008 le prix Léon-Nicolas Brillouin décerné l’IEEE et la SEE pour ses travaux concernant les effets de propagation dans les fibres optiques qui ont permis d’augmenter les limites des débits des fibres optiques. Il est à l’origine des premières fibres capables de gérer plus de 1 Tera-bits/s, les Teralight utilisant jusqu’à 160 longueurs d’onde (en 1999). Il est à l’origine de plus d’une vingtaine de records de transmission par fibre optique : la première transmission à 10 Terabit/s en 2001.

Depuis quelques temps, il planche sur le transfert d’un nouveau record : le transfert de 400 Gbits/s sur une seule longueur d’onde. Technologiquement, ce débit s’appuie sur la modulation de phase, de polarisation et d’amplitude (à quatre niveaux). Cela donne une capacité à multiplexer 64 flux binaires sur une seule longueur d’onde (c’est le 64QAM). Mais le signal optique s’atténue avec la distance. L’objectif du laboratoire était d’arriver à transférer ces 400 GBits/s sur une distance de plusieurs centaines de kilomètres avec une qualité de service acceptable pour de la mise en production.

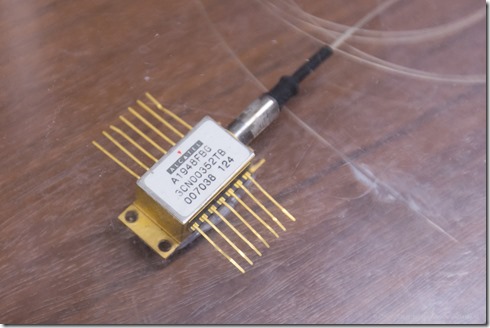

A la base de ces transmissions se situent des convertisseurs DAC et ADC (digital to analog et analog to digital) qui transforment des flux binaire électroniques de 50 GHz en lumière avec lasers et capteurs, et réciproquement. Tout ceci est réalisé avec des composants d’optronique spécifiques produits à Marcoussis avec les techniques III-V vues dans l’article précédent.

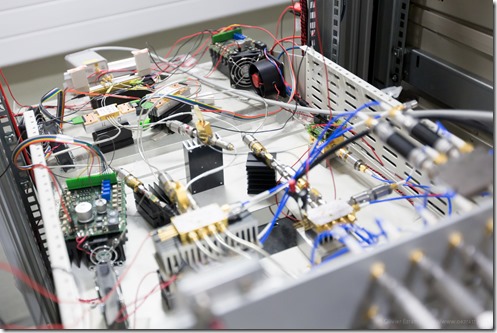

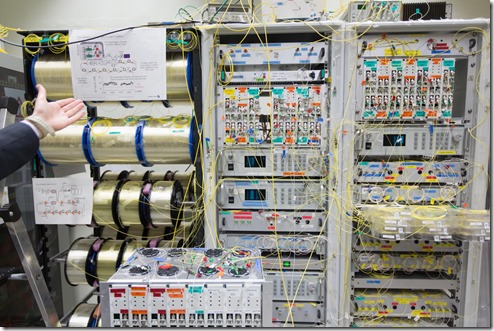

Le laboratoire de test du 400 GBits/s par longueur d’onde est assez particulier avec un mélange d’électronique et d’optronique assez vertigineux. C’est bourré de systèmes de modulation et de multiplexage de signaux binaires aléatoires (pour les tests).

La liaison optique utilisée pour les tests fait plus de 600 Km. Elle est incarnée par les bobines de fibres optiques que l’on voit à gauche de la photo. Chaque bobine représente donc environ 100 km de fibre.

Le laboratoire réalise des tests de transfert à 400 GBits/s de flux binaires multiplexés. Cela combine évidemment une approche scientifique mais aussi une approche expérimentale faite de tâtonnements. De nombreux paramètres sont “tunés” pour obtenir le meilleur résultat, à savoir, de récupérer un signal d’aussi bonne qualité que possible à l’autre bout de la fibre optique.

Mais les tests sont déjà réalisés sur le terrain puisque Alcatel-Lucent et Orange ont déjà mis en place une liaison expérimentale basée sur cette technologie entre Paris et Lyon début 2013. Ce déploiement accompagne celui du FTTH dans les foyers ainsi que celui de la 4G, tous deux très consommateurs de bande passante. Il a été réalisé avec des puces optroniques “400G Photonic Service Engine” issues visiblement de Marcoussis. Compte-tenu des 44 longueurs d’ondes utilisées, le débit de la liaison Paris-Lyon peut aller jusqu’à 17,6 Tbits/s.

Open Innovation et Design Lab

Nous poursuivons la visite avec de l’Acceleration Platform, le laboratoire dirigé par Bruno Aidan, en compagnie de Fabrice Poussière et Vincent Hiribarren. Ce laboratoire rappelle un peu le “D Lab” que j’avais pu visiter à l’université de Stanford en avril 2011. Il a pour but d’imaginer des usages innovants qui vont faire appel aux technologies de télécommunications. Ce sont autrement dit des “use case”.

Le processus du laboratoire part de “l’ideation”, la conception d’une idée à partir d’un ou de plusieurs besoins. Cela mène à des prototypes, parfois en carton. Puis à de l’expérimentation avec des technologies matérielles et logicielles.

Cela commençait avec deux projets de visioconférence : l’un avec un robot de visioconférence, un grand classique (ci-dessous). Ce robot suit la personne avec qui la personne qui est dedans discute. Il se déplace sur une base motorisée à trois roues.

Et l’autre, avec le projet “Event More” d’Olivier Martinot, un outil de visioconférence utilisant un capteur de Kinect. Celui-ci détecte le mouvement du présentateur ou d’intervenants à distance et incruste automatiquement leur image sur les slides. Cela apporte une plus grande interactivité entre les slides et les intervenants. L’ensemble est associé à des outils d’intervention plus classique par chat qui permettent d’interagir de manière plus classique avec son audience. Le projet a été mené en partenariat avec Ubimedia et Télécom SudParis.

Bruno Aida m’a sinon présenté cette expérimentation d’une LTEBox avec un ARDrone annoncée en octobre 2012. Il s’agissait de démontrer d’une part l’intérêt d’utiliser le LTE en lieu et place du WiFi pour piloter un AR-Drone qui pouvait ainsi voler à plus d’un kilomètre de son point de départ, et aussi, de démontrer ce LTEBox, un cube d’environ 50 cm de côté jouant le rôle d’un émetteur LTE. Le LTE apporte plein d’avantages à la liaison avec l’AR-Drone : à la fois un débit plus grand permettant d’avoir des images vidéo de meilleure qualité, et aussi, une latence plus faible de la communication, améliorant la réactivité du pilotage. L’expérience visait aussi à démontrer l’intérêt du LTE pour la fourniture de haut débit aux zones blanches, là où l’installation d’infrastructures terrestres (FTTH, ADSL) est difficile. L’annonce et la vidéo associée sont ici. Voir aussi cet article d’Engadget sur le sujet.

Une grande partie des travaux de l’Acceleration Platform concernent les objets connectés. Citons comme exemple ceux de Pierrick Thebault qui est en train de terminer une thèse sur le sujet après avoir travaillé dans cette plateforme. Il se trouve qu’avec Fabrice Poussière des Bell Labs, j’ai eu le plaisir de les avoir comme intervenants dans la table ronde que j’animais vendredi 17 mai à Nantes dans le cadre de la conférence Web2day. Cette table ronde comprenait également Emmanuelle Roux, la dynamique créatrice de plusieurs fablabs, à la Roche sur Yon et à Gennevilliers.

Pierrick Thebault a défini une bonne classification des objets connectés, de leur forme (augmentation numérique d’objets, augmentation physique d’objets, création de surfaces et création de produits) et de leur fonction (représenter les ressources, augmenter les fonctions ou orchestrer les ressources). Exemple pratique : ce travail de réflexion sur un radioréveil connecté. Il illustre deux visions différentes des objets connectés : une première qui consiste à mettre des capteurs et autres dispositifs et à les piloter intégralement avec la télécommande universelle qu’est devenue le smartphone ou bien avec son acolyte la tablette. Et une autre approche, ici, qui consiste à créer des objets “ad-hoc” pour remplir un ensemble de fonctions données. Le radioréveil comprendrait des boutons intégrant des écrans qui seraient configurables en fonction des besoins des utilisateurs. Cela en ferait une plateforme versatile et extensible. C’est un peu dans la lignée du Nest, ce thermostat très ergonomique créé par un ancien d’Apple, mais surtout piloté via le cloud par ses mobiles.

On est évidemment très en amont dans le cycle de l’innovation : au stade de la réflexion et de l’idée. Pour qu’un tel radioréveil arrive sur votre table de chevet, il faudrait qu’un entrepreneur passe par là !

Big data et réseaux sociaux

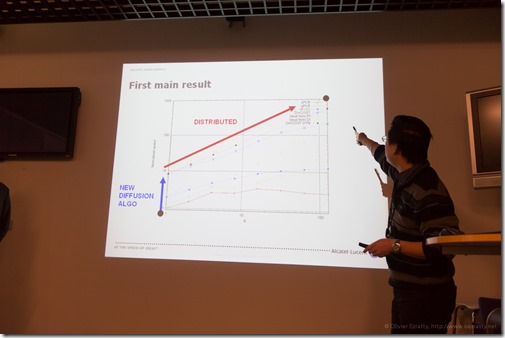

Plusieurs projets de recherche sont menés aux Bell Labs dans ce domaine. Dans l’un d’eux, Dohy Hong (ci-dessous) et Gérard Burnside utilise la théorie des graphes et une matrice de transition de Markov pour améliorer le classement de contenus, notamment issus de Twitter. Il exploite des arbres de suffixes et les citations dans les tweets qui permettent ensuite de classifier automatiquement les tweets par catégorie et en levant les ambigüités de termes pouvant avoir plusieurs significations. Ce projet est complété par celui de Philippe Jacquet, Dimitri Milioris et Bela Berde “Automated Text Analysis” mené avec Télécom Paristech et Télécom SudParis (ex INT Evry). Il sert à quantifier la distance sémantique entre tweets et fonctionne dans plusieurs langues.

Avec l’avantage d’être un algorithme linéaire qui supporte bien la charge avec le volume de tweets à analyser. Il faut dire qu’il faut faire face à une marée de 100 Go de tweets à la seconde ! Ce genre de chose peut améliorer l’efficacité de ce que l’on appelle le “collaborative filtering” pour faire de la recommandation. Par contre, pas évident de voir le lien avec le business d’équipementier d’Alcatel-Lucent.

C’est bien là le problème de ce genre de société : comment passer de la recherche aux produits et le faire en choisissant les bons marchés et la bonne approche business.

Je ne vais pas (trop) commenter ici les difficultés d’Alcatel-Lucent face notamment à la concurrence du chinois Huawei. Comme d’autres sociétés européennes telles que Nokia ou Ericsson, elle va de plans de restructuration en plans de restructuration notamment en Europe où les marchés sont atones. C’est surtout le cas en France où la concurrence de Free dans le mobile a amené les opérateurs à rogner sur les coûts et les investissements.

La fusion entre Alcatel et Lucent a démarré en 2006. On sait qu’elle fut chaotique sous la double houlette de Serge Tchuruk et Patricia Russo. A l’époque, les effectifs consolidés étaient de plus de 80000 personnes. Ils ont finalement plutôt bien résisté, atterrissant à 72344 fin 2012. Le groupe avait annoncé un plan de 12000 licenciements en 2007. Il semble donc que ces plans soient mise en œuvre partiellement ou que des embauches aient ensuite lieu dans les régions où le business se porte bien.

Alcatel-Lucent dispose de bons ingénieurs et de laboratoires de recherche à la pointe et d’une présence mondiale. Ceux-ci sont d’ailleurs plutôt épargnés par ces plans de restructuration à répétition car ce sont les équipes ventes et marketing qui trinquent en général. Son marketing b-to-b a l’air convenable. Alcatel-Lucent est aussi plutôt bien positionné dans les marchés du LTE et des infrastructures en fibre optique des opérateurs. Et la société est toujours dans le tiercé des grands équipementiers télécoms de ce bas monde.

Alors, qu’est-ce qui cloche ? L’absence dans les marchés grand public qui sont encore en croissance ?

Alcatel y était historiquement présent avec ses mobiles. Ce business a été cédé au chinois TCL qui exploite la marque Alcatel One Touch. Ce même TCL qui exploite la marque Thomson depuis que ce dernier, devenu Technicolor, s’est aussi désengagé des marchés grand public ! Il semble que l’industrie high-tech européenne dans son ensemble ait perdu le fil des marchés grand public. Le dernier en date est Nokia et il est bien mal en point, ayant complètement raté la vague des smartphones. Le pari Windows Phone est loin de porter ses fruits pour l’instant, faute d’un bon time-to-market pour ce dernier. L’Europe va aussi mal car elle ne sait pas assez concevoir de produits à forte valeur ajoutée pour les marchés de volume ! C’est un savoir-faire qu’il faut réapprendre !

Il y a d’ailleurs bien peu d’industriels dans le monde capables d’être performants dans les marchés professionnels et grand public. Les exceptions sont rares comme Samsung qui est à la fois présent dans les composants et les produits grand public et se porte plutôt bien. Les grands japonais comme Sony sont également sur les marchés grand public et professionnels. Mais de moins en moins dans les composants et ils sont presque tous en difficulté. Pas forcément du fait de ce double positionnement d’ailleurs ni seulement à cause du cours du Yen. Dans le logiciel, Microsoft est aussi à cheval sur les deux marchés, mais il est à la peine dans le grand public. Apple est focalisé sur le grand public même si les Macintosh sont utilisés par des professionnels (et plutôt des petites structures comme dans les métiers de la création ou dans l’éducation). IBM est dans l’entreprise après s’être désengagé du grand public (revente des PC à Lenovo et des imprimantes à Lexmark). Même Intel qui est à cheval sur les deux marchés est en difficultés car ses processeurs ne sont pas bien diffusés dans les nouveaux marchés grand public que sont les mobiles et TV connectées.

La bataille actuelle se résume à deux mots : grand public et plateformes. Le marché est maintenant gouverné par ceux qui maitrisent les secondes. Il est dominé par Apple, Google, Amazon et dans une certaine mesure Facebook (qui est encore petit face aux trois autres). Toutes les startups aspirent à ce genre de succès mais il y a peu d’élus et c’est encore plus difficile pour les sociétés industrielles du 20ième siècle de s’adapter à cette nouvelle donne.

Sans plateforme, les autres sociétés produisent des commodités qui sont exposées à une concurrence impitoyable et à une guerre des prix sans relâche, surtout en période de crise économique. Maitriser des technologies de pointe et faire des produits ne suffit plus. Il faut créer des plateformes extensibles à partir d’un bon produit pour s’implanter durablement dans le numérique et dans des marchés de volume avec de fortes économies d’échelle. Les industriels sont condamnés à se réinventer et ce n’est pas facile !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

il parait que les bonnes entreprises innovantes sont toujours sur le fil rouge.

La beauté de la technologie : ma photo préférée de l’épisode 3 d’O. Ezratty

http://t.co/PU4U3ATbY3 http://t.co/ON93hc0b4Q

au sujet du record du drone:

“démontrer d’une part l’intérêt d’utiliser le LTE en lieu et place du WiFi pour piloter un AR-Drone ”

Une telle “démonstration” mériterait un oscar aux vidéogags: plus de 10 personnes, 4 voitures et 1/4 m3 de LTE sans compter l’antenne, pour établir qu’un émetteur”LTE” de plusieurs Watt est, en distance de portée, supérieur aux 0,1 watt maxi imposé par la norme ISO 8802.11b/Wifi… Chapeau aux Bells Labs de Villarceaux, il fallait l’oser….

Pour reprendre et répondre à l’argumentaire Application “pompier” du V.P. marketing d’Alcatel Lucent encore faut-il qu’en rase campagne l’incendie veuille bien démarrer à moins d’1 km de la station de base LTE….

10 contre 1, bien vu. Zont pas peur chez BLV