Quand on pense startups du numérique, on associe souvent la notion aux TPE du secteur de l’Internet ou de la mobilité. Mais le champ du numériques va bien au-delà. D’autres pans du numérique donnent lieu à la création de sociétés très innovantes dans leur domaines. Il y a les logiciels d’entreprise, les outils de développement, les applications verticales (santé, éducation, industries, etc). Et puis celui des métiers de l’image qui m’intéresse tout particulièrement. Nous allons ici regarder ce qu’il en est du côté du cinéma numérique.

La France est le pays du Minitel, de l’IPTV mais aussi de Georges Méliès et des Frères Lumière, et avec un peu plus d’antériorité ! Le cinéma français se manifeste non seulement pas ses films mais aussi par sa technologie. Nous avions déjà eu l’occasion d’évoquer le cas de l’amélioration du son au cinéma comme celui des acteurs du secteur de la télévision à l’occasion du dernier IBC d’Amsterdam. Ici, nous allons traiter de l’image et du cinéma au travers d’un petit échantillon de startups rencontrées chez Scientipôle Initiative où je joue plusieurs rôles dont celui d’expert pour le comité d’agrément du label et des prêts d’honneurs de cette association.

Caractéristiques de ces startups

J’ai pu identifier quelques points communs aux startups de ce secteur :

- Elles sont très souvent positionnées sur des marchés de niche avec une forte composante technologique et plutôt dans l’immatériel. Pas mal de ces startups sont issues de projets de recherche appliquée dans le domaine du traitement de l’image. Ce sont parfois des solutions qui ont mis du temps à trouver leur problème !

- Même si la création cinématographique s’y porte assez bien, le marché français est trop petit. D’où l’impératif de l’international pour se développer. C’est la condition indispensable pour dépasser le cap fatidique du million d’Euros de chiffre d’affaire. Avec un succès à l’international, ces entreprises pourraient atteindre 5m€ à 10m€. Ce n’est pas énorme et fait d’elles des cibles d’acquisition technologiques pour de plus grandes entreprises du secteur comme Sony ou le français Technicolor.

- Le modèle de ces sociétés penche souvent vers le “service outillé” destiné à la production, avec des prestations de service qui complètent le produit développé, voire même une activité produit marginale par rapport à l’activité de service. On est dans le “business to business” ou au mieux face à des technologies qui pourraient avoir des débouchés grand public, mais en marque blanche et/ou en OEM.

- Les créateurs de ces startups sont généralement des “hommes de l’art” passionnés et passionnants qui connaissent sur le bout des doigts leur métier et disposent d’un excellent réseau relationnel leur permettant de trouver leurs premiers clients. Et dans pas mal de cas, leur carnet d”adresses est déjà international tellement leur milieu est spécialisé.

- Les créateurs sont toujours en équipe, au minimum en binôme avec l’un des deux ayant une affinité business plus forte.

Les sociétés que je vais décrire ici couvrent des domaines assez différents de la chaine de production cinématographique et/ou télévisuelle : la production d’images en 3D stéréoscopique de synthèse (Supamonks) ou réelles (Stéréolabs), la prise de vue aérienne (XD Motion), le motion capture sans marqueurs (Ayotle), et l’étalonnage de couleurs collaboratif (Firefly Cinema). Que ceux que j’oublie me pardonnent d’emblée ! Je ne vise aucunement l’exhaustivité. Il s’agit surtout de montrer que ce petit secteur bouillonne aussi d’innovations !

SupaMonks : la génération d’images de synthèse en 3D

Supamonks est une société de production de films de publicité et de séries TV en images de synthèse qui a développé le plug-in 3D-SR1 pour les logiciels de production d’images de synthèse comme Autodesk Maya permettant de calibrer automatiquement la position des caméras virtuelles pour la génération d’images stéréoscopiques. Le plug-in a été développé avec Erwan Davigano, stéréographe et initiateur du projet.

Pour créer de telles images stéréoscopiques, il faut créer deux caméras virtuelles et définir le plan de zéro parallaxe, qui est en général le plan de l’objet principal filmé dans la scène correspondant aux éléments qui seront dans le plan de l’écran en projection stéréoscopique. L’animateur définit ensuite la profondeur de champ et les mouvements de caméras. Le plug-in calcule automatiquement et dynamiquement l’écartement des caméras et leur angulation, qui peut varier pendant chaque scène. De plus, il permet de respecter automatiquement trois contraintes de la vision stéréoscopique : éviter les situations de divergence oculaire, d’abuser des effets de jaillissement et les déformations trapézoïdale.

Le développement a été réalisé pour Autodesk Maya, un logiciel couramment employé dans les studios d’animation. Supamonks a commencé la transposition de ce plug-in sur d’autres logiciels de synthèse plus haut de gamme. Chaque logiciel disposant de ses propres interfaces de programmation (APIs) et des structures d’objets 3D différentes, il peut y avoir un travail spécifique significatif pour chaque logiciel. Le plug-in 3D-SR1 est pour l’instant diffusé par un site de vente en ligne spécialisé, PostLogic.

L’équipe s’est aussi lancée dans le développement de SupaManager, un outil permettant de gagner du temps dans la production et pour automatiser les processus de gestion de production. C’est une sorte de d’outil d’asset management qui créé les dossiers pour les effets 3D, les scènes, avec une nomenclature propre à la 3D. Il en existe sur le marché (3D-Clic, Shotgun, ArtForge) mais ils sont assez chers et pas bien adaptés aux petits studios. L’objectif de SupaManager est de faire économiser jusqu’à 20% des couts de production en automatisant les tâches et en évitant des erreurs. Cet outil peut donc être rentabilisé en environ une année d’activité de SupaMonks. Mais SupaManager est pour l’instant destiné à un usage interne. C’est donc destiné à du service (bien) outillé.

Nous avons ici un prestataire de services qui cherche à se crédibiliser en réalisant des outils de production efficaces. Cela améliore sa productivité et cela peut compléter son chiffre d’affaire avec un petit revenu complémentaire.

La société a été créée par cinq associés de 25 à 31 ans, dont quatre viennent de l’école d’animation Méliès. Certains ont aussi une expérience de deux ans chez McGuff, un studio d’animation de synthèse et d’effets spéciaux leader du marché.

Stéréolabs : l’ajustement automatique de la prise de vues 3D réelle

Il s’agit d’une startup créée par quatre anciens élèves de la filière entrepreneur de Sup Otique et en partenariat avec le CEA List et l’INSA de Rouen. L’équipe a développé Intuitiv3D, un logiciel de correction automatique de l’alignement d’images stéréoscopiques. Il corrige les défauts de la prise de vues 3D réalisée avec des caméras 3D qui ne sont pas calibrées mécaniquement avec précision.

En effet, pour être bien réalisée, une prise de vue 3D doit associer un bloc avec deux caméras dont l’orientation converge vers la zone centrale d’un plan de référence. Comme les yeux, les caméras ne sont pas parallèles mais orientées vers ce point avec un angle qui dépend de la distance. Le problème est que ces systèmes mécaniques coutent cher. Et de nombreuses caméras amateur ou semi-professionnelles ne disposent pas de ce mécanisme de convergence mécanique.

Le logiciel de Stéréolabs compense par logiciel ce qui manque côté mécanique dans le dispositif de prise de vues stéréoscopique. Et il présente l’avantage de pouvoir fonctionner en temps réel.

Le marché visé est celui de la TV, qui a besoin de faire sérieusement baisser les couts de production de la 3D, celui de la publicité ainsi que celui du cinéma.

Nous sommes face ici à un projet issu de la recherche et dont le domaine d’application a changé dans le temps. Initialement, le logiciel visait les applications dans la chirurgie !

Agence de Doublure Numérique (ADN) : la mutualisation de la création de doublures numériques d’acteurs

ADN est une agence proposant la création, la gestion et l’exploitation de doublures numériques de personnalités. Elle est focalisée sur le traitement numérique du visage. Elle intègre à la fois une innovation technologique et surtout une innovation de processus et de service pour réduire les couts et améliorer la versatilité des doublures numériques. On peut classer cette société dans les « services outillés innovants » mais avec une spécialité plus grande que Supamonks.

ADN se propose de mutualiser une grande partie du travail de création de la doublure numérique des acteurs et personnalités en amont de la post-production et une fois pour toutes. La post-production utilise la doublure ainsi créée pour l’intégrer dans son film. L’apparence de l’acteur est contrôlée par l’ADN en conformité avec ce que l’acteur ou la personnalité accepte.

Les scénarios d’usage au cinéma sont variés : le besoin de modifier l’apparence de l’acteur, une indisponibilité pour un tournage, l’incapacité voire le décès d’un acteur en cours de tournage (on se rappelle le cas de Heath Ledger dans le dernier Batman ou de Brendon Lee également mort pendant un tournage – bon la mort d’acteurs pendant un tournage n’est pas un business très scalable, on en conviendra…), l’intégration de l’acteur dans une performance sportive ou une cascade, voire musicale (Nathalie Portman dans Black Swan…), les reprises après tournage, les pertes des rushes en analogique comme en numérique (et oui, cela arrive), le voilage de pellicule pour les tournages argentiques qui ont encore cours ou le metteur en scène qui change d’avis en cours de route.

Le processus de création de doublures numériques proposé par ADN est réalisé en trois phases, la société assurant les deux premières :

- La création de la doublure numérique et la création de modèle virtuel. Elle est faite une fois pour toutes pour l’acteur et est ensuite mutualisée entre les productions qui y font appel. Il en résulte un modèle numérique de l’acteur en trois dimensions (et en éléments finis), avec texture de peau photoréaliste. La capture s’effectue avec une prise de photos à 360°. 90 secondes de capture suffisent à échantillonner un visage correctement. Elles enregistrent des « visemes », l’équivalent dans l’expression faciale des « phonemes ». S’ensuivent des prises de vue du visage avec différentes conditions d’éclairage avec une caméra stéréoscopique, puis avec une lumière polarisée. Les textures de peau, des yeux, de la bouche, sont enregistrées dans cette phase. A l’issue de cette phase est créé un modèle numérique du visage dont les différentes facettes sont positionnées par rapport à un visage de référence.

- L’acquisition du jeu de l’acteur pour créer l’animation destinée au film. Notamment, pour l’enregistrement des dialogues. Le son est capté à cette étape, en réel pour l’instant. La flexibilité est grande à ce stade : on peut capter le jeu d’un acteur A et l’appliquer à la doublure numérique d’un acteur B. On peut aussi appliquer un jeu entièrement virtuel à la doublure numérique d’un acteur. La performance est acquise par une technique de « motion capture » avec des points de repérage qui réfléchissent la lumière dans la même direction que sa source. Couplé aux données récupérées lors de l’acquisition, cela aboutit à un double numérique animé du visage prêt à être ensuite intégré dans le film. On est ici dans la partie non mutualisée du processus réalisée par ADN.

- L’intégration de la doublure dans le film : sur un corps, avec d’éventuelles déformations, maquillage numérique ou autre, vieillissement, prise de poids, cicatrices ou blessures, dans le décors réel ou virtuel du film, et avec l’ambiance lumineuse de la scène. Cela se fait en « post-production », c’est-à-dire après le tournage des scènes réelles du film. Cette phase est prise en charge par les studios de post-production. Pour la post-production, le double numérique est ensuite intégré dans la scène (réelle ou de synthèse) et sur son corps (en synthèse ou pas) via le même plug-in Maya. Le tout est généré en haute définition (Full HD pour la TV ou 2K et bientôt 4K pour le cinéma).

L’ADN joue surtout comme son nom l’indique le rôle d’agent pour les personnalités numérisées. Elle garantit ainsi que la personnalité numérisée pourra contrôler l’usage qui est fait de sa doublure numérique, autant dans l’apparence que dans le jeu d’acteur. Elle encadre de plus juridiquement l’exploitation de ces représentations numériques.

Le plug-in Maya est le résultat d’un travail de R&D mené par Cédric Guiard (ci-dessus à droite), cofondateur de l’ADN. Son collègue, Christian Guillon (ci-dessus à gauche), a plusieurs décennies d’expérience au compteur dans les effets spéciaux numériques au cinéma et a été notamment impliqué dans la production du dernier Astérix. Côté volumétrie, l’agence vise la numérisation d’une cinquantaine d’acteurs et personnalités dans les années qui viennent et cible en priorité le marché européen qui dispose de moins de moyens par production que le marché américain qui se soucie moins de mutualisation du processus de capture numérique de ses acteurs.

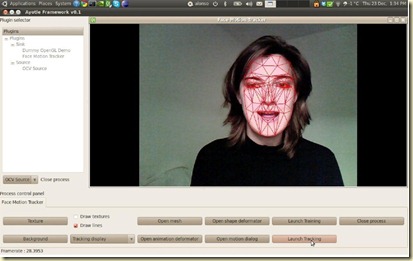

Ayotle : le motion capture 3D simplifié

Dans une activité connexe à celle de l’ADN, Ayotle propose une solution logicielle de « motion capture » des expressions du visage qui s’appuie sur une simple webcam et son flux vidéo. Elle permet de concevoir des animations et notamment des jeux, à faible cout par rapport aux solutions traditionnelles de Mocap.

La startup est issue des projets de recherche de José Alonso Ybanez Zepeda, ingénieur en télécommunication originaire du Mexique qui a fait sa thèse de doctorat à Telecom ParisTech et en collaboration avec l’UTC de Compiègne. Gisèle Belliot y joue le rôle de gérante et de business development. Elle apporte son expérience d’une dizaine d’années comme chargée de production dans l’événementiel.

La solution Face Tracker de Motion Capture (Mocap) d’Ayotle ambitionne de remplacer la motion capture réalisée avec des marqueurs (points noirs ou blancs) sur les visages des acteurs. Cette capture traditionnelle fonctionne avec le visage aussi bien qu’avec le corps. Elle est lourde à mettre en œuvre car elle nécessite un maquillage spécifique et implique généralement plusieurs caméras pour obtenir une vision stéréoscopique. Elle est de plus particulièrement gênante pour les acteurs et leur jeu.

Ce système traditionnel est exploité couramment pour la production de jeux et d’effets spéciaux au cinéma ou à la télévision. Dans la production d’Avatar, James Cameron a amélioré le procédé non pas au niveau de la capture du jeu d’acteurs elle-même, qui reste lourde et à base de marqueurs, mais au niveau de la restitution de l’image des avatars des acteurs qui fonctionne en temps réel pendant le tournage.

Le logiciel FaceTracker d’Ayotle s’exploite avec une simple webcam intégrée dans un laptop ou une webcam externe. Il faut disposer de préférence d’un éclairage correct vers le visage.

Le processus commence avec le calibrage du maillage du visage, un maillage standard du visage étant d’abord appliqué sur le visage de l’acteur. Le maillage du visage est ensuite automatiquement ajusté en fonction du visage de l’acteur, notamment au niveau des yeux et de la bouche. Le système est alors prêt pour réaliser des captures d’expression et de mouvements du visage. Les principales expressions du visage sont bien prises en compte : sourires, parole, mouvements des yeux, des paupières et des sourcils. La tête pour tourner à plus ou moins 30°. Au-delà, la capture du mouvement ne fonctionne plus. On peut vérifier en temps réel à l’écran que la capture fonctionne correctement. Ces captures donnent alors un maillage animé qui peut être injecté dans des logiciels d’animation, aussi bien en post-production qu’en direct, en fonction des capacités de ces derniers. Le maillage est généralement appliqué sur un personnage de fiction différent de celui de l’acteur, notamment dans les jeux vidéo.

La société n’est pas seule sur le secteur mais son procédé semble très efficace et il opère en temps réel. Son marché est assez élastique. Il démarrera avec la production de contenus (jeux, etc) mais pourrait très bien trouver un débouché plus orienté “volume” et en marque blanche dans le domaine des jeux à réalité augmentée ou qui intègrent des avatars de joueurs animés en temps réel à partir de l’expression des visages. J’avais vu cela au CES de Las Vegas dans une démonstration du keynote de Microsoft avec la Kinect. Mais la captation des expressions du visage était assez approximative. Ici, elle est de bien meilleure qualité.

XD Motion : la prise de vues aériennes

XD Motion est un prestataire de prise de vues aériennes pour la télévision, le cinéma et la publicité qui exploite des systèmes de support stabilisés de caméras vidéo et cinéma.

Les prises de vues aériennes réalisées par XD Motion se font avec différents supports : des câbles suspendus, des rails, des voitures, des ballons et des hélicoptères, voire des drones. Les prises de vue peuvent être 2D ou 3D, et aussi panoramiques avec plusieurs caméras montées sur leur support permettant des vues à 180° voire même 360° (avec plusieurs caméras). Les supports de caméras utilisés sont variés et correspondent aux différentes caméras employées dans les productions : des caméras cinéma 35 mm argentiques ou numériques très lourdes à des caméras vidéo plus légères, pour la télévision voire pour la télésurveillance.

La société qui est avant tout un prestataire de services est en train de concevoir avec son partenaire Attitude Technologies un nouveau système de prises de vue aériennes, la tête BlackShark, plus léger (réalisé en fibres de carbone) et moins cher. Elle permettra à la fois d’étendre le marché de la capture aérienne et de capter des parts de marché. Allégée par rapport aux concurrents, cette tête pourra être montée sur des câbles plus longs, jusqu’à 2 km !

La distribution de la Black Shark ? Dans un premier temps en location. Et puis en vente à quelques unités pour les marchés étrangers auprès de prestataires de services qui sont eux-mêmes concurrents de XD Motion.

Le créateur de cette société, Benoit Dentan, est un fondu de la prise de vue aérienne. Il exerce ce métier depuis des décennies, ayant notamment géré la filiale d’ACS en France, un prestataire de ce secteur d’origine anglaise. L’activité de service de XD Motion repose sur des intermittents du spectacle, un modèle assez classique. A ceci près que ceux-là doivent avoir un grand nombre de certifications, notamment lorsqu’ils font de la prise de vue dans des engins aéroportés (hélicos, ballons, drones). C’est dans ce mode de fonctionnement que Benoit Dantan a ainsi participé au tournage de “Mission Impossible 4” et des cascades en haut de la tour Burj Dubaï la plus haute du monde et avec un hélicoptère. Le film sortira en décembre 2011 !

Firefly Cinema : l’étalonnage couleur collaboratif

Dernière société de ce tour d’horizon, Firefly Cinema propose une panoplie de solution logicielle d’étalonnage numérique de la couleur pour le cinéma, qui fonctionne en mode collaboratif avec toutes les parties prenantes de la post-production d’un film. Les premières briques de l’offre sont disponibles et commercialisées.

La société Firefly Cinema a été créée par deux spécialistes de la filière de post-production du cinéma numérique Philippe Reinaudo, ancien Directeur Technique des Laboratoires Eclair et superviseur d’effets spéciaux numériques au Medialab aux USA et puis Luc Guénard, ancien responsable de R&D d’Eclair.

Leur offre s’adresse aux intervenants de la chaine de post-production des films de cinéma ou pour la télévision.

Elle permet :

- De gérer l’étalonnage des prises de vue après le dérushage des tournages et d’exploiter ensuite cet étalonnage dans la génération du film après le passage dans la phase du montage qui exploite des outils tiers type Avid ou FinalCut.

- De gérer ce processus de manière collaborative et à distance, permise par l’augmentation de la puissance des ordinateurs et la bande passante disponible sur Internet. Les images sont downscalées en 1K pour être faciles à transférer aux ordinateurs à distance, ce qui est suffisant pour réaliser de l’étalonnage. Les personnes qui vont travailler ensemble à distance sont les intervenants du tournage (chef opérateur, assistant chef opérateur, directeur de la photo, réalisateur) et de la post-production (étalonneur, assistant, réalisateur, chef opérateur).

- La gestion d’une base de donnée unifiée des rushes et données d’étalonnages, conservées pendant tout le processus de la post-production.

Les fonctions d’étalonnage comprennent ou comprendront :

- La correction pour chaque plan de la lumière, du contraste, de la saturation de couleur et de la balance des blancs, notamment pour corriger les défauts qui subsistent sur la couleur de la peau des acteurs selon les caméras. Comme dans la retouche photo, on peut effectuer une correction sur une teinte en particulier.

- La modification de zones d’image, pour par exemple éclaircir un visage. La fonction intègre la gestion du déplacement de la zone dans le plan avec la saisie de de points de passage.

- L’animation de tous ces paramètres dans le temps.

- La gestion d’une table de colorimétrie (LUT) par caméra de prise de vue (mais il leur reste à gérer une fonction d’identification des caméras pour simplifier encore plus le processus et appliquer automatiquement cette table aux rushes provenant d’une même caméra).

- La gestion de chroma key pour les incrustations. La « chroma key » est un filtre avec couche alpha transparente (équivalent Photoshop) qui permet d’effacer le fond vert d’un tournage en studio par une transparence permettant de réaliser une incrustation. Le réglage doit toujours être réalisé finement au niveau de la couleur de cette chroma et des zones concernées qui peuvent être dessinées.

- Les fonctions de recadrage d’image.

- L’étalonnage d’images 3D stéroscopiques et leur intégration dans tout le flux de post-production.

- La gestion d’arbre avec les nœuds de processus d’étalonnage. C’est une sorte d’historique des modifications présenté dans un workflow 2D entièrement éditable.

- La saisie de commentaires sur les plans ainsi qu’au niveau de chaque image (pas encore réalisé). Ils seront conservées de manière numérique pendant tout le processus de la post-production. Aujourd’hui, tout ceci est saisi et géré… sur papier. La révolution sera de le gérer en numérique dans la post-production car il restera saisi sur papier dans les studios pendant encore quelque temps eu égards au conservatisme de la profession.

Mais c’est surtout l’étalonnage collaboratif qui fait avancer l’état de l’art de l’étalonnage et est adapté aux besoins des équipes de production et de post-production qui peuvent maintenant être facilement disséminées géographiquement :

- Un projet peut-être partagé avec une ou plusieurs personnes situées n’importe où dans le monde pourvu qu’elles soient connectées sur Internet avec un simple laptop.

- Le chef de projet peut définir avec un outil d’administration quels sont les projets vus par chaque personne et ce qu’ils peuvent faire dessus.

- A un moment, une seule personne peut intervenir sur un point. Le recadrage est réalisé d’un côté tandis que la colorimétrie l’est d’un autre. Un intervenant peut demander à modifier un élément au chef de projet. Il envoie un « token » qui est accepté ou non.

- Les outils de gestion enregistrent un log du travail des uns et des autres, gèrent l’envoi de messages. On peut ainsi savoir qui a fait quoi dans tout le processus de la post-production, hors montage.

Des sociétés évoquées dans ce post, c’est la plus orientée “produit” et la moins orientée “service”. Un bon signe pour générer un business de volume, même si le marché de l’étalonnage de la vidéo n’est pas aussi grand que son équivalent dans la photo (géré avec des logiciels tels qu’Adobe Lightroom). On est dans une situation courante : un produit qui améliore l’état de l’art du marché en ajoutant une fonctionnalité clé (le collaboratif), et en reconstituant ce qui existe déjà (l’étalonnage). Dans l’Internet, je suis généralement sceptique. Genre face aux entrepreneurs qui vont faire un “Facebook plus ergonomique”. Ici, le workflow collaboratif construit autour d’une base de donnée centralisée joue un rôle très important dans la valeur ajoutée du logiciel par rapport aux fonctions de base de l’étalonnage. Reste à voir comment les concurrents réagiront si le marché “prend” bien sur cette notion d’étalonnage collaboratif. Comme il s’agit d’un marché de niche, il ne présente pas les inerties que l’on trouve dans d’autres domaines comme dans les réseaux sociaux ou les plateformes logicielles génériques (OS mobiles, etc). Il reste cependant à identifier des partenaires de distribution pour le logiciel. Cela peut-être des constructeurs de matériel de ce secteur (serveurs, surfaces de contrôle exploitées par le logiciel, etc).

Firefly Cinema est actuellement hébergé dans une sorte d’hôtel d’entreprises du secteur de la production audiovisuelle qui regroupe surtout des sociétés de service dans la post-production, « Commune Image », situé à Saint Ouen. C’est une initiative d’un certain Olivier Laffon, entrepreneur créateur de grands centres commerciaux qui est devenu une sorte de bienfaiteur et business angel du secteur de la production cinématographique.

Firefly Cinéma a ainsi vendu et installé son logiciel à Commune Image, avec son exploitation dans une salle de cinéma intégrée dans les locaux de cet hôtel d’entreprise. La salle d’une centaine de places est équipée d’un projecteur Christie 2K imposant et d’une régie avec une batterie de serveurs (ci-dessous). Une infrastructure plutôt impressionnante est ainsi mise à disposition de startups. Une belle initiative ! Autre client, la production du dessin animé Titeuf, récemment sortie sur les écrans. Ici, il s’agissait d’étalonnage d’images de synthèse, sans workflow de production avec dérushage de caméras. Mais la fonction collaborative y était très adaptée, la production du film étant répartie sur plusieurs sites.

Voilà, ce petit tour est terminé !

Ceci n’est qu’un tout petit échantillon d’un plus grand nombre de startups de ce secteur d’activité. Il incarne bien la diversité des innovations technologiques qui peuvent être lancées dans ce secteur. Sa taille reste cependant modeste en effectifs et en chiffre d’affaire, mais pas en innovations technologiques et dans la fascination qu’il procure dans le processus de création cinématographique. C’est ce qui fait son charme !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Bien vu les “traits communs” des sociétés de ce secteur peu médiatisé, pas toujours évident du point de vue de l’investisseur (niches niches…) mais au combien passionnant du point de vue techno et entrepreneurial !

Tu pourras étendre cette “typologie” aux boites technos du monde du jeu video… ça foisonne aussi beaucoup !(juste une pour l’exemple, à Clermont Fd http://www.allegorithmic.com/ )

Sinon… aucun commentaire un mois après parution ? serions-nous si peu nombreux à s’intéresser à ce “numérique” dont Techcruch ne parlera jamais… ?

Oui, en effet, pas de commentaires et merci d’être le premier à réagir ! L’article a tout de même été consulté 2800 fois ce qui est pas mal pour un secteur un peu obscur… pour les salles obscures. Les acteurs de ce secteur ont peut-être aussi moins l’habitude d’intervenir dans les “médias sociaux”.

Le secteur des jeux vidéo est quant à lui bien plus connu et plus médiatisé !

Très très bon article en effet!!

Je ne le découvre qu’aujourd’hui mais vais le partager aussitot!

Jean-Philippe

(de chez Barco, entreprise belge bien active aussi en cinéma numérique ;-p !)

comprendre que celui-ci de ce secteur peu médiatisé

Un acteur pour simple devenir? J’ai regardé sur le succès le film https://papystreaming.zone/8979-stronger-2017.html je voulais devenir acteur.