Dans un podcast de la série “Quantum”, Fanny Bouton et moi-même faisons notre tour mensuel de l’actualité quantique française et mondiale depuis mi-octobre 2021. Nous y couvrons comme d’habitude l’actualité événementielle, puis scientifique et des entreprises du secteur des technologies quantiques.

Voici une version “texte” de ce podcast et les liens associés.

Événements

Conférence GDR IQFA

J’étais à la conférence du GDR IQFA à Lyon des 3 au 5 novembre (lien). C’était l’une des premières conférences « IRL » de chercheurs dans le quantique en France depuis le covid.

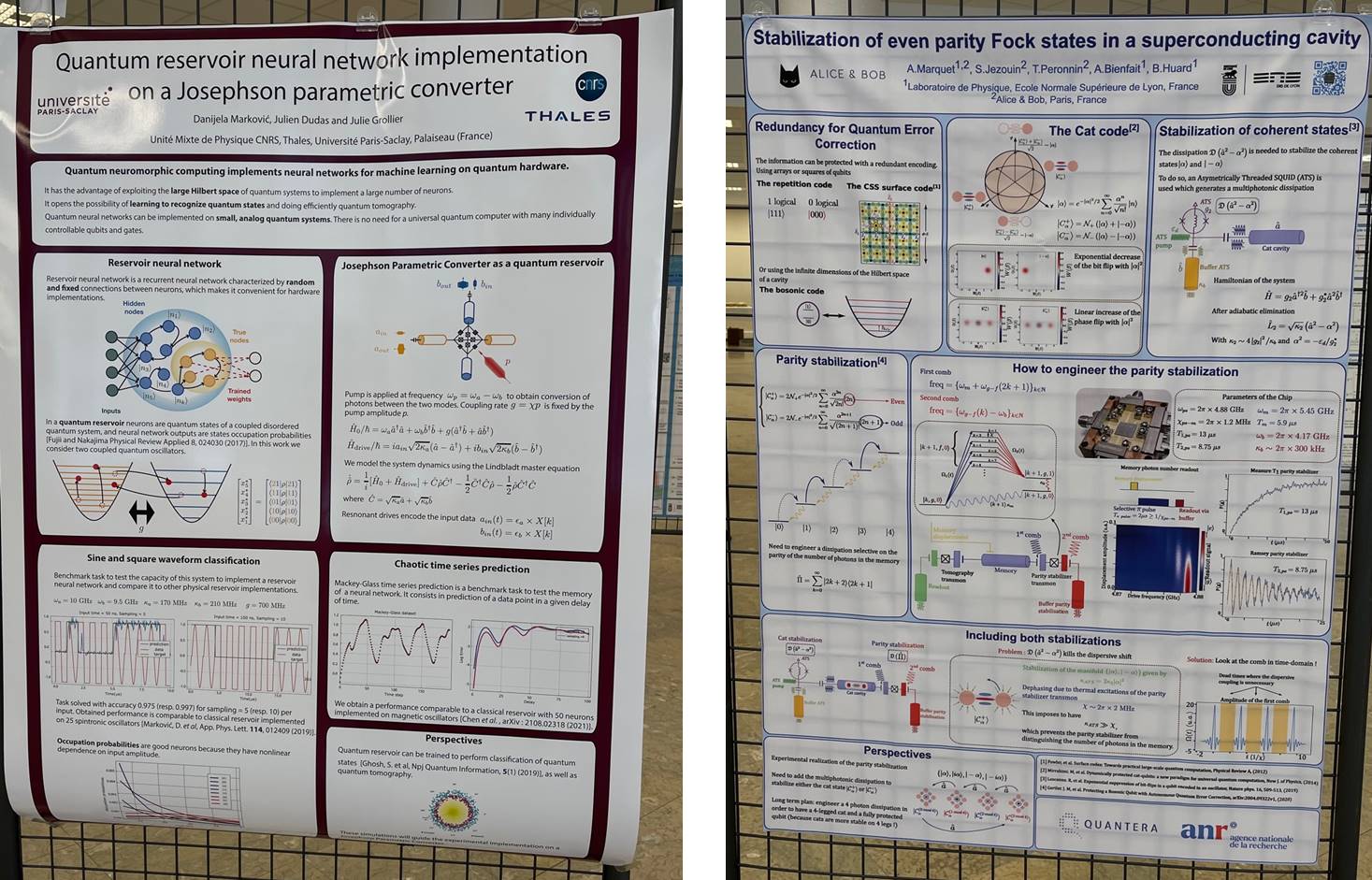

Il s’agissait de la 12e conférence annuelle du groupement de recherche « Quantum Engineering, Fundamental Aspects to Applications », avec 180 participants dont 150 sur place à l’ENS Lyon. Elle comprenait des tutoriaux (le point pendant une heure sur un sujet, comme sur le Quantum Machine Learning avec Iordanis Kerenidis), des interventions de thésards et post-doctorants de laboratoires de recherche en France (CNRS, CEA, Inria) et des « poster sessions » ou les thésards et post-docs présentent leurs travaux pendant des breaks en fin de conférence. Cela couvrait les différentes branches du quantique : physique fondamentale, calcul, métrologie et télécommunications.

Dans ce qui sortait du lot, on pouvait notamment remarquer deux travaux intéressants liés à l’amélioration de la qualité de la lecture des états de qubits supraconducteurs avec “Detecting spins by their fluorescence with a microwave photon counter” par Léo Balembois du CEA-Saclay et “Multiplexed photon number measurement” par Antoine Essig du Laboratoire de Physique de l’ENS Lyon portant une réalisation d’une mesure quantique multiplexée battant un record de vitesse en photocomptage. Danijela Marković de Thales TRT/CNRS présentait une intéressante architecture de réseau de neurones à base de qubits supraconducteurs.

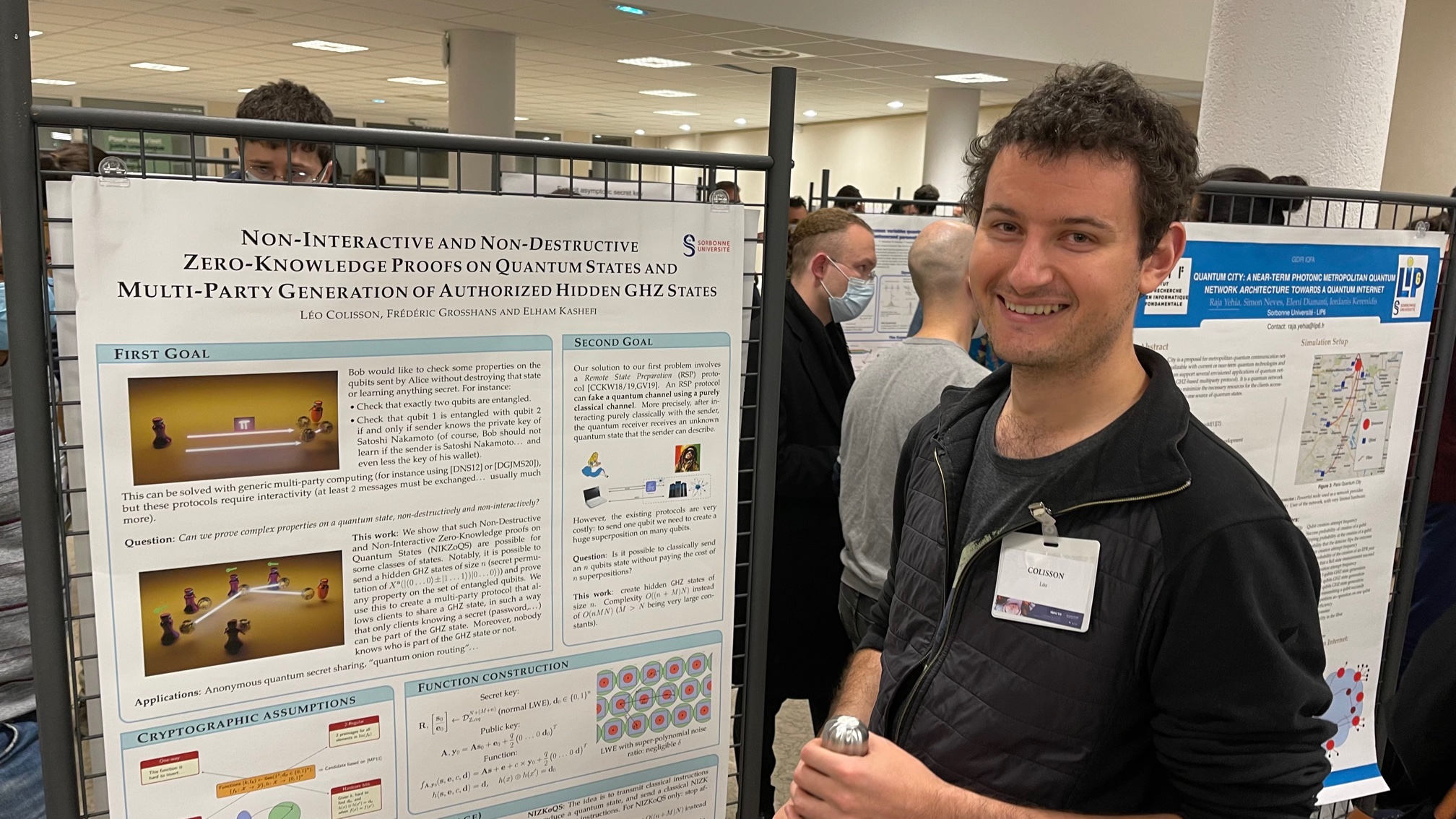

Valentina Marulanda Acosta présentait des travaux sur l’usage d’optique adaptative pour améliorer la transmission de clés quantiques par satellite, un travail dirigé par Eleni Diamanti du CNRS LIP6 à Paris. Dans “Satellite-to-ground DV and CV-QKD links with adaptive optics correction” (à paraître). Et ci-dessous, Léo Colisson, thésard de Frédéric Grosshans et Elham Kashefi du CNRS LIP6. Je vous laisse cependant interpréter le poster par vos propres moyens… !

Parmi les intervenants étrangers, à noter Menno Veldhorst de QuTech, sur “Spin-qubit processors in silicon and germanium” qui présentait une première, un ensemble de 15 qubits en silicium-germanium et Ronald Walsworth de l’Université du Maryland sur “Quantum sensing with NV centers in diamond”.

Enfin, la présidence du GDR IQFA est passée de Sébastien Tanzilli à Anaïs Dréau, chargée de recherche au laboratoire Charles Coulomb de Montpellier, et spécialiste de sources de photons à base de silicium. Elle annonçait d’ailleurs que la prochaine édition de cette conférence aurait lieu en 2022 en région parisienne.

Q2B 2021 à Santa Clara

Dans les événements internationaux, la conférence Q2B aura lieu du 7 au 9 décembre 2021 (lien). Elle réunit les principaux fournisseurs d’ordinateurs quantiques qui font un point assez technique sur leur technologie. C’est un must annuel organisé par l’éditeur de logiciels américain QC-Ware. Jean-François Bobier du BCG à Paris y interviendra, ainsi que Robert Marino de Qubit Pharmaceuticals et Loïc Henriet et Georges-Olivier Raymond de la startup Pasqal. Et puis John Martinis (ex-Google), John Preskill et Simone Severini d’Amazon.

Nous aurons sûrement l’occasion de revenir sur cette conférence en décembre 2021.

En France

J’interviens à Futurapolis le 26 novembre, un événement gratuit organisé par Le Point dans un panel quantique avec Alexia Auffèves (CNRS Institut Néel) et Eleni Diamanti (CNRS LIP6) à Toulouse le 26 novembre et animé par Guillaume Grallet du Point. Le thème de l’événement porte sur l’innovation technologique, le changement climatique et la mobilisation politique et citoyenne. Dans notre panel, on parlera calcul quantique, énergétique du calcul et aussi télécommunications quantiques. Inscriptions.

Puis à Strasbourg le 6 décembre dans un événement organisé par l’INSA Strasbourg en liaison avec les équipes de recherche quantique locales, comme celle de Shannon Whitlock de l’Université de Strasbourg et spécialiste des atomes froids. J’y interviens en compagnie d’une spécialiste et enseignante du quantum machine learning à l’INSA, Kaoutar Benlamine, pour présenter mon ebook Understanding Quantum Technologies et évoquer les grands enjeux du calcul quantique. Ensuite, deux panels permettront d’illustrer les actions de la Région Grand Est dans le quantique. Inscriptions.

Enfin, la conférence NAIA-A accueille une intervention d’Eleni Diamanti et moi-même à Bordeaux le 9 décembre de vulgarisation sur les technologies quantiques. Ce qui permettra de parler un peu plus que de coutume des télécommunications quantiques. On interviendra aussi auprès des enseignants et élèves des écoles d’ingénieur de Bordeaux dont l’Institut d’Optique le 10 décembre en milieu de journée. Inscriptions.

A noter que l’Usine Digitale publie un condensé hebdomadaire de l’actualité quantique en France. Voici le lien.

Actualité technologique

Une initiative dans l’énergétique du calcul quantique

Alexia Auffèves de l’Institut Néel du CNRS à Grenoble propose le lancement d’une initiative sur l’énergétique des technologies quantiques. Elle l’explique dans un dense papier de 10 pages en pre-print “Quantum technologies need a quantum energy initiative”.

Il s’agit de prendre en compte la dimension énergétique dès la conception des technologies quantiques et pas après coup. C’est à la fois un enjeu sociétal incontournable et de responsabilité des chercheurs et entreprises. La dimension énergétique doit être aussi prise en compte pour faire scaler les ordinateurs quantiques qui sont sous contraintes de ce côté-là. Dans cette démarche, Alexia Auffèves a déjà obtenu le soutien de nombreux chercheurs en France, en Europe, aux USA (comme Michel Devoret de Yale et Michael Frank des Sandia Labs du Département de l’Energie) et à Singapour. Elle propose une approche pluridisciplinaire très transversale associant physique et thermodynamique quantiques, électronique basse température, matériaux, cryogénie, algorithmie, etc.

Sa conclusion vaut le détour : “It would ensure that science and technology care about bringing out responsible innovations, by developing conceptual tools and applying them to minimize the resource consumption. It would make quantum technologies a model of virtuous deployment process for future innovations. This is essential in a world where resources get limited, and where the positive impact of science and technology for mankind must be demonstrated more than ever“.

C’était accompagné de la parution du papier Limitations in Quantum Computing from Resource Constraints par Marco Fellous-Asiani, Robert Whitney, Alexia Auffèves et Hui Khoon Ng dans PRX Quantum. Le papier explique comment faire du calcul quantique scalable sous contrainte de ressources, notamment énergétiques. Ce travail est le fruit d’une collaboration entre le le centre de recherche quantique CQT de Singapour, l’institut Néel et le LPMMC de Grenoble. Ce consortium vient également de décrocher une ANR internationale sur l’optimisation des ressources dans le contexte du calcul quantique.

J’avais assisté à la soutenance de thèse de Marco Fellous-Asiani le 9 novembre à Grenoble. Son jury comprenait Eleni Diamanti (CNRS LIP6), Mazyar Mirrahimi (Inria, récemment invité dans Decode Quantum), Maud Vinet (CEA Leti), Franck Ballestro (Institut Néel) et Patrice Bertet (CEA Saclay) illustrant l’intérêt pour le sujet de chercheurs de renom dans les technologies de qubits.

Sur ce même sujet, voir aussi le papier d’Alexia publié dans Reflets de la Physique en juillet 2021 : “Optimiser la consommation énergétique des calculateurs quantiques“.

IBM et ses 127 qubits

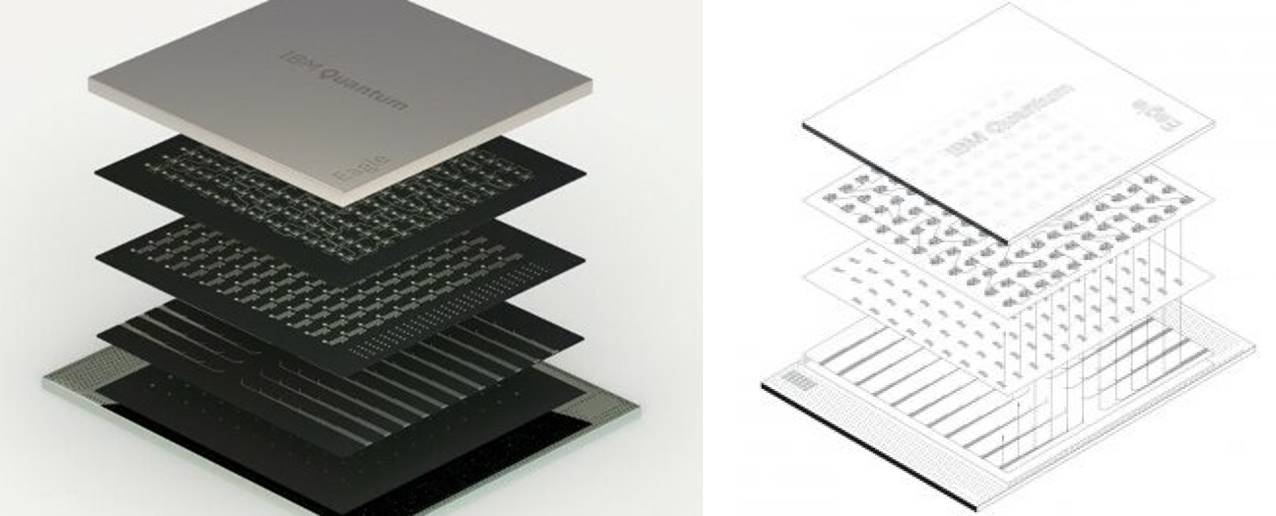

IBM annonçait en novembre 2021 la mise en service de son calculateur quantique de 127 qubits ‘Eagle’, respectant sa roadmap présentée en septembre 2020 qui prévoyait cela avant la fin 2021. IBM présente cela comme le premier processeur quantique qui n’est pas émulable sur des calculateurs classiques.

Est-ce vraiment le cas ? C’est difficile à évaluer car aucune caractérisation technique de ces qubits n’a été fournie par IBM, notamment au niveau de leur fidélité. Ici, le marketing est arrivé avant la science contrairement à Google en 2019 qui avait publié deux documents détaillés de 70 pages au total pour décrire sa “suprématie quantiques”. Même si celle-ci était contestable, au moins, on pouvait juger sur pièces.

[correction du 30 novembre 2021 : la fidélité du système à 127 qubits est de 98% pour les portes CNOT à deux qubits et celle de la lecture est de 91,2%, selon ce lien]

Par contre, IBM a dévoilé le fait que le processeur d’Eagle était multicouche avec des couches qui doivent contenir la circuiterie de contrôle des qubits, ce qui permet peut-être de mieux les isoler les uns des autres. Ils utilisent aussi un multiplexage de la lecture des qubits par groupes de 8, une technique semble-t-il déjà utilisée par Google. Il est probable qu’IBM ait bien fait avancer l’état de l’art avec ses qubits.

Pourquoi IBM n’a-t-il pas communiqué de benchmarks comme celui du Quantum Volume dont ils sont eux-mêmes à l’origine ? A leur crédit, on supposera que la création de ces benchmarks prend beaucoup de temps et qu’il risquait de ne pas être prêt avant la fin 2021.

IBM présentait aussi “System Two”, le format des ordinateurs quantiques de la génération future, à commencer par le processeur de 433 qubits prévu en 2022. Il utilise un cryostat de forme hexagonale créé par le Finlandais Bluefors sous l’appellation KIDE. Celui-ci permet de créer des liens cryogéniques entre différents hexagones, dans l’optique de relier entre eux plusieurs processeurs quantiques. C’est une approche dont on entend de plus en plus souvent parler mais qui n’est pas encore au point. Cela n’empêche pas quelques startups de se lancer dans le créneau comme QPhoX aux Pays-Bas.

Pour ce qui est de l’impossibilité de l’émulation sur une machine classique, c’est jusqu’à ce que Xavier Waintal le fasse comme il l’a proposé pour Google Sycamore en 2020 !

La Chine bat encore des records

Les chercheurs Chinois font encore du bruit avec des records dans les qubits aussi bien dans les supraconducteurs (66 qubits) qu’avec des qubits photons (jusqu’à 114 en boson sampling). Il y a une différence entre les deux records. Il est peu signifiant dans les qubits supraconducteurs car l’expérience des Chinois reprend quasiment à l’identique celle de Google Sycamore, sans vraiment faire avancer l’état de l’art. Et les 127 qubits d’IBM battent leur record de 66 qubits.

C’est cependant intéressant sur les photons car pour la première fois, ils créent une expérience d’échantillonnage de boson paramétrable qui ouvre la porte à de la programmation. On demande à voir la suite !

D-Wave et le gate-based

D-Wave annonçait début octobre 2021 se lancer dans les ordinateurs quantiques à base de portes et pas seulement dans l’annealing. D-Wave fournissait quelques informations complémentaires dans une visio-conférence organisée le 20 octobre 2021. J’ai pu y apprendre qu’ils vont en fait créer un nouveau processeur quantique de toutes pièces.

Ils repartent presque à zéro. Mais avec une technologie qu’ils maîtrisent bien, l’électronique supraconductrice de contrôle de qubits (dite SFQ). Ils vont donc sortir d’ici un à deux ans un processeur supraconducteurs avec seulement quelques qubits, et pas les 5000 dont ils disposent actuellement dans leur “quantum annealer”. C’est un peu comme s’ils repartaient à zéro, dans la course aux qubits supraconducteurs. Ils annoncent d’ailleurs que leur puce sera multicouches. Comme celle d’IBM ! Mais probablement pas de la même manière car ils intègreront probablement des SFQ, ce qu’IBM n’a pas l’air d’avoir l’intention de faire.

Actualité entrepreneuriale

Quandela annonçait une levée de fonds de 15M€. C’est la seconde la plus importante en France dans le domaine après celle de Pasqal en début d’année. C’est un bon signe. A noter l’arrivée d’un investisseur généraliste, Omnes, accompagné de Quantonation (inévitable), Bpifrance et de l’Agence de l’Innovation de la Défense (qui a aussi investi dans Pasqal). Cette levée de fonds fait suite au lancement par la startup cofondée par Valerian Giesz, Niccolo Somaschi et Pascale Senellard (du laboratoire C2N du CNRS et de l’Université Paris Saclay) de leur projet d’ordinateur quantique à base de photons. C’est une suite logique de leur excellente offre de sources de photons uniques et indistingables.

La startup américaine QuEra lève 17 M€ et annonce un calculateur quantique de 256 qubits. Il s’agit d’une startup lancée par des chercheurs de Harvard et du MIT, et notamment par Mikhail Lukin. Leur produit a l’air d’être un simulateur quantique à base d’atomes froids, mais ils semblent vouloir aussi rapidement le faire fonctionner en mode « portes quantiques ». Leur annonce entretient bien la confusion de ce point de vue-là. Et pour cause, utiliser un tel système en mode “gate-based” plutôt qu’en mode “quantum simulation” est plus délicat à mettre au point. Ce que fait QuEra est sinon très voisin de Pasqal (France) et ColdQuanta (USA). Un fait qui n’est pas rappelé dans la couverture presse sur le sujet comme dans la MIT Technology Review.

Pasqal annonçait un partenariat avec MBDA, leader dans les systèmes de missiles et filiale d’Airbus. C’est un nouveau client potentiel pour eux, à l’étape de l’évaluation.

Divers

Enfin, une fois n’étant pas coutume, on appréciera qu’un entrepreneur basé au Royaume Uni écrive du bien de la France. Il s’agit d’Andersen Cheng, CEO de Post-Quantum et Nomidio. Que dit-il au juste ? Que la stratégie française s’intéresse notamment aux technologies habilitantes et à la PQC. Avec une volonté d’attirer des talents en France. L’auteur était intéressé puisqu’il est CEO de deux startups qui proposent des solutions… de PQC. Mais c’est bien quand même !

![]()

![]()

![]()

Reçevez par email les alertes de parution de nouveaux articles :

![]()

![]()

![]()

Articles

Articles

Bonjour,

Juste pour préciser que IBM publie les caractéristiques techniques de ces machines, y compris de celles qui ne sont pas accessibles gratuitement au grand public. Par exemple pour le 127 qubits : https://quantum-computing.ibm.com/services?services=systems&system=ibm_washington ou encore pour une machine dite core system à 27 qubits: https://quantum-computing.ibm.com/services?services=systems&system=ibmq_sydney

Ces caractéristiques, mises à jour quotidiennement pour la plupart, sont visibles depuis plusieurs mois pour toutes les machines et depuis plusieurs années pour celles accessibles au grand public. A lire votre livre et à écouter ce podcast vous semblez l’ignorer. J’espère que vous prendrez en compte mon commentaire. Bien cordialement.

Merci pour l’information. Au moment de la publication du podcast, ces données sur les 127 qubits n’étaient pas disponibles sur le lien indiqué que je connais bien. Il me semble que je le mentionne pour les processeurs de 5 à 65 qubits dans mon ebook mais il faut que je vérifie.

Au demeurant, on comprend pourquoi IBM ne communique pas beaucoup dessus sur les fidélités des 127 qubits, vu le taux d’erreur de 2% pour les portes à deux qubits et de 8% pour la lecture. Cela confirme que la performance se dégrade avec le nombre de qubits dans ce type de processeur. Seuls le T1 et le T2 s’améliorent.

Bonjour,

Permettez-moi de corriger quelques erreurs ou imprécisions :

– Les données étaient accessibles dès l’annonce du 16 novembre bien avant votre podcast (Scott Aaronson y fait d’ailleurs référence le 17 novembre).

– A ma connaissance vous n’évoquez pas dans votre ebook que IBM Quantum publie et met à jour quotidiennement les données de calibrations de leurs systèmes. Vous oubliez d’ailleurs d’y faire référence dans la partie consacrée au Quantum Volume en suggérant que ces données sont au mieux cachées dans la litterature (dans la partie consacrée au Quantum Volume p 508 – These indicators are generally found in the scientific publications of researchers but not always in the marketing literature of manufacturers ). C’est faux en ce qui concerne IBM, les données techniques sont publiées ouvertement et mises à jour quotidiennement sur ce site. Elles sont de plus accessibles en utilisant qiskit et l’API d’IBM Quantum.

– En ce qui concerne les erreurs sur les CNOT l’amélioration est effective sur toutes les générations de machine (Penguin (20Q), Falcon (27Q), Hummingbird (65Q)) au fur et à mesure des révisions (= versions i.e. Falcon_r5 est plus récente que Falcon_r4). Voir https://twitter.com/jaygambetta/status/1445115380616335373 . On peut voir qu’un 65Q (Hummingbird_r2, Brooklyn) en Janvier 2021 a un plus faible taux d’erreur sur une CNOT qu’un 27Q (Falcon_r1, Paris) en Janvier 2020 ou qu’un 20Q (penguin_r3, Poughkeepsie) en Janvier 2019. Si on considère juste une génération de machine (i.e. nombre de qubit constant) l’amélioration est encore plus visible (voir la différence entre un Falcon_r1 en janvier 2020 et un Falcon_r10 en décembre 2021). Je vous accorde que eagle_r1 n’est pas encore sur ce graphe. On peut imaginer que le taux d’erreur sur les CNOTs sera surement moins bon au début que sur le plus récent des Falcon. A noter cependant que c’est le départ d’une nouvelle génération de machines et donc d’une succession de révisions qui bénéficieront probablement et comme précédemment des dernières technologies et améliorations développées sur les autres générations.

– L’amélioration sur les erreurs de mesure est effective sur la dernière génération de machines Falcon_r5 (mesure 7x plus rapide et 2x moins d’erreur sur la mesure entre Falcon_r5 et Falcon_r4 : ici )

Bien cordialement.

Merci. J’ai complété l’ebook avec les données les plus à jour sur les fidélités (en fait, dans la rubrique sur les Qubit Fidelity qui contenait déjà des données sur la fidélité des QPU de 27 et 65 qubits). Et indiqué à différents endroits que les données étaient disponibles chez IBM.

Ceci étant dit, si les fidélités s’améliorent au gré des évolutions de chaque classe de QPU (27, 65 et bientôt donc 127 qubits), le best-in-class actuel montre toutefois un décalage significatif lors que l’on augmente le nombre de qubits, en particulier sur le readout :

IBM Q27 Kolkata : 98,9% (2Q) et 98,6% (readout)

IBM Q65 Brooklyn : 98,7% (2Q) et 96,0% (readout)

IBM Q127 Washington : 98,0% (2Q) et 91,2% (readout)

Est-ce que cela pourrait s’inverser ? Est-ce que la baisse de fidélité du readout sur 127 qubits est due au multiplexage de la lecture qui a été introduit sur cette génération (sans passer par un TWPA je crois) ?

Par ailleurs, les fidélités des portes à 1 qubit ne sont plus indiquées. C’est dommage, même si l’on sait que les fidélités des portes à 2 qubits sont plus difficiles à obtenir.

Bonjour,

Je ne partage pas votre interprétation. A noter que le développement de ces machines se fait suivant plusieurs axes et de manière itérative i.e. la dernière machine avec le plus de qubits (Eagle) ne contient pas forcement toutes les dernières avancées sur les machines à plus faible nombre de qubits (Falcon). IBM Quantum différencie les machines core (aujourd’hui Falcon_r5, le standard accessible aux clients dans le cloud ou sur site) et celles dites exploratory. Pour citer la documentation: There are a number of checks and considerations before an exploratory system or class of systems may be promoted to a core premium system. Some of the exploratory systems today include more qubits (Hummingbird R2), faster qubit reset and measurement (Falcon R5), and new gates and couplers (Falcon R6). They have new features that we believe will make our systems better – but because of their exploratory nature, we do not offer them in all systems, as they have not yet been fully qualified. New features can be unreliable, and yet we are opting to rapidly give you access, while also maintaining our core premium systems as a stable backbone for your science and research.

Il m’apparait donc hasardeux de tirer une conclusion aussi large que “plus il y a de qubits moins c’est bon” alors que nous comparons des machines qui n’inclues pas toutes les mêmes technologies. Néanmoins nous verrons comment évolue le taux d’erreur des CNOT sur Eagle dans les prochaines mois/années. Personnellement et au vu des progrès sur Falcon je suis serein.

A ma connaissance le multiplexage en lecture a été testé pour la première fois sur la génération Hummingbird (65Q) et a été integré depuis au niveau des core systems Falcon_r4. A voir si le multiplexage est très différent pour eagle (possible mais je ne le crois pas).

A l’heure actuelle les données de calibration de Eagle ne sont pas encore mises à jour quotidiennement (la matrice de données est une image fixe vieille de quelques semaines et en effet les valeurs sur les portes mono-qubits n’apparaissent pas). Ces données seront rafraichies (avec les mono-qubits) et mises à jour quotidiennement une fois que Eagle sera pleinement accessible aux utilisateurs (sans doute avant la fin de l’année).

Merci. Cordialement.